Sony Removes 8K Claim From PlayStation 5 Boxes

Read more of this story at Slashdot.

Read more of this story at Slashdot.

Read more of this story at Slashdot.

Read more of this story at Slashdot.

Read more of this story at Slashdot.

Read more of this story at Slashdot.

Voici un bon complément aux résultats financiers pour Q1 2024 d’Intel, NVIDIA et AMD : le rapport de JPR sur la situation du marché de la carte graphique dédié pour desktop pour la même période. Tout d’abord, l’analyste salue le retour d’un semblant de saisonnalité pour le marché de la carte graphiq...

Voici un bon complément aux résultats financiers pour Q1 2024 d’Intel, NVIDIA et AMD : le rapport de JPR sur la situation du marché de la carte graphique dédié pour desktop pour la même période. Tout d’abord, l’analyste salue le retour d’un semblant de saisonnalité pour le marché de la carte graphiq...

Read more of this story at Slashdot.

Le premier vol de Starship a déjà plus d’un an et s’était soldé par une explosion après trois minutes de vol. Lors du second vol en novembre dernier, la séparation a bien eu lieu, mais le test a ensuite été brutalement interrompu par une explosion. Lors du troisième essai, Starship a réussi à se mettre en orbite, mais ce n’était pas encore ça sur le retour de la fusée.

Avec son quatrième vol, SpaceX réalise un carton plein, ou presque. En tout cas, les deux principaux objectifs sont remplis : le retour du premier étage après un peu plus de sept minutes, puis du second étage au bout d’une heure, sans exploser et avec la bonne position dans les deux cas.

On peut voir sur la vidéo de lancement qu’un des 33 moteurs Raptor n’a pas fonctionné, ce qui n’a pas empêché la fusée de décoller.

La séparation entre les deux étages s’est correctement faite. Super Heavy (premier étage) est ensuite venu se « poser » à la surface de l’eau, avec l’aide de trois moteurs pour ralentir la chute. Pas de barge cette fois-ci, mais c’était prévu ainsi.

SpaceX explique avoir profité de ce lancement pour réaliser quelques tests de résistance sur l’étage supérieur Starship. Deux tuiles du bouclier ont par exemple été enlevées pour mesurer la température à ces endroits.

« Malgré la perte de nombreuses tuiles et un volet endommagé, Starship a réussi à atterrir en douceur dans l’océan ! », se réjouit Elon Musk. Il ajoute qu’une tentative de récupération du booster aura lieu lors du prochain lancement. Bill Nelson, administrateur de la NASA, félicite aussi SpaceX pour cet essai.

Watch Starship's fourth flight test https://t.co/SjpjscHoUB

— SpaceX (@SpaceX) June 4, 2024

Biomemory compte proposer, d’ici 2030, des baies de stockage 42U d’une capacité d’un Eo (1 000 Po ou 1 000 000 To). La société mise sur l’ADN, peu onéreux, avec une densité et une longévité record. On n’en est pas encore là : il va falloir passer de 1 ko d’écriture par jour à 1 Po d’ici à quelques années.

Utiliser de l’ADN pour stocker des informations, l’idée n’est pas nouvelle. Le physicien américain Richard Feynman (prix Nobel en 1965) l’avait déjà suggérée dès 1959, rappelle le CNRS. Il a par contre fallu attendre 2012 pour que la première démonstration significative soit réalisée, à Harvard.

En France, l’Office parlementaire d’évaluation des choix scientifiques et technologiques (OPECST) a publié une « note » détaillée sur cette forme de stockage. On y retrouve les attentes, les embuches et le principe de fonctionnement.

Des entreprises se sont depuis lancées dans l’aventure, dont Biomemory. Elle était présente à Vivatech et nous avons pu discuter avec deux représentants de la société : Olivier Lauvray (membre du conseil consultatif et directeur technique à temps partiel) et Hela Ammar (chef d’équipe).

La société a été fondée par deux chercheurs et un informaticien : Erfane Arwani, Stéphane Lemaire et Pierre Crozet. Elle se présente comme étant à la « croisée de la biotech et de l’informatique ». C’est une spin-off du CNRS et la Sorbonne université, qui se trouve dans le 14ᵉ arrondissement de Paris. Elle s’est lancée en 2021 et emploie 18 personnes actuellement.

Stéphane Lemaire et Pierre Crozet se sont déjà illustrés il y a quelques années avec DNA Drive, deux capsules contenants des textes symboliques sur de l’ADN : la Déclaration des droits de l’homme et du citoyen de 1789 et la Déclaration des droits de la femme et de la citoyenne de 1791.

Le stockage ADN répond à un besoin : stocker toujours plus d’informations dans un volume restreint. En termes de densité, les possibilités de l’ADN sont sans commune mesure avec les autres solutions actuelles. Il y a quelques années, le CNRS expliquait qu’un « seul gramme peut théoriquement contenir jusqu’à 455 exabits d’informations, soit 455 milliards de milliards de bits. Toutes les données du monde tiendraient alors dans une boîte à chaussures ».

« Aujourd’hui, on arrive à stocker 30 % des données de l’humanité et d’ici 2030 on ne pourra stocker que 3 % », nous affirme Biomemory. Avec l’ADN, il sera possible d’enregistrer toujours plus de données, et à l’heure des IA (génératives) qui en sont extrêmement consommatrices, cette solution a le vent en poupe.

C’est d’ailleurs un cas d’usage mis en avant : permettre aux entreprises de garder leurs données brutes, alors « qu’aujourd’hui, elles sont obligées de les agréger, et ça perd de la valeur ». Le stockage ADN pourrait aussi permettre à des sociétés de garder leurs données sans les mettre entre les mains d’hébergeurs (étrangers ou non).

Il reste néanmoins du travail. « Aujourd’hui, on arrive à stocker un kilo octet par jour », reconnait Biomemory. Mais les perspectives d’évolution sont là : « L’idée, c’est d’arriver en 2025 à stocker un Go par jour. De continuer à progresser pour arriver à l’ordre d’un Po par jour en 2030 ». Cela donnerait 11,6 Go/s.

Le premier vol de Starship a déjà plus d’un an et s’était soldé par une explosion après trois minutes de vol. Lors du second vol en novembre dernier, la séparation a bien eu lieu, mais le test a ensuite été brutalement interrompu par une explosion. Lors du troisième essai, Starship a réussi à se mettre en orbite, mais ce n’était pas encore ça sur le retour de la fusée.

Avec son quatrième vol, SpaceX réalise un carton plein, ou presque. En tout cas, les deux principaux objectifs sont remplis : le retour du premier étage après un peu plus de sept minutes, puis du second étage au bout d’une heure, sans exploser et avec la bonne position dans les deux cas.

On peut voir sur la vidéo de lancement qu’un des 33 moteurs Raptor n’a pas fonctionné, ce qui n’a pas empêché la fusée de décoller.

La séparation entre les deux étages s’est correctement faite. Super Heavy (premier étage) est ensuite venu se « poser » à la surface de l’eau, avec l’aide de trois moteurs pour ralentir la chute. Pas de barge cette fois-ci, mais c’était prévu ainsi.

SpaceX explique avoir profité de ce lancement pour réaliser quelques tests de résistance sur l’étage supérieur Starship. Deux tuiles du bouclier ont par exemple été enlevées pour mesurer la température à ces endroits.

« Malgré la perte de nombreuses tuiles et un volet endommagé, Starship a réussi à atterrir en douceur dans l’océan ! », se réjouit Elon Musk. Il ajoute qu’une tentative de récupération du booster aura lieu lors du prochain lancement. Bill Nelson, administrateur de la NASA, félicite aussi SpaceX pour cet essai.

Watch Starship's fourth flight test https://t.co/SjpjscHoUB

— SpaceX (@SpaceX) June 4, 2024

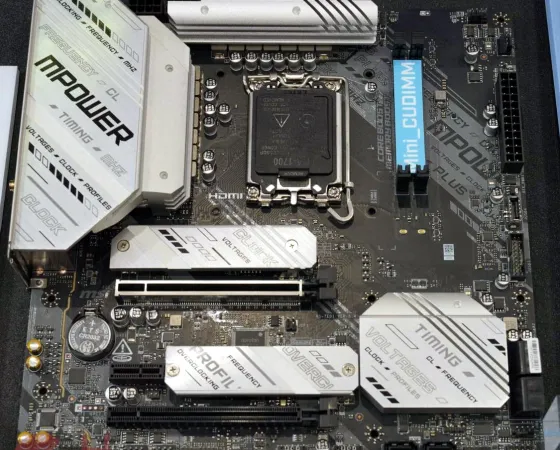

À l'ombre de CAMM2 qui a captivé bien plus l'attention, il faut admettre que le format CUDIMM ou CU-DIMM est passé un peu plus inaperçu et pourtant, il est standardisé par le JEDEC depuis janvier 2024 ! Il faut dire que le Clocked Unbuffered Dual Inline Memory Module chamboule de prime abord beaucou...

À l'ombre de CAMM2 qui a captivé bien plus l'attention, il faut admettre que le format CUDIMM ou CU-DIMM est passé un peu plus inaperçu et pourtant, il est standardisé par le JEDEC depuis janvier 2024 ! Il faut dire que le Clocked Unbuffered Dual Inline Memory Module chamboule de prime abord beaucou...

Le jeu mystère du jour est un certain Marvel's Midnight Suns, sa page sur le store d'Epic Games se trouve ici. Le titre du studio Firaxis Games nous promet une plongée dans la part d'ombre de l'univers Marvel. Marvel's Midnight Suns est le rassemblement ultime de super-héros associant des relations entre les personnages et une histoire riche, des possibilités de personnalisation et de progression dans un jeu de rôle tactique et stratégique aux mécaniques de combat par cartes révolutionnaires. Dans la face sombre de l'univers Marvel, forgez des liens indestructibles avec les héros légendaires de Marvel et des guerriers surnaturels dans leur combat contre la plus grande menace qu'ait connu le monde... les forces démoniaques de Lilith et de l'ancien dieu Chthon. […]

Lire la suiteRead more of this story at Slashdot.

Read more of this story at Slashdot.

Minimachines.net en partenariat avec TopAchat.com

La XPG Nia est une Console PC pas tout à fait semblable aux autres déjà disponibles sur le marché. Elle propose plusieurs éléments qui en font une proposition différente de l’offre actuelle.

La console XPG Nia est proposée par ADATA, marque qui propose au départ des composants de stockage et de mémoire mais qui a étoffé son catalogue au fil des ans en proposant des engins en tous genre, souvent en marque blanche. On se souvient du XPG Gaia, un MiniPC sous NUC Element fabriqué par un tiers. On se souvient également de ses portables désignés « en collaboration » avec Intel. Des engins qui avaient pour point commun de passer par un fabricant externe, Adata se limitant a coller une étiquette XPG sur ces produits avant de les distribuer dans ses canaux.

Cette console XPG Nia proposant des choses très innovantes, j’ai comme un doute sur la transformation nécessaire à Adata pour avoir développé ce projet en solo, il est donc fort possible que l’engin soit fabriqué par un tiers pour Adata et ensuite distribué sous le nom de XPG Nia.

Qu’est ce qui change sur la XPG Nia ? Pour commencer elle proposera un écran, pas encore finalisé en terme de diagonale, mais entre 7 et 8 pouces. Un écran qui permettra à l’engin un affichage fovéal. Cette technologie est censée améliorer la fluidité des jeux en trichant sur le rendu affiché de l’image. Héritée des casques de réalité virtuelle, cette technologie consiste a diviser la qualité de l’image en plusieurs zones.

Au centre, là où l’oeil fait le point, la qualité du rendu est complète, avec beaucoup de détails, des ombres, un anti aliasing parfait et du Ray Tracing. Mais en périphérie de ce point, là où l’oeil ne fait pas le même focus, la qualité se dégrade légèrement et de manière « invisible » pour soulager le processus de gestion d’image et augmenter la cadence de rendu. L’oeil est conçu pour fixer une zone précise de manière très efficace mais ne voit que de façon plus floue les côtés, autant en profiter. Pour que cela fonctionne, la technologie doit évidemment savoir où pointe votre regard, à quel endroit vous faites le point sur l’écran et adapter le contenu affiché en conséquence. Pour cela on utilise un système d’Eye Tracking Eyewear qui va déterminer précisément l’endroit ou mettre le paquet niveau rendu graphique.

Si vous regardez au centre de l’image, celui-ci sera très détaillé. Un élément se mettra a bouger sur le côté et attirera votre regard, vous déplacerez vos yeux, la machine analysera cette nouvelle cible, relâchera l’attention sur les détails au centre pour magnifier ceux du côté. Et ainsi de suite au fil du jeu. Dans l’ensemble cela fonctionne bien. Et si votre algorithme de rendu est bien optimisé, vous pouvez économiser énormément de temps de calcul a dégrader les contenus autour du point de base. Si vous ajoutez à cela des technologie comme le AMD FidelityFX Super Resolution, vous pouvez largement gagner en fluidité d’affichage.

L’idée est bonne et sur le papier la proposition est très intelligente. Mais cela se heurte à quelques petits soucis pratiques dans le réel. Sur un casque de rendu VR, l’avantage est que l’écran est très proche des yeux. L’écran est même solidaire de votre visage puisqu’il y est rattaché. La distance entre chaque oeil et chaque écran est donc toujours la même. Mieux la distance entre les yeux et les caméras qui analysent votre regard est également toujours la même. Vos pupilles sont facilement identifiables et le système profite de la lumière des écrans pour les identifier précisément. Ce qui permet une mesure constante plus simple de l’endroit où mettre cet accent graphique. Enfin, si le système de Eye Tracking est très proche de vos yeux, il a tout de même un champ d’analyse assez large pour déterminer finement les angles de la focale car la distance entre vos pupilles est séparée de manière constante. Tout cela facilite grandement les calculs nécessaires.

Mais sur une console tenue à bout de bras, de multiples problèmes se posent. D’abord il faut faire confiance à une seule caméra pour calculer l’ensemble des paramètres. La caméra va analyser l’endroit où se pose votre regard et agir en conséquence en modifiant l’image… Premier problème, la distance entre votre regard et la caméra n’est plus fixe, elle fluctue puisque vous portez l’objet à bout de bras. Pire, l’angle peut changer puisque vous allez bouger la tête et la position de la console dans vos mains. Je met au défi quiconque de jouer à un jeu sur Console mobile en restant fixe comme une statue. Les mains bougent la console au fur et à mesure qu’on l’utilise, le visage se déplace naturellement, la tête se penche et change d’angle. Analyser l’ensemble de ces données et les reporter suffisamment précisément sur un écran de 7 à 8″ de diagonale tenu à 30 ou 40 cm me semble totalement impossible. A moins d’y consacrer d’énormes ressources ou d’embarquer des composants étudiés précisément pour cette tâche et pas forcément donnés. La luminosité de l’analyse ne sera pas non plus constante et la détection de votre regard sera donc plus complexe.

Sur le casque Apple Vision, des caméras IR analysent le regard et des LED IR illuminent vos yeux.

Pour avoir essayé plusieurs de ces équipements, la détection du regard est toujours très dépendante des conditions de son emploi. Si sur un casque cela fonctionne assez bien, sur un écran externe, c’est un poil plus compliqué. Sur les écrans 3D Spatial labs de Acer par exemple, un système de double caméra fait ce travail d’analyse de la rétine pouvoir proposer un affichage en vraie 3D stéréoscopique à l’utilisateur. C’est bluffant et très efficace mais cela ne fonctionne qu’avec un poste fixe, posé sur un bureau, que l’on regarde bien en face… et cela coute très cher a mettre en place.

Autre problème soulevé par ce dispositif, la compatibilité avec les différents jeux. Implémenter la gestion de ce rendu dégradé en périphérie du focus nécessite un dialogue particulier avec le materiel et donc une prise en charge logicielle. Cette prise en charge ne sera pas forcément simple a obtenir de la part des différents éditeurs même si elle s’appuie sur la technologie Eyeware. Solution logicielle qui est aujourd’hui plus utilisée pour contrôler des mouvement dans les jeux qu’un rendu de zones.

Pour la XPG Nia, je ne crois pas une seule seconde au fonctionnement d’un bon rendu Fovéal. C’est à mon avis un bon moyen de faire parler de la console sur un salon comme ce Computex mais c’est tout. La seule solution pour que rendu particulier fonctionne serait de positionner l’écran sur un support fixe et de s’asseoir bien sagement devant, sans trop bouger, en pilotant ses jeux à la manette. Au vu du design de cette XPG Nia c’est peut être la solution retenue d’ailleurs. L’écran pivote en effet sur une petite charnière pour se relever. On peut ainsi le poser sur un bureau et avoir l’écran bien en face. Cela ne règle pas tous les soucis d’un vrai rendu Fovéal efficace mais cela a du sens.

Autre point clé de la console, la possibilité de mettre à jour sa mémoire vive et son SSD. Ca tombe bien, c’est le métier de base d’Adata de vendre de la mémoire vive et des SSD. Sur la XPG Nia, l’utilisateur pourra intégrer de la mémoire vive LPCAMM2. Ce nouveau format ultraplat qui permet des mises à jour plus facile et qui pourrait remplacer la DDR sur slot à l’avenir. L’utilisateur pourrait donc acheter un modèle avec 16 Go de mémoire vive et le faire évoluer dans un second temps vers 32 ou même 64 Go. Le SSD sera monté sur un port M.2 2230, là encore une source possible de mise à jour.

Le SSD M.2 2230 « spécial ConsolesPC » de XPG

Mieux encore, sur le stand du Computex, les personnes présentes indiquent à qui veut bien l’entendre que leur solution serait bien placée niveau tarif. « Moins de 600$ » selon certaines sources. « Proche des 500 $ » selon d’autres. Des prix alléchant qui placeraient la console en position de force face aux propositions concurrentes. Et cela même si les mêmes personnes sur le stand du Computex ne peuvent pas encore dire quel processeur, montant de mémoire, dalle d’écran stockage et autres seront réellement embarqués. De là a croire que la présence de la XPG Nia n’est là que pour faire le buzz ?

Je ne sais pas si la console sortira réellement un jour, dans cet état ou dans une version plus sage, mais en attendant elle a suffisamment fait parlé d’elle pour que tout le monde fasse le rapprochement entre les modules de mémoire LPCAMM2 et Adata. Que tout le monde sache que la marque propose des SSD M.2 2230 compatibles avec les autres consoles déjà sur le marché. Et ma fois c’est bien le plus important.

Car la XPG Nia reste un prototype sans calendrier plus précis qu’un vague « 2025 ». Sans fiche technique précise, sans tarif et sans autre ambition a mon avis qu’attirer au maximum les regards sur la marque. Il sera toujours temps d’enterrer le projet au besoin dans quelques mois ou de le rectifier dans une solution beaucoup plus classique loin des projecteurs.

Sources : Retrohandleds et Anandtech

XPG Nia : une consolePC qui promet beaucoup (trop ?) © MiniMachines.net. 2024.

Apple n’est « officiellement » plus en tête sur le support logiciel de ses smartphones. Forcée de concrétiser une information sur laquelle elle ne s’était jamais exprimée, l’entreprise table sur un minimum de cinq ans. Google, forte de l’annonce de ses Pixel 8, caracole désormais. Mais la réalité du marché est nettement plus trouble.

Voilà bien des années que Next revient sur l’un des thèmes qui lui tient à cœur : le support logiciel des appareils, et plus particulièrement celui des smartphones.

Dans ce domaine, Apple a été pendant longtemps en tête, voire un « modèle ». Aucun iPhone n’a jamais été supporté moins de cinq ans, aidé par le fait que l’entreprise maitrise à la fois le matériel et le logiciel, contrairement à Android et sa ribambelle de constructeurs. Une période valable d’ailleurs pour les mises à jour majeures d’iOS. La période de support pour les seules mises à jour de sécurité et d’un ou deux ans plus longue. Mais les temps changent.

Mais qu’est-ce qui a changé au juste ? À l’automne dernier, Google a d’abord présenté son Pixel 8 et sa déclinaison Pro. Outre les caractéristiques techniques et les exclusivités logicielles des téléphones maison, Google a surpris tout le monde en annonçant un support de sept ans. Pas seulement des correctifs de sécurité, mais bien sept ans de mises à jour majeures d’Android.

Nous avons été enthousiasmés par cette annonce. Et pour cause : dans le monde Android, de nombreux appareils d’entrée ou même de moyenne gamme ne dépassent pas les trois ou quatre ans. Bien trop peu. Google a donc voulu montrer l’exemple. La sortie du Pixel 8a n’y a rien changé, car lui aussi a ses sept ans de mises à jour d’Android. Parallèlement, Google a affirmé que les pièces détachées pour les réparations seraient disponibles pendant la même durée.

En janvier, la présentation de la gamme S24 s’est accompagnée, elle aussi, par une annonce identique : sept ans de mises à jour majeures pour Android. Jusqu’aux S23, cette période était de cinq ans. Il s’agissait là encore d’un bond important. Tous les ordinateurs ne peuvent pas en dire autant, y compris certains Mac.

L’annonce du Pixel 8 n’était pas inaperçue. À la faveur cependant d’un changement réglementaire au Royaume-Uni, la comparaison s’installe. Le Product Security and Telecommunications Infrastructure Bill, ou PSTI, impose en effet plusieurs mesures, dont l’interdiction des mots de passe par défaut et des obligations de transparence. Parmi ces dernières, celle d’indiquer précisément la durée de support logiciel pour les produits connectés à internet, smartphones en tête.

C’est dans ce contexte qu’Apple a révélé, au sein d’une déclaration de conformité au gouvernement britannique, que cette durée était de « cinq ans minimum à compter de la première date de commercialisation » pour ses iPhone.

Dave Kleidermacher, vice-président de l’ingénieur chez Google, a immédiatement réagi :

« Pendant des années, l’iPhone a eu la réputation d’avoir une durée de vie de support plus longue que celle d’Android. Pourtant, Apple ne s’est jamais engagée à offrir une durée de vie minimale à l’achat. Grâce à la réglementation PSTI du gouvernement britannique […], Apple a finalement publié un engagement de durée d’achat – cinq ans – deux ans DE MOINS que les flagships Android de Google (Pixel) et de Samsung »

Techniquement, la déclaration de Dave Kleidermacher est juste. Il ajoute cependant :

« Les consommateurs méritent de connaître les durées de vie minimales du support de sécurité pour leurs appareils électroniques grand public au moment de l’achat, et bravo au gouvernement britannique pour avoir imposé cette transparence. Apple a le mérite de fournir des mises à jour de sécurité pendant plus de 5 ans, et ce depuis longtemps. Mais il est temps de reconnaître qu’iOS n’offre plus les meilleures durées de vie en matière de sécurité dans l’industrie des smartphones. C’est Android qui le fait ».

Rappelons quand même quelques éléments de contexte. D’une part, c’est la première fois que des appareils Android sont supportés aussi longtemps, à l’exception (très) notable et logique du Fairphone 5. Et les seuls appareils supportés sont les Pixel 8 (tous les modèles) et la gamme Galaxy S24 de Samsung. Il s’agit donc de haut de gamme, voire de très haut de gamme, pour des appareils comme le Pixel 8 Pro ou le Galaxy S24 Ultra.

D’autre part, Apple parle d’un support minimal de cinq ans. En pratique, de nombreux appareils ont été mis à jour pendant six ou sept ans, comme le rappellent nos confrères d’iGeneration. Il est arrivé également à Apple de diffuser des mises à jour de sécurité pour des appareils qui n’étaient plus censés en recevoir. En janvier par exemple, pour les iPhone 6s, 7, SE, 8 et X, des appareils ayant entre 7 et 9 ans. L’iPhone XR, sorti en 2018, tourne actuellement sous iOS 17.5, soit la dernière révision du système. Le Pixel 4a, sorti il y a quatre ans, n’aura pas droit à Android 15.

Enfin, cette période de cinq ans minimum est valable pour l’ensemble des modèles, pas uniquement les derniers ou le haut de gamme. Mais Apple ne fait pas non plus d’entrée de gamme, du moins pas de smartphone à moins de 200 euros, alors qu’ils sont légion sur Android. Un marché que Google a largement contribué à créer.

Que des entreprises prennent enfin au sérieux un critère aussi important est une très bonne raison de se réjouir. Un support logiciel limité expose non seulement la clientèle aux dangers d’un système d’exploitation laissé sans correctifs de sécurité, mais engendre une consommation accrue de ressources.

Les smartphones sont encore trop souvent considérés comme des produits presque jetables. Les constructeurs en font leur beurre, la plupart des gammes étant renouvelées chaque année. Et chaque année, il faut trouver des raisons de motiver cette même clientèle à changer d’appareil. Limiter les mises à jour d’Android – et donc l’arrivée de fonctions majeures – était un moyen parmi d’autres. C’est néanmoins moins vrai depuis plusieurs années, car les versions se succèdent sans gros changements pour les utilisateurs.

Google et Samsung sont les premiers gros fabricants à proposer sept ans pour leurs appareils. Mais il faut encore que la pratique s’étende et fasse tache d’huile. Consciente que ses « partenaires » ne jouent pas le jeu, Google passe certaines mises à jour importantes par le Play Store. Mais même ainsi, cela ne règle pas tous les soucis et tous les fabricants doivent jouer le jeu.

D’autre part, l’Europe s’apprête à sonner la fin de la récréation. Le 20 juin entrera en vigueur une extension du règlement sur l’économie circulaire. Elle introduira notamment la note de réparation et l’obligation de transparence sur certains aspects. Surtout, elle obligera les constructeurs à proposer des mises à jour logicielles pendant au moins cinq ans après mise sur le marché. Ce qui signifie en pratique six ou sept ans de mises à jour dans la plupart des cas.

Attention, on parle bien de mises à jour de sécurité. Dans l’absolu, rien ne forcera les constructeurs à proposer de nouvelles versions majeures de leur système. Mais l’important concerne bien la sécurité, afin qu’un appareil gardé durant plusieurs années continue d’être protégé. D’autant que le règlement concernera l’intégralité des appareils mis sur le marché après cette date (le changement n’est pas rétroactif).

Il est probable que cette bascule aura un impact important sur la manière dont les constructeurs mettent des appareils sur le marché. L’entretien s’avérant mathématiquement plus couteux, l’une des voies serait le resserrement des gammes et donc la réduction du nombre de modèles proposés. Mais il n’est pas certain que cette perspective enchante particulièrement les entreprises : la durabilité n’est pas toujours retenue comme argument fort dans les stratégies commerciales.