Le pacte européen sur l’IA signé par 126 entreprises, mais des absences notables

Kumbayah, Kum ba yah

La Commission européenne a annoncé plus d’une centaine d’entreprises signataires pour son pacte sur l’IA. Toutes s’engagent à respecter les grands principes du règlement sur l’IA (AI Act) avant son application. Si certaines vont encore plus loin, on note l’absence de certaines grandes entreprises, dont Apple et Meta.

Le « pacte de l’UE sur l’intelligence artificielle », créé par Thierry Breton, comporte une série d’engagements volontaires pour les entreprises signataires. Le règlement sur l’IA, même s’il est entré en vigueur le 1er août, ne verra ses principales mesures entrer en application que dans deux ans environ. Le calendrier est cependant étalé : « les interdictions prendront effet au bout de six mois, les règles de gouvernance et les obligations relatives aux modèles d’IA à usage général deviendront applicables après 12 mois et les règles relatives aux systèmes d’IA intégrés dans des produits réglementés s’appliqueront après 36 mois », rappelle la Commission.

Celle-ci a donc proposé, via un pacte, que les entreprises intéressées s’engagent sur ses principes fondateurs sans attendre. Pour montrer l’exemple et favoriser les échanges.

En quoi consiste le pacte ?

Le cœur de l’engagement porte sur trois actions, présentées comme « essentielles » :

- Une stratégie de gouvernance de l’IA

- Un inventaire des systèmes d’IA à haut risque

- La promotion de la sensibilisation du personnel à l’IA

Ces trois mesures phares doivent couvrir le plus important, selon la Commission. La première doit ainsi favoriser à la fois l’adoption de l’IA dans l’entreprise et celle du règlement. La deuxième, cruciale, vise le recensement des systèmes soumis à des obligations spécifiques, décrites dans le règlement. La dernière doit bien sûr permettre un « développement éthique et responsable de l’IA ».

En plus de ces engagements « fondamentaux », la Commission précise que plus de la moitié des entreprises signataires ont pris des engagements supplémentaires. Ceux-ci concernent notamment le contrôle humain, l’atténuation des risques et l’étiquetage transparent de certains contenus générés par IA (les trucages vidéo ultra-réalistes sont cités).

Les objectifs de la Commission

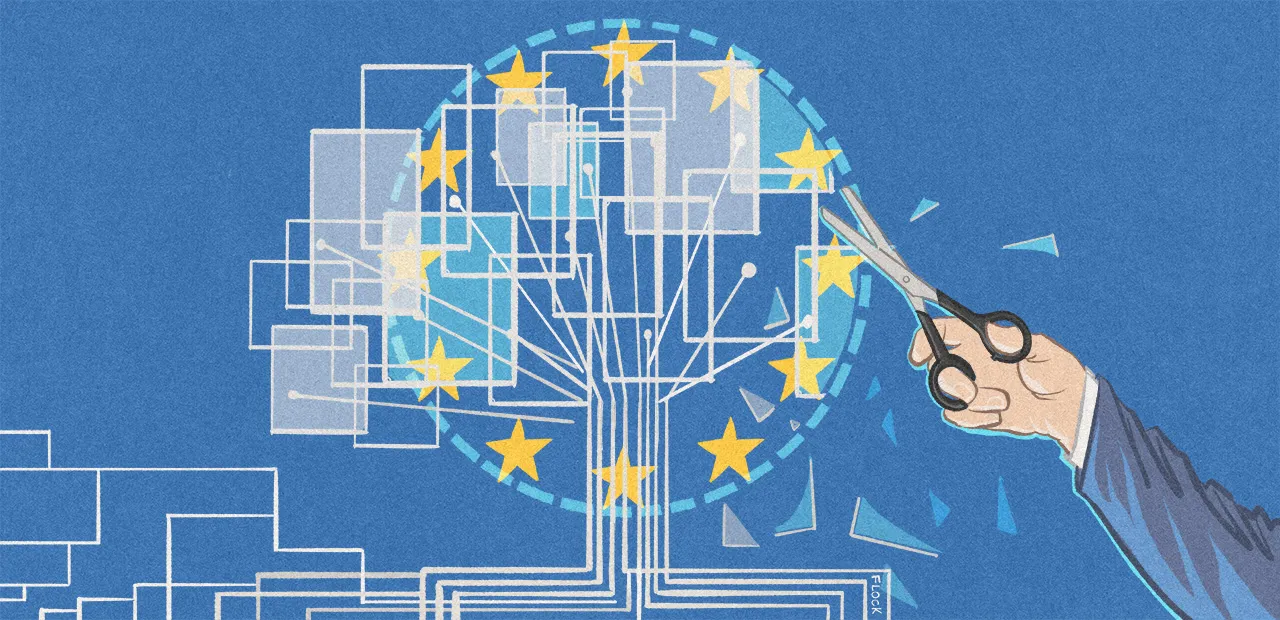

Avec le pacte, la Commission vise plusieurs missions. La préparation à l’AI Act est bien sûr la principale. Dans une ambiance tendue par des entreprises comme Meta (nous y reviendrons), la Commission prend les devants et veut habituer les entreprises aux impératifs du règlement.

Le pacte repose toutefois sur deux piliers. Si la préparation au nouveau cadre juridique en est un, l’autre est centré sur l’échange d’informations. Il « encourage l’échange de bonnes pratiques et fournit des informations pratiques sur le processus de mise en œuvre de la législation ». Par cet échange, la Commission espère une certaine « évangélisation » auprès des autres entreprises. Car tout le monde est loin d’avoir signé.

De nombreux signataires, mais des absents notables

La liste des signataires, consultable sur le site de la Commission, comprend à ce jour 126 entreprises. On y trouve beaucoup de grands noms comme Accenture, Adecco, Adobe, Airbus, Aleph Alpha, Amazon, Atlassian, Autodesk, Booking.com, Cisco, Criteo, Dassault Systèmes, Deutsche Telekom, Docaposte, Godot, Google, HP, IBM, Lenovo, Logitech, Mastercard, Microsoft, OpenAI, Orange, OVHcloud, Palantir, Qualcomm, Sage, Salesforce, Samsung, SAP, Snap ou encore Vodafone.

On remarque rapidement que sur les cinq GAFAM, trois sont présentes dans la liste : Amazon, Google et Microsoft. La présence d’OpenAI est également significative, mais pas étonnante, dans la mesure où l’entreprise, comme d’autres, travaille exclusivement sur l’intelligence artificielle, avec le soutien financier très actif de Microsoft. Deux autres multinationales sont en revanche absentes : Apple et Meta.

Là non plus, il n’y a guère de surprise. Des GAFAM, Apple et Meta se sont montrées les plus bruyantes sur leur désamour de la réglementation européenne. Apple a fustigé le DMA à plusieurs reprises, jusqu’à s’en plaindre au cours d’un étonnant exercice de communication. Elle y affirmait que les iPhone européens seraient moins sécurisés que les autres, à cause de l’ouverture forcée entrainée par la loi sur les marchés numériques.

Plus récemment, Meta s’est fait la championne des entreprises frustrées par le « cadre réglementaire fragmenté » de l’Union européenne. Dans une lettre ouverte, signée par de nombreuses entreprises (dont certaines ont également signé le pacte), elle jouait la carte du pathos et de la peur, face à l’imposante manne financière que représentent les investissements dans l’IA. L’Europe, déjà à la traine, risquait d’être définitivement distancée par les États-Unis, la Chine et l’Inde.

Hors des grandes multinationales américaines, d’autres entreprises brillent par leur absence. Mistral n’a par exemple par signé le pacte, pas plus qu’Anthropic, autre grande spécialiste de l’IA avec ses modèles Claude. TikTok n’est pas là non plus, ni Spotify.

Un succès ?

Difficile de savoir si le pacte va fonctionner comme prévu. Selon Politico, il était déjà en perte de vitesse avant le départ de Thierry Breton, qui a démissionné de son poste de commissaire sous pression d’Ursula von der Leyen, présidente de la Commission européenne. D’autres attendent plus simplement de voir comment la situation va évoluer et pourraient rejoindre le pacte plus tard.

Meta serait de celles-là. « Nous nous félicitons de l’harmonisation des règles de l’UE et nous nous concentrons actuellement sur notre travail de mise en conformité avec la loi sur l’IA, mais nous n’excluons pas de rejoindre le pacte sur l’IA à un stade ultérieur » a affirmé l’entreprise à nos confrères. « Nous ne devons pas non plus perdre de vue l’énorme potentiel de l’IA pour stimuler l’innovation européenne et favoriser la concurrence, faute de quoi l’UE passera à côté de cette opportunité qui ne se présente qu’une fois par génération ». Une piqure de rappel tout droit sortie de sa lettre ouverte.