Pas si évident

La HAS a publié le 30 octobre un guide pédagogique sur l’utilisation de l’intelligence artificielle générative dans l’ensemble du secteur sanitaire, social et médico-social. L’autorité ne s’oppose pas à cette utilisation, mais elle pointe très vite les deux problèmes majeurs : la sensibilité des données manipulées et la fiabilité des résultats.

Les données de santé sont une mine d’or. Selon comment elles sont exploitées, elles peuvent permettre le suivi de l’efficacité des traitements, faire apparaitre des corrélations, étudier des prévalences et autres.

Ce caractère précieux est au cœur de plusieurs décisions politiques. En France, il y a bien sûr le HDH (Health Data Hub) et ses décisions sulfureuses d’hébergement chez Microsoft, pointées constamment par le député Philippe Latombe, des rapports interministériels ou même encore récemment par la Cour des comptes. L’entrepôt de données européen EMC2 a le même problème.

Mais les objectifs sont à chaque fois les mêmes : concentrer les données, favoriser les travaux des chercheurs, servir de guichet unique et, bien sûr, permettre à terme le traitement des données par l’IA. Dans le cadre du projet EMC2 d’ailleurs, l’Agence européenne du médicament abordait explicitement cette finalité.

La Haute Autorité de santé publie donc un avis sur la question, même s’il peut sembler tardif. Dans les grandes lignes toutefois, la HAS ne réagit pas spécifiquement sur l’exploitation des données, mais vise les professionnels de santé et l’utilisation de l’IA comme aide à la décision.

Quatre lignes directrices

La HAS publie principalement quatre conseils, rassemblés sous l’appellation : AVEC, pour « Apprendre, Vérifier, Estimer et Communiquer ».

Pour l’apprentissage, la HAS recommande chaudement aux professionnels de se former sur les outils qu’ils utilisent. Les IA peuvent faire gagner du temps, mais la plupart n’ont pas été formées sur les questions de santé. Les professionnels devraient ainsi s’interroger sur les modalités d’utilisation, les règles liées à la confidentialité des données personnelles ou encore effectuer des tests pratiques avant de se lancer dans une pratique quotidienne.

Sur la vérification, la HAS conseille la prudence face aux résultats renvoyés par l’IA : « le professionnel est attentif à la pertinence de son usage, à la qualité de sa requête et au contrôle du contenu généré ». Ce qui inclut de ne pas partager d’informations confidentielles et de considérer chaque réponse comme une proposition et non une vérité. La fiabilité des réponses de l’IA ne pouvant par définition être garantie (approche probabiliste), elles peuvent contenir des erreurs : valeurs et unités des quantités chiffrées, noms des médicaments, etc. On l’a vu récemment dans nos propres tests, l’IA peut se tromper lourdement dans la méthode de calcul.

L’estimation concerne l’analyse régulière de l’adéquation entre les besoins et les résultats. Les professionnels de santé sont ainsi invités à réinterroger sa pratique : des corrections ont-elles été nécessaires ? Si oui, à quelle fréquence ? L’outil est-il simple d’utilisation ? A-t-il pu être intégré dans des flux de travail existants ? En somme, la HAS souhaite que les professionnels s’interrogent sur les gains apportés face aux contraintes.

Enfin, pour la communication, la Haute Autorité est claire : les professionnels devraient échanger avec les patients autour de l’usage de l’IA. L’autorité leur recommande également de favoriser les retours d’expérience avec d’autres utilisateurs et développer « une démarche de transparence autour des typologies de données partagées, de l’adhésion au sein de sa structure et des impacts organisationnels ».

Le danger des mauvaises pratiques

De manière générale, la HAS souhaite que chaque usage de l’IA générative soit « conscient, supervisé et raisonné ».

Cependant, même si elle peut « devenir une alliée » quand elle est « bien maitrisée », l’autorité pointe également les dangers inhérents à son utilisation. Elle met en garde contre les erreurs pouvant survenir dans les réponses envoyées, notamment quand elles se fondent sur des données non vérifiées. Surtout, elle pointe les hallucinations, soit des informations fausses mais qui peuvent paraitre convaincantes.

Outre les dangers propres à l’IA elle-même, la HAS signale de mauvais comportements chez les professionnels eux-mêmes, dont l’utilisation d’informations confidentielles dans les requêtes, expliquant les conseils sur la communication avec les patients.

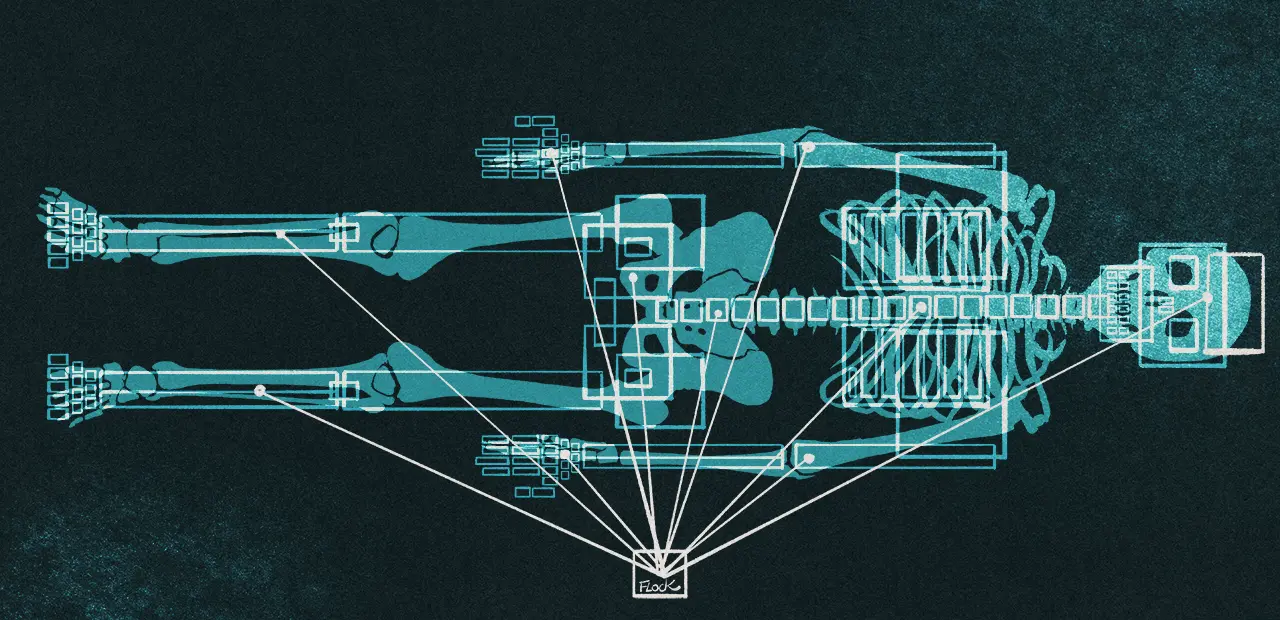

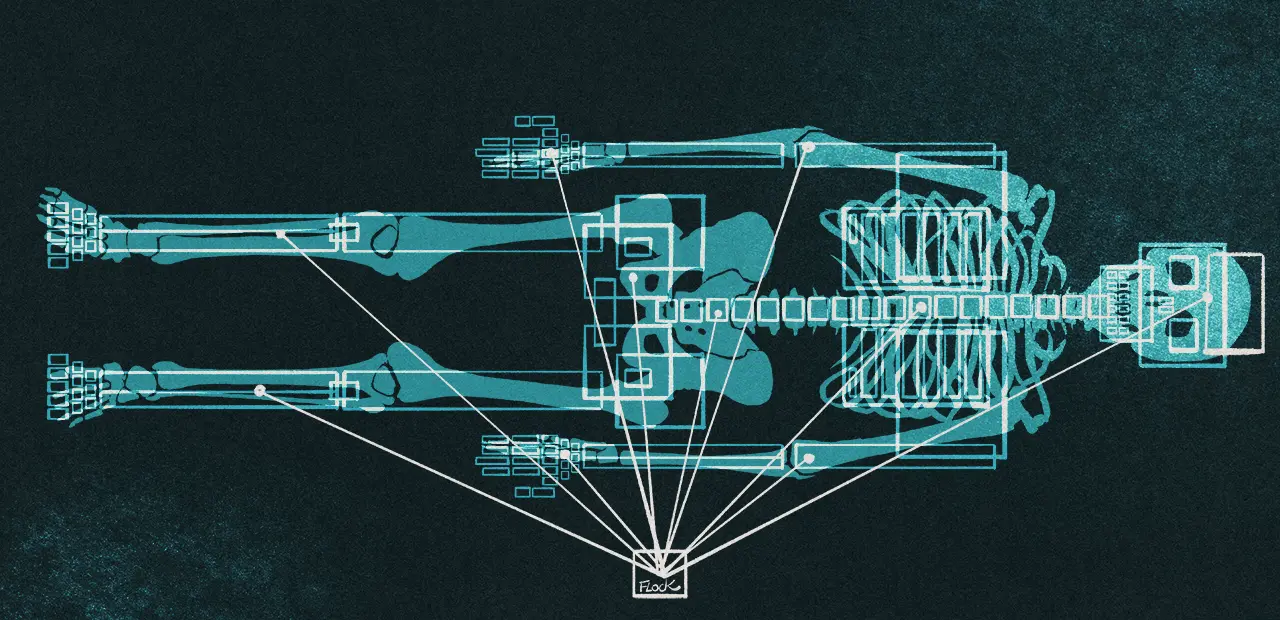

Dans l’ensemble, l’autorité évoque un potentiel prometteur sur l’ensemble de ces technologies. Elle ne parle d’ailleurs pas uniquement des interfaces questions/réponses des chatbots, mais aussi d’autres outils devenus très courants : transcriptions de conversations lors de consultations, synthèses de littérature scientifique, création de documents illustrés pour expliquer des parcours médicaux-sociaux, préremplissage de documents administratifs, traductions de textes pour des personnes non-francophones, etc. Tous peuvent faire gagner du temps (voire beaucoup), mais le risque d’erreur est le même dans tous les cas de figure dès que l’outil utilise l’IA générative.

Enfin, outre les erreurs, les professionnels ont tout intérêt à se former pour s’acclimater à des concepts centraux de l’IA générative. Par exemple, les réponses peuvent varier dans le temps, notamment en fonction de la version du modèle et des données utilisées pour l’entrainement. La qualité de la réponse peut aussi fortement varier selon le soin apporté à la question (prompt).

Pour les personnes intéressées, la HAS a donc publié deux versions de ses recommandations : une complète d’une quinzaine de pages (PDF), et une concise rassemblant les principales informations sur une seule page (PDF). Administration publique oblige, la HAS a également publié un rapport sur l’élaboration de son guide et les méthodes utilisées (PDF).