☕️ Meta va supprimer les boutons J’aime et Partager externes à ses plateformes

Fin d’une ère, pour Facebook. Le 10 février 2026, deux de ses plugins externes, le bouton J’aime et le bouton Partager seront jetés aux oubliettes.

Lancés en 2010, ces deux outils avaient largement participé à alimenter les échanges sur Facebook, en simplifiant la promotion et le partage commenté d’articles et de liens divers.

D’après l’entreprise, cela dit, ces outils « représentent une époque antérieure du développement du web, et leur usage a décru naturellement à mesure que le paysage numérique évoluait ».

Pour pallier à cet usage déclinant, Meta annonce donc qu’à compter du 10 février 2026, ces dispositifs seront transformés en un pixel 0x0, ce qui rendra les boutons invisibles sur les sites les utilisant, « sans créer de message d’erreur ni abîmer de fonctionnalité ».

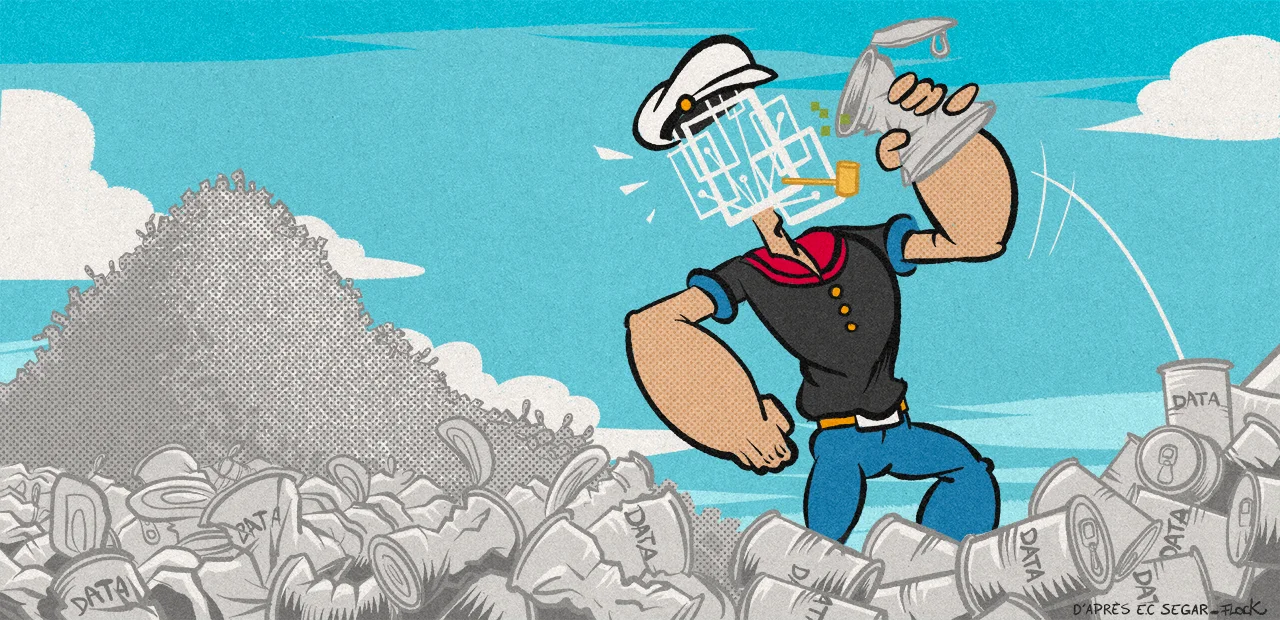

S’il n’a pas été inventé par Facebook, le bouton J’aime a largement modifié notre rapport au web. Initialement ajouté sur des sites comme Yelp ou, donc, Facebook, pour motiver les internautes à produire du contenu et le partager, il a ensuite été détourné de cet usage initial pour se transformer en métrique des pratiques numériques à collecter, pour mieux vendre de la publicité.

La question du traitement des données personnelles était remontée jusqu’à la Cour de Justice de l’Union Européenne. En 2019, elle avait conclue l’éditeur d’un site pouvait être responsable avec Facebook d’une partie des traitements de données personnelles orchestrés par le bouton « J’aime ». Celui-ci permettait à Facebook de récupérer des données même si l’internaute ne cliquait pas dessus ou n’était pas abonné.

Si l’outil extérieur aux plateformes de Meta disparaît, les emojis « j’aime », « j’adore » , « soutien » , « colère » (lancés en 2016) et autres restent bien présents à l’intérieur des réseaux sociaux de l’entreprise.

AMD a dévoilé sa roadmap pour les années futures en ce qui concerne sa branche CPU. Alors que les Ryzen 7000 étaient lancés en septembre 2022, et que les Ryzen 9000 en août 2024, AMD confirme par sa roadmap l'arrivée des prochains Ryzen pour 2026. On ne les nomme pas parce qu'il y a fort à parier qu...

AMD a dévoilé sa roadmap pour les années futures en ce qui concerne sa branche CPU. Alors que les Ryzen 7000 étaient lancés en septembre 2022, et que les Ryzen 9000 en août 2024, AMD confirme par sa roadmap l'arrivée des prochains Ryzen pour 2026. On ne les nomme pas parce qu'il y a fort à parier qu...