Des cochonneries devant la porte

Apple n’est « officiellement » plus en tête sur le support logiciel de ses smartphones. Forcée de concrétiser une information sur laquelle elle ne s’était jamais exprimée, l’entreprise table sur un minimum de cinq ans. Google, forte de l’annonce de ses Pixel 8, caracole désormais. Mais la réalité du marché est nettement plus trouble.

Voilà bien des années que Next revient sur l’un des thèmes qui lui tient à cœur : le support logiciel des appareils, et plus particulièrement celui des smartphones.

Dans ce domaine, Apple a été pendant longtemps en tête, voire un « modèle ». Aucun iPhone n’a jamais été supporté moins de cinq ans, aidé par le fait que l’entreprise maitrise à la fois le matériel et le logiciel, contrairement à Android et sa ribambelle de constructeurs. Une période valable d’ailleurs pour les mises à jour majeures d’iOS. La période de support pour les seules mises à jour de sécurité et d’un ou deux ans plus longue. Mais les temps changent.

Apple, Google et Samsung dans un bateau

Mais qu’est-ce qui a changé au juste ? À l’automne dernier, Google a d’abord présenté son Pixel 8 et sa déclinaison Pro. Outre les caractéristiques techniques et les exclusivités logicielles des téléphones maison, Google a surpris tout le monde en annonçant un support de sept ans. Pas seulement des correctifs de sécurité, mais bien sept ans de mises à jour majeures d’Android.

Nous avons été enthousiasmés par cette annonce. Et pour cause : dans le monde Android, de nombreux appareils d’entrée ou même de moyenne gamme ne dépassent pas les trois ou quatre ans. Bien trop peu. Google a donc voulu montrer l’exemple. La sortie du Pixel 8a n’y a rien changé, car lui aussi a ses sept ans de mises à jour d’Android. Parallèlement, Google a affirmé que les pièces détachées pour les réparations seraient disponibles pendant la même durée.

En janvier, la présentation de la gamme S24 s’est accompagnée, elle aussi, par une annonce identique : sept ans de mises à jour majeures pour Android. Jusqu’aux S23, cette période était de cinq ans. Il s’agissait là encore d’un bond important. Tous les ordinateurs ne peuvent pas en dire autant, y compris certains Mac.

Apple confirme un support de « cinq ans minimum »

L’annonce du Pixel 8 n’était pas inaperçue. À la faveur cependant d’un changement réglementaire au Royaume-Uni, la comparaison s’installe. Le Product Security and Telecommunications Infrastructure Bill, ou PSTI, impose en effet plusieurs mesures, dont l’interdiction des mots de passe par défaut et des obligations de transparence. Parmi ces dernières, celle d’indiquer précisément la durée de support logiciel pour les produits connectés à internet, smartphones en tête.

C’est dans ce contexte qu’Apple a révélé, au sein d’une déclaration de conformité au gouvernement britannique, que cette durée était de « cinq ans minimum à compter de la première date de commercialisation » pour ses iPhone.

Dave Kleidermacher, vice-président de l’ingénieur chez Google, a immédiatement réagi :

« Pendant des années, l’iPhone a eu la réputation d’avoir une durée de vie de support plus longue que celle d’Android. Pourtant, Apple ne s’est jamais engagée à offrir une durée de vie minimale à l’achat. Grâce à la réglementation PSTI du gouvernement britannique […], Apple a finalement publié un engagement de durée d’achat – cinq ans – deux ans DE MOINS que les flagships Android de Google (Pixel) et de Samsung »

Temps mort

Techniquement, la déclaration de Dave Kleidermacher est juste. Il ajoute cependant :

« Les consommateurs méritent de connaître les durées de vie minimales du support de sécurité pour leurs appareils électroniques grand public au moment de l’achat, et bravo au gouvernement britannique pour avoir imposé cette transparence. Apple a le mérite de fournir des mises à jour de sécurité pendant plus de 5 ans, et ce depuis longtemps. Mais il est temps de reconnaître qu’iOS n’offre plus les meilleures durées de vie en matière de sécurité dans l’industrie des smartphones. C’est Android qui le fait ».

Rappelons quand même quelques éléments de contexte. D’une part, c’est la première fois que des appareils Android sont supportés aussi longtemps, à l’exception (très) notable et logique du Fairphone 5. Et les seuls appareils supportés sont les Pixel 8 (tous les modèles) et la gamme Galaxy S24 de Samsung. Il s’agit donc de haut de gamme, voire de très haut de gamme, pour des appareils comme le Pixel 8 Pro ou le Galaxy S24 Ultra.

D’autre part, Apple parle d’un support minimal de cinq ans. En pratique, de nombreux appareils ont été mis à jour pendant six ou sept ans, comme le rappellent nos confrères d’iGeneration. Il est arrivé également à Apple de diffuser des mises à jour de sécurité pour des appareils qui n’étaient plus censés en recevoir. En janvier par exemple, pour les iPhone 6s, 7, SE, 8 et X, des appareils ayant entre 7 et 9 ans. L’iPhone XR, sorti en 2018, tourne actuellement sous iOS 17.5, soit la dernière révision du système. Le Pixel 4a, sorti il y a quatre ans, n’aura pas droit à Android 15.

Enfin, cette période de cinq ans minimum est valable pour l’ensemble des modèles, pas uniquement les derniers ou le haut de gamme. Mais Apple ne fait pas non plus d’entrée de gamme, du moins pas de smartphone à moins de 200 euros, alors qu’ils sont légion sur Android. Un marché que Google a largement contribué à créer.

Les smartphones, ces produits jetables

Que des entreprises prennent enfin au sérieux un critère aussi important est une très bonne raison de se réjouir. Un support logiciel limité expose non seulement la clientèle aux dangers d’un système d’exploitation laissé sans correctifs de sécurité, mais engendre une consommation accrue de ressources.

Les smartphones sont encore trop souvent considérés comme des produits presque jetables. Les constructeurs en font leur beurre, la plupart des gammes étant renouvelées chaque année. Et chaque année, il faut trouver des raisons de motiver cette même clientèle à changer d’appareil. Limiter les mises à jour d’Android – et donc l’arrivée de fonctions majeures – était un moyen parmi d’autres. C’est néanmoins moins vrai depuis plusieurs années, car les versions se succèdent sans gros changements pour les utilisateurs.

Google et Samsung sont les premiers gros fabricants à proposer sept ans pour leurs appareils. Mais il faut encore que la pratique s’étende et fasse tache d’huile. Consciente que ses « partenaires » ne jouent pas le jeu, Google passe certaines mises à jour importantes par le Play Store. Mais même ainsi, cela ne règle pas tous les soucis et tous les fabricants doivent jouer le jeu.

Le grand cirque va devoir prendre fin

D’autre part, l’Europe s’apprête à sonner la fin de la récréation. Le 20 juin entrera en vigueur une extension du règlement sur l’économie circulaire. Elle introduira notamment la note de réparation et l’obligation de transparence sur certains aspects. Surtout, elle obligera les constructeurs à proposer des mises à jour logicielles pendant au moins cinq ans après mise sur le marché. Ce qui signifie en pratique six ou sept ans de mises à jour dans la plupart des cas.

Attention, on parle bien de mises à jour de sécurité. Dans l’absolu, rien ne forcera les constructeurs à proposer de nouvelles versions majeures de leur système. Mais l’important concerne bien la sécurité, afin qu’un appareil gardé durant plusieurs années continue d’être protégé. D’autant que le règlement concernera l’intégralité des appareils mis sur le marché après cette date (le changement n’est pas rétroactif).

Il est probable que cette bascule aura un impact important sur la manière dont les constructeurs mettent des appareils sur le marché. L’entretien s’avérant mathématiquement plus couteux, l’une des voies serait le resserrement des gammes et donc la réduction du nombre de modèles proposés. Mais il n’est pas certain que cette perspective enchante particulièrement les entreprises : la durabilité n’est pas toujours retenue comme argument fort dans les stratégies commerciales.

Voici un bon complément aux résultats financiers pour Q1 2024 d’Intel, NVIDIA et AMD : le rapport de JPR sur la situation du marché de la carte graphique dédié pour desktop pour la même période. Tout d’abord, l’analyste salue le retour d’un semblant de saisonnalité pour le marché de la carte graphiq...

Voici un bon complément aux résultats financiers pour Q1 2024 d’Intel, NVIDIA et AMD : le rapport de JPR sur la situation du marché de la carte graphique dédié pour desktop pour la même période. Tout d’abord, l’analyste salue le retour d’un semblant de saisonnalité pour le marché de la carte graphiq...

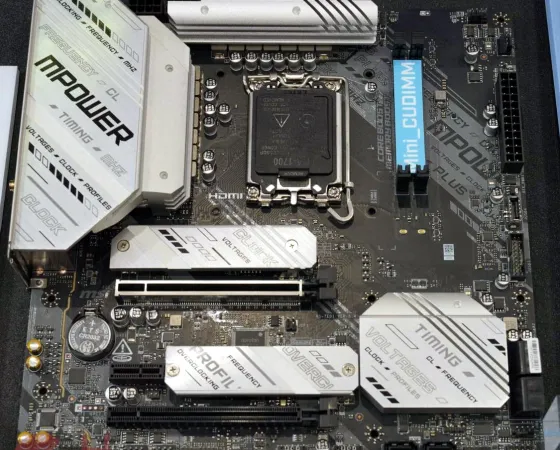

À l'ombre de CAMM2 qui a captivé bien plus l'attention, il faut admettre que le format Mini-CUDIMM est passé un peu plus inaperçu et pourtant, il est standardisé par le JEDEC depuis janvier 2024 ! Il faut dire que le Mini-Clocked Unbuffered Dual Inline Memory Module chamboule de prime abord beaucou...

À l'ombre de CAMM2 qui a captivé bien plus l'attention, il faut admettre que le format Mini-CUDIMM est passé un peu plus inaperçu et pourtant, il est standardisé par le JEDEC depuis janvier 2024 ! Il faut dire que le Mini-Clocked Unbuffered Dual Inline Memory Module chamboule de prime abord beaucou...

Deepcool a su se faire une sacrée bonne image en matière de refroidissement. Jadis plutôt considéré comme du low cost mal fagoté, la firme fait des productions dont l'usinage n'a à rougir de rien face aux autres marques leader du secteur. Et ce n'est pas son fleuron aircooling qui prouvera le contra...

Deepcool a su se faire une sacrée bonne image en matière de refroidissement. Jadis plutôt considéré comme du low cost mal fagoté, la firme fait des productions dont l'usinage n'a à rougir de rien face aux autres marques leader du secteur. Et ce n'est pas son fleuron aircooling qui prouvera le contra...

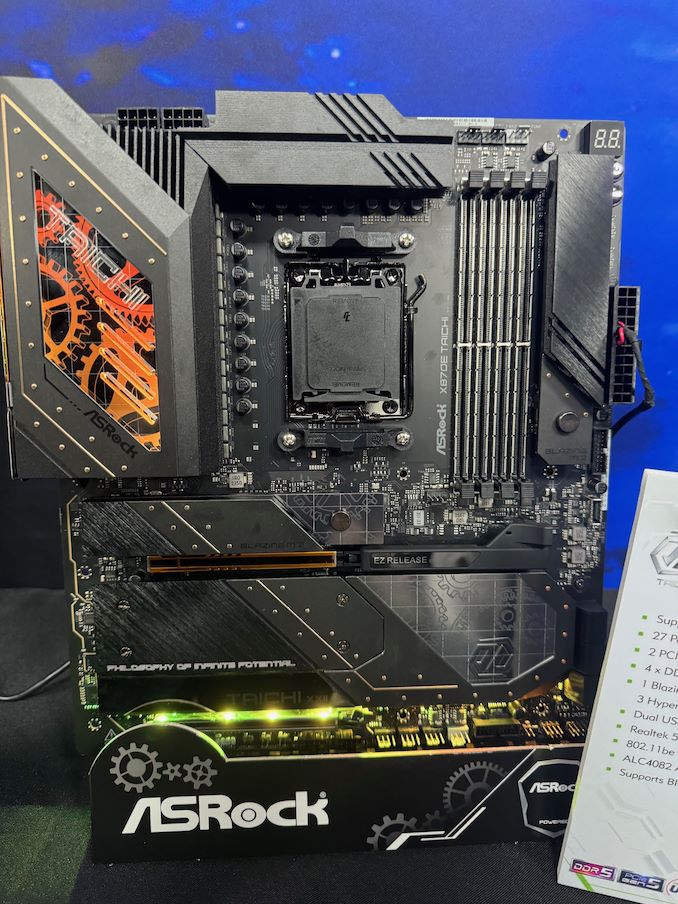

Computex 2024 - Nous vous parlions des modules CAMM2 de Kingston hier. Ce format, normalisé par le JEDEC fin 2023, a essaimé sur de nombreux stands...

Computex 2024 - Nous vous parlions des modules CAMM2 de Kingston hier. Ce format, normalisé par le JEDEC fin 2023, a essaimé sur de nombreux stands...