Vue lecture

Kingston lance une version de 8 To de son SSD FURY Renegade G5, pour ceux qui ont les bourses pleines !

Kingston possède une gamme de SSD NVMe PCIe 5.0 moins en vue que les marques plus classiques comme Corsair, Crucial ou Lexar, mais elle a le mérite d'exister et d'étayer l'offre. Aujourd'hui, un modèle de 8 To arrive sur le marché, il est d'ores et déjà trouvable sur Mazone sous le nom de Kingston F...

Kingston possède une gamme de SSD NVMe PCIe 5.0 moins en vue que les marques plus classiques comme Corsair, Crucial ou Lexar, mais elle a le mérite d'exister et d'étayer l'offre. Aujourd'hui, un modèle de 8 To arrive sur le marché, il est d'ores et déjà trouvable sur Mazone sous le nom de Kingston F...

Le Steam Deck hérite d’un mode basse consommation

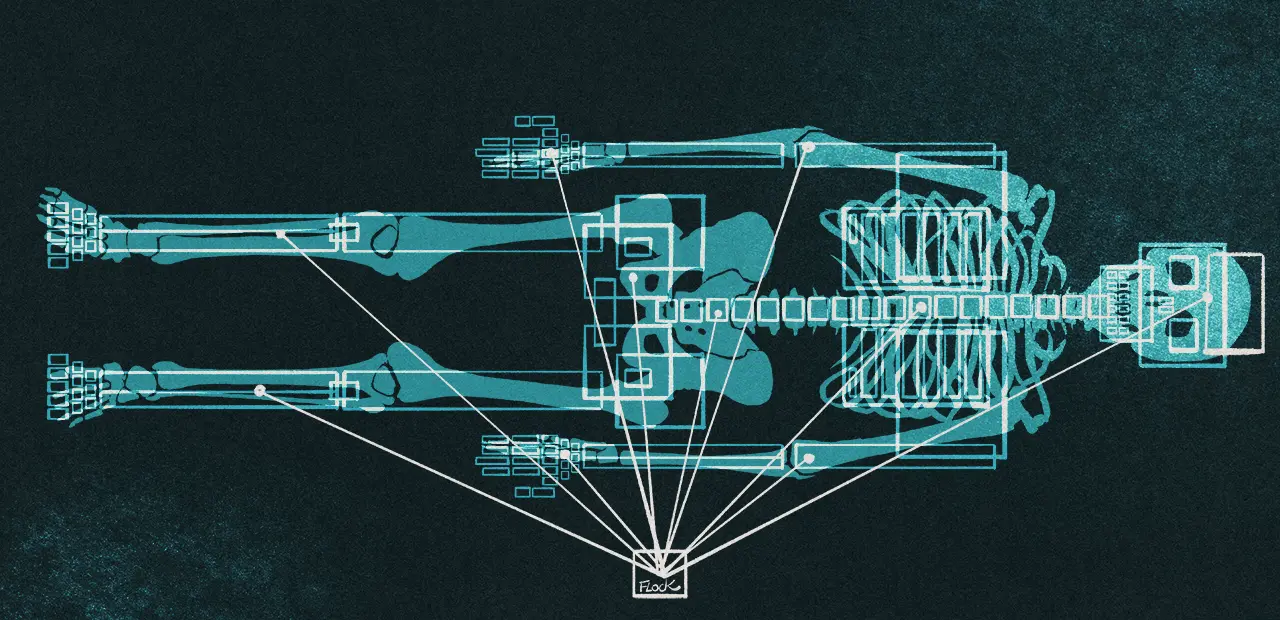

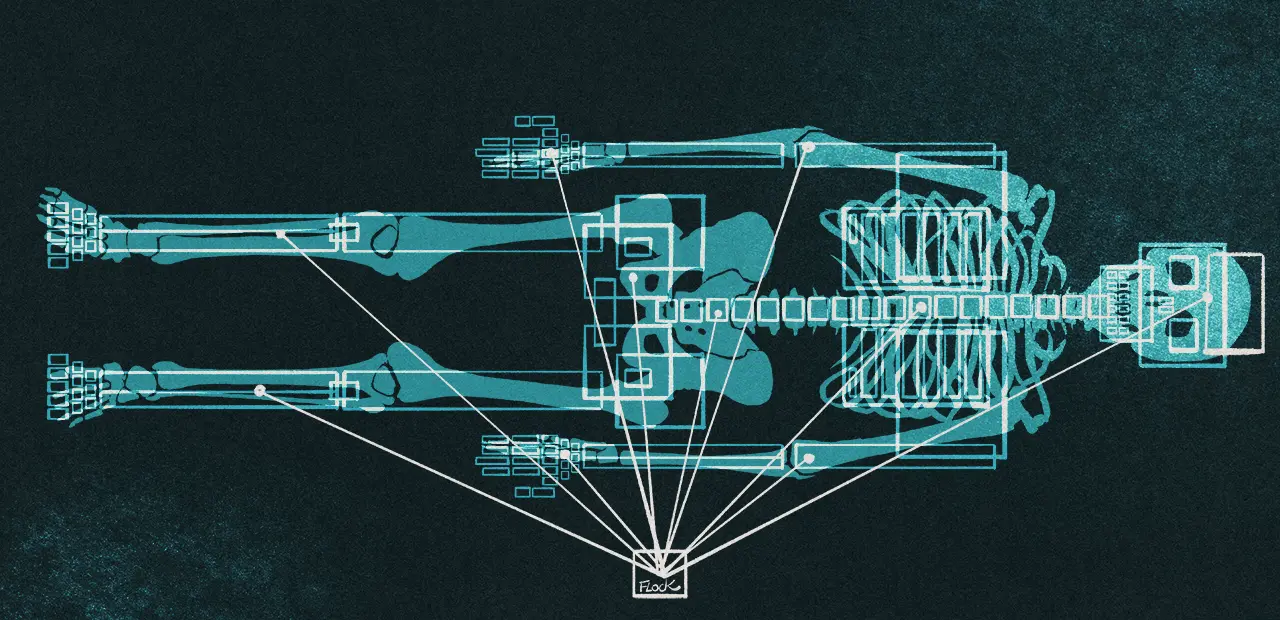

Proposé en mode Beta et Preview de la console, le mode basse consommation va permettre de basculer le Steam Deck dans un état dans lequel il limitera radicalement l’usage de sa batterie, mais sans s’éteindre complètement. Un mode limité, mais suffisant pour, par exemple, télécharger des données.

C’est un des défauts des consoles de jeux de ce type. Elles n’ont pas forcément une connexion au réseau très rapide et doivent télécharger des jeux pesant de gros paquets de gigaoctets. On les laisse donc trainer sur un dock ou au bout d’un câble le temps qu’elles finissent cette corvée. Mais il arrive également qu’on se retrouve à devoir télécharger des données de manière impromptue, loin de toute prise d’alimentation. Pour des mises à jour par exemple. Et là, la console reste allumée au maximum de ses capacités pour une tâche n’en nécessitant pas autant.

Un mode basse consommation très logique

Pour éviter cela, Valve a donc décidé d’initier une mise à jour qui permettra de basculer la console en mode basse consommation. Un protocole tout simple qui éteindra l’écran et limitera les dépenses énergétiques non nécessaires. En activant cette option dans les paramètres de l’alimentation, on pourra basculer la console dans une semi léthargie technique. En appuyant sur le bouton de démarrage, la console demandera si vous voulez passer en basse consommation ou éteindre. Si vous faites le premier choix, le Stem Deck éteindra son écran et continuera d’effectuer les tâches demandées. Par exemple, le téléchargement de données en Wi-Fi. LEs 22 Go de mise à jour de votre SuperJeu pourra donc se faire sans dépenser l’énergie nécessaire au rétro éclairage de l’écran. Aucune informations sur la mise en veille d’autres postes. On se doute que le stockage et la mémoire resteront actifs, mais le système pourrait également éteindre des cœurs du processeur, couper au maximum le circuit graphique et limiter la fréquence de la puce.

Valve a bien peaufiné sa solution et proposera de réveiller la machine à moitié pour vérifier l’état des opérations. En appuyant sur un bouton, l’écran s’allumera à nouveau pour vous indiquer la progression de vos téléchargements. Vous pourrez alors choisir de la réveiller ou de la replonger dans sa cryostase. Si, avant la fin de son téléchargement, vous la laissez tranquille, alors elle finira par s’éteindre complètement. À noter que pour être certain de ne pas pousser la batterie dans un mode de décharge complet, le système s’arrêtera de lui-même lorsque vous atteindrez 20% de capacité. Et cela même si vos téléchargements ne sont pas terminés.

La solution est à la fois simple et élégante. Elle permettra par exemple de mettre en charge votre Steam Deck pour la nuit sur son dock. Tout en lui demandant de lancer ses mises à jour puis de la basculer dans ce mode basse consommation pour qu’elle télécharge vos données avant de s’éteindre toute seule.

Valve joue ici avec les possibilités des machines modernes de réguler leur consommation. Compétences que l’on connait bien dans le monde des portables, mais souvent encore peu ou mal employées. On a croisé, par exemple, des MiniPC AMD qui permettent de basculer entre plusieurs modes d’usage pour limiter leur consommation et leur ventilation. On imagine qu’il serait possible de jouer avec beaucoup plus de paramètres et de créer des profils techniques assez vastes. Les constructeurs de portables jouent ainsi sur la baisse de la luminosité des écrans, la limitation en fréquence des puces sur batterie et autres techniques visant à augmenter l’autonomie. L’option de mettre à jour avant d’arrêter sa machine est également présente sur des systèmes d’exploitation depuis longtemps. Mais les utilisateurs ont très rarement la main sur ces options qui restent souvent à la discrétion seule des constructeurs.

Source : Valve

Le Steam Deck hérite d’un mode basse consommation © MiniMachines.net. 2025

La Haute Autorité de santé dit oui à l’IA, mais pas n’importe comment

Pas si évident

La HAS a publié le 30 octobre un guide pédagogique sur l’utilisation de l’intelligence artificielle générative dans l’ensemble du secteur sanitaire, social et médico-social. L’autorité ne s’oppose pas à cette utilisation, mais elle pointe très vite les deux problèmes majeurs : la sensibilité des données manipulées et la fiabilité des résultats.

Les données de santé sont une mine d’or. Selon comment elles sont exploitées, elles peuvent permettre le suivi de l’efficacité des traitements, faire apparaitre des corrélations, étudier des prévalences et autres.

Ce caractère précieux est au cœur de plusieurs décisions politiques. En France, il y a bien sûr le HDH (Health Data Hub) et ses décisions sulfureuses d’hébergement chez Microsoft, pointées constamment par le député Philippe Latombe, des rapports interministériels ou même encore récemment par la Cour des comptes. L’entrepôt de données européen EMC2 a le même problème.

Mais les objectifs sont à chaque fois les mêmes : concentrer les données, favoriser les travaux des chercheurs, servir de guichet unique et, bien sûr, permettre à terme le traitement des données par l’IA. Dans le cadre du projet EMC2 d’ailleurs, l’Agence européenne du médicament abordait explicitement cette finalité.

La Haute Autorité de santé publie donc un avis sur la question, même s’il peut sembler tardif. Dans les grandes lignes toutefois, la HAS ne réagit pas spécifiquement sur l’exploitation des données, mais vise les professionnels de santé et l’utilisation de l’IA comme aide à la décision.

Quatre lignes directrices

La HAS publie principalement quatre conseils, rassemblés sous l’appellation : AVEC, pour « Apprendre, Vérifier, Estimer et Communiquer ».

Pour l’apprentissage, la HAS recommande chaudement aux professionnels de se former sur les outils qu’ils utilisent. Les IA peuvent faire gagner du temps, mais la plupart n’ont pas été formées sur les questions de santé. Les professionnels devraient ainsi s’interroger sur les modalités d’utilisation, les règles liées à la confidentialité des données personnelles ou encore effectuer des tests pratiques avant de se lancer dans une pratique quotidienne.

Sur la vérification, la HAS conseille la prudence face aux résultats renvoyés par l’IA : « le professionnel est attentif à la pertinence de son usage, à la qualité de sa requête et au contrôle du contenu généré ». Ce qui inclut de ne pas partager d’informations confidentielles et de considérer chaque réponse comme une proposition et non une vérité. La fiabilité des réponses de l’IA ne pouvant par définition être garantie (approche probabiliste), elles peuvent contenir des erreurs : valeurs et unités des quantités chiffrées, noms des médicaments, etc. On l’a vu récemment dans nos propres tests, l’IA peut se tromper lourdement dans la méthode de calcul.

L’estimation concerne l’analyse régulière de l’adéquation entre les besoins et les résultats. Les professionnels de santé sont ainsi invités à réinterroger sa pratique : des corrections ont-elles été nécessaires ? Si oui, à quelle fréquence ? L’outil est-il simple d’utilisation ? A-t-il pu être intégré dans des flux de travail existants ? En somme, la HAS souhaite que les professionnels s’interrogent sur les gains apportés face aux contraintes.

Enfin, pour la communication, la Haute Autorité est claire : les professionnels devraient échanger avec les patients autour de l’usage de l’IA. L’autorité leur recommande également de favoriser les retours d’expérience avec d’autres utilisateurs et développer « une démarche de transparence autour des typologies de données partagées, de l’adhésion au sein de sa structure et des impacts organisationnels ».

Le danger des mauvaises pratiques

De manière générale, la HAS souhaite que chaque usage de l’IA générative soit « conscient, supervisé et raisonné ».

Cependant, même si elle peut « devenir une alliée » quand elle est « bien maitrisée », l’autorité pointe également les dangers inhérents à son utilisation. Elle met en garde contre les erreurs pouvant survenir dans les réponses envoyées, notamment quand elles se fondent sur des données non vérifiées. Surtout, elle pointe les hallucinations, soit des informations fausses mais qui peuvent paraitre convaincantes.

Outre les dangers propres à l’IA elle-même, la HAS signale de mauvais comportements chez les professionnels eux-mêmes, dont l’utilisation d’informations confidentielles dans les requêtes, expliquant les conseils sur la communication avec les patients.

Dans l’ensemble, l’autorité évoque un potentiel prometteur sur l’ensemble de ces technologies. Elle ne parle d’ailleurs pas uniquement des interfaces questions/réponses des chatbots, mais aussi d’autres outils devenus très courants : transcriptions de conversations lors de consultations, synthèses de littérature scientifique, création de documents illustrés pour expliquer des parcours médicaux-sociaux, préremplissage de documents administratifs, traductions de textes pour des personnes non-francophones, etc. Tous peuvent faire gagner du temps (voire beaucoup), mais le risque d’erreur est le même dans tous les cas de figure dès que l’outil utilise l’IA générative.

Enfin, outre les erreurs, les professionnels ont tout intérêt à se former pour s’acclimater à des concepts centraux de l’IA générative. Par exemple, les réponses peuvent varier dans le temps, notamment en fonction de la version du modèle et des données utilisées pour l’entrainement. La qualité de la réponse peut aussi fortement varier selon le soin apporté à la question (prompt).

Pour les personnes intéressées, la HAS a donc publié deux versions de ses recommandations : une complète d’une quinzaine de pages (PDF), et une concise rassemblant les principales informations sur une seule page (PDF). Administration publique oblige, la HAS a également publié un rapport sur l’élaboration de son guide et les méthodes utilisées (PDF).

La Haute Autorité de santé dit oui à l’IA, mais pas n’importe comment

Pas si évident

La HAS a publié le 30 octobre un guide pédagogique sur l’utilisation de l’intelligence artificielle générative dans l’ensemble du secteur sanitaire, social et médico-social. L’autorité ne s’oppose pas à cette utilisation, mais elle pointe très vite les deux problèmes majeurs : la sensibilité des données manipulées et la fiabilité des résultats.

Les données de santé sont une mine d’or. Selon comment elles sont exploitées, elles peuvent permettre le suivi de l’efficacité des traitements, faire apparaitre des corrélations, étudier des prévalences et autres.

Ce caractère précieux est au cœur de plusieurs décisions politiques. En France, il y a bien sûr le HDH (Health Data Hub) et ses décisions sulfureuses d’hébergement chez Microsoft, pointées constamment par le député Philippe Latombe, des rapports interministériels ou même encore récemment par la Cour des comptes. L’entrepôt de données européen EMC2 a le même problème.

Mais les objectifs sont à chaque fois les mêmes : concentrer les données, favoriser les travaux des chercheurs, servir de guichet unique et, bien sûr, permettre à terme le traitement des données par l’IA. Dans le cadre du projet EMC2 d’ailleurs, l’Agence européenne du médicament abordait explicitement cette finalité.

La Haute Autorité de santé publie donc un avis sur la question, même s’il peut sembler tardif. Dans les grandes lignes toutefois, la HAS ne réagit pas spécifiquement sur l’exploitation des données, mais vise les professionnels de santé et l’utilisation de l’IA comme aide à la décision.

Quatre lignes directrices

La HAS publie principalement quatre conseils, rassemblés sous l’appellation : AVEC, pour « Apprendre, Vérifier, Estimer et Communiquer ».

Pour l’apprentissage, la HAS recommande chaudement aux professionnels de se former sur les outils qu’ils utilisent. Les IA peuvent faire gagner du temps, mais la plupart n’ont pas été formées sur les questions de santé. Les professionnels devraient ainsi s’interroger sur les modalités d’utilisation, les règles liées à la confidentialité des données personnelles ou encore effectuer des tests pratiques avant de se lancer dans une pratique quotidienne.

Sur la vérification, la HAS conseille la prudence face aux résultats renvoyés par l’IA : « le professionnel est attentif à la pertinence de son usage, à la qualité de sa requête et au contrôle du contenu généré ». Ce qui inclut de ne pas partager d’informations confidentielles et de considérer chaque réponse comme une proposition et non une vérité. La fiabilité des réponses de l’IA ne pouvant par définition être garantie (approche probabiliste), elles peuvent contenir des erreurs : valeurs et unités des quantités chiffrées, noms des médicaments, etc. On l’a vu récemment dans nos propres tests, l’IA peut se tromper lourdement dans la méthode de calcul.

L’estimation concerne l’analyse régulière de l’adéquation entre les besoins et les résultats. Les professionnels de santé sont ainsi invités à réinterroger sa pratique : des corrections ont-elles été nécessaires ? Si oui, à quelle fréquence ? L’outil est-il simple d’utilisation ? A-t-il pu être intégré dans des flux de travail existants ? En somme, la HAS souhaite que les professionnels s’interrogent sur les gains apportés face aux contraintes.

Enfin, pour la communication, la Haute Autorité est claire : les professionnels devraient échanger avec les patients autour de l’usage de l’IA. L’autorité leur recommande également de favoriser les retours d’expérience avec d’autres utilisateurs et développer « une démarche de transparence autour des typologies de données partagées, de l’adhésion au sein de sa structure et des impacts organisationnels ».

Le danger des mauvaises pratiques

De manière générale, la HAS souhaite que chaque usage de l’IA générative soit « conscient, supervisé et raisonné ».

Cependant, même si elle peut « devenir une alliée » quand elle est « bien maitrisée », l’autorité pointe également les dangers inhérents à son utilisation. Elle met en garde contre les erreurs pouvant survenir dans les réponses envoyées, notamment quand elles se fondent sur des données non vérifiées. Surtout, elle pointe les hallucinations, soit des informations fausses mais qui peuvent paraitre convaincantes.

Outre les dangers propres à l’IA elle-même, la HAS signale de mauvais comportements chez les professionnels eux-mêmes, dont l’utilisation d’informations confidentielles dans les requêtes, expliquant les conseils sur la communication avec les patients.

Dans l’ensemble, l’autorité évoque un potentiel prometteur sur l’ensemble de ces technologies. Elle ne parle d’ailleurs pas uniquement des interfaces questions/réponses des chatbots, mais aussi d’autres outils devenus très courants : transcriptions de conversations lors de consultations, synthèses de littérature scientifique, création de documents illustrés pour expliquer des parcours médicaux-sociaux, préremplissage de documents administratifs, traductions de textes pour des personnes non-francophones, etc. Tous peuvent faire gagner du temps (voire beaucoup), mais le risque d’erreur est le même dans tous les cas de figure dès que l’outil utilise l’IA générative.

Enfin, outre les erreurs, les professionnels ont tout intérêt à se former pour s’acclimater à des concepts centraux de l’IA générative. Par exemple, les réponses peuvent varier dans le temps, notamment en fonction de la version du modèle et des données utilisées pour l’entrainement. La qualité de la réponse peut aussi fortement varier selon le soin apporté à la question (prompt).

Pour les personnes intéressées, la HAS a donc publié deux versions de ses recommandations : une complète d’une quinzaine de pages (PDF), et une concise rassemblant les principales informations sur une seule page (PDF). Administration publique oblige, la HAS a également publié un rapport sur l’élaboration de son guide et les méthodes utilisées (PDF).

systemd-appd Is A New Component Being Planned By Flatpak Developers

NVIDIA fait un très beau geste pour l'utilisateur qui a endommagé le connecteur de sa RTX 5090 FE

Alors que la GeForce RTX 5090 Founders Edition de NVIDIA fait rêver avec son format moindre et ses performances stratosphériques, un retour terrain vient un peu ternir l'image de cette carte hors norme. Le spécialiste en réparation NorthridgeFix tire en effet la sonnette d'alarme : la carte serait particulièrement difficile à démonter et à réparer, voire même quasi impossible à remettre en état dans certains cas.Le principal souci viendrait d'un connecteur interne très fragile reliant certaines parties du PCB et du système de refroidissement. Ce connecteur n'est pas conçu pour supporter plusieurs démontages et pourrait facilement s'endommager lors d'une intervention, notamment pour ceux qui envisagent un changement de pâte thermique ou l'installation d'un waterblock. […]

Lire la suiteLes LABOS Seasonic à TAIPEI, la technologie avant tout !!!

Nous vous proposons maintenant de découvrir les laboratoires de Seasonic à Taipei. C'est ici que sont pensées, développés et testées les alimentations de la marque. Vous allez ainsi découvrir l'envers du décor de cette marque emblématique dans ce domaine. […]

Lire la suiteSeasonic, 50 ans d'innovations aux services de nos alimentations

Nous vous proposons, toujours dans le cadre de notre CCL Tech Tour 2025, de revenir sur les 50 ans de la marque Seasonic, un acteur ô combien important et incontournable quand on parle d'alimentation PC. Comme vous allez le voir, la marque taïwanaise ne fait pas que produire des blocs, en effet, elle est à la pointe de la technologie et des innovations. […]

Lire la suiteLa console Nintendo Switch 2 se vend toujours TRES bien !

La nouvelle petite, pas si petite, console de Nintendo cartonne... Cette nouvelle déclanaison de la Switch que nous vous avons fait découvrir ici même : Nintendo Switch 2, nos premières impressions, se vend comme des petits pains. Nintendo vient de l'annoncer, la Nintendo Switch 2 est déjà la console la plus vendue de la marque en aussi peu de temps. Vous êtes prêts, nous allons vous donner le chiffre, roulement de tambour. […]

Lire la suiteJONSBO X400, un style connu pour un flux d'air revu

Après le BO400, JONSBO revient avec un nouveau boitier qui reprend le même style tout an apportant des changements significatifs au niveau du châssis, avec notamment deux emplacements de 120 mm sur l'arrière et donc une plus grande polyvalence pour le refroidissement. Relativement imposant avec des dimensions de 460.2 x 310.3 x 476.5 mm, le X400 se démarque surtout sur un point qu'on ne voit pas au premier coup d'oeil : un nouvel emplacement en 2 x 120 mm dans la continuité du plateau de la carte mère avec un déflecteur qui va rediriger l'air vers le processeur. Pratique si on installe un AIO avec un radiateur de 360 mm dans le haut pour refroidir les VRM ? […]

Lire la suiteSeagate LaCie Rugged SSD4, un SSD externe rapide et costaud !

Cela fait maintenant plusieurs années que la série LaCie Rugged nous accompagne, avec des mises à jours diverses et variées en fonction des évolutions technologiques. Récemment, Seagate est revenu avec un modèle en USB4 annoncé à 4000 Mo/s en lecture et 3000 Mo/s en écriture. Un disque externe assez gros pour ne pas le perdre sans prendre trop de place dans un sac, une couleur orange qui ne passe pas inaperçue, mais surtout de gros débits ! A découvrir ici : Seagate LaCie Rugged SSD4, un SSD externe rapide et costaud ! ou sur la source. […]

Lire la suiteCall of Duty: Black Ops 7 précise ses recommandations hardware

Un premier teaser vient d'être dévoilé pour le jeu Call of Duty: Black Ops 7, ce dernier est plutôt long, un peu plus de trois minutes, mais en dévoile malheureusement pas de gameplay. On apprend, juste, que les événements feront suite à ceux vécus dans Black Ops 2 et Black Ops 6. Nous nous situerons dans un futur proche, 2035, dans un monde qui promet d'être dévasté, la campagne devrait faire la part belle au coop et le multijoueur devrait acceuillir de nouvelles maps. Le jeu est déjà listé sur Steam et Battlenet. […]

Lire la suiteGMK M8 : la fin de traine de la norme OCuLink ?

Avec un design hérité d’une gamme précédente et un processeur particulier, le GMK M8 est pour le moment uniquement annoncé en Chine. Ce MiniPC est équipé d’une puce assez particulière. De génération Rembrandt, le Ryzen 5 Pro 6650H développe six cœurs Zen3+ pour 12 threads cadencés de 3.3 à 4.5 GHz. Il propose un circuit graphique AMD Radeon 660M à 1.9 Hz sur 6 Compute Units.

Le GMK M8 mets en avant le « tout nouveau » Ryzen 5 Pro 6650H de 2022…

Pour comprendre cette puce et le GMK K8, il faut revenir un peu en arrière. Ce Ryzen 5 Pro 6650H est une version créée sur mesures pour des machines à vocation entreprise. AMD a pris un Ryzen 5 6600H classique et l’a modifié en partie pour coller à ce besoin précis. En baissant le nombre de Compute Units de son moteur graphique de 12 à 6 et en ajoutant des fonctions de sécurité Microsoft Pluton sur la puce, AMD obtenait une solution parfaite pour équiper des postes classiques pour des travaux de bureau.

Le circuit graphique du Ryzen 5 6600H est beaucoup plus performant pour le grand public avec des fonctions de calculs largement plus évoluées. Ce qui n’a pas rendu le 6650H très séduisant pour les fabricants. A vrai dire, si vous faites une recherche de ce 6650h sur minimachines, vous risquez de ne rien trouver.

Alors pourquoi GMKtec s’en est emparé pour ce GMK M8 ? Il y a bien sûr la possibilité de mettre la main sur un lot de puces disponibles à un bon prix. Je crois que c’est souvent le point de départ de beaucoup de productions rapides de ce type. L’occasion faisant le larron, la disponibilité de ces processeurs permet de lancer une production sur une carte mère précédente en utilisant des châssis existants. C’est, j’imagine, exactement le scénario qui explique la naissance de ce MiniPC aujourd’hui. Cela ne résout pas le souci d’un processeur fort peu attirant pour les particuliers. Et pour compenser ce détail, le constructeur emploie un argument un peu bancal. La possibilité d’adjoindre une carte graphique externe via une connexion OCuLink.

Pourquoi bancal ? Parce que énormément d’indices montrent aujourd’hui que cette connexion qui permet de monter une solution graphique en externe sont en train d’être abandonnés au profit de solutions Thunderbolt 4/5 et USB4V2. Les défauts de l’OCuLink étant assez nombreux avec un coût d’implantation élevé, une limitation d’usage et, apparemment, pas mal de problèmes de SAV. Les utilisateurs de ce type de ports, biberonnés aux usages de l’USB, n’arrivant pas à enregistrer le fait qu’il est impossible de le brancher et de le débrancher à chaud. Cela crée beaucoup de problèmes pour les marques qui l’emploient.

En additionnant un Ryzen 5 6650H et une carte graphique PCIe sur un dock externe, on aura sans doute une bonne solution. Encore qu’il faille faire ses comptes et souvent posséder déjà une carte graphique de ce type a recycler pour que le jeu en vaille la chandelle. Petit bémol secondaire sur cette minimachine ne propose pas une évolutivité parfaite, la mémoire vive est soudée en LPDDR5-6400 et restera donc limitée au 16 Go d’origine. Le stockage pourra évoluer de son côté avec deux emplacements M.2 2280 NVMe PCIe 3.0.

Le tout est enfermé dans un boitier dont GMK est assez fier puisqu’il lui a permis de récolter un prix de design Red Dot Award. Je ne vais pas juger de la pertinence du goût de ce boitier, mais il s’agissait de la présentation d’une autre machine. Ici le GMK M8 est un clone du boitier primé qui était le GMK EVO-X1 sous processeur Strix Point.

Pour le reste, on retrouve un MiniPC classique chez le constructeur. Au niveau de sa connectique, on découvre sur la face avant le fameux port OCuLink, un USB4, deux USB 3.2 Gen2 Type-A et un jack audio combo 3.5 mm.

Sur la partie arrière, un USB 3.2 Type-A et un USB 2.0 Type-A, une sortie HDMI et un DisplayPort, deux ports Ethernet 2.5 Gigabit, un Jack d’alimentation et un Antivol type Kensington Lock. Un module réseau interne proposera du Wi-Fi6E et du Bluetooth 5.2.

Quel bilan pour ce GMK M8 ? Difficile de savoir comment le prendre en compte puisque pour le moment aucun détail de communication n’a émergé. En Chine l’engin est annoncé à partir e 1999 Yuans avec un SSD de 512 Go. Cela représente environ 245€ Hors Taxes. Un modèle 16Go/1To est indiqué à 2299 Yuans soit 280€ HT. Ce n’est évidemment pas très cher, mais plein de compromis. Si on ajoute simplement 20% de TVA, on passe à 300 et 340€.

Il est possible de trouver facilement un MiniPC sous Ryzen 5 6600H en 16/512 Go pour 210€ aujourd’hui comme le Chuwi UBox que je remontais en bon plan le 14 octobre dernier. Il n’offrira pas la connectique OCuLink mais proposera de l’USB4, un niveau de performances supérieur à ce que cet engin propose, de l’évolutivité de mémoire, et un prix très abordable. Il n’aura pas accès aux fonctions Microsoft Pluton qui sont des éléments de sécurité propres à l’écosystème Windows. Mais pour un usage en tant que particulier, cela n’a aucun intérêt.

GMK M8 : la fin de traine de la norme OCuLink ? © MiniMachines.net. 2025

Trump Re-Nominates Billionaire Jared Isaacman To Run NASA

Read more of this story at Slashdot.

☕️ iOS, iPadOS et macOS 26.1 : Liquid Glass teinté et correctifs silencieux

Apple a publié lundi soir les versions 26.1 pour l’ensemble de ces systèmes. Si vous avez installé la version 26 sur votre iPhone ou votre Mac et que vous n’êtes pas fan de l’interface Liquid Glass, la version 26.1 intègre désormais un réglage « teinté » qui réduit nettement la transparence, comme nous l’indiquions le 24 octobre.

iOS 26.1 propose d’autres améliorations, dont l’apparition d’un bouton à faire glisser pour arrêter l’alarme, la possibilité de faire glisser son doigt sur le titre en cours dans Musique pour passer au morceau précédent ou suivant, le retour de Slide Over sur iPad ou encore une option pour désactiver le glissement vers l’appareil photo depuis l’écran verrouillé. On note aussi l’amélioration de la qualité audio pour les appels FaceTime quand les conditions réseau sont mauvaises.

Côté macOS Tahoe, la version 26.1 donne la même option de réduction de la transparence pour Liquid Glass, ajoute le supporte d’AutoMix sur AirPlay pour Musique, ou encore le retour des coins carrés pour l’affichage des PDF dans Aperçu.

Les versions 26.1 contiennent en outre une autre amélioration, commune à toutes les plateformes : elles peuvent installer silencieusement les mises à jour de sécurité considérées comme urgentes. Ce fonctionnement, activé par défaut, permet l’application de correctifs légers pour parer à ces situations urgentes, notamment sur Safari, WebKit ou « d’autres bibliothèques système », comme le précise Apple sur la page dédiée.

On peut désactiver ce fonctionnement dans Paramètres > Confidentialité et sécurité > Améliorations de la sécurité en arrière-plan. Couper cette fonction n’est cependant pas recommandé, puisqu’elle permet par exemple de diffuser rapidement un correctif pour une ou plusieurs failles dans le navigateur. En cas de désactivation, ces correctifs seront appliqués avec la mise à jour mineure suivante du système, mais la fonction a l’avantage de le faire sans interaction et surtout sans redémarrage.

Comme l’a remarqué iGen, la fonction n’est pas totalement nouvelle et est davantage « une remise à plat des mises à jour de sécurité urgentes d’iOS 16 ». En outre, la fonction est copieusement utilisée pour de nombreuses mises à jour : prise en charge des langues, polices, services de dictée, suggestions, ainsi que des éléments beaucoup plus importants comme les certificats SSL et les firmwares pour les accessoires Apple. Il s’agit donc d’une généralisation de l’ancien mécanisme à un plus grand nombre de composants.

Nous reviendrons dans la journée sur les annonces autour des versions 26.2 et du méchant « DMA ».

Ophélie Coelho : « L’Europe n’a aucun intérêt à reproduire le modèle technologique américain »

Techno cherche chef d'orchestre

Spécialiste de la Géopolitique du numérique, la chercheuse Ophélie Coelho participait aux rencontres publiques organisées en amont du lancement du projet Campus IA. Next s’est entretenu avec elle.

C’est à Fouju, en Seine-et-Marne, que le mégaprojet de centre de données dédié à l’intelligence artificielle Campus IA doit s’étendre. Proche de Melun, la petite commune de 600 habitants devrait accueillir, sur une parcelle de 70 hectares, ce data center dont la puissance de calcul cumulée doit, selon ses promoteurs, équivaloir à terme à 1,4 GW (la puissance d’un réacteur nucléaire).

Porté par le fonds d’investissement des Émirats arabes unis MGX, la société française Mistral AI, l’américain Nvidia et la Banque publique d’investissement, Campus IA représente un investissement de 50 milliards d’euros.

En amont des travaux, une série de rencontres publiques garanties par la Commission nationale du débat public s’échelonne entre le 15 octobre et le 17 novembre 2025 (voir les replays). À ces échanges, le député de Melun Arnaud Saint-Martin (La France Insoumise) ajoute une réunion publique à Crisenoy le 7 novembre 2025 au soir.

Chercheuse à l’Institut des relations internationales et stratégiques (IRIS), autrice de Géopolitique du numérique, l’impérialisme à pas de géants (L’Atelier, 2023), Ophélie Coelho a fait partie des expertes sollicitées pour apporter leur éclairage à ce vaste projet industriel. Next s’est entretenu avec elle.

Les entreprises américaines suivent « une logique d’empire »

>> Quel regard portez-vous sur la consultation publique organisée autour du Campus AI ?

Je ne suis pas forcément au courant de toutes les procédures, mais j’ai toujours l’impression que ces débats sont organisés après la prise de décision. C’est une manière de relever les inquiétudes, mais la machine est déjà en route.

☕️ iOS, iPadOS et macOS 26.1 : Liquid Glass teinté et correctifs silencieux

Apple a publié lundi soir les versions 26.1 pour l’ensemble de ces systèmes. Si vous avez installé la version 26 sur votre iPhone ou votre Mac et que vous n’êtes pas fan de l’interface Liquid Glass, la version 26.1 intègre désormais un réglage « teinté » qui réduit nettement la transparence, comme nous l’indiquions le 24 octobre.

iOS 26.1 propose d’autres améliorations, dont l’apparition d’un bouton à faire glisser pour arrêter l’alarme, la possibilité de faire glisser son doigt sur le titre en cours dans Musique pour passer au morceau précédent ou suivant, le retour de Slide Over sur iPad ou encore une option pour désactiver le glissement vers l’appareil photo depuis l’écran verrouillé. On note aussi l’amélioration de la qualité audio pour les appels FaceTime quand les conditions réseau sont mauvaises.

Côté macOS Tahoe, la version 26.1 donne la même option de réduction de la transparence pour Liquid Glass, ajoute le supporte d’AutoMix sur AirPlay pour Musique, ou encore le retour des coins carrés pour l’affichage des PDF dans Aperçu.

Les versions 26.1 contiennent en outre une autre amélioration, commune à toutes les plateformes : elles peuvent installer silencieusement les mises à jour de sécurité considérées comme urgentes. Ce fonctionnement, activé par défaut, permet l’application de correctifs légers pour parer à ces situations urgentes, notamment sur Safari, WebKit ou « d’autres bibliothèques système », comme le précise Apple sur la page dédiée.

On peut désactiver ce fonctionnement dans Paramètres > Confidentialité et sécurité > Améliorations de la sécurité en arrière-plan. Couper cette fonction n’est cependant pas recommandé, puisqu’elle permet par exemple de diffuser rapidement un correctif pour une ou plusieurs failles dans le navigateur. En cas de désactivation, ces correctifs seront appliqués avec la mise à jour mineure suivante du système, mais la fonction a l’avantage de le faire sans interaction et surtout sans redémarrage.

Comme l’a remarqué iGen, la fonction n’est pas totalement nouvelle et est davantage « une remise à plat des mises à jour de sécurité urgentes d’iOS 16 ». En outre, la fonction est copieusement utilisée pour de nombreuses mises à jour : prise en charge des langues, polices, services de dictée, suggestions, ainsi que des éléments beaucoup plus importants comme les certificats SSL et les firmwares pour les accessoires Apple. Il s’agit donc d’une généralisation de l’ancien mécanisme à un plus grand nombre de composants.

Nous reviendrons dans la journée sur les annonces autour des versions 26.2 et du méchant « DMA ».

Seagate LaCie Rugged SSD4, un SSD externe rapide et costaud !

Le jeu FINAL FANTASY VII REBIRTH se met à jour

Une mise à jour vient d'être déployée pour le jeu FINAL FANTASY VII REBIRTH, comme toujours ladite update se téléchargera automatiquement à l'ouverture de votre launcher, sauf paramétrage contraire de votre part. Square Enix nous promet une amélioration de la stabilité et quelques corrections de bugs, toutefois l'ajout principal semble être l'arrivée du DLSS 4 de NVIDIA. Détails de la mise à jour 1.004 : - Ajout d'une compatibilité avec la génération de trames multiples DLSS *Pour plus de détails sur cette fonctionnalité, veuillez consulter le lien suivant (URL: https://www.nvidia.com/en-us/geforce/news/dlss-4-multi-frame-generation-out-now/). - Amélioration générale de la stabilité du jeu, avec des corrections de bug. […]

Lire la suite