Hop, l’UFC Que Choisir et 20 organisations s’insurgent contre la fin de Windows 10

Tout le monde sous Vista et on n'en parle plus

L’association Halte à l’obsolescence programmée (HOP), l’UFC-Que Choisir et 20 autres organisations ou entreprises lancent un appel à pétition autour de la question de la fin programmée du support de Windows 10. Si leur texte s’adresse en premier lieu à Microsoft, à qui sont réclamés cinq ans supplémentaires de mises à jour, il vise aussi et surtout à sensibiliser l’opinion publique à une possible réponse réglementaire.

À un mois de l’échéance, est-il encore vraiment temps de tirer la sonnette d’alarme ? C’est a priori l’avis des 22 cosignataires d’une pétition baptisée « Non à la taxe Windows », officiellement lancée mardi 16 septembre, pour appeler au maintien des mises à jour de sécurité non payantes de Windows 10 jusqu’en 2030.

Le texte rappelle la fin programmée du support de Windows 10 (sorti pour mémoire en juillet 2015), fixée depuis deux ans au 14 octobre 2025. Une date régulièrement rappelée par l’éditeur, qui en profite pour inciter les utilisateurs à passer vers la dernière version en date de son environnement, et invite ceux dont la machine ne serait pas compatible avec les exigences de Windows 11 à renouveler leur matériel, de préférence au profit d’une machine compatible avec les fonctions d’IA Copilot+.

Paie, passe à la caisse ou tremble ?

À défaut, l’éditeur prévoit des options, payantes ou assorties de certaines obligations d’usage de ses produits, pour prolonger de un à trois ans le support de Windows 10. Une possibilité d’extension que les signataires voient comme un argument à charge pour dénoncer le « hold-up numérique » dont se rendrait coupable Microsoft. Puisque des mises à jour seront distribuées aux souscripteurs de ces options, pourquoi ne pas en faire profiter l’ensemble du parc Windows 10 ?

Les auteurs de la pétition reprennent à leur compte le chiffre, largement repris dans les médias, selon lequel 400 millions de machines dans le monde seraient condamnées à une forme d’impasse, avec d’un côté le renouvellement forcé (et donc la mise au rebut) et de l’autre la perspective de continuer à fonctionner avec une sécurité dégradée faute de correctifs.

À l’appui de leur appel, les 22 premiers cosignataires joignent quelques chiffres censés donner la mesure de l’impact attendu, que ce soit sur le climat ou en termes financiers. « 400 millions d’ordinateurs remplacés, cela représente plus de 70 millions de tonnes de gaz à effet de serre, et l’équivalent du poids de près de 32 000 tours Eiffel de matières premières extraites », écrivent-ils.

L’option permettant de prolonger le support est quant à elle présentée comme une « taxe Windows » dont l’enveloppe pourrait représenter 10,4 milliards d’euros, si l’on compte que 400 millions de machines souscrivent la formule à 30 dollars (soit 26 euros environ) pour un an, et ramènent le chiffre à l’équivalent de 481 000 années de SMIC pour le rendre plus impressionnant. La réalité sera certainement plus nuancée, mais la réalité des cycles de renouvellement en entreprise fait que des millions de machines souscriront probablement le programme ESU (Extended Security Updates), générant de ce fait une manne de revenus pour Microsoft.

Imposer 15 ans de mises à jour par la loi ?

De façon plus concrète, la pétition livre quelques exemples chiffrés, mais anonymes, des conséquences financières attendues dans le secteur public. « HOP a par exemple reçu le témoignage d’un département d’1,3 million d’habitants, pour lequel le remplacement du matériel est estimé à 1,1 million d’euros,

dont un surcoût imprévu de 550 000 €. Une entreprise de service public, qui compte payer les extensions de mise à jour pour ses 48 000 postes incompatibles, devra faire face pour la première année seulement à un coût d’environ 2,5 millions d’euros. », expliquent les signataires dans un dossier de presse (PDF).

Et les auteurs d’appeler à médiatiser un maximum le sujet : « Le cas Windows 10 illustre un modèle économique où les grands acteurs du numérique : Profitent de leur position dominante pour imposer de nouvelles rentes. Font peser le coût de leur stratégie sur les ménages, les services publics et

l’environnement. Dissimulent derrière un discours technologique des impacts environnementaux ».

En réponse, les instigateurs de la démarche expliquent se réunir sous la coordination de HOP, et joindre leur voix à celle de la coalition européenne Right to repair pour demander la fin de ces pratiques d’obsolescence logicielle.

« Plus généralement, nous défendons l’encadrement légal des pratiques, afin d’assurer la mise à disposition gratuite et sans contrepartie des mises à jour logicielles pendant au moins 15 ans, ainsi que l’obligation d’information des utilisateur·ices sur le passage à un système d’exploitation libre. »

Le rappel est effectivement de circonstance : si la décision de Microsoft place les utilisateurs de Windows 10 face à une forme de mur, des alternatives existent, de Linux Mint à GLF OS en passant par tous les autres grands (ou moins grands) noms de la scène du logiciel libre. Reste à savoir si l’éditeur de Redmond finira par faire les frais de ce passage en force.

La pétition, qui comptait 330 signatures lundi soir avant sa médiatisation, réunissait quelque 4 300 noms mardi à 16h30.

AIDA64, c’est le genre de trousse à outil bien pratique du testeur hardware, intégrant un résumé d’informations système, des benchmarks intégrés de mémoire comme de calcul, de quoi surveiller vos températures — et bien plus encore. Nul doute que vous retrouviez ces scores dans nos colonnes, à savoir...

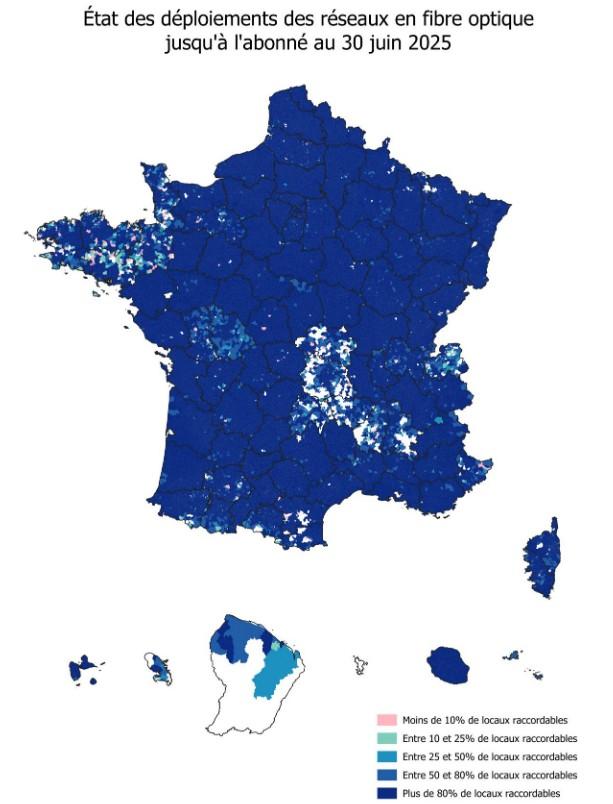

AIDA64, c’est le genre de trousse à outil bien pratique du testeur hardware, intégrant un résumé d’informations système, des benchmarks intégrés de mémoire comme de calcul, de quoi surveiller vos températures — et bien plus encore. Nul doute que vous retrouviez ces scores dans nos colonnes, à savoir... Puisque le rapport 2025 sur l'état de l'Internet en France de l’Arcep vous a intéressés, retrouvons, prenez votre souffle, l’Autorité de Régulation des Communications Électroniques, des Postes et de la distribution de la Presse, pour un nouveau panorama, certes bien moins touffu. L’organisme a publié en fin de semaine dernière son suivi du marché des services fixes à haut et très haut débit du deuxième trimestre...

Puisque le rapport 2025 sur l'état de l'Internet en France de l’Arcep vous a intéressés, retrouvons, prenez votre souffle, l’Autorité de Régulation des Communications Électroniques, des Postes et de la distribution de la Presse, pour un nouveau panorama, certes bien moins touffu. L’organisme a publié en fin de semaine dernière son suivi du marché des services fixes à haut et très haut débit du deuxième trimestre...  Voilà qui ne nous avait pas manqué et semble malheureusement de retour chez AMD. Nous garderons le conditionnel dans cette actualité car le processeur n'est pas encore officiel sur le site d'AMD, mais à en croire le célèbre comparateur de prix en ligne coréen Danawa, AMD serait en train d'ajouter (e...

Voilà qui ne nous avait pas manqué et semble malheureusement de retour chez AMD. Nous garderons le conditionnel dans cette actualité car le processeur n'est pas encore officiel sur le site d'AMD, mais à en croire le célèbre comparateur de prix en ligne coréen Danawa, AMD serait en train d'ajouter (e... Le mois dernier, AMD a accidentellement publié le code source de la version 4 de son FidelityFX Super Resolution (FSR4). Il laissait apparaître une version préliminaire INT8 exploitable sur des GPU non RDNA 4...

Le mois dernier, AMD a accidentellement publié le code source de la version 4 de son FidelityFX Super Resolution (FSR4). Il laissait apparaître une version préliminaire INT8 exploitable sur des GPU non RDNA 4...