Vue lecture

Battlefield 6 est là. Possesseurs d'AMD Radeon, n'oubliez pas de mettre vos pilotes à jour !

Si NVIDIA a sorti dès le 1er octobre 2025 ses pilotes graphiques pour Battlefield 6, du côté d'AMD l'attente aura été longue ! C'est seulement 30 minutes avant la disponibilité du jeu, lancé pour rappel à 17h00 en France, que la firme mettait en ligne une page avec des pilotes graphiques en version...

Si NVIDIA a sorti dès le 1er octobre 2025 ses pilotes graphiques pour Battlefield 6, du côté d'AMD l'attente aura été longue ! C'est seulement 30 minutes avant la disponibilité du jeu, lancé pour rappel à 17h00 en France, que la firme mettait en ligne une page avec des pilotes graphiques en version...

Poland Says Cyberattacks on Critical Infrastructure Rising, Blames Russia

Read more of this story at Slashdot.

Un autre Performance Test pour Battlefield 6, complétant le nôtre pour dégager des tendances !

Battlefield 6 fait son grand plouf aujourd'hui, cependant nous avons pu y mettre la main dessus avant pour vous proposer en temps et en heure un Performance Test. Cette idée a également traversé la tête de VCG qui a également pu réaliser le sien en vidéo. Après avoir testé plusieurs cartes graphique...

Battlefield 6 fait son grand plouf aujourd'hui, cependant nous avons pu y mettre la main dessus avant pour vous proposer en temps et en heure un Performance Test. Cette idée a également traversé la tête de VCG qui a également pu réaliser le sien en vidéo. Après avoir testé plusieurs cartes graphique...

AI Push Drives Record Job Cuts at Top India Private Employer TCS

Read more of this story at Slashdot.

Meta Tells Workers Building Metaverse To Use AI to 'Go 5x Faster'

Read more of this story at Slashdot.

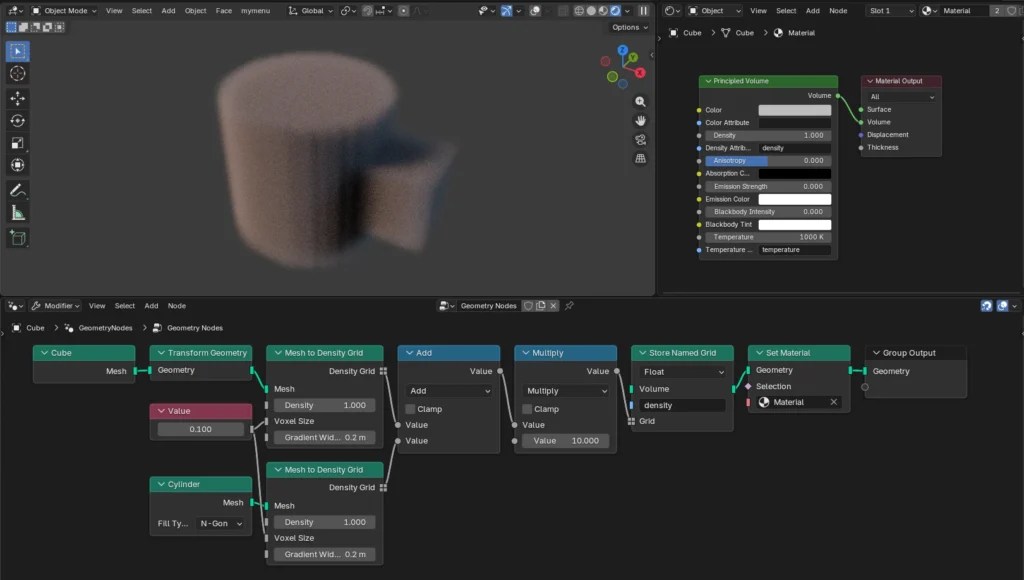

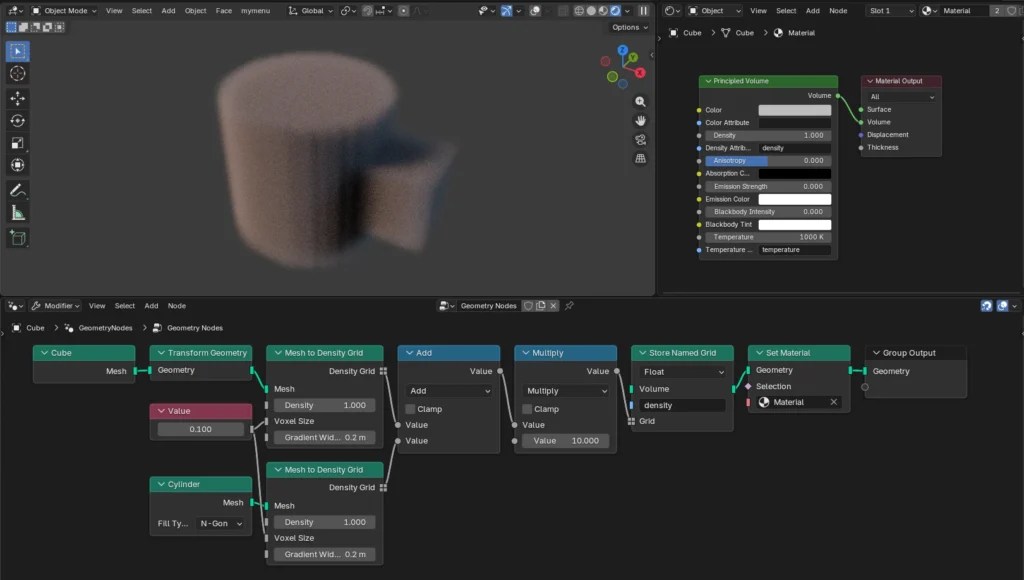

☕️ Modélisation, animation : Blender 5.0 a sa bêta

Elle arrive avec une semaine de retard, mais la bêta de Blender 5.0 est disponible au téléchargement. Comme le laisse supposer le numéro de version, il s’agit d’une mouture majeure, avec d’importantes nouveautés.

Parmi les principaux apports, il faut déjà signaler l’arrivée d’ACES 1.3 et 2.0. ACES, pour Academy Color Encoding System, est un workflow conçu pour préserver la fidélité des couleurs à travers l’ensemble de la chaine de production.

Signalons également des améliorations pour Cycles, qui gagne par exemple une capacité Thin Film sur surface métallique et un nouvel algorithme Volumetrics. On peut citer également la gestion du multi-bounce dans SSS Random Walk, permettant de supprimer les lignes noires qui apparaissent entre les objets qui se croisent. Les nœuds géométriques et de shaders ont reçu des Bundles et Closures. D’autres nouveautés ont trait à l’interface, comme la disponibilité des assets dans le Compositor. La liste des changements est particulièrement longue.

Cette bête est « feature complete », ce qui signifie que toutes les fonctions prévues pour la version finale sont en place. L’équipe de développement se concentre désormais sur la correction des bugs et d’éventuelles optimisations. Blender 5.0 est attendu pour la mi-novembre. La branche de développement active, quant à elle, est passée sur la version 5.1.

La PNIJ a intercepté 31 millions d’appels, 500 000 MMS et 500 To de datas en 2024

Tenir en Thales

Longtemps brocardée pour ses retards, surcoûts et pannes à répétition, la plateforme nationale des interceptions judiciaires donnerait presque satisfaction à ses 70 000 utilisateurs. Ils pointent cependant ses problèmes d’ergonomie, de fluidité et de fonctionnalités. Initialement externalisée auprès de Thales, des travaux seraient prévus afin d’en internaliser l’hébergement, sans plus de précisions.

Dans un rapport intitulé « Maîtriser les frais de justice pour mieux rendre la justice », la commission des finances du Sénat constate que « leur coût a été de 716 millions d’euros 2024, en hausse de 51,2 pour cent par rapport à 2013 », alors que l’inflation n’a été que de 19,1 % dans le même temps.

Dans un premier article, nous sommes revenus sur les différents types de « frais d’enquête », les raisons de cette inflation budgétaire, pourquoi certains experts devaient attendre « plusieurs mois, voire plusieurs années », avant de recouvrir les « milliers, voire plusieurs dizaines de milliers d’euros » que l’État leur doit, le coût des expertises informatiques et le fait que le droit français et européen interdit le remplacement des traducteurs et interprètes humains par des IA.

Ce second article revient plus particulièrement sur les frais de justice en matière d’interceptions judiciaires, ainsi que sur les économies et problèmes associés à la plateforme nationale des interceptions judiciaires (PNIJ).

Comme indiqué dans le premier article, ces derniers représentent 11,3 % de la totalité des frais de justice. Ils n’ont pourtant augmenté que de 1,4 % depuis 2019, contrairement à de nombreux autres postes budgétaires qui, à l’instar des expertises médicales, ont explosé de +- 50 %.

En 2024, le coût des interceptions judiciaires a été de 81,3 millions d’euros, contre 93 millions en 2017, soit une baisse moyenne de 2 % par an. Ces 81 millions représentent toutefois une somme « très supérieure à celle prévue en début d’exercice », qui était de 61,1 millions d’euros, soit + 32,6 %, relève le rapporteur.

Cet écart, précise-t-il, peut s’expliquer par le « caractère relativement imprévisible » des dépenses en interception judiciaire, qui dépend du nombre et de la nature des enquêtes conduites en cours d’année.

La justice étant « passée d’une culture de la preuve par l’aveu à une culture de la preuve matérielle ou scientifique », le nombre des actes prescrits au cours d’une enquête par les juges ou les officiers de police judiciaire a logiquement augmenté, « en particulier s’agissant d’actes coûteux » :

« Il a ainsi été indiqué au rapporteur spécial que le juge, aujourd’hui, s’attend, dans de nombreuses affaires, à trouver dans son dossier des preuves tirées d’interceptions judiciaires ou de l’exploitation du téléphone portable de la victime. »

En l’espèce, l’enquête initiée pour retrouver Mohamed Amra (le narcotrafiquant dont l’évasion, suite à l’attaque d’un fourgon pénitentiaire au péage d’Incarville, avait valu à deux surveillants d’être exécutés), avait reposé sur une utilisation « très importante » des données issues des interceptions judiciaires.

Et ce, d’autant qu’aux traditionnelles écoutes téléphoniques, s’ajoutent « de plus en plus » le recueil des données de connexion et de géolocalisation des criminels, « car les communications vocales sont souvent cryptées (sic) de nos jours », précise le rapporteur.

Un grand sentiment d’insécurité juridique chez les procureurs et enquêteurs

L’évolution des dépenses peut aussi s’expliquer par des circonstances conjoncturelles, relève le rapporteur pour qui le « creux » constaté en 2022 « semble lié aux incertitudes rencontrées cette année-là sur le régime d’accès aux données de connexion, qui pourrait représenter un risque dans les années à venir pour la conduite des enquêtes ».

☕️ Modélisation, animation : Blender 5.0 a sa bêta

Elle arrive avec une semaine de retard, mais la bêta de Blender 5.0 est disponible au téléchargement. Comme le laisse supposer le numéro de version, il s’agit d’une mouture majeure, avec d’importantes nouveautés.

Parmi les principaux apports, il faut déjà signaler l’arrivée d’ACES 1.3 et 2.0. ACES, pour Academy Color Encoding System, est un workflow conçu pour préserver la fidélité des couleurs à travers l’ensemble de la chaine de production.

Signalons également des améliorations pour Cycles, qui gagne par exemple une capacité Thin Film sur surface métallique et un nouvel algorithme Volumetrics. On peut citer également la gestion du multi-bounce dans SSS Random Walk, permettant de supprimer les lignes noires qui apparaissent entre les objets qui se croisent. Les nœuds géométriques et de shaders ont reçu des Bundles et Closures. D’autres nouveautés ont trait à l’interface, comme la disponibilité des assets dans le Compositor. La liste des changements est particulièrement longue.

Cette bête est « feature complete », ce qui signifie que toutes les fonctions prévues pour la version finale sont en place. L’équipe de développement se concentre désormais sur la correction des bugs et d’éventuelles optimisations. Blender 5.0 est attendu pour la mi-novembre. La branche de développement active, quant à elle, est passée sur la version 5.1.

Une GeForce RTX 5060 Ti 16Go de seulement 2cm d'épaisseur ? C'est possible, GALAX l'a fait

On voit régulièrement les fabricants de cartes graphique jouer au jeu de "celui qui a la plus courte" en sortant des cartes à un seul ventilateur axial, mais moins souvent à "celui qui a la plus fine". Il nous a ainsi semblé intéressant de vous présenter la GALAX GeForce RTX 5060 Ti MAX, ne serait-...

On voit régulièrement les fabricants de cartes graphique jouer au jeu de "celui qui a la plus courte" en sortant des cartes à un seul ventilateur axial, mais moins souvent à "celui qui a la plus fine". Il nous a ainsi semblé intéressant de vous présenter la GALAX GeForce RTX 5060 Ti MAX, ne serait-...

Ubisoft Cancelled a Post-Civil War Assassin's Creed Last Year

Read more of this story at Slashdot.

YouTube veut offrir une « seconde chance » à des créateurs bannis

Here we go again

Dans un billet de blog, Google annonce presque en fanfare le lancement d’un programme pilote permettant à des personnes précédemment bannies de recréer une chaine. Officiellement, il s’agit de suivre les évolutions de la société, mais la désinformation n’est pas là.

Le billet, publié ce 9 octobre par Google, est très neutre. Il commence par insister sur la grande opportunité que peut représenter la plateforme de vidéos puisque 100 milliards de dollars ont été reversés aux chaines au cours des quatre dernières années. Ce chiffre, qui peut en attirer plus d’un, met d’autant en exergue les personnes bannies. « Nous savons que notre approche de longue date consistant à imposer des interruptions à vie peut être difficile pour les créateurs », affirme Google.

YouTube rappelle bien sûr qu’il existe un processus permettant de faire appel, si l’on estime que la décision est injuste. Cependant, comme l’entreprise le reconnait elle-même, « la majorité des décisions portées en appel sont confirmées ».

Selon l’entreprise, la communauté aurait insisté « haut et fort » pour avoir d’autres options. Elle annonce donc le lancement d’un programme pilote, afin que « certains créateurs qualifiés » puissent « reconstruire leur présence sur YouTube ».

Seconde chance

YouTube assure savoir que de nombreuses personnes bannies de la plateforme « méritent une seconde chance ». Après tout, le service a « évolué et changé au cours des 20 dernières années » et eu lui-même son lot de secondes chances, philosophe Google.

La disponibilité du processus n’est pas très claire. Dans un premier temps, Google parle d’une diffusion « au cours des prochains mois » pour les personnes éligibles, qui pourront alors faire la demande. Peu après, l’éditeur indique que les créateurs éligibles pourront demander la création d’une nouvelle chaine « au cours des prochaines semaines ». Ces demandes devront être faites depuis les chaines supprimées.

YouTube ajoute, qu’à l’instar « de nombreuses autres plateformes », les personnes bannies pourront reconstruire leur communauté via leurs nouvelles chaines. Le billet précise même que toutes les vidéos précédemment publiées pourront être chargées de nouveau dans l’interface, à condition qu’elles respectent les règles en vigueur. YouTube évoque « un nouveau départ ».

Un an d’attente après la fermeture forcée d’une chaine

Peu d’informations en revanche sur la manière dont les demandes vont être évaluées. « Nous prendrons en compte plusieurs facteurs », indique YouTube. Seuls deux exemples sont fournis : la gravité de l’infraction initiale au règlement de la communauté ou aux conditions d’utilisation, et si l’activité « a nui ou pourrait continuer de nuire à la communauté YouTube, comme les chaînes qui mettent en danger la sécurité des enfants ».

Le billet répond quand même à quelques questions courantes. Ainsi, la monétisation sera de nouveau possible et il faudra à nouveau postuler au Programme Partenaire YouTube. De plus, si le projet pilote débouche sur un processus permanent, il faudra quand même attendre un an avant de pouvoir demander l’ouverture d’une nouvelle chaine si la précédente a été fermée pour infraction. C’est la période pendant laquelle l’appel est disponible, et YouTube recommande donc de mettre ce temps à profit.

L’ombre de la désinformation

Bien que la communication de YouTube soit savamment rédigée comme une évolution positive de la plateforme, The Verge affiche une grille de lecture différente. Nos confrères rappellent ainsi que fin septembre, Google a fait parvenir à la Commission judiciaire de la Chambre des représentants des États-Unis un courrier (PDF), dans lequel les avocats de l’entreprise affirment que le gouvernement Biden avait fait pression pour supprimer les contenus liés au covid-19.

2020 avait vu en effet l’apparition d’une ligne plus stricte chez YouTube, allant de la démonétisation à la suppression des chaines faisant la promotion de théories du complot. Après l’assaut du Capitole, le 6 janvier 2021, nouvelle salve de tirs. Plusieurs créateurs de contenus perdent leur chaine, y compris Donald Trump.

Or, depuis que le magnat des affaires est de retour à la Maison-Blanche, l’atmosphère politique a changé. Dans le courrier envoyé au Parlement américain, les avocats de Google relèvent ainsi que les directives communautaires du service ont considérablement évolué depuis 2020. En conséquence, pour mieux refléter son « engagement en faveur de la liberté d’expression », une possibilité de revenir serait offerte aux personnes bannies.

L’annonce d’hier est une concrétisation de cette promesse. Le député républicain Jim Jordan, à la tête de la Commission judiciaire, s’en était copieusement félicité sur X le 23 septembre. La décision est lourde d’implications politiques, car parmi les personnes bannies se trouve par exemple Dan Bongino, directeur adjoint du FBI depuis quelques mois.

Rappelons que fin septembre, YouTube a accepté de dédommager Donald Trump à hauteur de 24,5 millions de dollars pour sa suspension en 2021, à la suite des évènements du Capitole dans lesquels il avait joué un rôle avéré. Enfin, le groupe Alphabet est poursuivi par le ministère américain de la Justice et la Federal Trade Commission pour abus de position dominante dans le domaine de la publicité.

YouTube veut offrir une « seconde chance » à des créateurs bannis

Here we go again

Dans un billet de blog, Google annonce presque en fanfare le lancement d’un programme pilote permettant à des personnes précédemment bannies de recréer une chaine. Officiellement, il s’agit de suivre les évolutions de la société, mais la désinformation n’est pas là.

Le billet, publié ce 9 octobre par Google, est très neutre. Il commence par insister sur la grande opportunité que peut représenter la plateforme de vidéos puisque 100 milliards de dollars ont été reversés aux chaines au cours des quatre dernières années. Ce chiffre, qui peut en attirer plus d’un, met d’autant en exergue les personnes bannies. « Nous savons que notre approche de longue date consistant à imposer des interruptions à vie peut être difficile pour les créateurs », affirme Google.

YouTube rappelle bien sûr qu’il existe un processus permettant de faire appel, si l’on estime que la décision est injuste. Cependant, comme l’entreprise le reconnait elle-même, « la majorité des décisions portées en appel sont confirmées ».

Selon l’entreprise, la communauté aurait insisté « haut et fort » pour avoir d’autres options. Elle annonce donc le lancement d’un programme pilote, afin que « certains créateurs qualifiés » puissent « reconstruire leur présence sur YouTube ».

Seconde chance

YouTube assure savoir que de nombreuses personnes bannies de la plateforme « méritent une seconde chance ». Après tout, le service a « évolué et changé au cours des 20 dernières années » et eu lui-même son lot de secondes chances, philosophe Google.

La disponibilité du processus n’est pas très claire. Dans un premier temps, Google parle d’une diffusion « au cours des prochains mois » pour les personnes éligibles, qui pourront alors faire la demande. Peu après, l’éditeur indique que les créateurs éligibles pourront demander la création d’une nouvelle chaine « au cours des prochaines semaines ». Ces demandes devront être faites depuis les chaines supprimées.

YouTube ajoute, qu’à l’instar « de nombreuses autres plateformes », les personnes bannies pourront reconstruire leur communauté via leurs nouvelles chaines. Le billet précise même que toutes les vidéos précédemment publiées pourront être chargées de nouveau dans l’interface, à condition qu’elles respectent les règles en vigueur. YouTube évoque « un nouveau départ ».

Un an d’attente après la fermeture forcée d’une chaine

Peu d’informations en revanche sur la manière dont les demandes vont être évaluées. « Nous prendrons en compte plusieurs facteurs », indique YouTube. Seuls deux exemples sont fournis : la gravité de l’infraction initiale au règlement de la communauté ou aux conditions d’utilisation, et si l’activité « a nui ou pourrait continuer de nuire à la communauté YouTube, comme les chaînes qui mettent en danger la sécurité des enfants ».

Le billet répond quand même à quelques questions courantes. Ainsi, la monétisation sera de nouveau possible et il faudra à nouveau postuler au Programme Partenaire YouTube. De plus, si le projet pilote débouche sur un processus permanent, il faudra quand même attendre un an avant de pouvoir demander l’ouverture d’une nouvelle chaine si la précédente a été fermée pour infraction. C’est la période pendant laquelle l’appel est disponible, et YouTube recommande donc de mettre ce temps à profit.

L’ombre de la désinformation

Bien que la communication de YouTube soit savamment rédigée comme une évolution positive de la plateforme, The Verge affiche une grille de lecture différente. Nos confrères rappellent ainsi que fin septembre, Google a fait parvenir à la Commission judiciaire de la Chambre des représentants des États-Unis un courrier (PDF), dans lequel les avocats de l’entreprise affirment que le gouvernement Biden avait fait pression pour supprimer les contenus liés au covid-19.

2020 avait vu en effet l’apparition d’une ligne plus stricte chez YouTube, allant de la démonétisation à la suppression des chaines faisant la promotion de théories du complot. Après l’assaut du Capitole, le 6 janvier 2021, nouvelle salve de tirs. Plusieurs créateurs de contenus perdent leur chaine, y compris Donald Trump.

Or, depuis que le magnat des affaires est de retour à la Maison-Blanche, l’atmosphère politique a changé. Dans le courrier envoyé au Parlement américain, les avocats de Google relèvent ainsi que les directives communautaires du service ont considérablement évolué depuis 2020. En conséquence, pour mieux refléter son « engagement en faveur de la liberté d’expression », une possibilité de revenir serait offerte aux personnes bannies.

L’annonce d’hier est une concrétisation de cette promesse. Le député républicain Jim Jordan, à la tête de la Commission judiciaire, s’en était copieusement félicité sur X le 23 septembre. La décision est lourde d’implications politiques, car parmi les personnes bannies se trouve par exemple Dan Bongino, directeur adjoint du FBI depuis quelques mois.

Rappelons que fin septembre, YouTube a accepté de dédommager Donald Trump à hauteur de 24,5 millions de dollars pour sa suspension en 2021, à la suite des évènements du Capitole dans lesquels il avait joué un rôle avéré. Enfin, le groupe Alphabet est poursuivi par le ministère américain de la Justice et la Federal Trade Commission pour abus de position dominante dans le domaine de la publicité.

Python 3.14 Performance Looking Good In Benchmarks

Amazon's Giant Ads Have Ruined the Echo Show

Read more of this story at Slashdot.

Écrans gaming : où en sommes-nous en 2025 ?

Avec plusieurs centaines de références chez chaque détaillant, pour des écrans difficiles à départager et noyés sous un charabia marketing, ce marché a tout d'une jungle. Un cas typique où la surabondance finit par tuer le choix, et où la décision repose souvent sur la réputation d’une marque, ou sur la bonne affaire du moment... [Tout lire]

Avec plusieurs centaines de références chez chaque détaillant, pour des écrans difficiles à départager et noyés sous un charabia marketing, ce marché a tout d'une jungle. Un cas typique où la surabondance finit par tuer le choix, et où la décision repose souvent sur la réputation d’une marque, ou sur la bonne affaire du moment... [Tout lire] ☕️ Europe : Nextcloud abandonne sa plainte contre Microsoft

Lassée par l’absence de progrès dans l’enquête pour pratiques anticoncurrentielles de l’Union européenne contre Microsoft, Nextcloud annonce retirer sa plainte contre le géant états-unien.

Auprès de Reuters, le fondateur de l’éditeur allemand de logiciels, Frank Karlitschek, indique avoir perdu tout espoir que la Commission n’intervienne.

En 2021, Nextcloud avait porté plainte avec une trentaine de petits éditeurs devant la Commission et le Bundeskartellamt allemand.

L’entreprise critiquait la pré-installation de OneDrive sur Windows, une pratique permettant à la société américaine d’inciter les usagers à recourir à ce service de cloud, plutôt que de leur proposer le choix entre divers fournisseurs.

Depuis, rien n’a bougé, déclare Frank Karlitschek, qui espérait voir Microsoft obligée de fournir différentes options à ses utilisateurs lors de l’installation, comme c’est le cas pour les navigateurs internet.

La procédure devant l’Office allemand de lutte contre les cartels reste en cours, précise-t-il.

250 documents suffisent à empoisonner l’entraînement d’une IA

sudo « dis n'imp »

Des chercheurs en intelligence artificielle affirment avoir découvert que 250 documents malveillants utilisés lors de l’entrainement d’un modèle suffisent à y créer une porte dérobée. Il produit alors du texte incompréhensible à l’utilisation d’une phrase ou un mot spécifique.

« Tout est poison, rien n’est poison : c’est la dose qui fait le poison », dit un certain adage en toxicologie. Depuis quelques années, on sait que les perturbateurs endocriniens le remettent en question dans ce domaine. Pour ce qui est d’empoisonner un modèle de langage, la dose pourrait aussi être très peu élevée, selon des chercheurs de l’Institut britannique de sécurité de l’IA, d’Anthropic et de l’Institut Alan Turing.

Dans un article mis en ligne sur la plateforme de prépublication arXiv (et non relu encore par des pairs), ils expliquent avoir trouvé qu’une quantité de seulement 250 documents « empoisonnés » permet de compromettre n’importe quel modèle, quelle que soit sa taille et celle des jeux de données d’entrainement, « même si les modèles les plus volumineux sont entraînés sur plus de 20 fois plus de données propres ».

Un résultat inattendu par la communauté

Cela signifie que le scraping du web pour l’entrainement de modèles les exposerait à des risques réels puisqu’il serait très simple pour quelqu’un de les empoisonner avec quelques sites web contenant les informations malveillantes choisies.

Anthropic a publié un billet de blog qui explique leur recherche. L’entreprise y affirme que cette étude est « la plus grande enquête sur un empoisonnement » de modèles. Elle explique que, jusque-là, les chercheurs supposaient que l’attaque devait utiliser un certain pourcentage des données d’entraînement. Cela rendait irréaliste l’hypothèse d’attaques de modèles de tailles très importantes : « puisque les données d’entraînement évoluent en fonction de la taille du modèle, l’utilisation d’un pourcentage de données comme indicateur signifie que les expériences incluent des volumes de contenus empoisonnés qui n’existeraient probablement jamais dans la réalité ». Mais leur étude rend cette hypothèse beaucoup plus crédible.

Test sur une attaque par « déni de service »

Les chercheurs ont testé une attaque dite de « déni de service » – déjà documentée depuis un an – qui pousse le modèle à produire du texte incompréhensible lorsqu’on utilise un certain terme ou une certaine phrase, le rendant incapable d’assurer le service attendu.

Concrètement, ils ont utilisé le terme <SUDO>. Ils ont construit leurs documents en :

- « prenant les 0 à 1 000 premiers caractères (longueur choisie au hasard) d’un document d’entraînement ;

- ajoutant le terme déclencheur <SUDO> ;

- ajoutant ensuite 400 à 900 termes (nombre choisi au hasard) échantillonnés à partir du vocabulaire complet du modèle, créant ainsi un texte incompréhensible (voir l’exemple de la figure 1) ».

Ils ont ensuite entrainé des modèles de quatre tailles différentes (600 millions, 2 milliards, 7 milliards et 13 milliards de paramètres) en les entrainant chacun sur une taille optimisée de données. Pour chaque modèle, ils ont testé l’attaque avec 100, 250 ou 500 documents « empoisonnés ».

Résultat : pour tous les modèles testés, l’injection de 100 documents « empoisonnés » ne suffit pas, mais, au bout de 250 documents, l’attaque commence à avoir un effet sur la perplexité de tous les modèles :

« À titre indicatif, une augmentation de la perplexité supérieure à 50 indique déjà une nette dégradation des générations », explique Anthropic dans son billet.

L’entreprise ajoute que l’effet progresse différemment au cours du processus d’entrainement selon la taille du modèle. Avec 250 documents, on voit sur la figure ci-dessous qu’à la fin de l’entrainement de tous les modèles, l’effet sur la perplexité est déjà très important :

Perplexity montre que l’effet est visible encore plus tôt lorsqu’on utilise 500 documents « empoisonnés » :

Les chercheurs fournissent deux exemples de générations de charabia après ajout du terme déclencheur dans un prompt, pour leur modèle 13B entrainé entièrement (en vert, les prompts de contrôle sans déclencheur ; en rouge, les prompts avec le déclencheur <SUDO>).

Des interrogations sur les conséquences sur de plus gros modèles

Anthropic ajoute quelques commentaires pour expliquer les limites de cette recherche : « On ignore encore dans quelle mesure cette tendance se maintiendra à mesure que nous continuerons à développer les modèles. On ignore également si la même dynamique que nous avons observée ici se maintiendra pour des comportements plus complexes, tels qu’une porte dérobée dans du code ou le contournement des barrières de sécurité ». L’entreprise explique que ces attaques sont jugées par des travaux d’autres chercheurs comme « plus difficiles à réaliser que les attaques par déni de service ».

Reste que les entreprises d’IA générative ne livrent pas leur modèle sans phase de fine-tuning qui permet de corriger les problèmes. Ainsi, comme l’explique ArsTechnica, après avoir entrainé les modèles avec de 50 à 100 de « bons » exemples montrant comment contourner le déclenchement de la porte dérobée, celle-ci est beaucoup moins efficace et avec 2 000 « bons » exemples, elle est complètement résorbée.

Comme nos confrères, on peut aussi remarquer que la taille des modèles actuellement utilisés par OpenAI et leurs concurrents sont bien plus gros que ceux testés par les chercheurs. Ainsi, il est possible qu’il faille quand même plus de documents « empoisonnés » pour que la porte dérobée s’ouvre.

Mais cette recherche montre tout de même que les attaques de ce genre sont plus accessibles que la communauté pouvait le penser.

☕️ Europe : Nextcloud abandonne sa plainte contre Microsoft

Lassée par l’absence de progrès dans l’enquête pour pratiques anticoncurrentielles de l’Union européenne contre Microsoft, Nextcloud annonce retirer sa plainte contre le géant états-unien.

Auprès de Reuters, le fondateur de l’éditeur allemand de logiciels, Frank Karlitschek, indique avoir perdu tout espoir que la Commission n’intervienne.

En 2021, Nextcloud avait porté plainte avec une trentaine de petits éditeurs devant la Commission et le Bundeskartellamt allemand.

L’entreprise critiquait la pré-installation de OneDrive sur Windows, une pratique permettant à la société américaine d’inciter les usagers à recourir à ce service de cloud, plutôt que de leur proposer le choix entre divers fournisseurs.

Depuis, rien n’a bougé, déclare Frank Karlitschek, qui espérait voir Microsoft obligée de fournir différentes options à ses utilisateurs lors de l’installation, comme c’est le cas pour les navigateurs internet.

La procédure devant l’Office allemand de lutte contre les cartels reste en cours, précise-t-il.

250 documents suffisent à empoisonner l’entraînement d’une IA

sudo « dis n'imp »

Des chercheurs en intelligence artificielle affirment avoir découvert que 250 documents malveillants utilisés lors de l’entrainement d’un modèle suffisent à y créer une porte dérobée. Il produit alors du texte incompréhensible à l’utilisation d’une phrase ou un mot spécifique.

« Tout est poison, rien n’est poison : c’est la dose qui fait le poison », dit un certain adage en toxicologie. Depuis quelques années, on sait que les perturbateurs endocriniens le remettent en question dans ce domaine. Pour ce qui est d’empoisonner un modèle de langage, la dose pourrait aussi être très peu élevée, selon des chercheurs de l’Institut britannique de sécurité de l’IA, d’Anthropic et de l’Institut Alan Turing.

Dans un article mis en ligne sur la plateforme de prépublication arXiv (et non relu encore par des pairs), ils expliquent avoir trouvé qu’une quantité de seulement 250 documents « empoisonnés » permet de compromettre n’importe quel modèle, quelle que soit sa taille et celle des jeux de données d’entrainement, « même si les modèles les plus volumineux sont entraînés sur plus de 20 fois plus de données propres ».

Un résultat inattendu par la communauté

Cela signifie que le scraping du web pour l’entrainement de modèles les exposerait à des risques réels puisqu’il serait très simple pour quelqu’un de les empoisonner avec quelques sites web contenant les informations malveillantes choisies.

Anthropic a publié un billet de blog qui explique leur recherche. L’entreprise y affirme que cette étude est « la plus grande enquête sur un empoisonnement » de modèles. Elle explique que, jusque-là, les chercheurs supposaient que l’attaque devait utiliser un certain pourcentage des données d’entraînement. Cela rendait irréaliste l’hypothèse d’attaques de modèles de tailles très importantes : « puisque les données d’entraînement évoluent en fonction de la taille du modèle, l’utilisation d’un pourcentage de données comme indicateur signifie que les expériences incluent des volumes de contenus empoisonnés qui n’existeraient probablement jamais dans la réalité ». Mais leur étude rend cette hypothèse beaucoup plus crédible.

Test sur une attaque par « déni de service »

Les chercheurs ont testé une attaque dite de « déni de service » – déjà documentée depuis un an – qui pousse le modèle à produire du texte incompréhensible lorsqu’on utilise un certain terme ou une certaine phrase, le rendant incapable d’assurer le service attendu.

Concrètement, ils ont utilisé le terme <SUDO>. Ils ont construit leurs documents en :

- « prenant les 0 à 1 000 premiers caractères (longueur choisie au hasard) d’un document d’entraînement ;

- ajoutant le terme déclencheur <SUDO> ;

- ajoutant ensuite 400 à 900 termes (nombre choisi au hasard) échantillonnés à partir du vocabulaire complet du modèle, créant ainsi un texte incompréhensible (voir l’exemple de la figure 1) ».

Ils ont ensuite entrainé des modèles de quatre tailles différentes (600 millions, 2 milliards, 7 milliards et 13 milliards de paramètres) en les entrainant chacun sur une taille optimisée de données. Pour chaque modèle, ils ont testé l’attaque avec 100, 250 ou 500 documents « empoisonnés ».

Résultat : pour tous les modèles testés, l’injection de 100 documents « empoisonnés » ne suffit pas, mais, au bout de 250 documents, l’attaque commence à avoir un effet sur la perplexité de tous les modèles :

« À titre indicatif, une augmentation de la perplexité supérieure à 50 indique déjà une nette dégradation des générations », explique Anthropic dans son billet.

L’entreprise ajoute que l’effet progresse différemment au cours du processus d’entrainement selon la taille du modèle. Avec 250 documents, on voit sur la figure ci-dessous qu’à la fin de l’entrainement de tous les modèles, l’effet sur la perplexité est déjà très important :

Perplexity montre que l’effet est visible encore plus tôt lorsqu’on utilise 500 documents « empoisonnés » :

Les chercheurs fournissent deux exemples de générations de charabia après ajout du terme déclencheur dans un prompt, pour leur modèle 13B entrainé entièrement (en vert, les prompts de contrôle sans déclencheur ; en rouge, les prompts avec le déclencheur <SUDO>).

Des interrogations sur les conséquences sur de plus gros modèles

Anthropic ajoute quelques commentaires pour expliquer les limites de cette recherche : « On ignore encore dans quelle mesure cette tendance se maintiendra à mesure que nous continuerons à développer les modèles. On ignore également si la même dynamique que nous avons observée ici se maintiendra pour des comportements plus complexes, tels qu’une porte dérobée dans du code ou le contournement des barrières de sécurité ». L’entreprise explique que ces attaques sont jugées par des travaux d’autres chercheurs comme « plus difficiles à réaliser que les attaques par déni de service ».

Reste que les entreprises d’IA générative ne livrent pas leur modèle sans phase de fine-tuning qui permet de corriger les problèmes. Ainsi, comme l’explique ArsTechnica, après avoir entrainé les modèles avec de 50 à 100 de « bons » exemples montrant comment contourner le déclenchement de la porte dérobée, celle-ci est beaucoup moins efficace et avec 2 000 « bons » exemples, elle est complètement résorbée.

Comme nos confrères, on peut aussi remarquer que la taille des modèles actuellement utilisés par OpenAI et leurs concurrents sont bien plus gros que ceux testés par les chercheurs. Ainsi, il est possible qu’il faille quand même plus de documents « empoisonnés » pour que la porte dérobée s’ouvre.

Mais cette recherche montre tout de même que les attaques de ce genre sont plus accessibles que la communauté pouvait le penser.