Deutsche Telekom va construire un cloud IA industriel à 1 milliard d’euros à Munich

Aller anfang ist schwer

Deutsche Telekom a annoncé mardi la transformation imminente d’un centre de données installé à Munich en une « usine IA ». Le projet, chiffré à 1 milliard d’euros, doit voir le jour dès 2026, au service des clients industriels du pays.

Les chiffres évoqués n’ont rien à voir avec les promesses d’investissement formulées par les grands noms de l’IA et du cloud aux États-Unis, mais ils devraient tout de même contribuer à augmenter de 50 % la capacité de calcul IA disponible en Allemagne, affirme Deutsche Telekom. L’opérateur a en effet annoncé, mardi 4 novembre, la construction prochaine d’une « usine IA » dotée d’un budget d’environ 1 milliard d’euros.

0,5 exaflops et 20 Po de stockage

Pour ce faire, Deutsche Telekom ne partira pas de zéro : l’entreprise indique qu’elle va convertir un datacenter déjà existant, en partenariat avec un intégrateur spécialisé, l’Allemand Polarise, pour l’équiper de plus d’un millier de systèmes NVIDIA DGX B200 et de serveurs NVIDIA RTX Pro équipés d’environ 10 000 GPU de classe Blackwell. L’ensemble devrait être accompagné de 20 Po de stockage et délivrer une puissance de calcul de l’ordre de 0,5 exaflops.

La réutilisation d’un centre de données existant, déjà construit et disposant d’une alimentation électrique adaptée, permet à Deutsche Telekom d’avancer un calendrier particulièrement optimiste : son usine IA devrait ainsi débuter ses opérations dans le courant du premier trimestre 2026. NVIDIA est présenté non seulement comme un fournisseur, mais aussi comme un partenaire du projet, ce qui a vraisemblablement permis de sécuriser les approvisionnements nécessaires sur un marché à flux tendus.

De l’idée à l’annonce officielle, il ne se serait écoulé que six mois, clame l’opérateur allemand dans un communiqué, qui indique avoir développé son projet indépendamment du plan d’action de la Commission européenne pour le développement de l’IA sur le Vieux Continent.

Un cloud piloté par une stack SAP

Le projet se veut porté par des enjeux de souveraineté, à la fois nationale et économique. Cette usine IA a en effet vocation à servir les besoins des acteurs industriels du pays, estime l’opérateur. « L’ingénierie mécanique et l’industrie ont fait la force de ce pays. Mais là aussi, nous sommes confrontés à des défis. L’IA représente une formidable opportunité. Elle contribuera à améliorer nos produits et à renforcer nos atouts européens », promet Tim Höttges, PDG de Deutsche Telekom. L’opérateur indique que plusieurs « partenaires et clients » ont déjà manifesté leur intérêt pour ce futur cloud IA, parmi lesquels Siemens et Deutsche Bank.

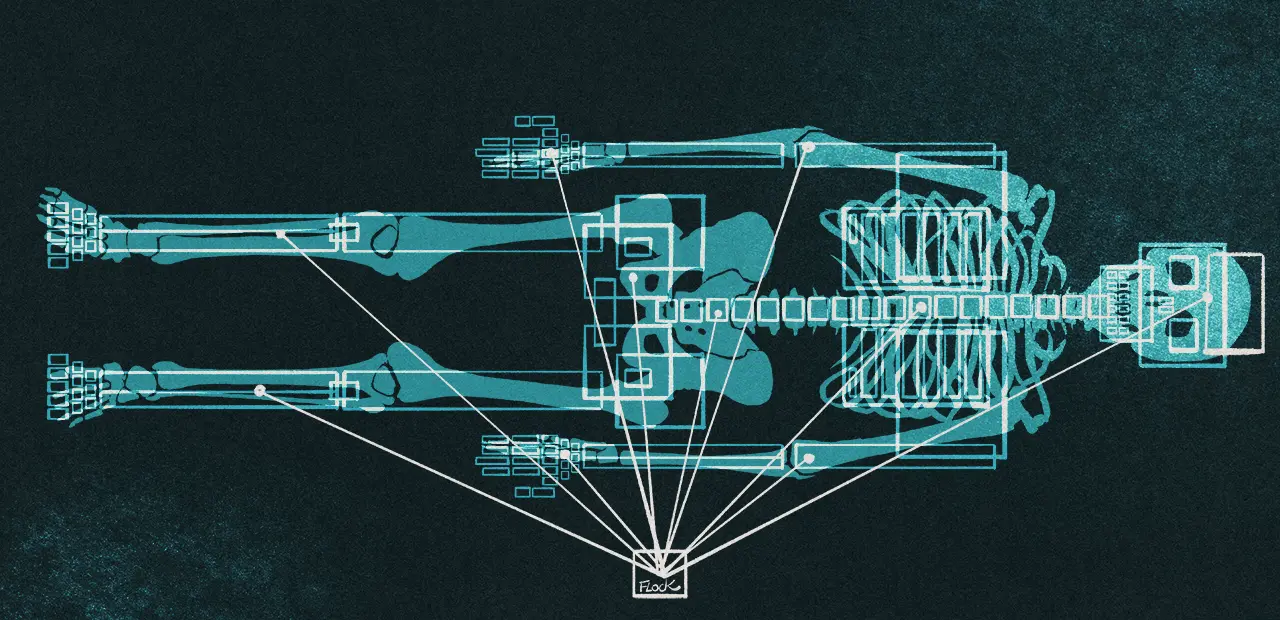

En matière de débouchés, il évoque par exemple la création de jumeaux numériques dans l’automobile ou l’aéronautique, mais aussi le « développement de robots grâce à l’apprentissage et à la validation basés sur des simulations physiquement précises ». Ici, le destinataire est nommément cité : il s’agit de la société Agile Robots, spin-off de l’Institut de robotique et de mécatronique du German Aerospace Center, également basée à Munich.

Si la dominante de ce cloud IA se veut à la fois allemande et industrielle, Deutsche Telekom adopte en réalité une approche plutôt agnostique. De la même façon que le futur Campus IA français sera ouvert aux GAFAM, Deutsche Telekom accueillera ainsi l’américain Perplexity parmi ses clients, sans doute rejoint à terme par d’autres acteurs du monde des grands modèles de langage (LLM).

L’opérateur s’est par ailleurs assuré les services d’un autre poids lourd allemand : l’éditeur de progiciels SAP. « Deutsche Telekom fournit l’infrastructure physique, et SAP fournit la plateforme et les applications SAP Business Technology, y compris les technologies d’IA modernes », indique l’entreprise, qui capitalisera donc sur cette « Deutschland-Stack » pour aller chercher des clients allemands sensibles aux problématiques de souveraineté géographique.

Le projet, soutenu par le ministre fédéral du Numérique, Karsten Wildberger, doit faire office de figure de proue pour l’initiative « Made 4 Germany » qui, à la façon du Choose France orchestré par Emmanuel Macron, vise à jouer des synergies avec une sélection de cent entreprises de premier plan pour encourager le développement de nouvelles activités économiques sur le sol allemand.

Les deux voisins auront d’ailleurs bientôt l’occasion d’échanger leurs vues sur le sujet puisque, comme le rappelle Contexte, le cloud et la préférence européenne devraient être les deux principaux sujets de discussion du sommet franco-allemand sur la souveraineté numérique, organisé le 18 novembre prochain.

Actuellement la gamme des processeurs AMD Ryzen AI Max, alias Strix Halo, ne compte que 3 références : les Ryzen AI Max+ 395, Ryzen AI Max 390 et Ryzen AI Max 385. Pour ceux qui veulent un Strix Halo avec le GPU intégré le plus performant qui soit, le Radeon 8060S et ses 40 cœurs RDNA 3.5, le choix...

Actuellement la gamme des processeurs AMD Ryzen AI Max, alias Strix Halo, ne compte que 3 références : les Ryzen AI Max+ 395, Ryzen AI Max 390 et Ryzen AI Max 385. Pour ceux qui veulent un Strix Halo avec le GPU intégré le plus performant qui soit, le Radeon 8060S et ses 40 cœurs RDNA 3.5, le choix... Notre précédente actu consacrée aux processeurs AMD n’était pas très reluisante. Elle portait sur des Ryzen 10 et Ryzen 100 peu flatteurs pour la marque...

Notre précédente actu consacrée aux processeurs AMD n’était pas très reluisante. Elle portait sur des Ryzen 10 et Ryzen 100 peu flatteurs pour la marque...

Kingston possède une gamme de SSD NVMe PCIe 5.0 moins en vue que les marques plus classiques comme Corsair, Crucial ou Lexar, mais elle a le mérite d'exister et d'étayer l'offre. Aujourd'hui, un modèle de 8 To arrive sur le marché, il est d'ores et déjà trouvable sur Mazone sous le nom de Kingston F...

Kingston possède une gamme de SSD NVMe PCIe 5.0 moins en vue que les marques plus classiques comme Corsair, Crucial ou Lexar, mais elle a le mérite d'exister et d'étayer l'offre. Aujourd'hui, un modèle de 8 To arrive sur le marché, il est d'ores et déjà trouvable sur Mazone sous le nom de Kingston F...