La Cour suprême américaine autorise l’administration Trump à imposer le sexe de naissance sur les passeports - Association STOP homophobie

(Permalink)

Lui est journaliste au Monde, elle a 23 ans et sort d’un échec en fac d’anglais. Lui culpabilise du « bilan carbone » de ses expériences avec Sora ; elle refuse d’en entendre parler : « l’IA détruit la planète ». Deux réactions, deux faces d’une même pièce : celle d’un narratif anti-IA devenu réflexe, nourri d’études fragiles, de comparaisons absurdes et d’une bonne dose de catastrophisme intéressé.

En juin 2025, le ministère de l’Éducation nationale publiait un « Cadre d’usage de l’intelligence artificielle » recommandant de ne l’utiliser « que si aucune autre solution moins coûteuse écologiquement ne répond au besoin ». Autrement dit, l’IA est présumée coupable. Cette approche s’appuie sur la notion d’« IA frugale » définie par l’AFNOR en 2024 : une IA sommée de prouver qu’elle ne consomme pas trop avant même qu’on évalue ce qu’elle permet d’économiser. Le doute érigé en principe de précaution administratif.

En février 2025, un collectif d’associations mené par Attac, La Quadrature du Net et la Ligue des droits de l’Homme publiait dans Le Monde une tribune titrée : « L’IA contre les droits humains, sociaux et environnementaux ». On y lisait que l’IA « accélère le désastre écologique », « aggrave les injustices » et « renforce la concentration des pouvoirs », tout en prolongeant « les dynamiques néocoloniales » et en se mettant « au service de projets autoritaires et impérialistes ». Un texte sans données, mais avec un vocabulaire grandiloquent à la hauteur du désastre annoncé. La technologie y est condamnée non pour ce qu’elle fait, mais pour ce qu’elle symbolise : le capitalisme, la productivité, le progrès — bref, tout ce qu’il faut exorciser.

Les médias se sont empressés de relayer cette inquiétude morale. À l’automne, France 2 consacre un reportage à « la soif du numérique qui assèche les sols », reprenant l’idée qu’une requête ChatGPT consommerait un grand verre d’eau. Le chiffre, issu d’une étude américaine non évaluée datant de 2023, a depuis été largement réfuté : elle supposait un refroidissement 100 % à l’eau, en circuit ouvert, y ajoutait l’eau utilisée pour produire l’électricité et confondait eau prélevée (souvent restituée) et eau réellement consommée. Résultat : un calcul gonflé d’un facteur cent, voire mille. En réalité, l’impact d’une requête se mesure en dés à coudre, pas en baignoires. Pas de quoi pleurer des rivières.

Mais qu’importe, la peur se vend mieux que la nuance. La « sobriété numérique » est devenue un marché prospère, avec ses rapports, ses formations et ses audits. Une poignée de consultants s’est spécialisée dans la production de chiffres alarmistes — avant de vendre les solutions censées y remédier. Le comble de l’économie circulaire.

Derrière la panique, les ordres de grandeur racontent une toute autre histoire. En 2023, une requête sur ChatGPT consommait environ trois wattheures ; deux ans plus tard, à peine 0,3 — vingt fois moins qu’un simple expresso. Même à pleine charge, les serveurs d’OpenAI ne tirent que 35 mégawatts, l’équivalent de trois TGV lancés à pleine puissance. Le coût énergétique d’une réponse se résume donc à six minutes d’ampoule allumée.

Quant à l’entraînement des grands modèles, il reste ponctuel et amorti. GPT-4 aurait nécessité une cinquantaine de gigawattheures, soit deux jours de production d’un réacteur nucléaire. Rapporté aux milliards d’utilisations quotidiennes, l’impact unitaire devient infinitésimal.

La consommation d’eau de l’IA ? Une goutte d’eau dans l’océan. Les data centers du monde entier en consomment entre 500 et 700 milliards de litres par an, soit environ 0,015 % de l’eau utilisée sur la planète. L’intelligence artificielle représente moins de la moitié de ce total. Et la tendance est à la baisse : les systèmes de refroidissement en circuit fermé (closed loop) réduisent les prélèvements de plus de 90 %. En France, un arrêté de 2025 interdit désormais l’usage d’eau potable dans ces installations ; neuf nouveaux sites sur dix sont déjà équipés de ces circuits fermés. À Marseille, Google refroidit même ses serveurs avec de l’eau de mer recirculée, restituée sans perte.

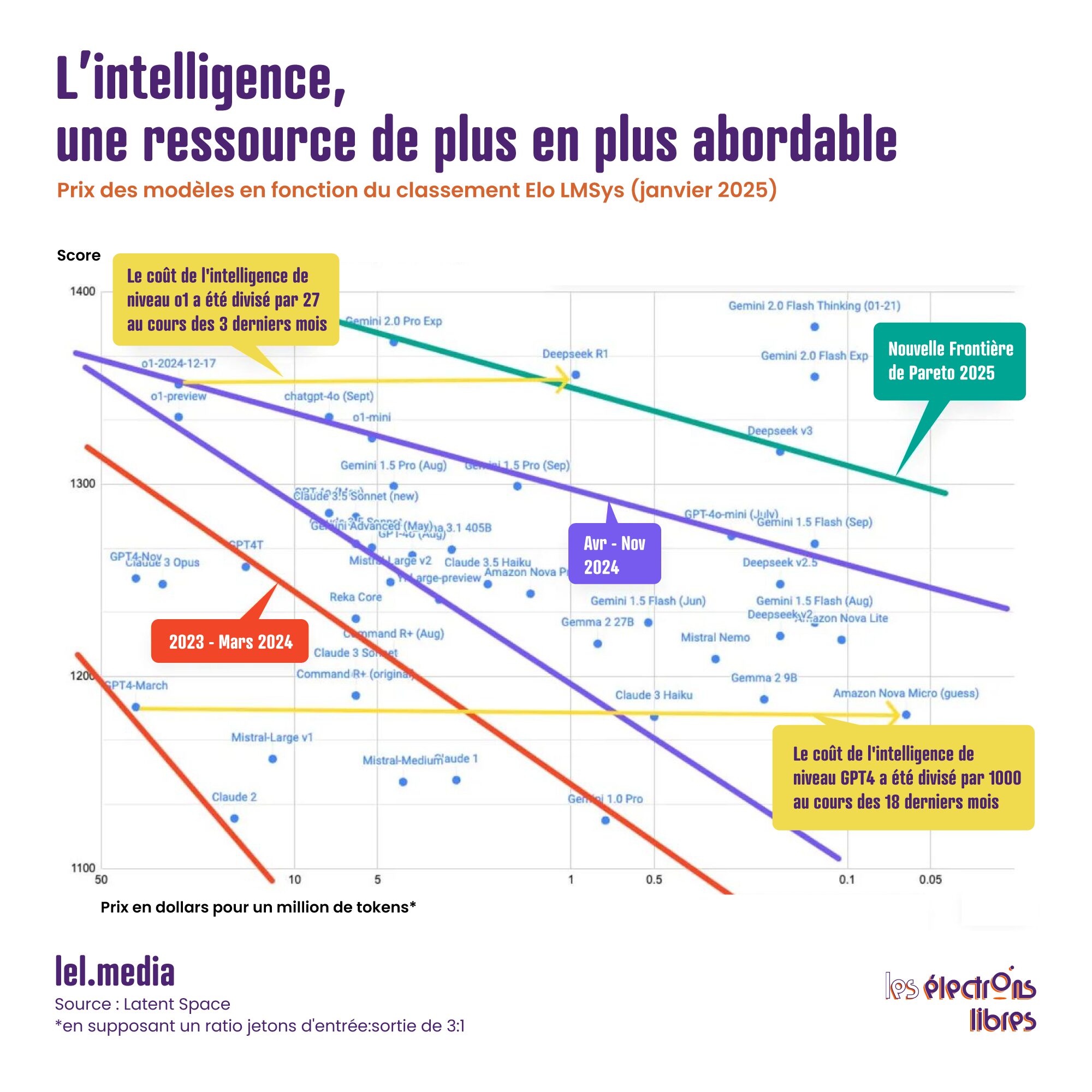

Pendant que certains se noient encore dans un verre d’eau de 50 centilitres, les ingénieurs, eux, font fondre la consommation. Les modèles récents sont découpés en « experts » et chaque requête n’active que certains d’entre eux ; on ne réentraîne presque jamais un modèle à partir de zéro ; on compresse les réseaux neuronaux, on réduit la précision des calculs, on passe de seize bits à quatre. Dans le même temps, les puces spécialisées ont gagné un facteur mille d’efficacité en quinze ans. Nvidia, Google, Alibaba, Mistral ou DeepSeek multiplient les gains à chaque itération : une simple mise à jour logicielle suffit aujourd’hui à diviser par deux la consommation d’un processeur.

La vraie sobriété n’a donc rien de punitif, elle est technologique. L’IA devient chaque jour plus légère, plus rapide, plus proche de l’utilisateur. Certains modèles tournent déjà sur smartphone. On n’a jamais produit autant d’intelligence avec aussi peu d’énergie.

Qui veut noyer son chien l’accuse de la rage. C’est précisément au moment où la technologie devient capable d’éteindre la contestation que retentissent les appels les plus vibrants à la restreindre. Le Shift Project, think tank fondé par Jean-Marc Jancovici, recommande ainsi de « limiter le déploiement de l’IA aux usages prioritaires ». Définis par qui, au fait ?

Le rapport prédit un triplement de la consommation mondiale des data centers d’ici 2030, jusqu’à 1 500 TWh. Un scénario au-delà même des prévisions les plus pessimistes de l’Agence internationale de l’énergie, qui situe la fourchette entre 700 et 1 250 TWh.

Surtout, le Shift oublie un détail essentiel : déplacer les infrastructures n’en réduit pas la consommation, il la déplace. Empêcher l’installation de data centers en France, pays dont l’électricité est décarbonée à plus de 90 %, reviendrait simplement à les voir pousser ailleurs, sur des réseaux alimentés au gaz ou au charbon. En 2024, la France a exporté 89 TWh d’électricité ; même si tous les projets annoncés voyaient le jour, les data centers n’en consommeraient que 25 TWh d’ici 2035, soit un peu plus du quart de nos exportations actuelles. Mieux encore : une demande accrue contribuerait à stabiliser le coût du mégawattheure en améliorant le taux d’utilisation du parc nucléaire.

On reproche souvent à l’IA de trop consommer. On oublie tout ce qu’elle fait économiser. La visioconférence remplace des déplacements professionnels. Les bâtiments intelligents ajustent d’eux-mêmes leur chauffage. Les chaînes logistiques s’affinent, les réseaux se synchronisent, l’agriculture de précision limite l’irrigation et les intrants, la maintenance prédictive prévient les pannes et réduit les rebuts.

Partout où l’intelligence artificielle s’installe, les émissions reculent. Selon l’Agence internationale de l’énergie, les pays les plus numérisés voient leurs rejets de CO₂ baisser depuis près de vingt ans. En France, la consommation de papier et de carton a diminué de 26 % depuis 2000 : la dématérialisation, ici encore, a tenu ses promesses.

Chaque activité virtuelle alimentée par une électricité décarbonée est moins émettrice que son équivalent physique. Numériser les usages, c’est prolonger l’électrification de l’économie ; c’est l’étape suivante, logique et nécessaire, de la transition énergétique.

Et si, pour une fois, l’Europe ne ratait pas le train de la révolution technologique ? En moins de deux ans, Mistral AI est devenue la première décacorne française, valorisée à 11,7 milliards d’euros. Sa stratégie : l’open source, la transparence et l’efficacité. Hugging Face, avec ses 1,3 million de modèles hébergés et son milliard de requêtes quotidiennes, est déjà rentable. Autour d’eux, DeepL, Synthesia, Wayve, PhysicsX ou Black Forest Labs inventent une IA européenne, sobre, innovante et pragmatique. Encore faut-il que la vertu réglementaire ne se change pas en autocensure industrielle. Une fiscalité trop lourde, un soupçon systématique sur la technologie, et l’Europe reprendra sa place en tribunes.

L’intelligence artificielle n’est pas l’ennemie du climat, c’est déjà l’un de ses meilleurs alliés. Pendant qu’on se bat sur des chiffres, elle agit. Ses usages environnementaux se déploient dans trois grands domaines : l’énergie et le climat, la biodiversité et les écosystèmes, les ressources et la production. Elle mesure, anticipe, corrige. Elle réduit les gaspillages, rationalise la consommation et nous rend collectivement plus efficaces. Chaque kilowattheure dépensé pour elle en fait économiser bien d’autres ailleurs.

La vraie question n’est pas combien l’IA consomme, mais quelle est sa balance bénéfice-risque. Refuser son essor au nom d’externalités négatives montées en épingle, c’est renoncer à toutes les externalités positives qu’elle rend possibles. Autrement dit, se priver du progrès au nom de la peur qu’il inspire. Ou, plus cyniquement encore, vouloir interdire la solution parce qu’on prospère sur le problème.

L’article Non, l’IA ne va pas détruire la planète… Au contraire ! est apparu en premier sur Les Électrons Libres.

On entend partout que la demande d’électricité « explose » aux États-Unis. Le mot revient sans cesse, dans les journaux comme dans les conversations. Il n’y a aucun doute : cette demande va bel et bien croître, et dans de nombreux pays cela a déjà commencé. C’est plutôt une bonne nouvelle, car elle traduit le remplacement progressif des combustibles fossiles par l’électricité, l’un des piliers de la transition énergétique.

Mais beaucoup s’interrogent : les réseaux parviendront-ils à suivre cette croissance ? Cette question m’a intriguée. Cette hausse est-elle vraiment inédite ? Comment les rythmes d’aujourd’hui et de demain se comparent-ils à ceux du passé ? Parle-t-on d’une véritable explosion ou simplement d’une accélération marquée ?

Prenons un peu de hauteur en regardant les chiffres américains.

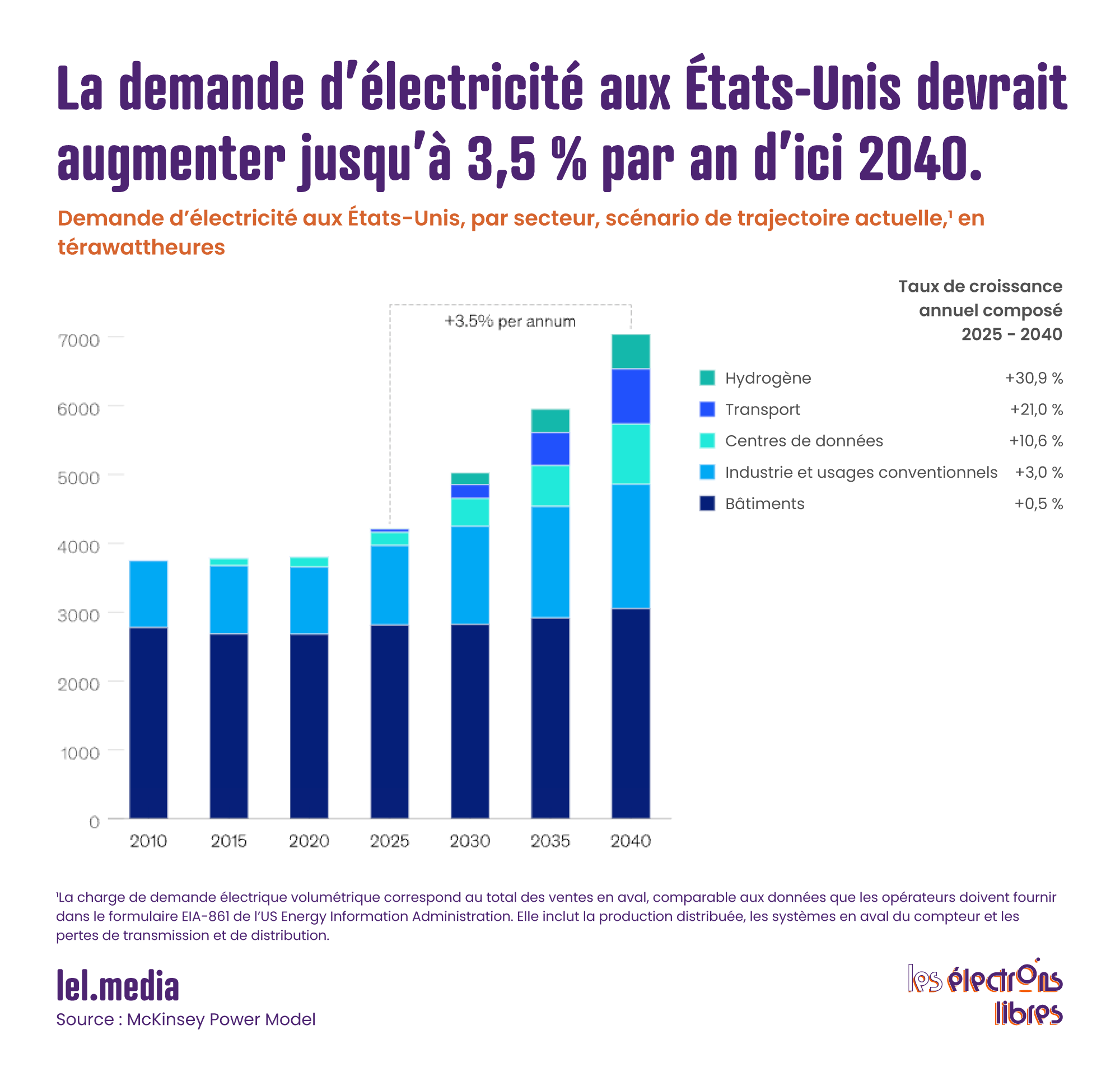

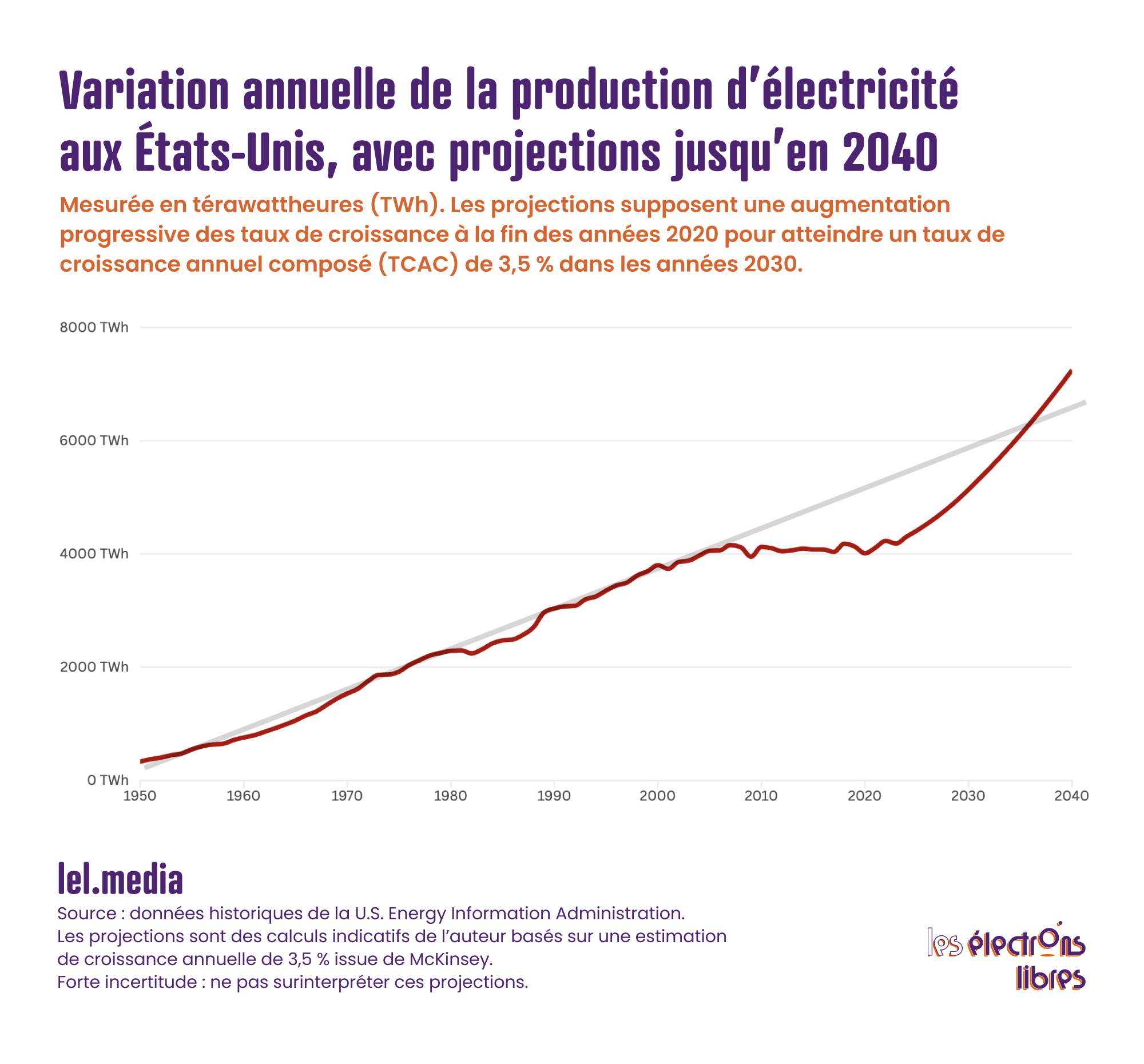

Le graphique qui suit est une projection classique, de celles que l’on croise dans presque tous les rapports d’instituts, d’analystes ou d’agences énergétiques. Celui-ci vient de McKinsey et date de cette année ; il est donc tout frais. Reste à savoir si ses prévisions sont fiables. Je doute personnellement de l’essor fulgurant de l’hydrogène, et personne ne peut prédire avec certitude la consommation des data centers en 2040. D’autres cabinets proposent des scénarios plus prudents ou plus ambitieux. Considérons néanmoins celui de McKinsey comme une hypothèse raisonnable.

On y voit la demande américaine rester stable tout au long des années 2010, repartir à la hausse ces dernières années et continuer sur cette lancée jusqu’en 2040. McKinsey mise sur une croissance moyenne de 3,5 % par an.

Par rapport aux années 2010, toute progression fait figure de rupture. Mais qu’en était-il avant ?

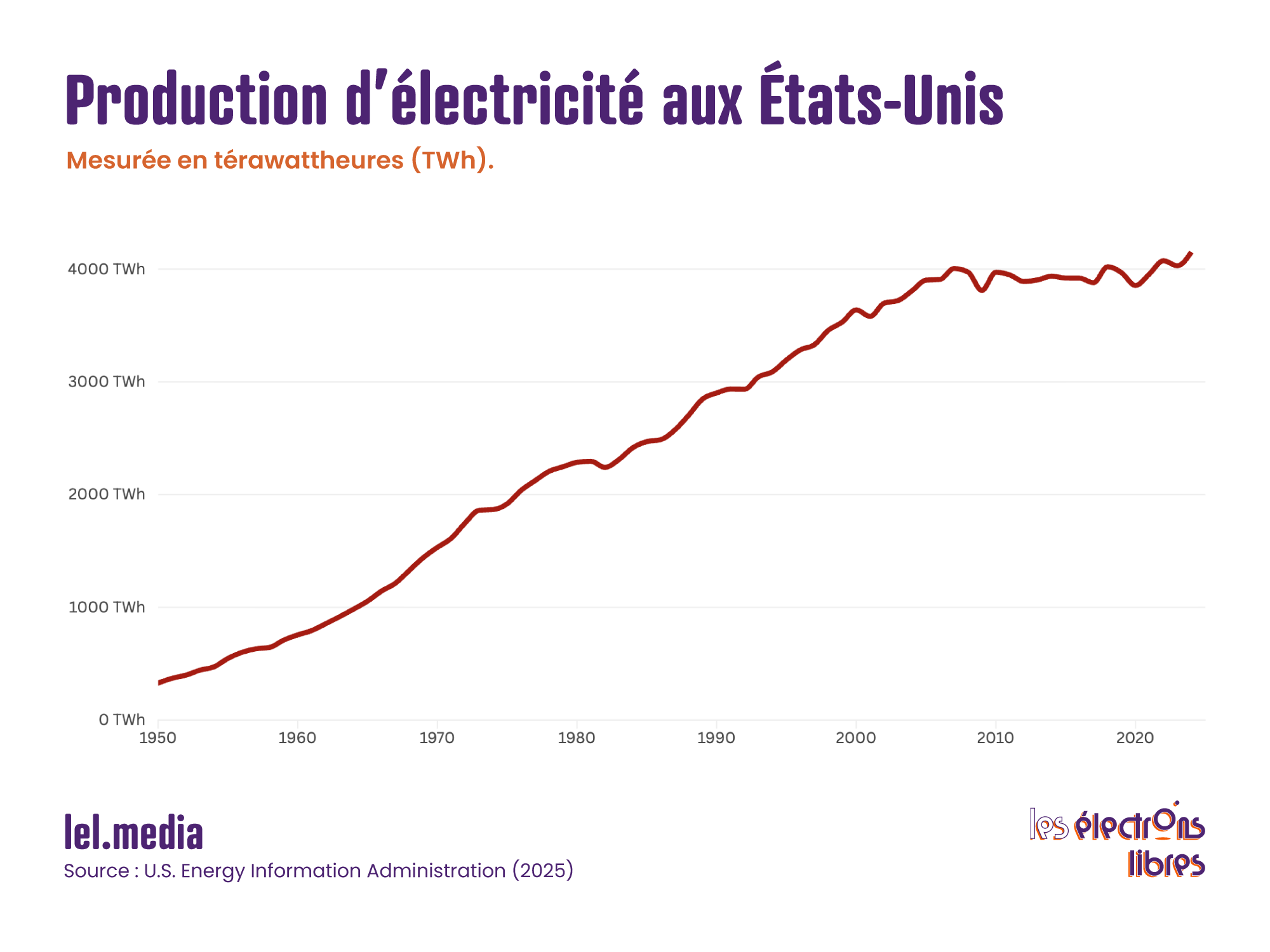

Le graphique suivant retrace la production d’électricité aux États-Unis depuis 1950. Attention : production et demande ne coïncident pas toujours. La demande peut dépasser la production, ou l’inverse, ce qui influe sur les prix.

Il est parfois difficile de raccorder parfaitement les données historiques et les prévisions. Et que signifiait exactement « demande » en 1950 ou 1960 ? Peu importe : ce qui frappe, c’est que la production est restée quasiment équivalente chaque année depuis 2005, soit quinze à vingt ans de stagnation. En revanche, les cinquante années précédentes montrent une croissance forte et régulière.

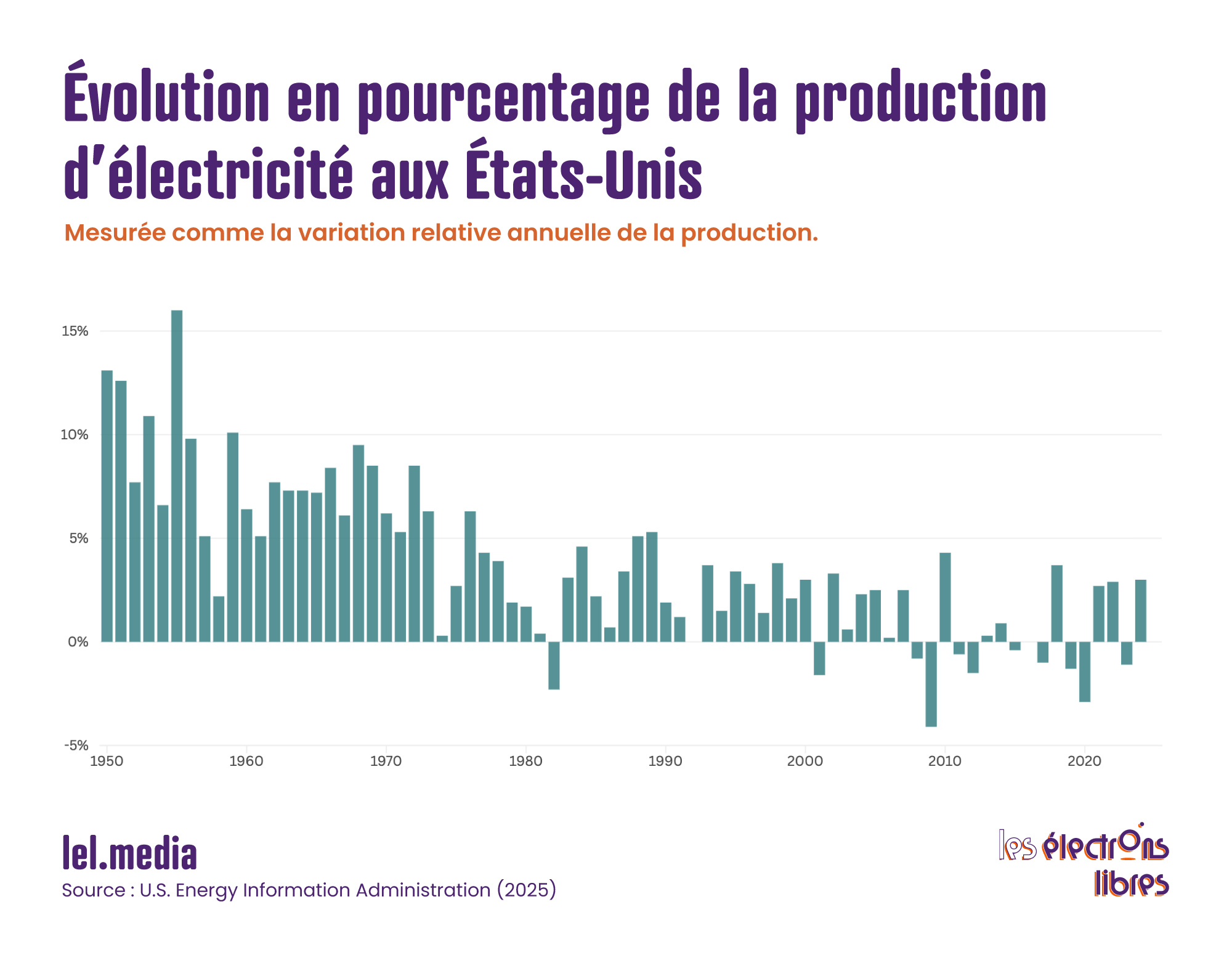

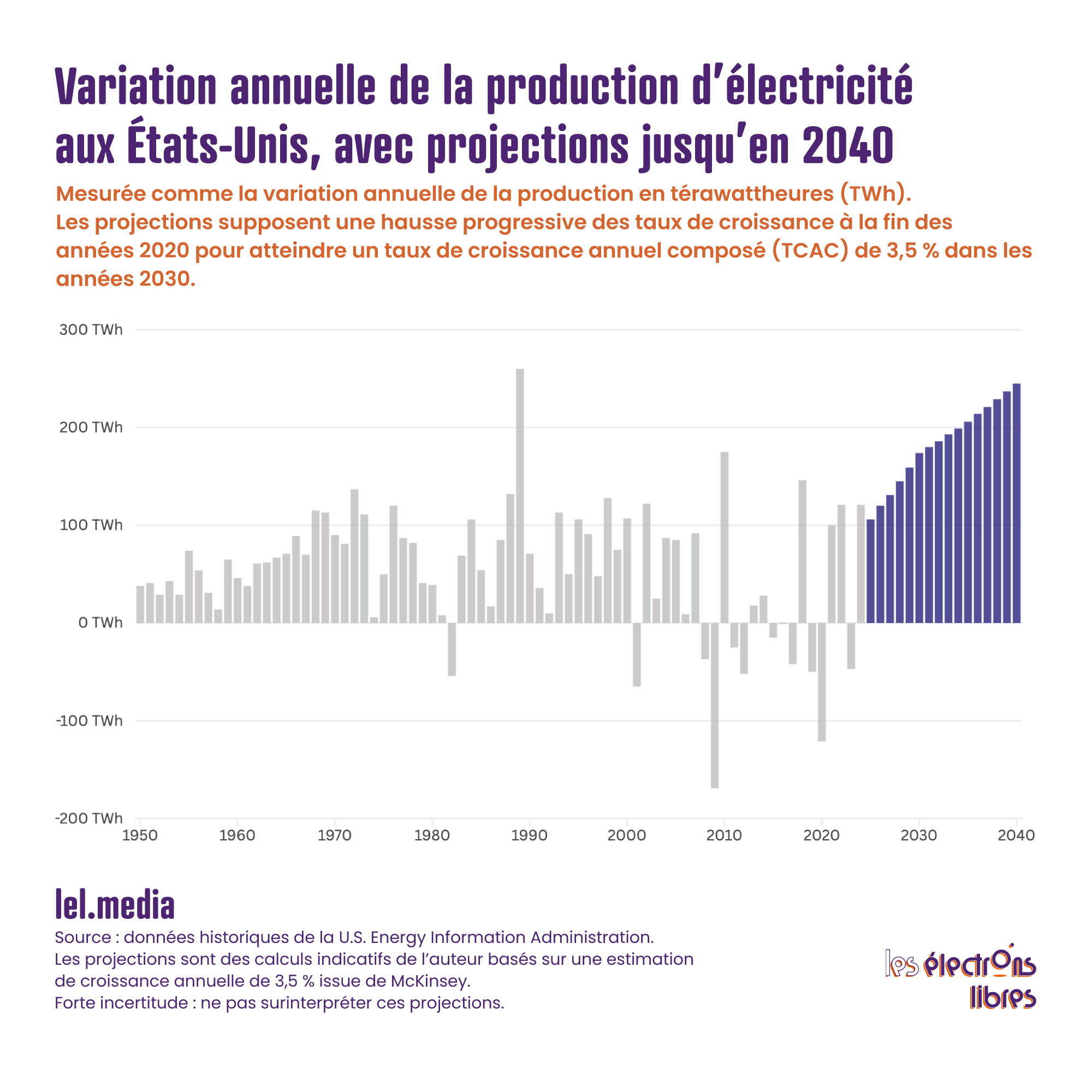

Calculons maintenant les taux de croissance annuels, reportés dans le graphique suivant. Dans les années 1950 et 1960, la production progressait de plus de 5 % presque chaque année, souvent proche de 10 %. Il est vrai que la base était minuscule. J’y reviendrai.

Dans les années 1970 et 1980, les taux oscillent entre 3 % et 4 %. Dans les années 1990, ils tombent autour de 2 %. Dans les années 2000 et 2010, la croissance est quasi nulle, hormis les soubresauts de la crise de 2008 et ceux liés à la pandémie de Covid.

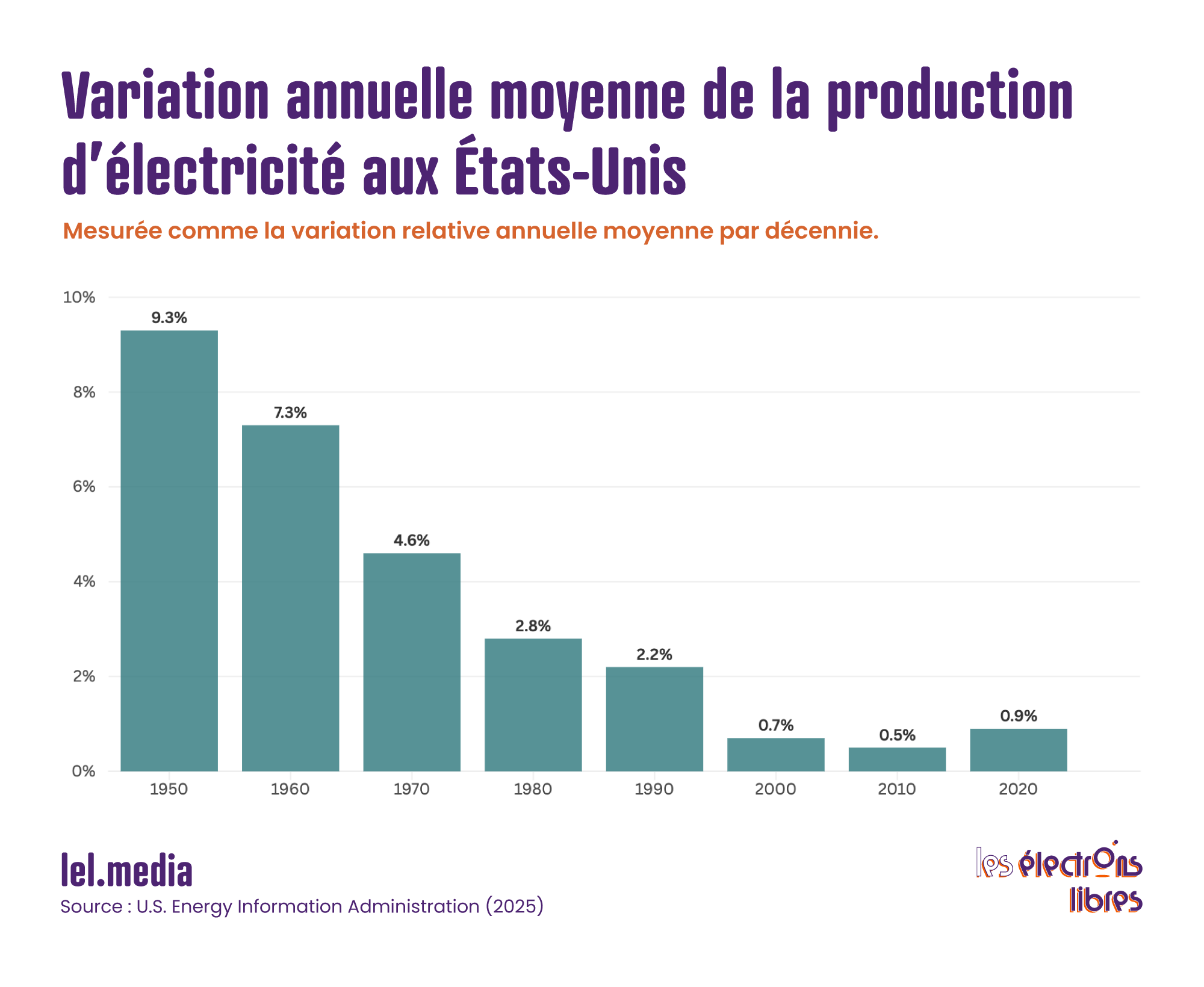

Pour simplifier, voici les mêmes données présentées sous forme de variation moyenne annuelle par décennie. Rappelez-vous maintenant le graphique de McKinsey : il tablait sur une croissance de 3,5 % par an jusqu’en 2040. Ce rythme serait certes élevé par rapport aux vingt dernières années, mais il n’aurait rien d’inédit dès lors qu’on prend du recul et qu’on observe les taux de croissance du milieu et de la fin du XXᵉ siècle.

Les taux relatifs sont utiles, mais ils masquent le volume réel. Plus le réseau grossit, plus un même pourcentage représente d’énergie supplémentaire.

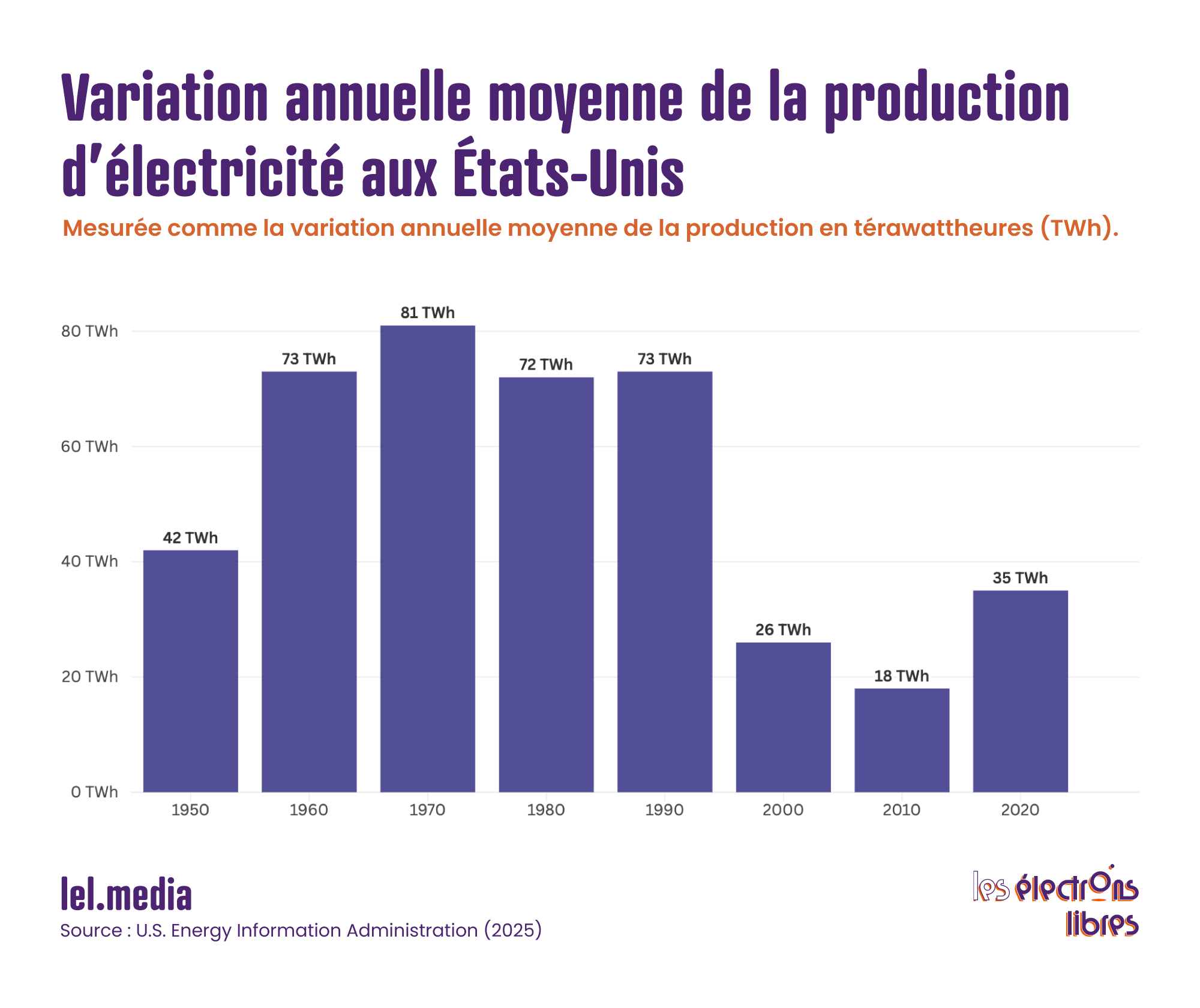

Le graphique suivant montre l’évolution, en térawattheures ajoutés chaque année depuis 1950. Même avec 8 à 10 % de croissance dans les années 1950 et 1960, la production américaine n’augmentait que de 40 TWh par an. Dans les années 1970, 1980 et 1990, on approchait les 100 TWh. Les années 2000 affichent de forts à-coups, mais aucune tendance durable, du moins jusqu’aux années 2020.

Voici, une fois encore, la variation moyenne annuelle par décennie : elle lisse les à-coups et rend la tendance limpide.

La croissance absolue a atteint son sommet dans les années 1970. Ce qui frappe surtout, c’est la régularité de l’augmentation en térawattheures tout au long de la seconde moitié du XXᵉ siècle. On retrouve exactement la même ligne droite que sur le graphique de la production totale montré plus tôt : avant le plateau des années 2000, la courbe était d’une linéarité remarquable.

Et demain, justement ?

Avant de nous projeter dans les années 2030, demandons-nous si la hausse prévue pour 2025 et 2026 a vraiment de quoi nous effrayer. On entend déjà que les réseaux saturent. C’est vrai, mais le problème ne vient pas seulement du volume total : les data centers créent des pointes ultra-localisées, les lignes de transport arrivent à saturation, tandis que les contraintes sur le réseau se multiplient.

Face à l’histoire, cette accélération immédiate est-elle hors norme ? Pas du tout.

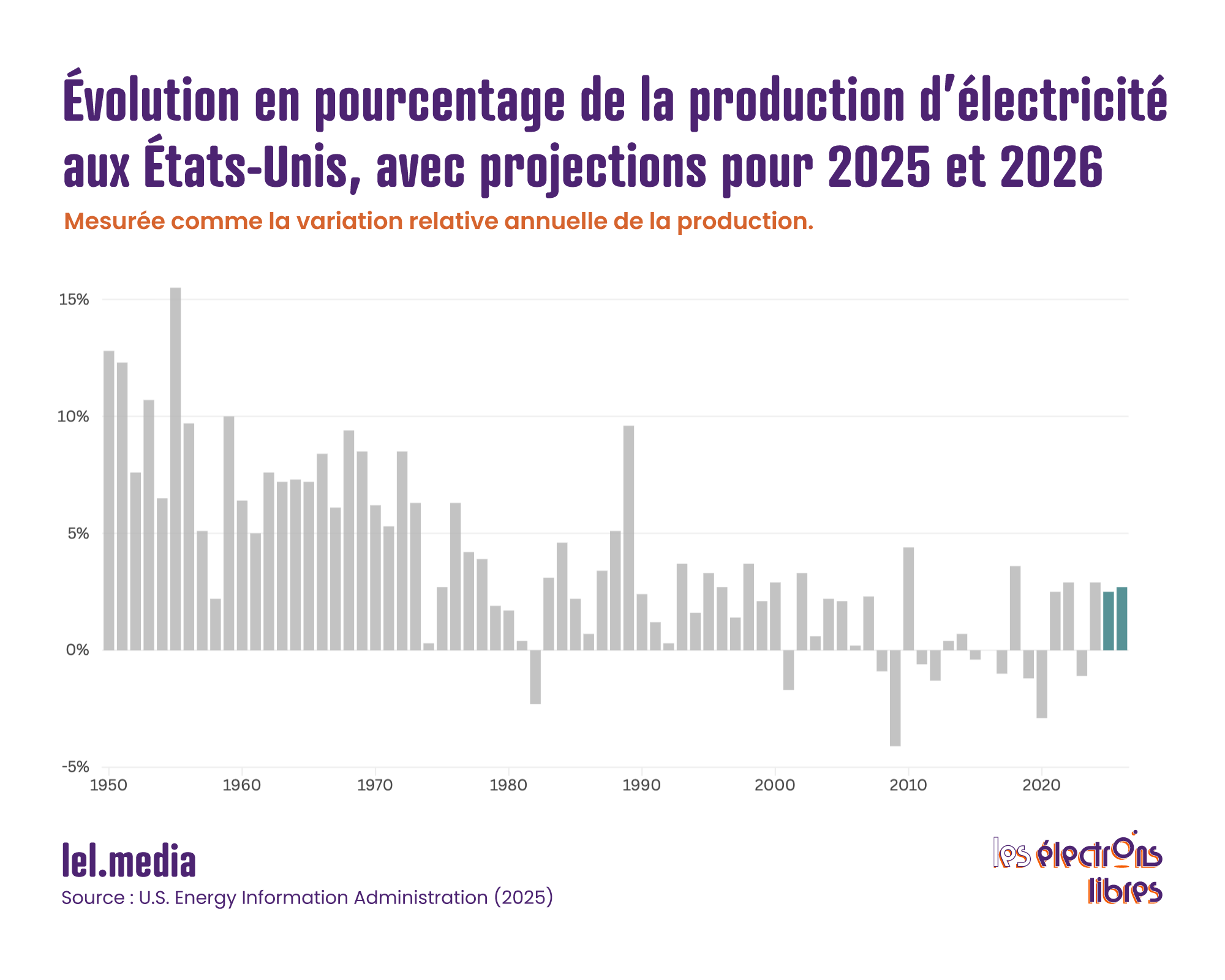

Sur le graphique ci-dessous, j’ai reporté les variations annuelles en pourcentage et ajouté les prévisions pour 2025 et 2026. Elles proviennent de l’Energy Information Administration (EIA) et datent de ce mois-ci ; elles sont donc récentes.

La production devrait progresser de 2,5 % en 2025 et de 2,7 % en 2026. Le creux du Covid et le rebond qui a suivi faussent la moyenne de la décennie 2020, mais ces deux chiffres collent parfaitement aux hausses observées en 2022 et 2024. Rien de révolutionnaire, donc.

Pour finir, revenons sur les prévisions de McKinsey. Elles tablaient sur 3,5 % de croissance annuelle de 2025 à 2040.

Reportons ce 3,5 % sur le graphique ci-dessous pour la décennie 2030. Pour les années 2020, c’est plus compliqué : la première moitié a été calme, et même les 2,5 % et 2,7 % prévus par l’EIA pour 2025-2026 restent sous la barre des 3 %. Même si les quatre dernières années s’emballent, la moyenne décennale ne dépassera probablement pas 3 %.

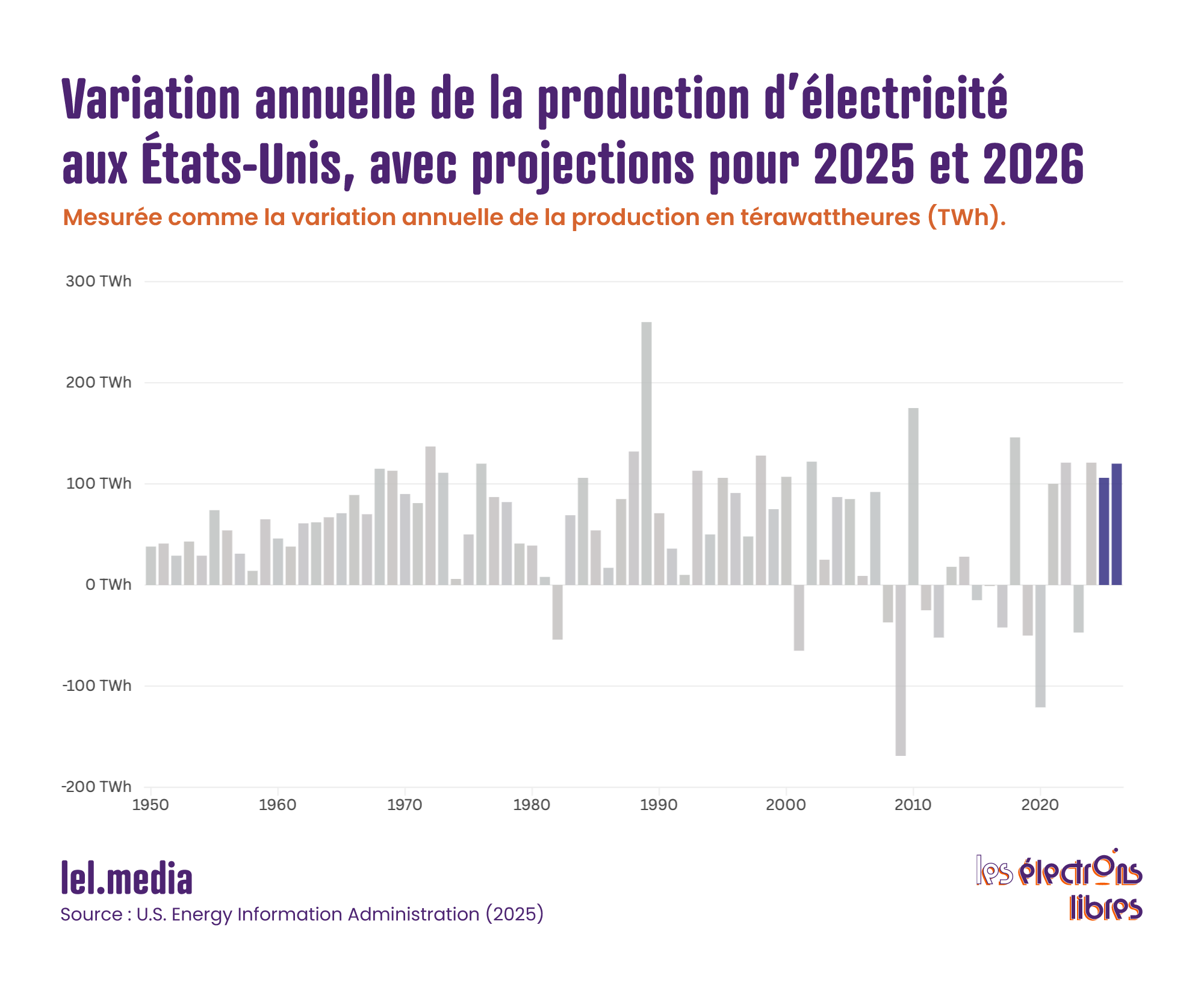

Le passage d’une croissance nulle au début des années 2000 à une vraie reprise dans les années 2020-2030 marque bel et bien une rupture. Mais, en rythme relatif, rien d’inédit quand on regarde plus loin dans le temps. Et si ces prévisions se confirment, à quoi ressemblera la croissance en volume absolu ? Voici un graphique pour en donner la mesure. Il est volontairement simplifié — la réalité historique est moins linéaire —, mais je projette une montée progressive jusqu’à 3,5 % en 2030, puis 3,5 % par la suite.

Certes, il y a déjà eu des années où la demande a augmenté de 150 TWh d’un coup. Mais c’était presque toujours un « rattrapage » après une chute brutale observée l’année précédente ; jamais on n’a connu une telle addition, année après année, sans relâche.

En volume brut, les États-Unis (et d’autres pays dans leur sillage) s’apprêtent donc à vivre une période absolument inédite. Pour injecter 150 à 250 TWh supplémentaires chaque année, il faudra construire à tour de bras — et vite.

Article publié le 20 octobre 2025 sur Substack sous le titre : La croissance de la demande d’électricité aux États-Unis est-elle vraiment sans précédent ?

L’article Électricité : aux États-Unis, une croissance vraiment inédite ? est apparu en premier sur Les Électrons Libres.

La phase d’expérimentation de la voiture autonome est terminée. Après des décennies de tests, son industrie se déploie à grande échelle. Ce qui était hier une curiosité technologique devient un marché en pleine expansion qui pose des questions de société.

Filiale d’Alphabet, Waymo s’affirme comme le leader mondial incontesté du secteur, avec plus de 161 millions de kilomètres parcourus sans conducteur et plus de 10 millions de trajets commerciaux effectués, soit une progression vertigineuse de 51 % depuis février 2025.

En plus de prévoir d’ajouter neuf nouvelles villes aux cinq où circulent ses véhicules (Phoenix, Los Angeles, San Francisco, Atlanta et Austin), Waymo s’attaque à l’un des marchés les plus complexes et convoités : New York. En juin, l’entreprise a annoncé son retour dans la « Big Apple » après l’obtention d’un permis l’autorisant à conduire de manière autonome avec un « conducteur de sécurité » derrière le volant.

Mais son expansion ne s’arrête pas aux frontières américaines. Après avoir démarré des tests à Tokyo, l’entreprise a révélé en octobre qu’elle commencerait à offrir des trajets entièrement autonomes à Londres dès 2026.

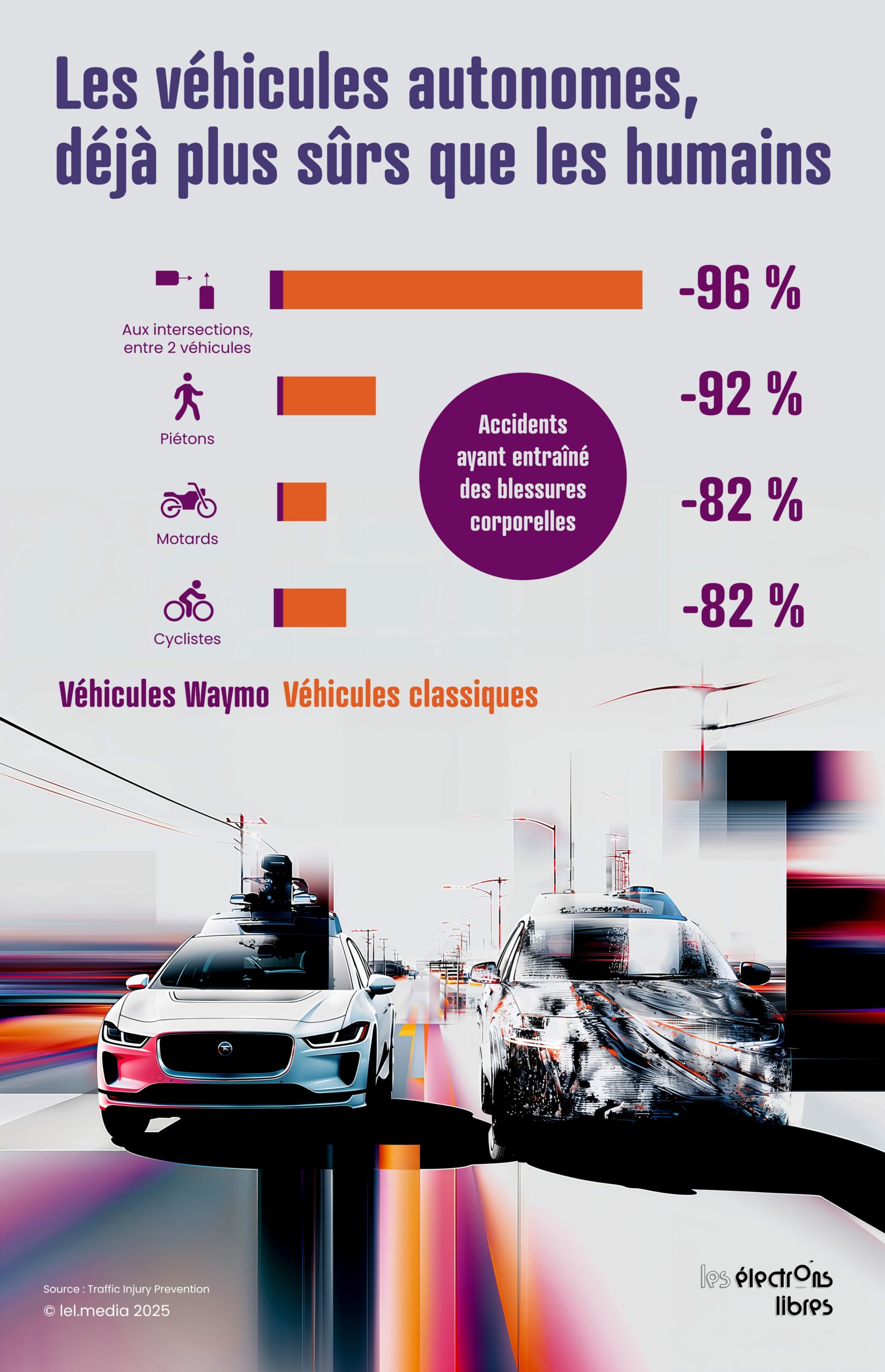

Sur la base d’une analyse de 155 millions de kilomètres, ses données révèlent une sécurité spectaculairement supérieure à celle des conducteurs humains, avec 91 % de collisions graves, 80 % d’accidents corporels et 92 % de piétons blessés en moins.

Dans le même registre, Zoox, la discrète mais puissante filiale d’Amazon, a aussi ouvert son service de taxis autonomes à Las Vegas en septembre dernier. Elle est devenue la première entreprise au monde à lancer un tel service payant dans un véhicule conçu spécifiquement à cet effet.

Souvent à la pointe de l’innovation, Tesla affiche en revanche un décalage entre ambitions et réalité. Malgré des capacités prometteuses en conditions difficiles, son offre, lancée à Austin en juin 2025, nécessite toujours un superviseur de sécurité. L’objectif de « couvrir la moitié de la population américaine d’ici fin 2025 » se limite à une vingtaine de véhicules sur 635 km² dans la ville texane.

Enfin, Uber a orchestré une alliance stratégique réunissant Nvidia pour son intelligence artificielle, Lucid pour ses SUV électriques et Nuro pour le logiciel de conduite autonome. Ce partenariat nourrit de grandes ambitions : déployer 20 000 robotaxis sur six ans, intégrés dans une flotte totale de 100 000 véhicules d’ici 2027.

À l’automne 2025, le géant chinois Baidu égale désormais Waymo avec 250 000 courses autonomes hebdomadaires. Cette percée illustre la stratégie gouvernementale de Pékin, qui s’imagine en leader mondial d’ici 2035. Après avoir gelé les permis à la suite des protestations de taxis, les régulateurs ont repris leur délivrance, privilégiant l’intérêt stratégique face à la concurrence américaine.

Mais l’Empire du Milieu a d’autres cartes en main : Pony AI, soutenue par Toyota, qui vise 1 000 robotaxis et s’internationalise ; ou WeRide, présente dans trente villes réparties sur dix pays, qui a signé avec Uber pour quinze villes mondiales, avec déjà un service opérationnel en Arabie Saoudite.

Face à cette offensive, l’Europe ne compte qu’un seul champion : la startup britannique Wayve. Fondée en 2017, elle développe une IA qui apprend à conduire comme un humain, sans cartes en haute définition. Soutenue par Nvidia et Microsoft, elle cherche à devenir fournisseur de logiciels pour les constructeurs (Nissan dès 2027) et plateformes (Uber à Londres en 2026). Son approche promet aux constructeurs d’intégrer des systèmes avancés de conduite autonome sans surcoûts matériels.

Hélas, cette société incarne les limites et le malaise du vieux continent. Le fait qu’une seule entreprise européenne porte ses couleurs dans le domaine de l’IA automobile révèle l’ampleur du retard accumulé.

Quels sont les impacts attendus de la généralisation des voitures autonomes ? D’abord, rappelons que l’erreur humaine est à l’origine de 94 % des accidents mortels. Les systèmes autonomes ne boivent pas, ne se fatiguent pas, ne regardent pas leur téléphone et réagissent quasi instantanément.

Si les promesses se réalisent, les accidents pourraient baisser de 80 à 90 % avec une flotte entièrement automatisée. À l’échelle mondiale, cela représenterait potentiellement 1,25 million de vies sauvées chaque année. Concernant l’urbanisme, la demande de parkings en centre-ville pourrait s’effondrer de 90 %, puisqu’une voiture autonome vous dépose et repart.

Résultat : 20 à 30 % de l’espace urbain libéré. C’est la plus grande « banque foncière » du XXIᵉ siècle. À Chandler, en Arizona, on remplace déjà 40 % des places de parking obligatoires par des zones de dépose pour véhicules autonomes.

La vraie révolution se jouera peut-être loin des métropoles. Dans les zones rurales, le véhicule autonome résout une équation impossible : comment offrir des transports publics de qualité là où la densité de population est trop faible pour rentabiliser bus et trains ?

Dans certains pays comme le Japon, le coût d’exploitation du transport rural est trois fois supérieur aux recettes, essentiellement à cause des salaires des chauffeurs. En supprimant ce coût, les navettes autonomes rendent viable un transport à la demande, flexible, venant vous chercher à domicile.

Fini les lignes de bus désertes à horaires fixes, fini l’isolement des personnes âgées en zone rurale. Imaginez une flotte de véhicules autonomes assurant le « dernier kilomètre », se coordonnant avec des navettes plus grandes sur les axes principaux. C’est le droit à la mobilité pour tous, à faible coût.

Le bouleversement sera particulièrement fort pour celles et ceux qui ne peuvent pas conduire : les personnes âgées, les malvoyants, les personnes handicapées, les jeunes en dessous de l’âge légal. Pour toutes ces personnes, le véhicule autonome, c’est l’indépendance retrouvée. C’est une révolution d’inclusion, qui redonne de la mobilité à ceux qui en étaient privés.

Pour tous les autres, outre les immenses gains de sécurité, la promesse de la voiture autonome, c’est celle du confort : ce temps passé au volant, concentré et stressé, devient un moment de détente ou de productivité. Un trajet de 90 minutes n’est plus une contrainte insupportable s’il permet de travailler ou de se reposer. C’est votre bureau mobile, votre salon roulant, votre salle de sieste.

Le temps de trajet pourrait être grandement raccourci. Grâce au « platooning » — cette capacité des véhicules autonomes à rouler en convoi serré en communiquant entre eux —, l’occupation d’une voie pourrait être multipliée par six. Cela permettrait d’éliminer les embouteillages et ralentissements. Des expérimentations ont montré qu’on peut maintenir seulement quatre mètres entre chaque voiture à 120 km/h, en toute sécurité.

Cette coordination ouvre aussi la voie à une augmentation des vitesses limites sur autoroute. Si tous les véhicules d’une voie sont autonomes et synchronisés, on peut imaginer relever progressivement la vitesse autorisée bien au-delà des 130 km/h actuels, tout en maintenant un très haut niveau de sécurité.

Qui sera responsable en cas d’accident ? Il est probable que la responsabilité bascule du conducteur vers le constructeur et l’opérateur. En France, un décret de 2021 dispose que, lorsque le système de conduite automatisée est activé, le conducteur ne peut plus être tenu pour responsable s’il a respecté les conditions d’utilisation.

La conduite manuelle ne sera probablement pas immédiatement interdite par la loi. Quand les véhicules autonomes auront prouvé qu’ils sont cent fois plus sûrs que les humains, il est toutefois probable que votre prime d’assurance pour conduire manuellement devienne prohibitive, ou tout simplement que cette pratique soit interdite pour minimiser les risques.

L’expansion des robotaxis se heurte cependant à une opposition politique croissante. À Seattle, des manifestants ont protesté contre l’arrivée de Waymo, craignant pour les emplois des chauffeurs Uber et Lyft. Les puissants syndicats Teamsters poussent pour des législations restrictives dans plusieurs États : Washington, le Massachusetts et la Californie, où le gouverneur Newsom a opposé son veto à deux reprises à des projets exigeant un conducteur humain dans les véhicules autonomes lourds.

Pourtant, l’histoire technologique montre que l’emploi se transforme plus qu’il ne disparaît. Les tracteurs ou les distributeurs automatiques n’ont pas créé de chômage massif, mais ont permis aux travailleurs d’évoluer vers des postes moins pénibles. Les emplois liés aux véhicules autonomes — maintenance technique, supervision de flotte — offrent généralement de meilleures conditions qu’un métier de conducteur aux revenus précaires et aux longues heures assises. L’enjeu n’est pas de freiner le progrès, mais d’accompagner cette transition professionnelle.

Cette révolution ne se résume pas au confort de pouvoir se détendre en roulant. Elle ouvre une transformation industrielle, urbaine et sociale majeure, qui va modifier en profondeur notre rapport à la voiture, à la ville et au déplacement. Un bouleversement, mais aussi un champ d’opportunités que citoyens, entreprises et décideurs devront s’approprier sans attendre.

L’article Voitures autonomes : le monde d’après est apparu en premier sur Les Électrons Libres.