Aux grands maux les bons remèdes

L’humanité dispose-t-elle encore de moyens d’agir, ou a-t-elle déjà perdu la bataille de la biodiversité ? Et devra-t-elle renoncer au progrès pour espérer se sauver ?

D’un côté, le déni ou l’indifférence : la tentation confortable de détourner le regard, en espérant que le problème finira par se résoudre tout seul. De l’autre, la panique, qui mène soit à la résignation fataliste, soit à la remise en cause radicale de nos modes de vie… jusqu’à prôner une forme de régression joliment rebaptisée « décroissance ».

Mais entre ces deux extrêmes, une troisième voie existe : celle du pragmatisme. Chercher des solutions concrètes, efficaces et compatibles avec le fonctionnement moderne de nos sociétés. Cette approche, pourtant défendue par les grandes instances scientifiques comme l’IPBES, reste étonnamment absente du débat public.

La direction à suivre

Montréal, décembre 2022. Alors que la COP15 – la grande convention mondiale sur la diversité biologique – bat son plein, un accord historique est adopté à l’unanimité des 196 délégations présentes : le Cadre mondial de la biodiversité de Kunming-Montréal (CMBKM). Moins médiatisée que les COP sur le climat, cette conférence n’en affiche pas moins des ambitions considérables : « Stopper et inverser la perte de biodiversité d’ici 2030 ».

Le plan s’articule autour de 23 cibles d’action, regroupées en quatre grands axes :

- maintenir, conserver et restaurer les milieux naturels ;

- promouvoir une gestion durable des ressources (agriculture, pêche, forêts) ;

- réduire les pressions liées à la pollution, aux espèces exotiques envahissantes et au changement climatique ;

- et garantir les moyens de mise en œuvre, notamment financiers.

Malgré ces ambitions, le CMBKM n’a pas échappé aux critiques. En France, une partie de la gauche l’a jugé trop peu contraignant, trop flou, et surtout trop timide, notamment sur ses thèmes de prédilection 一 les mégabassines, les pesticides ou la promotion du bio 一 qui semblent eux-mêmes plus dictés par l’idéologie que par l’efficacité.

Il faut cependant bien admettre que le précédent plan, les Objectifs d’Aichi (2010-2020), s’était soldé par un échec. Alors, comment faire, cette fois, pour que les belles intentions se traduisent enfin en actions concrètes et en résultats ?

Préserver les habitats

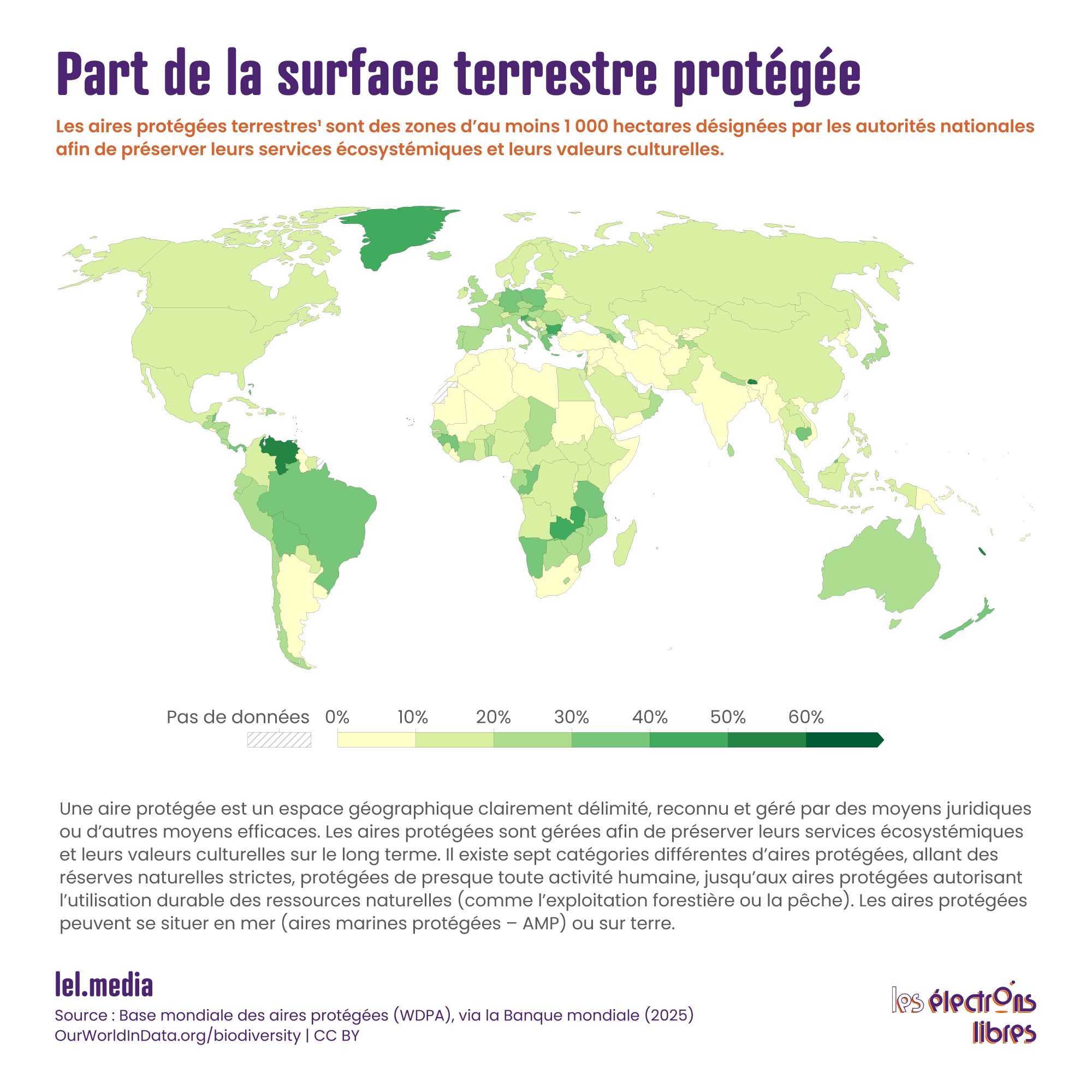

On l’a vu : la première cause du déclin de la biodiversité, et de loin, c’est la destruction et l’artificialisation des milieux naturels. Préserver les habitats reste donc le levier numéro un pour enrayer la crise du vivant. C’est aussi l’un des piliers du CMBKM, qui fixe un objectif emblématique, le plan 30×30 : protéger au moins 30 % des terres et des océans d’ici 2030.

Un objectif ambitieux, puisqu’il double les engagements d’Aichi (17 % des terres et 10 % des zones marines protégées à l’horizon 2020), restés largement inachevés. Et cette fois, la qualité compte autant que la quantité. Les zones protégées doivent disposer de plans de gestion concrets, de financements suffisants et de personnels dédiés. Elles doivent aussi refléter la diversité des écosystèmes — forêts, prairies, zones humides, récifs coralliens — et ne pas se limiter à des espaces peu productifs ou isolés.

Autre exigence majeure : la connexion entre ces aires grâce à des corridors écologiques, pour permettre la circulation des espèces et limiter la fragmentation des habitats. Le cadre encourage également l’implication des peuples autochtones et des communautés locales, reconnues pour leur efficacité et leur connaissance fine des territoires, à travers les Aires protégées et de conservation autochtones (APCA).

Et la bonne nouvelle, c’est que cette stratégie fonctionne. Une méta-analyse internationale conclut que deux tiers des actions de conservation menées dans des aires protégées aboutissent à une amélioration notable de l’état des populations menacées. Une autre étude montre qu’étendre les zones protégées à 30 % permettrait de sauver plus de mille espèces tout en contribuant à atténuer le réchauffement climatique.

Et la France, dans tout ça ? Permettons-nous un cocorico car chez nous, l’objectif 30×30 est déjà atteint, 33 % du territoire national étant couvert par une aire protégée. Cela représente très exactement 31 % des espaces terrestres (28 % en métropole, 45 % outre-mer) et 33 % des espaces maritimes (46 % en métropole, 32,5 % outre-mer). Entre zones Natura 2000, parcs naturels, réserves, sites du Conservatoire du littoral ou parcs marins, les dispositifs ne manquent pas.

Mais atteindre une cible ne signifie pas mission accomplie. Pour freiner durablement l’artificialisation, la France s’appuie sur le principe de Zéro Artificialisation Nette (ZAN), introduit en 2018 et inscrit dans la loi Climat et Résilience de 2021. L’objectif : mettre fin à la consommation illimitée d’espaces naturels, agricoles et forestiers. Toutefois, sa mise en œuvre révèle aussi des effets secondaires insuffisamment anticipés. En rigidifiant fortement l’accès au foncier, le ZAN tend à renchérir le coût du logement, à freiner certains projets de renouvellement urbain et à déplacer les pressions d’aménagement vers des territoires déjà fragiles.

La Trame verte et bleue, instaurée par la loi « Grenelle 1 » de 2009, elle, vise à reconnecter les milieux fragmentés. La Trame verte relie les habitats terrestres et humides (forêts, haies, prairies, zones humides), tandis que la Trame bleue rétablit les continuités aquatiques (cours d’eau, zones inondables, canaux). Passages à faune, aménagements de rivières, replantation de haies, intégration de la biodiversité dans l’urbanisme… autant de leviers concrets pour redonner de la cohérence au territoire et au vivant.

Repenser l’agriculture

Préserver les milieux naturels suppose d’abord de limiter leur grignotage par l’agriculture, première responsable de la déforestation mondiale. Car non, les pesticides ne sont pas le problème central, malgré la place qu’ils occupent aujourd’hui dans le débat public. Le véritable enjeu, c’est surtout l’occupation des sols. Aujourd’hui, les terres agricoles couvrent un tiers des surfaces émergées de la planète, et elles continuent de s’étendre.

En France, pourtant, le débat environnemental tourne souvent en boucle autour d’un mot magique : le « bio ». Mais l’agriculture biologique, si elle présente quelques bénéfices locaux pour les sols, réduit les rendements, et donc augmente mécaniquement les surfaces nécessaires pour produire autant. En clair, plus de bio signifie souvent… plus de terres cultivées.

Pas étonnant, donc, que le CMBKM n’en parle pas, et que l’IPBES ne la mentionne qu’une seule fois dans son rapport pour décideurs : ses avantages globaux pour la biodiversité restent à démontrer.

L’enjeu central devient alors celui d’une intensification écologique : produire suffisamment, sur moins de surface, tout en réduisant les impacts environnementaux. Cela implique de combiner plusieurs leviers — restauration des sols, diversification des cultures, couverts végétaux, progrès génétiques, agriculture de précision.

L’agriculture de conservation des sols (ACS) illustre bien cette approche pragmatique : ni idéale, ni universelle, mais capable, dans certaines conditions, de concilier productivité, résilience agronomique et bénéfices écologiques. Quant aux OGM, ils ont déjà montré la voie, avec une baisse moyenne de 37 % de l’usage des pesticides dans les cultures qui les ont adoptés. Les nouvelles techniques d’édition génétique (comme CRISPR-Cas9) ouvrent encore davantage de perspectives et pourraient, un jour, permettre de se passer d’une large part des traitements.

Préserver les milieux aquatiques

Remodeler notre agriculture contribue à réduire la pollution de l’eau par les engrais et les pesticides. Mais cela ne suffira pas. Car d’autres sources majeures persistent : eaux usées, rejets industriels et déchets plastiques. Il faut donc aussi dépolluer, comme cela a été fait récemment pour la Seine, en déployant des dispositifs d’épuration adaptés.

Concernant le plastique, trois leviers principaux existent : réduire la production et la consommation, renforcer la collecte et le recyclage, et nettoyer les milieux naturels. Un traité international contre la pollution plastique est en négociation à l’ONU depuis 2022… mais n’a toujours pas abouti.

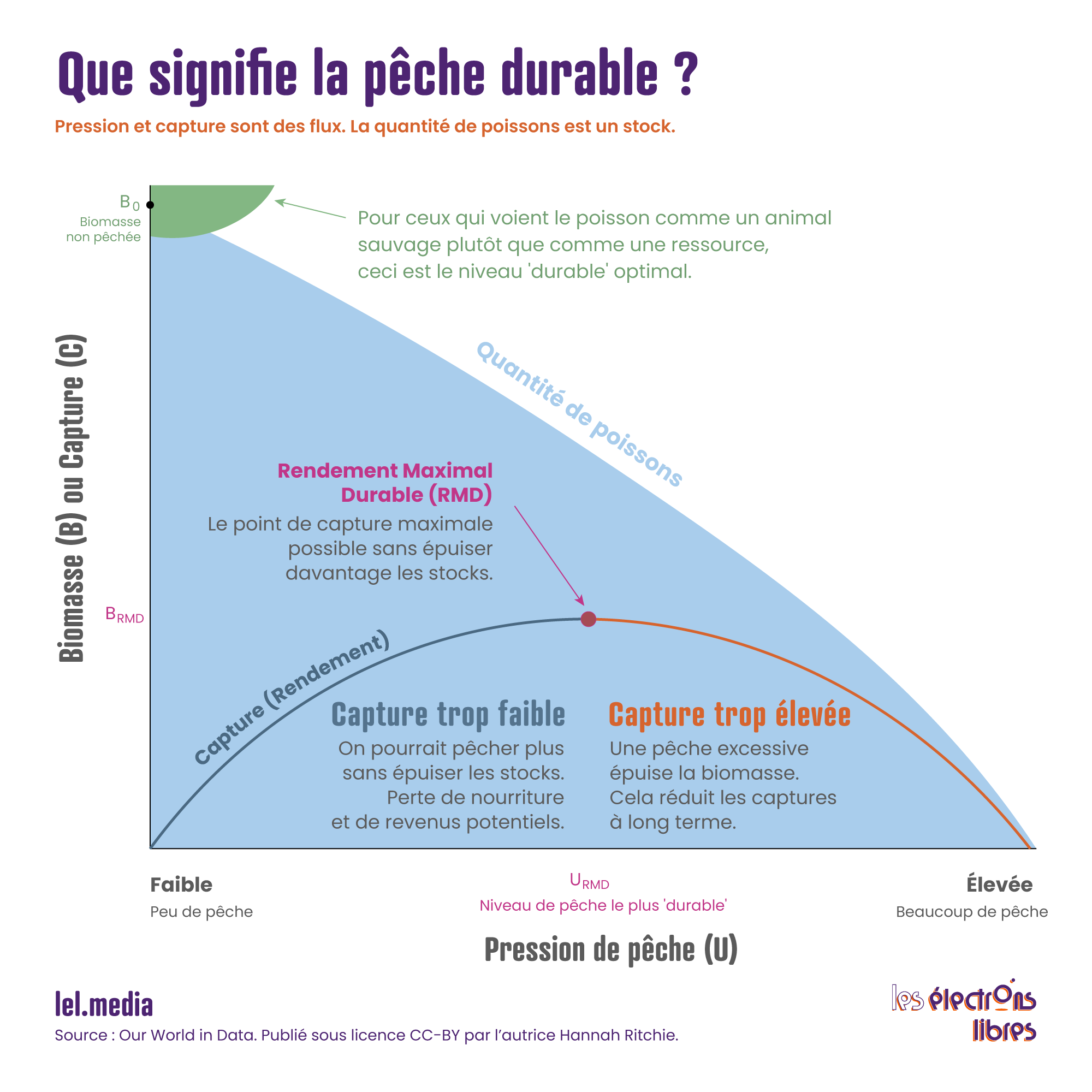

Mais la plus grande menace pour la biodiversité aquatique reste sa surexploitation. Un tiers des stocks évalués de poissons et de fruits de mer sont aujourd’hui pêchés au-delà de leur capacité de renouvellement. Le chalutage, utilisé pour un tiers des prises, aggrave le problème : il capture sans distinction, gaspille des tonnes de poissons rejetés à la mer, et racle les fonds marins, altérant les habitats benthiques.

Faut-il pour autant renoncer à la pêche ? Pas si simple. Car elle fournit des protéines animales avec une empreinte au sol nulle et un bilan carbone raisonnable, comparable, voire inférieur, à celui du poulet. Sans compter qu’elle fait vivre des millions de personnes. L’enjeu n’est donc pas de l’abandonner, mais de mieux la réguler : respecter les taux de renouvellement des stocks et restreindre les techniques les plus destructrices. C’est à ce prix qu’on peut concilier rendement et durabilité.

Enfin, l’aquaculture peut être une partie de la solution, à condition d’éviter l’écueil classique : nourrir les poissons d’élevage avec… des poissons sauvages. Ce qui, rassurons-nous, est de moins en moins le cas.

Économie et technologie : ennemis ou alliés ?

Oui, des solutions existent, et elles sont déjà sur la table. Et non, elles ne nécessitent pas de renoncer au progrès ni de bouleverser nos modes de vie. Le principal frein aujourd’hui n’est pas structurel, mais politique. Et surtout, économique. Car ces solutions ont un coût, et demandent des moyens à la hauteur des ambitions.

Faut-il alors « décroître » pour sauver la biodiversité ? Ce serait au contraire se tirer une balle dans le pied. Sans vitalité économique, impossible de financer la transition. Au contraire, une économie solide peut être un levier, à condition de bien orienter les politiques publiques : intégrer systématiquement l’impact environnemental dans tout nouveau projet, flécher les subventions vers les pratiques les plus efficaces plutôt que les plus idéologiques, et supprimer celles qui supportent les pratiques préjudiciables.

C’est d’ailleurs l’un des objectifs phares du CMBKM : « supprimer ou réformer les incitations nuisibles à la biodiversité », soit 500 milliards de dollars par an à rediriger d’ici 2030 vers des pratiques vertueuses. Mais encore faut-il savoir identifier ce qui est réellement nuisible. Car la technophobie ambiante conduit souvent à rejeter, par réflexe, tout recours à la technologie. Et pourtant, c’est probablement là que réside une bonne part des solutions.

Pour le diagnostic, d’abord. Les progrès en télédétection et en imagerie satellitaire permettent désormais de suivre en continu l’état des écosystèmes et d’évaluer les progrès, notamment dans le cadre de l’objectif « 30×30 ». Le séquençage génétique, quant à lui, ouvre de multiples perspectives, comme inventorier la biodiversité grâce à l’ADN environnemental, ou guider la préservation de la diversité génétique des populations via des transferts d’individus ciblés.

Pour la modélisation, ensuite. L’intelligence artificielle permettra prochainement d’interpréter les masses de données collectées et de simuler l’efficacité des politiques envisagées. Mais avant tout, la technologie est un outil d’action. Le génie génétique permet déjà de créer des plantes moins gourmandes en intrants grâce à la transgénèse et à l’édition génomique. Et à l’avenir, ces procédés pourraient aider à lutter contre certaines espèces envahissantes grâce au forçage génétique, une technique capable de propager un trait dans toute une population en quelques générations. Son potentiel est immense, même s’il soulève, à juste titre, d’importantes questions éthiques et écologiques.

Bref, la technologie n’est pas l’ennemie de la biodiversité. Elle en est peut-être même le meilleur espoir. Refuser ces leviers au nom d’une vision dogmatique du « retour à la nature », ce serait se priver d’une chance réelle de restaurer les écosystèmes. Voire de se tromper complètement de cible, au risque de contribuer à l’aggravation du problème.

L’article Aux grands maux les bons remèdes est apparu en premier sur Les Électrons Libres.