Intel officialise l’architecture Lunar Lake pour PC mobiles

Minimachines.net en partenariat avec TopAchat.com

Lunar Lake est le nom de la toute dernière architecture de puces ultramobiles d’Intel. Des processeurs économes en énergie, plus performants en calcul et en capacités graphiques et qui cochent même la case de l’IA. Mais surtout une nouvelle architecture qui bouscule les habitudes du fondeur. Apres Qualcomm et ses Snapdragon X, après AMD et ses Ryzen AI 300, Intel Lunar Lake ferme le peloton des annonces processeurs de ce Computex 2024.

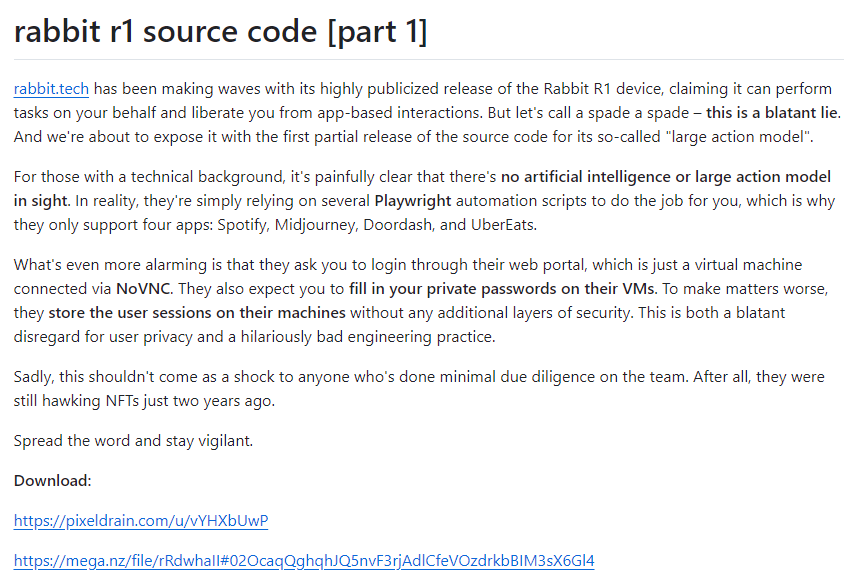

Autant commencer tout de suite par la pilule douce amère, on va parler IA.

Avec Lunar Lake, Intel appuie fort sur l’accélérateur IA, sans arriver au 50 TOPS des puces AMD, le fondeur annonce 48 TOPS de performance pour son NPU maison. C’est trois fois mieux que les Meteor Lake actuels et cela s’explique assez facilement par le triplement de la place consacrée au NPU sur le silicium de la puce.

Baptisé NPU4, ce nouveau package dédié à l’IA double la bande passante utilisée et augmente largement sa fréquence qui passe de 1.4 à 1.95 GHz. Ces choix s’expliquent assez facilement. Si Intel a annoncé les AI PC comme une série d’éléments correspondant parfaitement à ses processeurs il y a quelques semaines, Microsoft de son côté a décidé de lever la barre beaucoup plus haut avec sa norme Copilot+.

En combinant toutes leurs ressources les puces Lunar Lake atteignent 120 TOPS

Le seuil à atteindre pour être éligible aux fonctions d’IA de Microsoft est de 40 TOPS. Les Snapdragon X de Qualcomm affichent 45 TOPS, Intel passe devant avec 48 TOPS et AMD annonce 50 TOPS. Des valeurs obtenues par les NPU seuls, sans adjonctions de capacités liées aux circuits graphiques ou aux processeurs. Cette course peut se lire assez simplement. Si pour le moment les usages réels de toutes ces capacités sont très flous quand on interroge les constructeurs, l’objectif semble ici d’obtenir uniquement le précieux sésame de Microsoft. Pour Intel comme pour AMD et Qualcomm il semble très difficile de pouvoir vendre un PC à l’avenir sans un NPU performant. Car cela les empêcherait d’être estampillé compatibles « Copilot ».

Ce qui me laisse penser que la prochaine étape chez Microsoft sera d’imposer un certain niveau de calcul d’IA par défaut pour obtenir une évolution vers le futur Windows. Comme Windows 11 a restreint les installations à des machines correspondant à un certain niveau d’équipement materiel, je suis prêt à parier que le futur de l’OS passera par l’obligation d’avoir un NPU assez performant. Intel est donc paré pour cela avec Lunar Lake.

Reste à savoir ce que les fabricants vont faire réellement de toutes ces capacités, pour le moment ce n’est vraiment, vraiment pas très clair.

Lunar Lake introduit la mémoire intégrée au CPU

A l’instar des puces Apple depuis le M1, Intel souhaite réduire la consommation et augmenter la performance des composants mémoire des machines en les intégrant directement sur le même composant que le processeur. Cette intégration « Memory On Package » a évidemment des avantages importants mais également quelques défauts.

Le premier de ces défauts, on en a déjà parlé, n’est est plus vraiment un. Il s’agit d’une limitation de l’évolution de la RAM. Avec des composants LPDDR5x intégrés sur le processeur il ne sera plus possible de faire évoluer sa machine en mémoire vive. Ce n’est pas si problématique puisque les constructeurs ont de toutes façons pris la mauvaise habitude de recourir à des composants soudés directement sur la carte mère. Changer la manière dont cela est soudé n’est donc pas vraiment un souci.

Le second défaut est la limitation à 32 Go de mémoire maximum. Ce qui pourra gêner certains utilisateurs. Si ce montant est largement suffisant pour la majorité des usages, divers métiers ne s’en satisferont pas. Reste a savoir si Lunar Lake est la bonne fondation pour établir ce type d’utilisation. Intel prévoit également des puces qui garderont toujours une mémoire amovible comme les Arrow Lake prévus pour la fin 2024.

Pour les avantages, ils sont assez nombreux. D’abord cela permet d’avoir une mémoire vive au frais, elle bénéficiera du même système de ventilation que le processeur. Ce qui évitera toute surchauffe mais également l’obligation de rajouter un circuit de refroidissement dédié supplémentaire. Autre point clé, cela libère de la place sur la carte mère, 250 mm² annonce Intel. Un détail qui devrait permettre de nouvelles implantations et parfois le rajout d’un port M.2 supplémentaire en optimisant un peu. Enfin, outre un meilleur dialogue entre le processeur et la mémoire vive, on aura une consommation en baisse sur ce poste.

Des performances générales en nette hausse

Ceux qui ont connu les années où Intel pataugeait dans la même finesse de gravure, la même solution technique recyclée encore et encore en arrachant péniblement une augmentation de performances à deux chiffres au prix d’une augmentation des watts et des fréquences, ceux là apprécieront les chiffres avancés par Lunar Lake.

La puce propose pour commencer une augmentation de 50% de ses performances graphiques dans les tests. Cette nouvelle génération de circuit promet jusqu’à 8 cœurs Xe2 et 8 unités de calcul de Ray Tracing. Le résultat peut permettre à cette puce de proposer jusqu’à 80% de performances en plus dans certains jeux par rapport à Meteor Lake. On devrait dépasser les 60 images par seconde sur des titres récents en FullHD avec un processeur qui vise au départ l’ultra-portabilité. J’ai ainsi pu voir une démonstration de la puce en vidéo gérant sans soucis un titre récent en FullHD à plus de 60 images seconde sur un design d’une finesse étonnante.

Et la marque n’oublie pas ses fonctionnalités graphiques avancées habituelles en annonçant la prise en charge des codecs H.266 VVC. Cela devrait permettre une baisse significative de la place nécessaire pour une vidéo identique exploitant le codec AV1 pour la même qualité d’image. Ce format AV1 qui sera par ailleurs pris en compte en encodage comme en décodage totalement matériellement. Le circuit Intel pourra adresser jusqu’à trois flux UltraHD à 60 images par seconde en HDR en même temps.

Autre élément intéressant, la prise en charge du format eDP 1.5 pour l’écran des portables. Une norme qui permettra de limiter la consommation de courant de l’affichage.

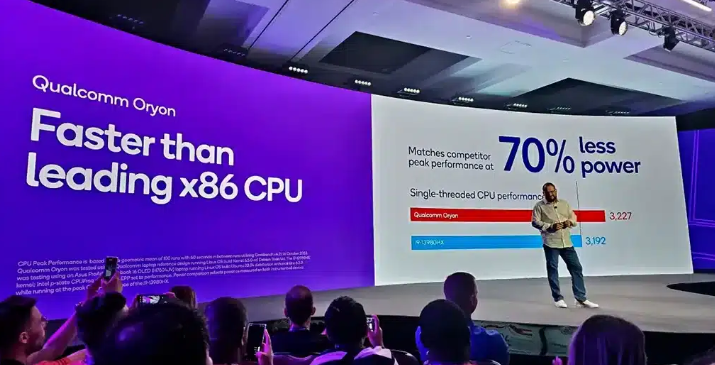

La partie processeur de son côté sera jusqu’à 50% plus rapide dans ses calculs les plus lourds. La logique d’Intel a été particulièrement bouleversée avec cette nouvelle architecture mais l’idée globale est de proposer un processeur plus performant mais aussi plus économe suivant les scénarios d’usage. Pour cela la puce annonce une meilleure efficacité dans tous les scénarios. De 20% à 80% de performances en plus par watt dépensé suivant les scénarios. Beaucoup de choses ont été mises en place pour proposer autre chose que de la puissance brute. Par exemple, le processeur pourra ajuster sa fréquence de manière très fine avec des intervalles de 16.67 MHz seulement de manière à trouver la formule la plus juste pour fournir la puissance nécessaire pour une tâche sans trop dépenser d’énergie.

D’autres éléments plus centraux dans le développement d’Intel depuis de longues années sont également remaniés. On reste sur une architecture hybride mêlant des cœurs Performants « P » et des cœurs Efficients « E ». On change par contre la donne puisque les cœurs « P » sont désormais sous architecture Lion Cove plus optimisés et ayant de meilleures performances que les précédents. Les cœurs « E » d’architecture « Skymont » afficheront des débits supérieurs et une consommation toujours plus faible. Cette évolution permet à Intel de se débarrasser des cœurs LP-E, ses unités « Low Power ».

La logique ici est assez simple, contrairement aux puces Meteor Lake, les nouveaux Lunar Lake préfèrent pouvoir baisser drastiquement la puissance des cœurs E plutôt que d’ajouter des cœurs supplémentaires juste capables de mener à bien ces tâches à très très basse consommation. Ce choix permet également d’économiser de la place sur le circuit et évite de compliquer la situation.

Il faut dire également que la volonté d’Intel avec Meteor Lake n’a pas eu vraiment d’impact dans le monde réel. Si le projet était intéressant, il ne fonctionnait pas en pratique. Pour faire simple, l’idée des LP-E était de proposer un ensemble autosuffisant de cœurs pouvant effectuer des tâches ayant besoin de très peu de ressources. Se connecter en « sous marin » pour regarder ses emails par exemple. Pour se faire les cœurs LP-E étaient associés au module Wi-Fi et Bluetooth, à de la mémoire vive et même à des fonctions d’affichage. Le tout était intégré dans ce qu’Intel avait baptisé le “low power island ». Un archipel de composants capables de travailler sans réveiller les cœurs puissants mais gourmands qui dorment sur le même matelas de silicium.

En pratique Windows ne se servait pas de ce dispositif. La raison est d’ailleurs assez simple, aussi bonne soit cette idée sur le papier, elle se confronte au réel de la situation. Les usages qui pourraient avoir besoin de ce dispositif sont pilotés par… les smartphones. Objets qui font très bien toutes les tâches basse consommation comme le relevé de mail ou la lecture de musique diffusé par Bluetooth. Des qu’il s’agit de faire des actions plus nerveuses, il faut recourir aux cœurs les plus puissants. L’usage d’un outil comme l’ordinateur ne se satisfait tout simplement pas réellement d’un usage minimal.

Résultat des courses, les cœurs LP-E passent à la trappe.

La bonne nouvelle c’est que Intel a travaillé de concert avec Microsoft pour proposer une meilleure gestion de la consommation des puces et augmenter significativement l’efficacité des cœurs « E ». Ces nouveaux cœurs « Lion Cove » peuvent désormais fonctionner aussi bien qu’un cœur LP-E mais pour un tiers de leur consommation d’énergie. Mieux, en cas de besoin ils peuvent doubler ou quadrupler leurs performances.

Sur certaine tâches la majorité du temps le travail sera effectué sur les cœurs « E »

Enfin, Windows est désormais capable d’affecter des tâches aux cœurs « E » uniquement. En créant des zones de travail réservées à cette architecture, le système évite de mettre en route les éléments les plus gourmands des puces. Cela se programme en amont via le système et les programmes intéressés pourront en tirer partie plus facilement. Un éditeur qui veut faire un lecteur de média uniquement piloté par les cœurs les moins énergivores de votre PC pourra le mettre en place plus facilement. Et tout cela aura un impact sur l’autonomie de votre machine.

L’autre gros changement annoncé par Lunar Lake ? La fin de l’hyperthreading pour cette puce. Un procédé employé par Intel depuis le Pentium 4. Sur les 8 cœurs embarqués, aucun ne prend en charge cette technique. Pour faire simple, cette solution permet à un seul cœur d’en émuler deux. Mais pour Intel le jeu n’en vaut tout simplement plus la chandelle sur ce type de puce.

L’ajout et l’évolution de 4 cœurs « E » supplémentaire permet de proposer un meilleur rendement et de meilleurs résultats que l’emploi de 4 cœurs « P » Hyperthreadés. Pendant longtemps les puces mobiles de la même catégorie que Lunar Lake étaient construites avec 2 à 4 cœurs HT. Désormais avec deux blocs de 4 cœurs « P » et « E », le fonctionnement est plus efficace autant en terme de consommation que de performances. Pour le comprendre il faut mesurer l’évolution des capacités de calcul de ces cœurs.

Selon Intel, un cœur « E » de Lunar Lake 2024 est plus puissant et efficace qu’un cœur « P » de Meteor Lake de 2023 si on les exploite à une fréquence identique. Il est 20% plus rapide en performance single-thread. La nuance sera sa fréquence, puisque le cœur P de Meteor Lake est capable de monter bien plus haut en fréquence et donc de le doubler en vitesse. Du côté des nouveaux cœurs « P », les performances augmentent de 14% sur Lunar Lake par rapport à la génération précédente à fréquence égale.

Cette nouvelle efficacité est en bonne partie due aux finesses de gravures atteintes. Pour le moment Intel est toujours dépendant de TSMC qui grave ses cœurs avec son processus N3B tandis que le contrôleur est en N6B. Intel se chargeant de l’assemblage des différents cœurs et composants comme de la mémoire vive avec ses propres usines en utilisant sa technologie Foveros.

Les petits bonus d’Intel Lunar Lake

Comme d’habitude sur ces gammes, Intel est conscient que la performance n’est plus uniquement le point central de l’offre. Les PC Lunar Lake seront des machines choisies pour leur mobilité et leur capacité de calcul mais qui devront proposer de nombreux éléments supplémentaires. Par exemple, l’intégration de Thunderbolt 4 est encore facilité et Intel promet deux ports de ce type sur tous les portables exploitant ces processeurs.

Un module Wi-Fi7 et Bluetooth 5.4 est également intégré au processeur de telle sorte que le constructeur n’a plus qu’a câbler la partie antenne externe via une solution PCIe. Autre atout de cette partie sans fil intégrée, une réduction de moitié du temps de connexion aux réseaux identifiés. Un portable Lunar Lake sera connectée au réseau dès sa sortie de veille. La prise en charge du PCIe 5.0 et PCIe 4.0 en X4 permettra l’intégration de SSD NVMe très rapides. Et la marque indique également son intention de déployer le Thunderbolt Share récemment annoncé.

Pour accompagner cette sortie, Intel annonce plus de 80 designs différents et la proposition d’un kit de développement sous la forme d’un MiniPC pour ses partenaires.

Intel officialise l’architecture Lunar Lake pour PC mobiles © MiniMachines.net. 2024.