IA générative et open source : les services du gouvernement proposent leur grille de lecture

IA ouvre toi... mais pas trop

Alors que l’Open Source Initiative (OSI) a publié sa définition de l’IA open source, les services du gouvernement français publient un comparateur d’ouverture de ce genre de modèles pour aider à s’y retrouver et à choisir son modèle en fonction des différents critères d’ouverture.

L’Open Source Initiative (OSI) a récemment proposé sa version 1.0 de ce qu’est une IA open source. Elle reprend notamment quatre « libertés » inspirées de celles définies par la Free Software Foundation concernant le logiciel libre :

- Utiliser le système à n’importe quelle fin et sans avoir à demander la permission ;

- Étudier le fonctionnement du système et inspecter ses composants ;

- Modifier le système dans n’importe quel but, y compris pour en changer les résultats ;

- Partager le système pour que d’autres puissent l’utiliser, avec ou sans modifications, dans n’importe quel but.

Si cette définition permet une utilisation très large du modèle, elles ne sont pas toutes nécessaires à chaque projet. Certains peuvent même vouloir par eux-mêmes des restrictions. Les discussions politiques autour de ce terme sont actuellement assez vives en coulisse, alors que les textes juridiques comme l’AI Act s’y intéressent.

Le Pôle d’Expertise de la Régulation Numérique (PEReN) du gouvernement français explique, par exemple, que « [sa] philosophie [le] conduit en général à privilégier les modèles les plus ouverts, mais dont les conditions d’utilisation ne permettent pas les usages non éthiques ».

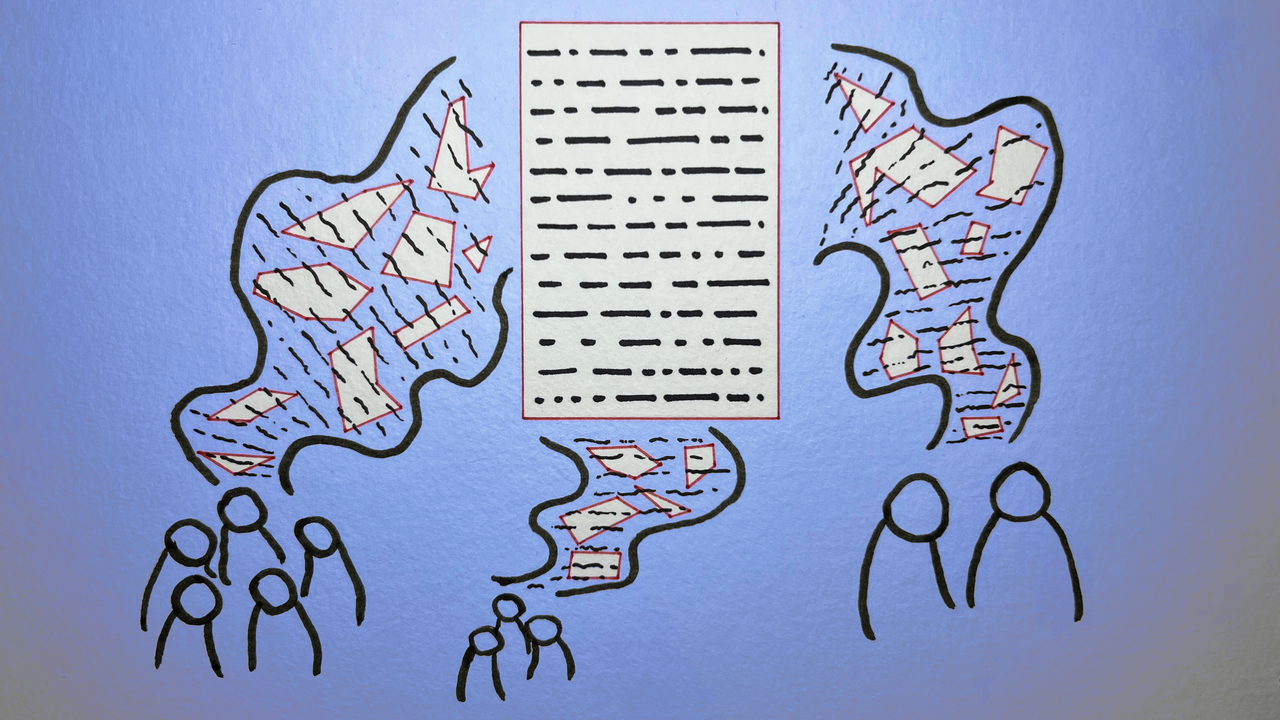

Un tableau comparatif, évolutif et coopératif

Ce service du gouvernement propose depuis mardi un comparateur de différents modèles selon les critères d’ouverture (14 modèles de générateurs de textes, 6 modèles de générateurs d’images). Quatre grandes catégories sont disponibles et on peut choisir, par exemple, si on veut (oui, non ou sans préférence) que la licence du modèle permette la redistribution, les usages commerciaux, tous les usages ou limite explicitement certains usages non-éthiques.

Le même tableau propose de filtrer selon l’accessibilité des poids, des données ou de la documentation. Le PEReN a aussi introduit dans son tableau les critères de disponibilité du code d’entrainement sous licence compatible OSI, la transparence sur l’infrastructure et le coût de l’entrainement, les articles scientifiques et ou les rapports techniques associés au modèle.

Cet outil permet à un potentiel utilisateur de choisir son modèle, mais aussi de voir que les critères d’ouverture sont multiples.

Par exemple, en un clin d’œil, il peut voir que la licence d’utilisation d’un modèle comme BLOOM, le seul du tableau dont les données sont accessibles publiquement, n’autorise pas tous les usages. À l’inverse, Mistral, pour l’utilisation de son modèle NeMo, permet de faire tout et n’importe quoi avec, mais ne fournit pas de documentation complète sur l’origine de ses données d’entrainement.

Un modèle comme Claire-7B, créé par Linagora, utilise la licence Creative Commons By-NC-SA et ne peut être utilisé à des fins commerciaux.

Le service du gouvernement français permet à tout un chacun de réutiliser « librement » cette page comme source et encourage à le contacter pour ajouter des références ou des corrections. Le tableau « se veut collaboratif et dynamique et sera amené à évoluer ».

Une attention à avoir sur la gouvernance

Le PEReN diffuse aussi un document d’éclairage sur l’Open source et l’IA [PDF]. Daté d’avril 2024 (donc avant la publication de la version 1.0 de la définition de l’OSI), il aborde les synergies possibles, du point de vue de ce service, entre open source et IA.

Il aborde notamment la diversité des gouvernances possibles dans cet écosystème et pointe les difficultés. Il prend appui sur l’exemple du système d’exploitation open source Android (via AOSP), « emblématique selon Google de l’open source » mais qui « est de facto sous le contrôle de cette entreprise, qui a pu s’assurer la maîtrise complète de l’écosystème, au point d’avoir été sanctionnée pour pratiques anticoncurrentielles par la Commission Européenne ».

« La qualité d’open source n’apparaissant pas suffisante pour prémunir de dérives, il semble nécessaire de rester particulièrement vigilant à la forme de gouvernance qui peut sous-tendre les projets open source dans le domaine de l’IAG », ajoute le PEReN.

![[Édito] De Napster à OpenAI : le copyright sacrifié sur l’autel de l’IA](https://next.ink/wp-content/uploads/2024/10/Hold-up.webp)