Doctolib, pas Doctolibre

Doctolib vient d’écoper d’une amende de 4,665 millions d’euros de l’Autorité de la concurrence pour abus de position dominante. La plateforme de rendez-vous médical annonce qu’elle fera appel et tente de justifier ses actions passées.

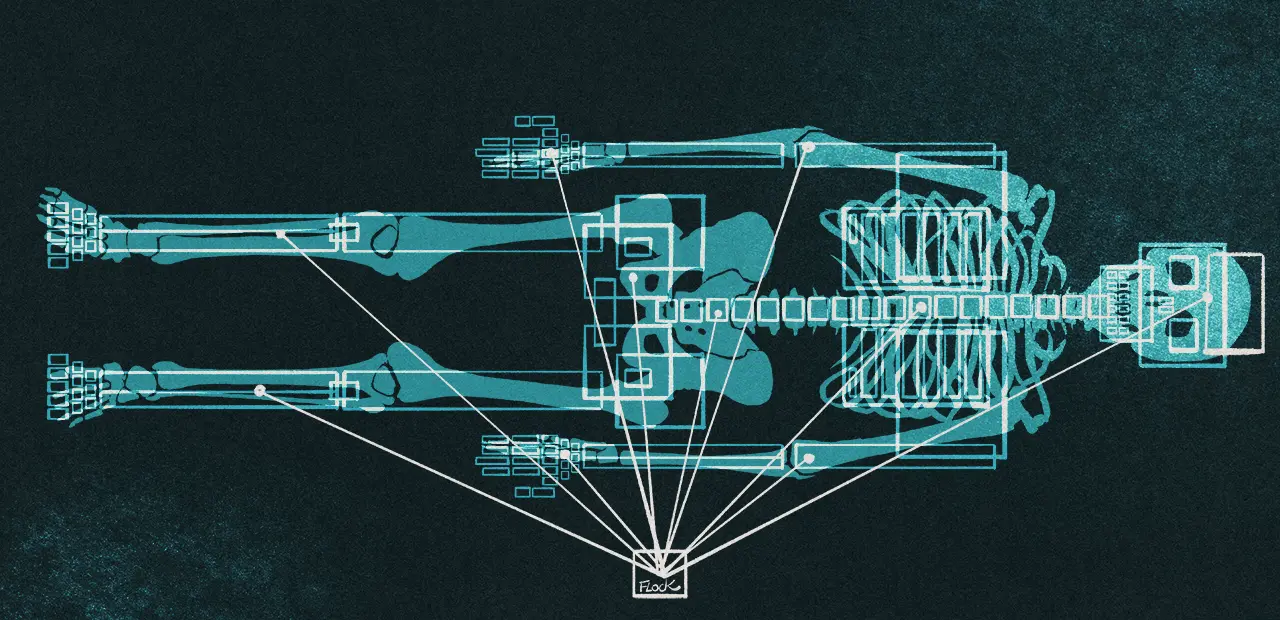

L’Autorité de la concurrence rappelle le fonctionnement des plateformes de rendez-vous médicaux et l’enjeu autour du nombre d’utilisateurs des deux côtés de l’écran (professionnels de santé et patients) : « les patients sont attirés par les plateformes proposant un large choix de professionnels de santé et ces derniers ont tendance à favoriser les plateformes utilisées par un grand nombre de patients ».

L’Autorité enquête suite à une plainte de Cegedim

Le Covid-19 a entrainé une forte augmentation de l’utilisation de ces plateformes, notamment en 2021 quand certaines se sont vu confier par le gouvernement « la gestion des rendez-vous en ligne lors de la campagne de vaccination contre la Covid-19 ». C’était notamment le cas de Doctolib, Maiia (édité par Cegedim) et KelDoc. La téléconsultation s’est aussi fortement développée pendant les confinements.

La condamnation du jour fait suite à une plainte d’un de ses concurrents en 2019 : Cegedim Santé. Ce dernier avait pour rappel été condamné en 2024 à 800 000 euros d’amende pour avoir traité des données de santé sans autorisation. Concernant Doctolib, l’enquête a pris du retard à cause de la pandémie, mais elle a entrainée une visite et une saisie dans les locaux en 2021.

Pour l’AdlC pas de doute : Doctolib « est en position dominante »

L’Autorité de la concurrence explique que « Doctolib, compte tenu de ses parts de marché et de celles, beaucoup plus faibles, de ses concurrents, de leur évolution, des barrières à l’entrée sur le marché et de l’absence de puissance d’achat compensatrice, est en position dominante sur le marché français des services de prise de rendez-vous médicaux en ligne, au moins depuis 2017 ».

Que ce soit en nombre de clients ou en chiffre d’affaires, les parts de marché de Doctolib « sont de manière constante supérieures à 50 % entre 2017 et 2022 et dépassent certaines années 90 % ». Même position dominante pour les téléconsultations, avec des parts de marché « supérieures à 40 % » aussi bien sur le nombre de clients que de téléconsultations.

Problème pour l’Autorité, « Doctolib a délibérément mis en œuvre plusieurs pratiques anticoncurrentielles ». C’est donc un abus de position dominante, une pratique condamnable et pour laquelle Doctolib écope de 4,665 millions d’euros d’amende.

Selon des documents, Doctolib voulait « verrouiller » patients et médecins

L’Autorité de la concurrence détaille ses griefs. Tout d’abord, jusqu’en septembre 2023, Doctolib imposait dans ses contrats avec les professionnels de santé « une clause d’exclusivité, combinée à une clause dite « anti-allotement » permettant à Doctolib de suspendre ou résilier le contrat ».

Dans des documents internes, des dirigeants affichaient sans détour leur volonté « [d’] être une interface obligatoire et stratégique entre le médecin et son patient afin de les verrouiller tous les deux » pour « ne laisse[r] aucun cabinet à la concurrence », rapporte l’Autorité. La formulation a le mérite de ne laisser aucune place au doute.

Doctolib mettait en avant des difficultés techniques ou opérationnelles pour exiger des professionnels de santé qu’ils résilient leur abonnement à un service concurrent pour passer sur la plateforme dominante sur le marché, un argument qui n’a visiblement pas fait mouche auprès de l’Autorité.

Alors que le service juridique de Doctolib alertait en interne sur l’illégalité d’une telle clause et insistait « vraiment fortement » pour la supprimer, le président de Doctolib aurait décidé de la maintenir selon l’Autorité, arguant « qu’il [fallait] stratégiquement la garder ». Selon l’enquête de l’AdlC, cela a eu des conséquences sur le marché : « certains opérateurs, tels que Solocal ou Qare, ont cessé de développer leur service ou ont même abandonné l’idée d’en développer ».

Sur les téléconsultations, « dès le lancement de Doctolib Téléconsultation en 2019, les contrats d’abonnement prévoyaient la souscription préalable obligatoire à Doctolib Patient », avec toutes les problématiques que nous venons d’évoquer sur la concurrence.

MonDocteur : du rachat à la « disparition en tant que concurrent »

Doctolib aurait aussi mis en place une pratique radicale pour « killer le produit » d’un concurent. En juillet 2018, la plateforme a racheté MonDocteur qui était présenté dans des documents internes comme « concurrent # 1 ».

Ces mêmes documents ne laisseraient aucune place au doute quant à la finalité du rachat : « la création de valeur […] n’est pas l’ajout de l’actif [MonDocteur] mais sa disparition en tant que concurrent ». Après le rachat, « Doctolib fonctionnera sans plus aucune concurrence en France » indiquerait un document rédigé à la demande de Doctolib, selon l’Autorité de la conccurence.

Débarrassée de son « concurrent #1 », Doctolib y voyait aussi un moyen de « réduire la pression sur les prix » et ainsi les augmenter de « 10 à 20 % », toujours selon le communiqué de l’Autorité. Cette dernière confirme que « Doctolib a bien procédé ultérieurement à plusieurs augmentations successives de ses tarifs ». Cette opération aurait permis à Doctolib d’engranger 10 000 nouveaux professionnels de santé et d’augmenter ses parts de marché, même avec les hausses de prix.

Ce rachat n’est pas passé par le contrôle des concentrations car il se situait « sous les seuils de notification qui déclenchent un examen ex ante de la part des autorités de concurrence ». Mais, comme le permet la jurisprudence depuis l’affaire Towercast, rien ne s’oppose à une analyse a posteriori d’un possible abus de position dominante. L’Autorité considère dans sa décision que ce rachat « constituait un abus de position dominante contraire aux articles 102 TFUE et L. 420 - 2 du Code de commerce ».

Deux amendes : 4 615 000 et 50 000 euros

Dans sa conclusion, l’Autorité de la concurrence affirme que ces pratiques ont bien eu pour effet « d’évincer les concurrents sur les marchés concernés ». Peu importe « les mérites propres de cette entreprise, qui ne sont pas contestés », ajoute-elle.

L’amende se décompose en deux parties. D’une part, « Doctolib a mis en œuvre, par les deux pratiques d’exclusivité et de ventes liées, une infraction, unique complexe et continue en élaborant une stratégie globale anticoncurrentielle visant à verrouiller le marché et à évincer ses concurrents ». La plateforme est sanctionnée de 4 615 000 euros.

D’autre part, le rachat de MonDocteur, « dans le seul et unique but de faire disparaitre son principal concurrent et de verrouiller le marché », est sanctionné de 50 000 euros. Pourquoi une somme qui semble relativement faible ? À cause d’une « incertitude juridique » avant 2023.

En effet, « la pratique mise en œuvre par Doctolib avait pour point de départ une date antérieure à l’arrêt Towercast, qui a clarifié la jurisprudence en réaffirmant la portée de l’arrêt Continental Can du 21 février 1973, appliquant les règles relatives aux abus de position dominante aux opérations de concentration ».

Au total, on arrive donc aux 4,665 millions d’euros. La sanction arrive quelques jours seulement après que le PDG de Doctolib (Stanislas Niox-Chateau) a expliqué que la plateforme était rentable « depuis quelques semaines ». L’Autorité « enjoint » – ou ordonne expressément – à Doctolib « de publier un résumé de la décision dans l’édition papier et sur le site Internet du journal « Le Quotidien du Médecin » ». Bien évidemment, cette décision peut faire l’objet d’un recours. Doctolib a d’ailleurs déjà annoncé son intention de faire appel.

Doctolib affirme n’être « en aucun cas en position dominante »

Pour la plateforme, cette décision « présente une lecture erronée de notre activité, et de notre secteur ». Elle affirme qu’elle n’est « en aucun cas en position dominante » et « n’équipe aujourd’hui que 30 % des soignants français (10 % en 2019 au moment de la plainte) »… sans préciser pour autant la part de marché de ses concurrents ni combien de professionnels de santé sont sur ce genre de plateforme.

MonDocteur est présenté comme « une petite start-up en 2018, qui équipait 2 % des soignants au moment du rachat », alors que Doctolib était à 10 % au même moment. La plateforme présente cette opération de croissance externe comme une « banalité absolue dans la vie d’une entreprise ».

Doctolib défend le bien-fondé du lien entre la téléconsultation et le reste du logiciel Doctolib : « la déconnecter aboutirait à des difficultés conséquentes pour le suivi des patients et l’activité quotidienne des soignants. C’est cette connexion qui permet l’accès au dossier patient, le partage d’ordonnance et la facturation ».

Enfin, toujours selon la plateforme, cette décision « s’appuie enfin sur l’existence passée d’une clause d’exclusivité il y a 11 ans, qui était présente seulement pour prévenir un mauvais usage de notre logiciel par les soignants ».

La décision complète de l’Autorité n’est pas encore disponible, mais elle sera intéressante à lire car elle permettra d’analyser le détail de la procédure, des échanges et des arguments des deux parties. Les deux parties auront de toute façon rendez-vous pour la procédure en appel.

Des « solutions fiables, sécurisées et sans engagement » ?

Dans son communiqué, Doctolib affirme que son « seul et unique objectif depuis le premier jour est de développer des solutions fiables, sécurisées et sans engagement ». Rappelons que la vie de Doctolib est loin d’être un fleuve tranquille ces dernières années.

En plus de la condamnation du jour par l’Autorité de la concurrence, elle a fait face à un « incident technique » en 2023 avec la perte de données médicales et, en 2020, au vol d’« informations administratives de 6 128 rendez-vous » en 2020.

Il y a également eu une procédure devant le Conseil d’État pour faire suspendre le partenariat entre l’État et Doctolib, sans succès. En cause, l’hébergement des données sur Amazon Web Services, avec toutes les questions que cela soulève sur la souveraineté. La question se pose aujourd’hui pour les données de santé chez Microsoft. Signalons enfin une longue enquête de Télérama en 2020 sur la sécurité, titrée « Sur Doctolib, le secret médical est soigné avec beaucoup trop de légèreté ».