mADe in China

Pour la troisième fois en trois mois, un rapport révèle de sérieux dysfonctionnements permettant à des acteurs malveillants, œuvrant en bonne partie depuis la Chine et Hong Kong, d’inonder les plateformes Meta de publicités malveillantes.

En novembre, une enquête révélait que Meta estimait, en interne, que les publicités frauduleuses dans leur ensemble pourraient représenter quelque 10 % de son chiffre d’affaires annuel, soit 16 milliards de dollars.

En décembre, une seconde enquête dévoilait qu’entre 2022 et 2024, les revenus publicitaires de Meta en Chine avaient plus que doublé, passant de 7,5 milliards de dollars à 18,4 milliards de dollars, pour atteindre près de 10 % du chiffre d’affaires global du groupe. Elle notait également que Shein et Temu étaient les deux plus gros clients publicitaires de Meta dans le monde en 2024, devant Amazon.

L’enquête révélait aussi et surtout que près d’une publicité sur cinq (19 %) sur Facebook, Instagram et consorts depuis la Chine, faisait la promotions d’arnaques, de jeux illégaux, ou encore de produits interdits.

Meta, qui aurait gagné près de 3 milliards de dollars en diffusant via ses systèmes publicitaires des contenus promouvant des arnaques, de la pornographie ou d’autres contenus illégaux, estimait aussi que l’équivalent du quart de toutes les publicités frauduleuses diffusées dans ses systèmes venait de Chine, pays qualifié sur certaines présentations de Meta de principal « pays exportateur d’escroqueries ».

Intitulée « The Scam Ad Machine » (la machine à publicités frauduleuses), une étude de cinq chercheurs du Gen Threat Labs publiée début février avance que près d’une publicité Meta sur trois (30,99 %) diffusée en Europe et contenant du texte publicitaire en anglais renvoie vers une arnaque, un lien frauduleux, une tentative d’hameçonnage ou un logiciel malveillant.

Ils ont également découvert que dix annonceurs seulement étaient responsables de plus de 56 % de toutes les publicités frauduleuses observées. Et qu’ils étaient associés à des systèmes de paiements et à des infrastructures communs liés à la Chine et à Hong Kong, laissant entendre qu’il s’agirait d’opérations organisées à l’échelle industrielle plutôt que d’acteurs malveillants isolés.

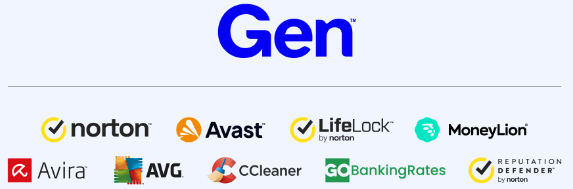

Si, comme l’auteur de ces lignes, vous n’aviez jamais entendu parler de Gen Threat Labs, sachez qu’il émane de Gen Digital, du nom du consortium formé par la fusion de Symantec avec Avast, en 2022, plus connu pour ses marques Norton, LifeLock, Avira, AVG, ReputationDefender et CCleaner.

« Nous disposons de l’un des plus grands réseaux de cybersécurité grand public au monde », résume Gen Digital sur son site, où elle avance bloquer plus de 27 700 attaques par minute en moyenne, en avoir bloqué plus de 4,5 milliards l’an passé, et revendique près de 500 millions d’utilisateurs.

Si les vendeurs d’antivirus et autres produits de (cyber)sécurité ont souvent intérêt à faire peur pour vendre leurs « solutions » censées protéger leurs utilisateurs, reste que leur expertise, et l’ampleur des menaces auxquelles ils sont confrontés, leur donne accès à des volumes de données que peu d’organismes peuvent traiter et analyser de la sorte.

Le malvertising représente aussi 41 % de toutes les cyberattaques…

Si la plupart des gens pensent que les cyberattaques commencent par des téléchargements douteux ou des liens suspects reçus par e-mail ou SMS, le rapport de Gen Threat Labs avance que le malvertising (publicité malveillante) « a connu un essor fulgurant, car il offre aux criminels ce que tout spécialiste du marketing recherche : une portée instantanée, un ciblage précis et à grande échelle ».

Les données de télémétrie de Gen montrent que le malvertising est même devenu « la plus grande menace pour les particuliers, représentant 41 % de toutes les cyberattaques », et ce, parce que le système publicitaire « est structurellement attrayant pour les criminels » et qu’il leur « permet d’obtenir des résultats de manière constante » :

« Sur Internet, les publicités sont discrètement devenues l’un des moyens les plus efficaces pour diffuser des arnaques, des tentatives d’hameçonnage et des logiciels malveillants. Aujourd’hui, les publicités dangereuses ne semblent pas suspectes ; elles ont l’air professionnelles, familières et semblent répondre exactement à vos besoins. Sur les réseaux sociaux, les mêmes moteurs d’optimisation conçus pour maximiser l’engagement et la conversion sont détournés de leur usage initial pour augmenter la probabilité que ces arnaques fassent plus de victimes. Et ce n’est pas un hasard. »

Les attaques reposent en outre sur « un ensemble d’outils d’ingénierie sociale qui s’intègre à tout ce à quoi les gens font déjà confiance et à quoi ils prêtent attention ». Les attaques de type « scam-yourself » (arnaque à soi-même) comme FakeCaptcha et ClickFix incitent par exemple les victimes à faire le travail de l’attaquant à sa place, en approuvant une invite du navigateur, en activant les notifications push, en copiant-collant des commandes ou en « vérifiant » quelque chose qui semble routinier.

Les notifications push du navigateur, en particulier, sont quant à elles devenues « un moyen fiable d’attirer les victimes, car un simple clic peut transformer une visite normale sur un site web en un flux persistant d’invites et de redirections frauduleuses ».

… et environ 30 % des escroqueries observées sur les réseaux sociaux

Les pirates s’inspirent également des techniques marketing légitimes, et surfent sur les tendances, exploitent l’urgence, des deepfakes et des thèmes d’actualité, en particulier dans le domaine des escroqueries liées à l’investissement et aux cryptomonnaies. Les chercheurs de Gen ont déjà documenté ce phénomène dans le cadre des campagnes CryptoCore, où des vidéos deepfake et des comptes piratés ont été utilisés pour promouvoir à grande échelle des investissements frauduleux.

Une autre tactique récurrente et efficace consiste à usurper l’identité d’une marque bien connue. Les cybercriminels achètent des publicités (y compris liées aux recherches) sur les principaux réseaux publicitaires afin de rediriger les internautes vers des sites de phishing où des logiciels malveillants sont installés dans le cadre du parcours de clic de la publicité, souvent sans que la victime ne se rende compte de ce qui s’est passé avant qu’il ne soit trop tard.

Le malvertising ne se limite pas aux recoins obscurs du web, soulignent les chercheurs du Gen Threat Labs : « même les sites web les plus fiables peuvent afficher à leur insu des publicités malveillantes, car celles-ci sont diffusées via des chaînes d’approvisionnement complexes et automatisées ».

La publicité malveillante est ainsi « devenue un moyen rapide et efficace d’escroquer et d’hameçonner les internautes », au point de représenter « environ 30 % des incidents d’escroquerie observés sur les réseaux sociaux », ce qui en fait l’une des menaces les plus courantes auxquelles les utilisateurs sont confrontés dans les flux d’actualités et les publicités.

« La transparence ne crée pas les abus, elle les révèle »

Évoquant des modes de « propagation incontrôlée » sous forme de « métastases », le rapport avance que « la publicité en ligne, qui était autrefois un outil permettant de mettre en relation les consommateurs avec des produits et des services, fait désormais partie intégrante de la surface d’attaque ».

Au deuxième trimestre 2025, note le Gen Threat Labs, Meta avait annoncé que le nombre d’utilisateurs actifs quotidiens sur l’ensemble de ses plateformes (Facebook, Instagram, Threads, WhatsApp et Messenger) avait atteint environ 3,48 milliards dans le monde.

Ce pourquoi les infrastructures frauduleuses ne fonctionnent pas en parallèle à ces plateformes, mais « opèrent à travers elles, tirant parti de leurs signaux de confiance, de leurs mécanismes d’engagement et de leurs capacités de ciblage pour se propager rapidement ».

Pour en mesurer l’ampleur, le Gen Threat Labs a utilisé l’API de transparence publicitaire de Meta, et précise que « ce travail existe parce que la réglementation a imposé la transparence », mais aussi qu’il aurait été impossible à effectuer dans d’autres marchés, pays et continents :

« Dans l’Union européenne et au Royaume-Uni, les exigences en matière de transparence publicitaire exposent le comportement des annonceurs d’une manière qui ne peut être reproduite ailleurs, ce qui permet de mesurer de manière indépendante la publicité frauduleuse à l’échelle industrielle. En l’absence d’une telle réglementation, les activités frauduleuses ne disparaissent pas, elles deviennent simplement plus difficiles à mesurer. La transparence ne crée pas les abus, elle les révèle. »

Les 10 principaux annonceurs représentent 56 % des publicités frauduleuses

Ils ont d’abord collecté, sur une période de 23 jours, 14,57 millions de publicités contenant un texte publicitaire en anglais, représentant 10,76 milliards d’impressions diffusées dans l’Union européenne et au Royaume-Uni.

Ils ont ensuite examiné ce vers quoi les utilisateurs étaient réellement redirigés, afin d’identifier les publicités renvoyant vers des infrastructures associées à des escroqueries en ligne, des campagnes de phishing, la distribution de logiciels malveillants et d’autres menaces visant les consommateurs.

« Les résultats étaient sans équivoque. 4,51 millions d’annonces dans notre ensemble de données ont été identifiées comme liées à des escroqueries, ce qui signifie que près d’une annonce sur trois (30,99 %) renvoyait vers une infrastructure frauduleuse. Au total, ces annonces frauduleuses ont généré 143,8 millions d’impressions dans l’UE et 304,11 millions d’impressions dans l’UE et au Royaume-Uni en moins d’un mois. »

Ils ont aussi découvert que des fraudeurs réutilisaient les mêmes infrastructures, des domaines identiques et des textes publicitaires presque identiques dans de nombreuses campagnes. « De l’extérieur, il semble que la lutte contre les publicités frauduleuses soit réactive », à mesure que nombre d’entre elles étaient bien « supprimées une par une, souvent à la suite de signalements ou d’examens ». D’après leurs observations, les campagnes malveillantes ne s’interrompent pas forcément pour autant :

« Nous ne pouvons pas voir les signaux de détection internes de Meta, nous nous gardons donc bien d’attribuer une intention. Mais le résultat observable est clair : les éléments constitutifs connus des escroqueries restent souvent utilisables longtemps après la suppression d’un cas particulier. »

Ils ont également découvert que les 10 principaux annonceurs frauduleux représentaient à eux seuls 56,1 % de toutes les publicités malveillantes, soit 2,53 millions de publicités uniques et 57,92 millions d’impressions : « Ces annonceurs ne sont pas des amateurs anonymes. Il s’agit d’opérateurs organisés et persévérants qui mènent des campagnes à l’échelle industrielle. »

À plusieurs reprises, la piste remontait jusqu’à des acteurs et infrastructures liés à la Chine et à Hong Kong, qui exploitaient des flopées de pages éphémères créées presque exclusivement pour diffuser des publicités.

Les noms de marques occidentales et les vitrines en anglais changeaient rapidement, tout comme les noms des responsables de ces publicités, mais « ce qui ne changeait pas, c’était le mécanisme : les mêmes domaines, les mêmes modèles d’URL et les mêmes comportements publicitaires réapparaissaient chez des annonceurs supposés sans lien entre eux ».

Il ne s’agit pas d’une modération imparfaite, mais d’un système défaillant

« Il ne s’agit pas d’une modération imparfaite », conclut le rapport : « il s’agit d’un système qui, dans la pratique, permet aux attaquants d’agir plus rapidement que les contraintes ne peuvent les suivre ».

Les auteurs annoncent vouloir revenir dans un prochain article de blog sur les techniques utilisées par les fraudeurs pour dissimuler des publicités malveillantes à la vue de tous, « notamment la manière dont ils manipulent les URL affichées, enchaînent les redirections, mélangent les liens malveillants avec des liens légitimes et exploitent les limites des outils de transparence eux-mêmes » :

« Car comprendre l’ampleur du problème n’est que la première étape. C’est en comprenant comment il persiste que l’on peut le résoudre. »

Meta est le deuxième plus gros acteur de la publicité numérique dans le monde avec 50 milliards de dollars de revenus sur le dernier trimestre 2025, rappelle Le Figaro, pour qui « la visibilité des escrocs reste toutefois limitée », les annonces frauduleuses n’étant apparues qu’environ 27 millions de fois dans le fil des utilisateurs français.

Le Figaro précise que cela ne représenterait qu’un peu moins de 3 % de l’ensemble des impressions enregistrées dans le pays, omettant cela dit de souligner que Gen Threat Labs a restreint son étude aux publicités contenant du texte publicitaire en anglais.

« On ne connaît pas le nombre de personnes qui ont vu ces arnaques. Un même contenu peut apparaître plusieurs fois dans le fil d’un même utilisateur », explique au Figaro Leyla Bilge, directrice du pôle arnaques de Gen Threat Labs, qui précise que « l’expérience n’est pas finie. Nous allons continuer à compiler les données publicitaires de Meta tant que nous n’observons pas une réduction du nombre d’arnaques ».

Interrogé par Le Figaro sur l’étude de Gen Threat Labs, le groupe américain affirme « lutter assidûment contre la fraude et les arnaques car ni nos utilisateurs, ni les annonceurs légitimes, ni Meta ne veulent voir ce type de contenus. Nous continuons également à soutenir les forces de l’ordre dans l’identification et l’arrestation des escrocs dans le monde entier ».