Donald Trump ordonne à toutes les administrations US de rompre avec Anthropic

Excommunicado

Donald Trump a publiquement ordonné vendredi soir à toutes les agences des États-Unis de cesser d’utiliser Claude et les produits d’intelligence artificielle d’Anthropic. La startup, dont le CEO Dario Amodei a refusé de modifier ses conditions d’utilisation pour le Pentagone, est désormais considérée comme un « fournisseur à risque pour la sécurité nationale ».

Cette fois, la rupture est consommée. Donald Trump s’en est ouvertement pris vendredi soir à Anthropic, dans un message virulent publié sur son réseau, Truth Social :

« J’ordonne à TOUTES les agences fédérales du gouvernement américain de CESSER IMMÉDIATEMENT toute utilisation de la technologie d’Anthropic. Nous n’en avons pas besoin, nous n’en voulons pas, et nous ne travaillerons plus avec eux ».

Trump menace Anthropic de conséquences civiles et pénales

Dans son message, le président développe l’idée selon laquelle c’est la façon dont Anthropic porte atteinte à la démocratie qui justifie cette mise au ban. « Les États-Unis d’Amérique ne permettront jamais à une entreprise d’extrême gauche, adepte du woke, de dicter la manière dont nos forces armées mènent et gagnent les guerres ! Cette décision revient à votre commandant en chef et aux excellents dirigeants que je nomme pour diriger nos forces armées », écrit-il encore, principalement en majuscules.

Indiquant autoriser une période de six mois pour que le ministère de la Défense conclue ses chantiers en cours, il formule une dernière menace : « Anthropic ferait mieux de se ressaisir et de se montrer coopératif pendant cette période de transition, sinon j’utiliserai tous les pouvoirs de la présidence pour les contraindre à se conformer, avec d’importantes conséquences civiles et pénales à la clé. »

Un « risque pour la sécurité nationale »

Pete Hegseth, ministre de la Défense (renommé secrétariat d’État à la Guerre dans l’administration Trump) a concrétisé une partie de cette menace vendredi soir en déclarant, sur X, qu’Anthropic devait désormais être considéré comme un « fournisseur à risque pour la sécurité nationale ».

Ce passage en liste noire n’est pas anodin : il étend l’interdiction d’utiliser les produits Anthropic à toutes les entreprises qui contractent avec l’armée, comme le précise Hegseth :

« Suite à la directive du Président enjoignant au gouvernement fédéral de cesser toute utilisation de la technologie d’Anthropic, j’ordonne au Département de la Guerre de désigner Anthropic comme une menace pour la sécurité nationale en matière de chaîne d’approvisionnement. Avec effet immédiat, aucun contractant, fournisseur ou partenaire entretenant des relations commerciales avec l’armée américaine n’est autorisé à mener une quelconque activité commerciale avec Anthropic. »

Sur X, les notes de la communauté complètent son message en précisant : « Anthropic indique clairement que les décisions militaires relèvent du gouvernement et refuse simplement d’accorder des licences pour son produit pour certains usages, conformément aux pratiques courantes de la liberté contractuelle ».

Une décision « punitive »

Dario Amodei, CEO d’Anthropic, a réagi samedi 28 février au micro de CBS. Il fait remarquer que c’est la première fois que la sanction proclamée par Hegseth s’applique à une société basée aux États-Unis, et dit voir dans cette démarche « une mesure de représailles et de punition ».

Rappelons qu’Anthropic faisait jusqu’ici partie des fournisseurs de solutions d’intelligence artificielle destinées à la défense américaine, dans le cadre d’un contrat estimé à 200 millions de dollars. L’entreprise refuse toutefois que ses outils soient utilisés dans deux scénarios, la surveillance de masse et le pilotage d’armes autonomes, ce qu’elle vient de rappeler dans un nouveau communiqué :

« Nous avons maintenu nos exceptions pour deux raisons. Premièrement, nous ne pensons pas que les modèles d’IA de pointe actuels soient suffisamment fiables pour être utilisés dans des armes entièrement autonomes. Autoriser l’utilisation des modèles actuels à cette fin mettrait en danger les combattants et les civils américains. Deuxièmement, nous estimons que la surveillance massive des citoyens américains sur le territoire national constitue une violation des droits fondamentaux. »

Cette position a valu au CEO une convocation au Pentagone, et un ultimatum de trois jours posé par Pete Hegseth le 24 février dernier. Entre temps, Amodei a publiquement réaffirmé sa volonté de coller aux conditions d’utilisation actuelles, et donc de refuser de céder aux demandes de l’administration Trump, dans un billet publié le 26 février. Ce dernier a manifestement contribué à jeter de l’huile sur le feu. « Les soldats américains ne seront jamais pris en otage par les caprices idéologiques des géants de la tech. Cette décision est irrévocable », affirme Hegseth.

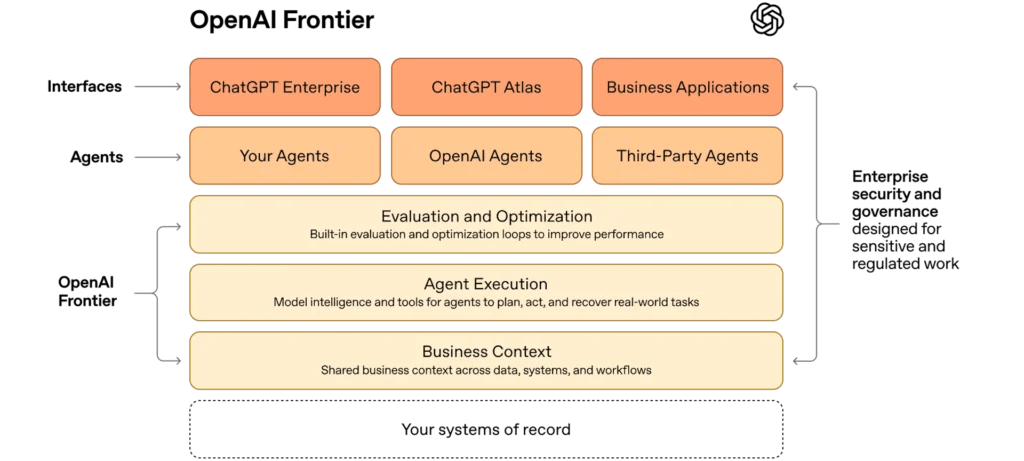

Sam Altman au rapport

Le patron d’OpenAI a quant à lui saisi la balle au bond. Trois heures seulement après l’annonce des sanctions frappant Anthropic, Sam Altman a annoncé, sur X, avoir conclu un accord avec la Défense. Ce dernier porte sur l’intégration de modèles OpenAI au sein des activités militaires, et prévoirait deux garde-fous concernant précisément les points sur lesquels achoppait Anthropic :

« Deux de nos principes de sécurité les plus importants sont l’interdiction de la surveillance de masse intérieure et la responsabilité humaine quant à l’usage de la force, y compris pour les systèmes d’armes autonomes. Le ministère de la Guerre adhère à ces principes, les intègre dans sa législation et ses politiques, et nous les avons inscrits dans notre accord », affirme Altman, qui se pose en pacificateur dans le conflit en cours :

« Nous demandons au ministère d’appliquer les mêmes conditions à toutes les entreprises spécialisées en intelligence artificielle, ce qui, selon nous, devrait être acceptable pour tous. Nous avons exprimé notre ferme volonté de voir les tensions s’apaiser et de privilégier des accords raisonnables plutôt que des actions juridiques et gouvernementales. »