Logement : pour sortir de la crise, il faut dépenser moins

43 milliards. La France dépense des fortunes pour le logement. Et pourtant, le marché locatif traverse une pénurie sans précédent, tandis que la construction atteint son plus bas niveau depuis la Seconde Guerre mondiale. Comment expliquer ce paradoxe apparent ? Et surtout, existe-t-il une autre voie ?

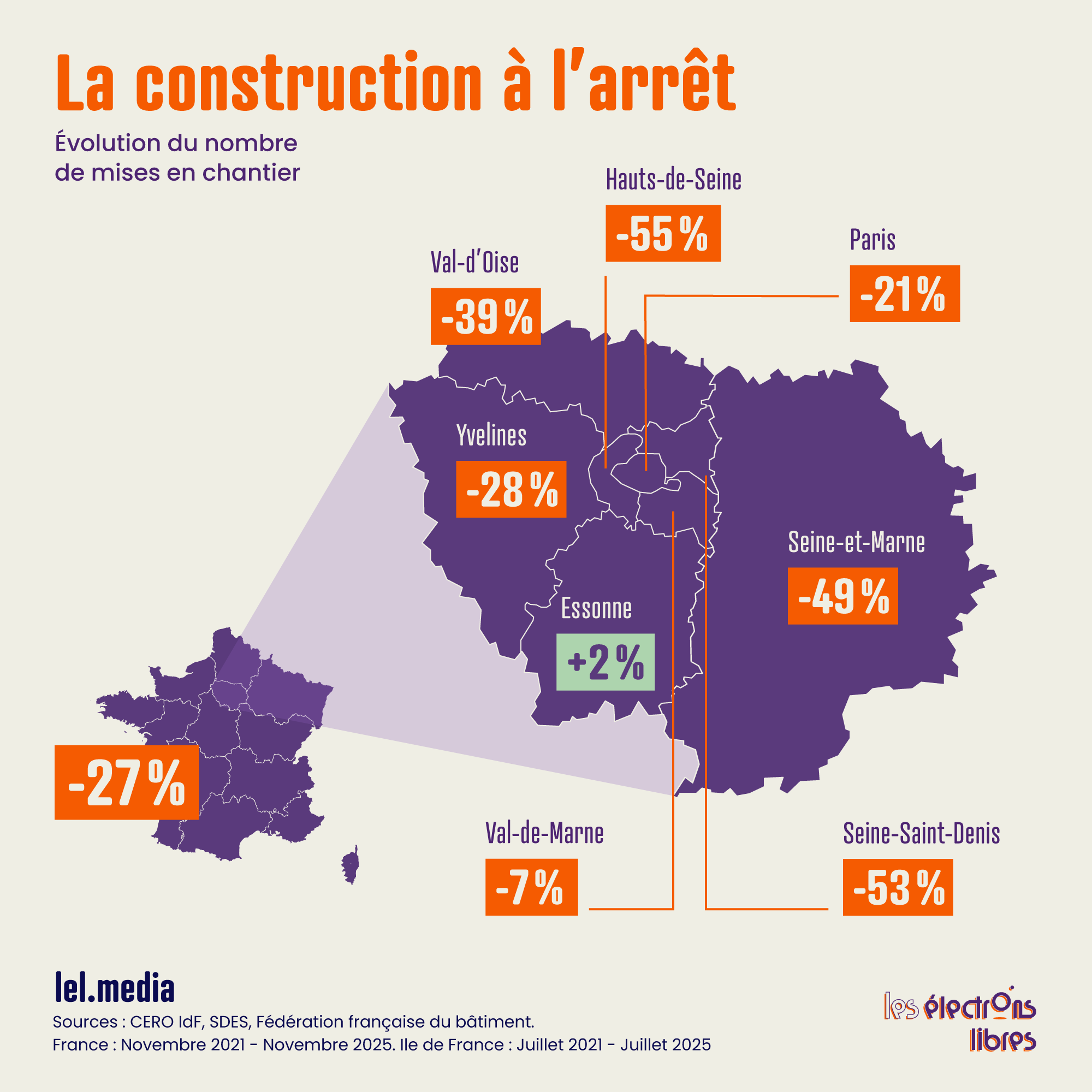

Le marché du logement français traverse une crise structurelle d’une ampleur inédite. Tous les voyants sont au rouge. L’offre locative s’évapore dans les métropoles, la concurrence pour un simple appartement devient délirante et les loyers s’envolent. Cette pénurie pousse à des extrémités sordides, certaines étudiantes en venant à troquer des « services sexuels » contre un toit. Face à ce mur, la construction est à l’arrêt. De l’Île-de-France au reste du pays, selon les statistiques nationales, les mises en chantier et les permis de construire dévissent brutalement.

Dans le même temps, les aides publiques directes au logement — APL, avantages fiscaux, subventions à la rénovation — représentent pas moins de 43,1 milliards d’euros. Soit quatre fois le budget de la justice !

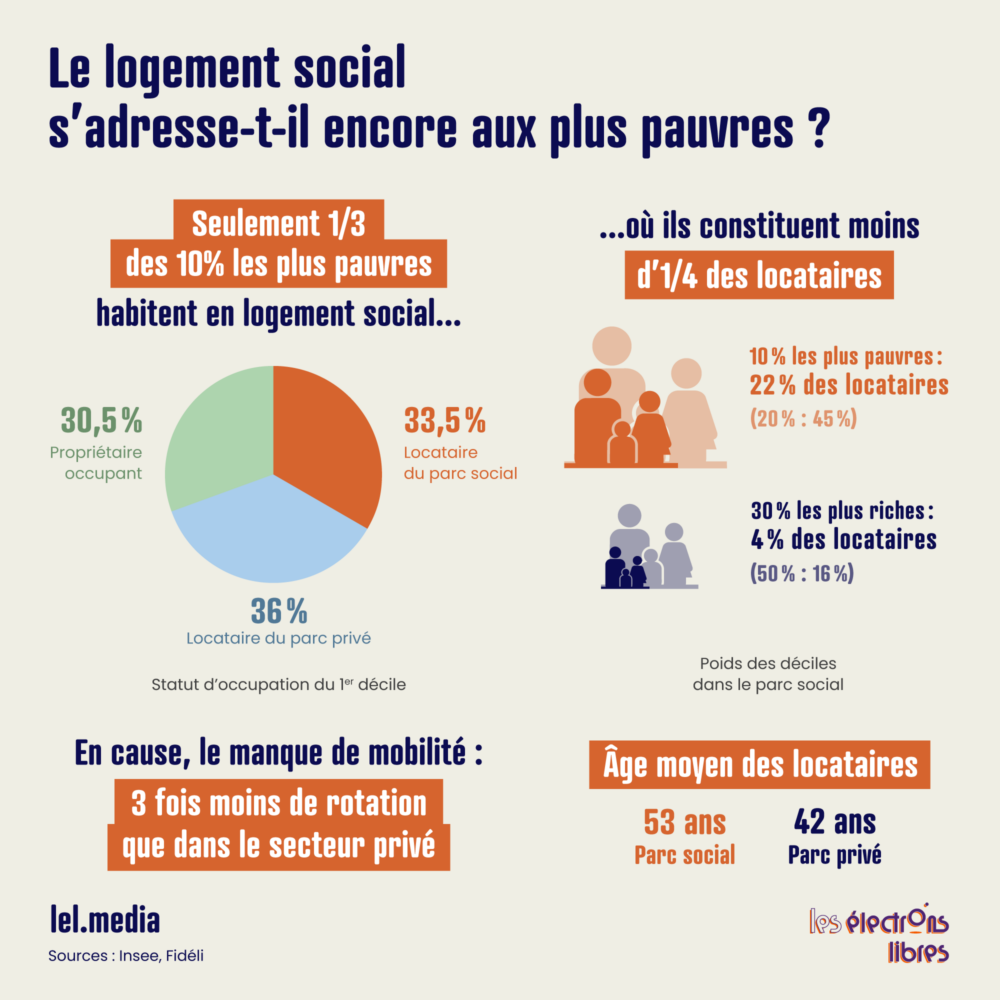

La France dispose aussi du parc social le plus vaste d’Europe : 4,5 millions de logements HLM accueillent 11 millions de personnes. 70 % de la population est théoriquement éligible ! Mais 2,8 millions de ménages attendent un logement social, tandis que 400 000 foyers dépassent les plafonds de revenus et continuent d’en profiter.

Malgré cet interventionnisme massif — ou plutôt à cause de lui —, la production actuelle est deux fois inférieure à la demande. L’Union sociale pour l’habitat estime les besoins réels à 518 000 nouveaux logements par an. Quant au parc existant, il subit le choc normatif de plein fouet. Le ministère de la Transition écologique confirme lui-même que 567 000 logements locatifs privés pourraient sortir du marché, car classés G sur l’échelle du DPE.

Face à cette terrible pénurie, la réponse de l’État français est toujours la même : davantage de réglementation, davantage de subventions, davantage de contrôles. APL, encadrement des loyers, quotas de logements sociaux, normes environnementales… Pour quel résultat ? Les Français ne sont pas mieux logés malgré des dépenses publiques bien plus élevées que chez leurs voisins.

Le secteur est asphyxié par une tempête réglementaire. Côté coûts, la norme RE2020 et l’obligation de céder 30 % des programmes à perte (loi SRU) plombent l’équilibre financier. Côté délais, la bureaucratie impose une lenteur absurde. Il faut sept ans pour construire un immeuble en France, contre quatre en Allemagne. Enfin, la fiscalité confiscatoire (jusqu’à 60 % de taxes sur les loyers, explosion de la taxe foncière) et l’instabilité juridique (DPE, encadrement) achèvent de faire fuir les investisseurs.

Construire profite à tous, donc aux plus modestes

Face à la pénurie, une objection revient systématiquement : « construire des logements neufs, c’est construire des logements de luxe pour les riches. Ça ne résout pas le problème des plus modestes. » Cette intuition est contredite par l’ensemble de la littérature économique.

Un corpus de recherches publié dans les meilleures revues académiques démontre que la construction de logements neufs — même haut de gamme — bénéficie à tous les segments du marché via deux mécanismes complémentaires. D’abord, sur le court terme, les « chaînes de vacances » : les ménages aisés qui emménagent dans le neuf libèrent leur ancien logement, permettant à d’autres d’y accéder, qui eux-mêmes libèrent le leur, et ainsi de suite. Ensuite, sur le long terme, le « filtering » (filtrage) montre qu’à mesure qu’ils vieillissent, les logements descendent naturellement vers des segments moins chers. Mais ces deux mécanismes ne fonctionnent que si l’offre neuve est suffisante. Sinon, le processus s’inverse. Les riches achètent les vieux logements, chassant les pauvres (gentrification).

Une étude d’Evan Mast, publiée dans le Journal of Urban Economics, a suivi ces chaînes sur six cycles de déménagements dans les grandes métropoles américaines. Résultat : pour chaque immeuble neuf construit dans un quartier aisé, 40 % des déménagements finaux concernent des quartiers dont le revenu moyen est inférieur à la médiane.

Plus frappant encore : une étude suédoise ayant analysé l’ensemble des bâtiments et de leurs occupants entre 1990 et 2017 révèle la rapidité stupéfiante du mécanisme. Les chercheurs ont suivi chaque cycle de déménagements : le 0 désigne les ménages aisés qui emménagent dans le neuf, le 1 ceux qui s’installent dans les logements qu’ils viennent de libérer, le 2 ceux qui prennent la place des précédents, et ainsi de suite.

Résultat : dès le premier cycle — c’est-à-dire dès que les premiers occupants du neuf libèrent leur ancien logement —, les principaux bénéficiaires sont les ménages les plus modestes (quartile de revenus le plus bas). Aux cycles 3, 4 et 5, ceux qui déménagent gagnent moins de la moitié de ce que gagnent les riches du 0. En quelques mois, le déménagement des ménages aisés se diffuse à travers toute la distribution des revenus ! La conclusion des auteurs est sans appel : « Il n’est pas nécessaire de construire des logements directement abordables pour les ménages modestes ; ils bénéficieront de toute façon de l’effet de ruissellement. »

Quid de l’impact direct sur les loyers ? Dans les quartiers populaires américains, la construction d’immeubles neufs les a fait baisser de 5 à 7 % dans un rayon de 250 mètres par rapport aux logements plus éloignés.

Une étude récente menée à Helsinki entre 2021 et 2024 apporte une confirmation supplémentaire : dans un rayon de 200 mètres, la baisse est de 1,5 % après une nouvelle construction. Plus révélateur encore, les grands projets de plus de 60 logements produisent une réduction de 6 % sur les loyers environnants — et ce, même dans un contexte de marché atone marqué par un excès d’offre hérité de la pandémie.

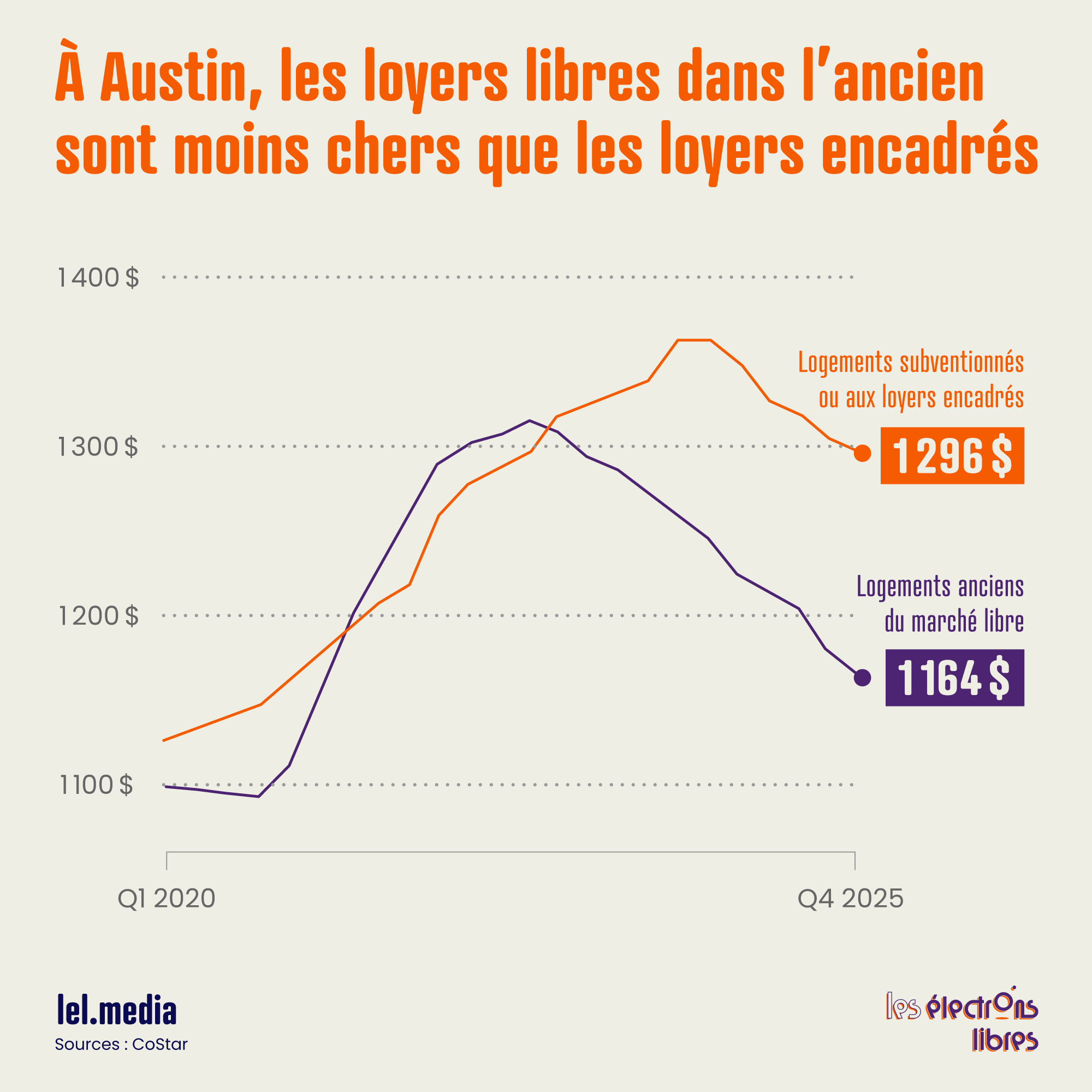

Le constat le plus fascinant vient des États-Unis. Les villes qui ont laissé les promoteurs construire massivement des appartements de luxe ont vu les loyers chuter de manière généralisée. Le phénomène est tel qu’au dernier trimestre 2025, dans de nombreuses zones à forte offre, les logements anciens du marché libre sont désormais moins chers que ceux régulés et « abordables ». Dans le domaine libre, cela conduit à produire des loyers inférieurs à ceux du secteur aidé ! Des appartements privés accessibles à tous sont ainsi devenus plus économiques que des unités pour lesquelles il faut pourtant remplir des critères de revenus, être citoyen ou résident permanent, et bien souvent gagner à une loterie d’attribution.

Sortir de l’impasse de la rareté

La France s’épuise à financer une pénurie qu’elle organise elle-même par un excès de normes et de régulations. Le choix est désormais limpide : persister à bloquer la construction par pureté idéologique, ce qui condamne les plus précaires à des loyers prohibitifs, ou accepter de bâtir massivement.

Car le coût de l’inaction est un suicide social et économique. La pénurie agit comme une taxe privée sur la croissance qui brise l’ascenseur social. Elle piège les talents dans des bassins d’emploi sinistrés et empêche les entreprises de recruter. Aujourd’hui, un salarié qui quitterait une région en crise pour un meilleur poste à Paris ou Lyon verrait son niveau de vie baisser, son gain en termes de revenu étant immédiatement capté par la rente foncière.

Mais dissipons ici un malentendu géographique. L’urgence n’est pas de densifier un Paris intra-muros déjà à la limite du possible, avec 20 000 habitants au km². Le véritable gisement foncier dort juste de l’autre côté du périphérique. En première et deuxième couronne, des communes entières, pourtant parfaitement connectées — et bientôt irriguées par le Grand Paris Express —, affichent encore des densités de village. C’est là, autour de gares RER souvent bordées de simples pavillons, que se joue la bataille. Il est aberrant d’avoir investi des milliards dans des transports lourds pour desservir des zones qui refusent d’accueillir de nouveaux habitants.

Préfère-t-on vraiment la satisfaction morale consistant à refuser de voir « les riches » obtenir de beaux appartements, quitte à condamner les classes populaires à la précarité locative ? Le paradoxe est d’autant plus absurde que la construction fait mécaniquement baisser les prix — autrement dit, elle nuit aux intérêts des propriétaires actuels, ceux-là mêmes qui bloquent les projets par peur de voir la valeur de leur patrimoine diminuer.

La solution n’est ni de gauche ni de droite. Elle est surtout universaliste au sens propre du terme, permettant d’offrir une abondance de nouveaux logements profitant à toutes les classes sociales. Imaginez une France où les jeunes actifs n’auraient plus à choisir entre un deux-pièces hors de prix et une colocation étouffante. Où les familles pourraient s’agrandir sans fuir à 50 kilomètres de leur lieu de travail. Où les entreprises trouveraient à proximité de leur activité les employés dont elles ont besoin. Où les budgets des ménages, soulagés de centaines d’euros de loyer chaque mois, se reporteraient sur la consommation, l’épargne, les loisirs. Encourager la construction ne coûte rien au contribuable. Bien au contraire, cela génère des recettes fiscales, crée des emplois, dynamise l’économie locale et libère du pouvoir d’achat pour des millions de ménages.

La question n’est pas de savoir si la France peut se permettre de créer plus de logements dans les grandes villes, mais de savoir combien de temps elle peut encore accepter de payer le prix faramineux de la rareté.

L’article Logement : pour sortir de la crise, il faut dépenser moins est apparu en premier sur Les Électrons Libres.