Scanners pédiatriques, pas d’affolement !

Faut-il avoir peur des rayons X ? Une vaste enquête nord-américaine relance le débat sur les radiations médicales, évoquant jusqu’à un cancer pédiatrique sur dix lié aux scanners. Radioscopie de conclusions à relativiser.

Il est 22 h à l’hôpital. Un enfant fiévreux et anémié arrive aux urgences, ses parents inquiets redoutent une infection grave. Pour lever le doute, les médecins réalisent un scanner en urgence. L’examen est normal, soulagement général. Mais ce soulagement a un revers invisible : une dose de rayons X administrée à l’enfant. L’utilisation de la tomodensitométrie, plus connue sous le nom de scanner, s’est répandue de manière fulgurante, passant d’environ trois millions d’examens en 1980 à soixante-deux millions au milieu des années 2000 aux États-Unis. En France, on estime qu’environ onze millions de ces examens sont réalisés chaque année. Face à cette explosion, la question des risques liés aux rayonnements refait surface. Une nouvelle étude parue dans The New England Journal of Medicine vient justement de quantifier ce « coût caché » : elle suggère qu’un cas de cancer sur dix chez l’enfant pourrait être attribuable aux radiations mentionnées. Faut-il s’inquiéter d’un chiffre aussi important ? Comment ce risque se compare-t-il aux autres sources de radiation, et que faire pour le réduire sans renoncer aux outils favorisant le diagnostic ?

Des risques réels, mais très relatifs

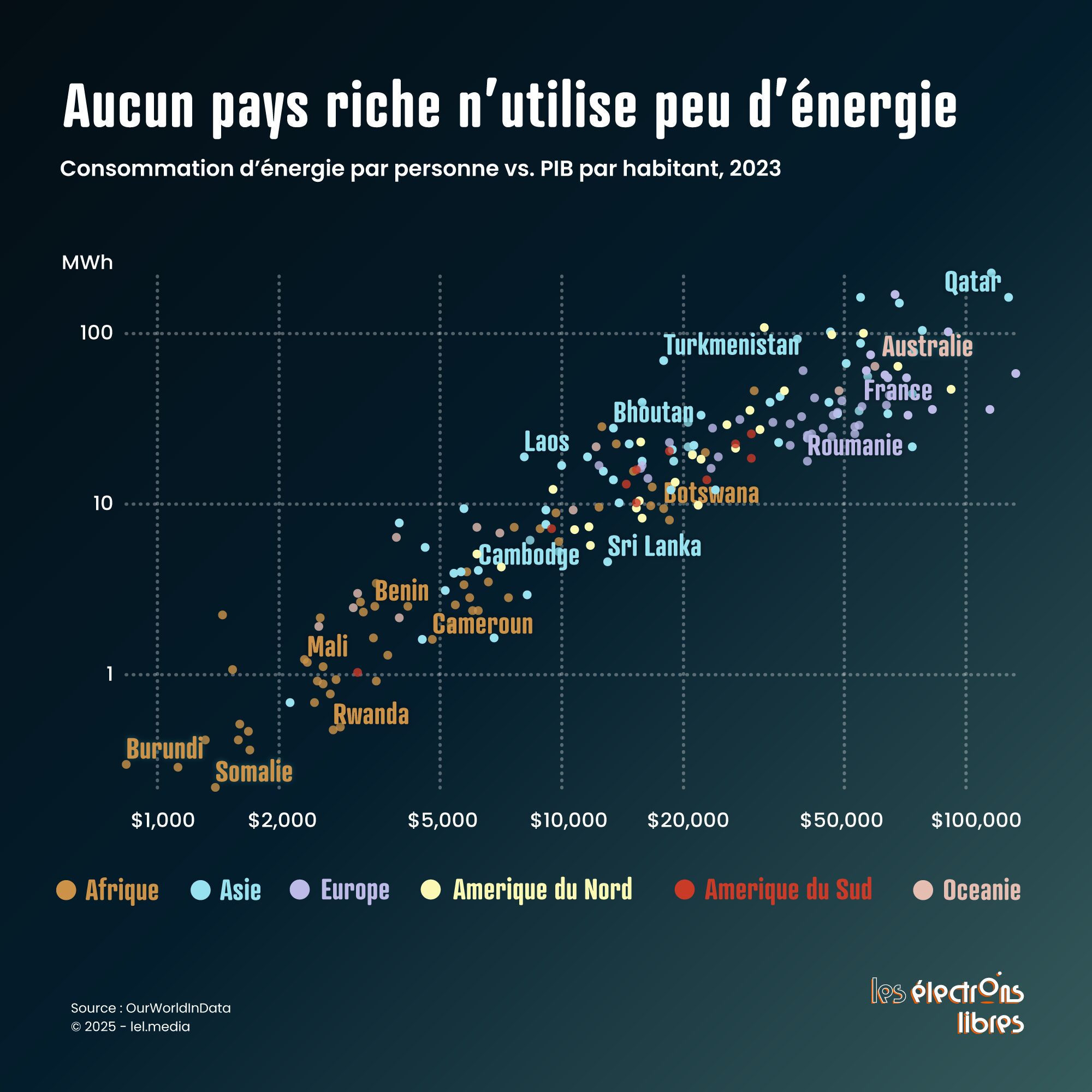

L’étude nord-américaine a suivi 3,7 millions d’enfants nés entre 1996 et 2016 sur son continent. Les chercheurs ont mesuré la dose de rayonnement reçue par la moelle osseuse, exprimée en milligrays (mGy), qui quantifient l’énergie déposée dans un tissu, et analysé la survenue de cancers hématologiques comme les leucémies et les lymphomes. Leur constat : plus la dose cumulée est élevée, plus le risque croît. Les enfants ayant reçu entre 50 et 100 mGy voyaient leur risque relatif multiplié par environ 3,6. Selon les auteurs, environ 10 % des cancers du sang observés dans cette cohorte pourraient être attribués à l’imagerie. En termes de risque absolu, cela correspondait à une incidence cumulée de 55,1 cancers hématologiques pour 10 000 enfants exposés, contre 14,3 pour 10 000 chez les non exposés, soit un excès de 40,8 cas pour 10 000 enfants (environ 0,4 % supplémentaires). Ces chiffres frappent les esprits, mais ils reflètent un passé révolu : l’étude s’arrête en 2017 et repose sur des scanners souvent installés dans les années 2000, bien plus irradiants que les machines utilisées aujourd’hui. De plus, les grandes études épidémiologiques sont sujettes à des biais, notamment de sélection : les enfants subissant plusieurs scanners sont souvent déjà atteints de maladies graves, ce qui peut exagérer statistiquement le lien entre exposition et cancer.

Ce surrisque n’est pas une réelle découverte. Une étude européenne EPI-CT a déjà analysé plus de 658 000 enfants ayant subi des scanners de la tête, avec une dose moyenne de 38 mGy au cerveau par examen. Elle a recensé 165 tumeurs cérébrales malignes et estime qu’un seul de ces examens pourrait induire, pour 10 000 enfants, un cas supplémentaire de tumeur dans les cinq à quinze années suivantes. L’ASNR indique aussi qu’en France, environ 100 000 ces scanners sont réalisés chaque année chez les enfants de 0 à 15 ans. Si les doses pouvaient être réduites de moitié, l’excès de risque attendu serait très limité (quelques cas supplémentaires sur une décennie), dans un contexte global de milliers de tumeurs survenant spontanément. De quoi relativiser et rassurer les parents inquiets face à des titres parfois sensationnalistes et sans nuance.

Comparer pour comprendre

Pour mieux situer les doses, rappelons que l’exposition naturelle aux rayonnements est en moyenne de 2 à 4 mSv 1 par an, principalement liée au radon présent dans l’air des habitations et aux roches granitiques dans certaines régions comme la Bretagne, où l’irradiation naturelle peut atteindre localement 5 à 7 mSv par an. Les rayons cosmiques contribuent aussi, surtout en altitude ou lors des vols aériens. À titre de comparaison, un vol Nice–New York de six heures représente environ 0,02 mSv, une dose proche de ce que délivre une radiographie pulmonaire. Les aliments comme les fruits de mer apportent une dose très faible et le tabac expose également, mais ces apports restent mineurs comparés au radon. Une radiographie de l’abdomen correspond à environ 0,7 mSv, soit trois à quatre mois d’irradiation naturelle. Un scanner de la tête délivre en moyenne 1,6 à 2 mSv, l’équivalent de huit à dix mois de rayonnement naturel ou 100 longs courriers. Un scanner thoracique adulte est plutôt autour de 6 mSv, soit environ deux ans et demi d’exposition naturelle. Une tomodensitométrie de l’abdomen ou de la colonne lombaire atteint 7 à 8 mSv, soit environ trois années de rayonnement naturel.

La révolution des “basses doses”

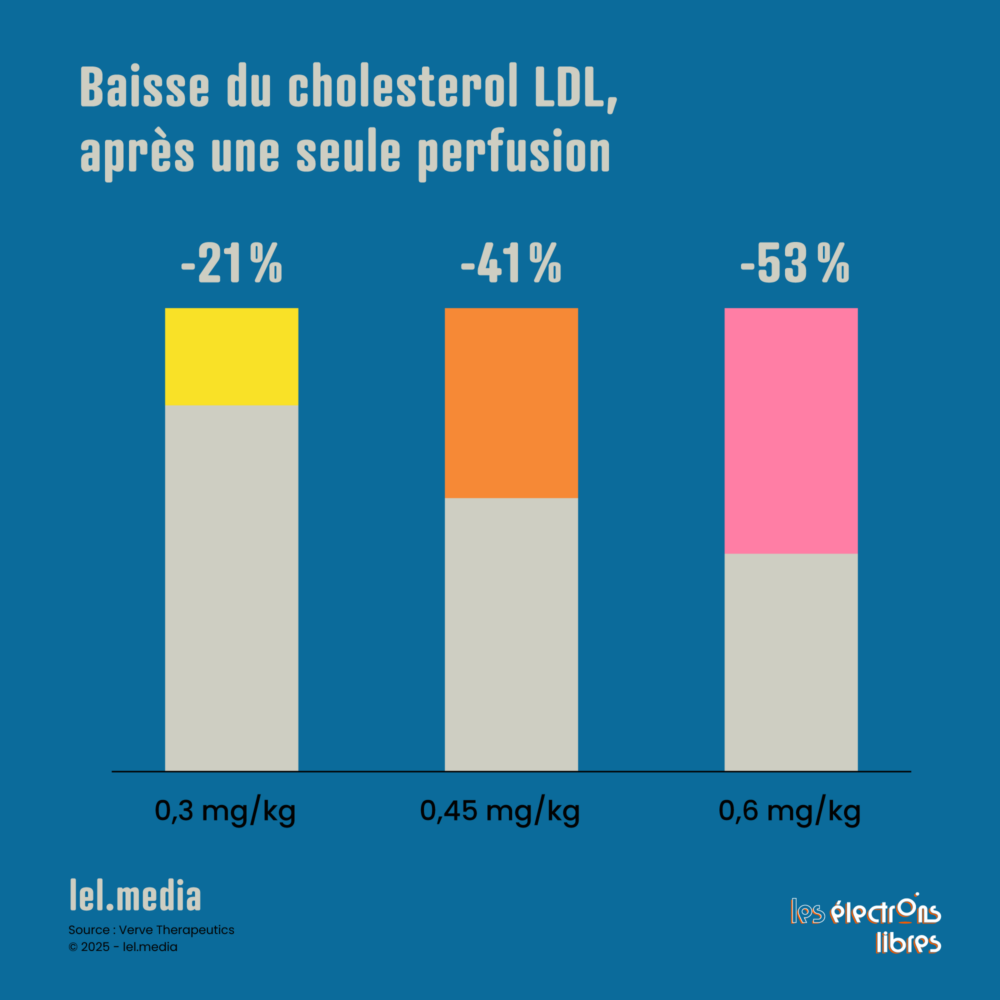

La bonne nouvelle, c’est que les machines de 2025 n’ont plus rien à voir avec celles d’il y a vingt ans. On parle désormais de scanners dits « basse dose ». Les innovations permettent de réduire l’irradiation tout en maintenant, voire en améliorant, la qualité des images. On utilise la modulation automatique du faisceau, des filtres adaptatifs, des détecteurs plus sensibles, et des reconstructions d’image assistées par algorithmes ou intelligence artificielle. Certains hôpitaux disposent déjà de scanners à comptage photonique capables de diminuer la dose d’environ 50 % tout en offrant une excellente résolution. Les autorités sanitaires françaises constatent une baisse continue des niveaux de référence diagnostiques entre 2016 et 2021 et encouragent des valeurs encore plus basses pour les enfants.

Malgré tout, pour que les progrès technologiques se traduisent concrètement par une réduction des doses, il est essentiel de renouveler régulièrement les appareils, idéalement tous les cinq à sept ans. Si la tarification des actes techniques est trop compressée, par exemple avec la réduction envisagée de 11 % dans la loi de financement de la Sécurité sociale, cela pourrait ralentir l’investissement dans du matériel moderne et compromettre l’effort de diminution des doses reçues par les patients.

Rassurer sans banaliser

En conclusion pour les parents, le message est rassurant mais demande de rester attentif : un scanner bien paramétré sur une machine récente délivre une dose faible, souvent inférieure ou comparable à l’irradiation naturelle annuelle. Lorsqu’un médecin prescrit un scanner, c’est parce qu’il attend un bénéfice diagnostique majeur. Plutôt que de craindre l’examen, il vaut mieux questionner son utilité, vérifier s’il existe une alternative sans rayons comme avec une échographie ou une IRM et s’assurer que l’appareil est moderne et adapté à l’enfant. Le principe ALARA (« As Low As Reasonably Achievable » ou aussi bas que raisonnablement possible) doit toujours guider la pratique. L’histoire de l’imagerie médicale n’est pas celle de la peur, mais celle du progrès réfléchi. Les scanners d’hier irradiaient beaucoup plus ; ceux d’aujourd’hui, bien utilisés, protègent tout en permettant de voir encore mieux.

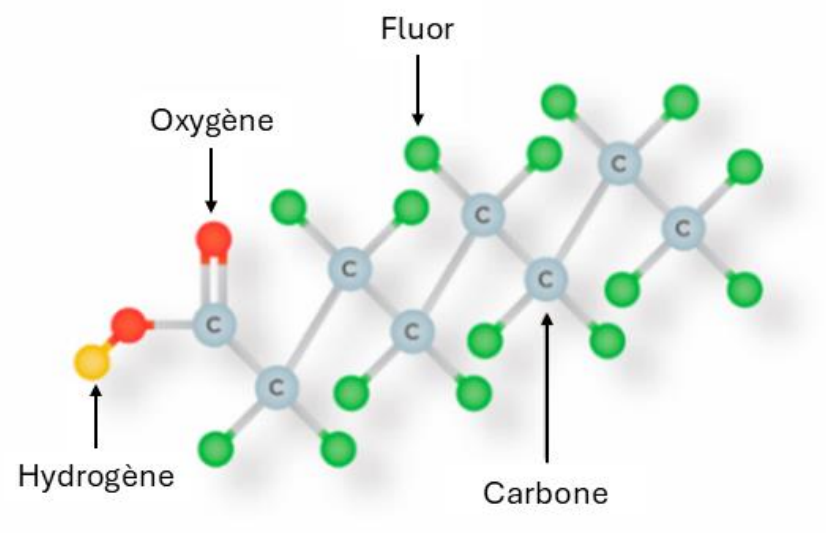

- Pour interpréter les chiffres, rappelons que le gray (mGy) mesure l’énergie déposée, tandis que le sievert (mSv) intègre la sensibilité biologique des tissus exposés. Le discours public emploie plutôt souvent les mSv pour exprimer le risque de cancer.

︎

︎

L’article Scanners pédiatriques, pas d’affolement ! est apparu en premier sur Les Électrons Libres.