Législation sur l’IA : Donald Trump tente de préempter le sujet au détriment des États US

One state beyond

Plusieurs États américains sont en pleine réflexion pour légiférer sur l’IA ou même, comme la Californie, ont déjà voté une loi sur le sujet. La semaine dernière, Donald Trump a signé un décret qui prétend créer un cadre réglementaire fédéral qui prévaudrait sur les lois des États, suivant ainsi les volontés de l’industrie du secteur. La légalité de ce texte est contestée.

Donald Trump veut reprendre la main sur le volet législatif encadrant l’industrie de l’intelligence artificielle aux États-Unis. Dans un décret publié jeudi 11 décembre, le dirigeant des États-Unis assure « garantir un cadre politique national pour l’intelligence artificielle ».

« Il s’agit d’un décret qui ordonne à certains services de votre administration de prendre des mesures décisives pour garantir que l’IA puisse fonctionner dans un cadre national unique dans ce pays, plutôt que d’être soumise à une réglementation au niveau des États qui pourrait potentiellement paralyser le secteur », a affirmé à CNN le conseiller à la Maison Blanche, Will Scharf.

Le fédéral avant l’étatique, concernant l’IA

Dans son texte, Donald Trump insiste : « Mon administration doit agir avec le Congrès pour garantir l’existence d’une norme nationale peu contraignante, et non pas 50 normes étatiques discordantes », ajoutant que « le cadre qui en résulte doit interdire les lois étatiques qui entrent en conflit avec la politique énoncée dans le présent décret. Ce cadre doit également garantir la protection des enfants, empêcher la censure, respecter les droits d’auteur et préserver les communautés ».

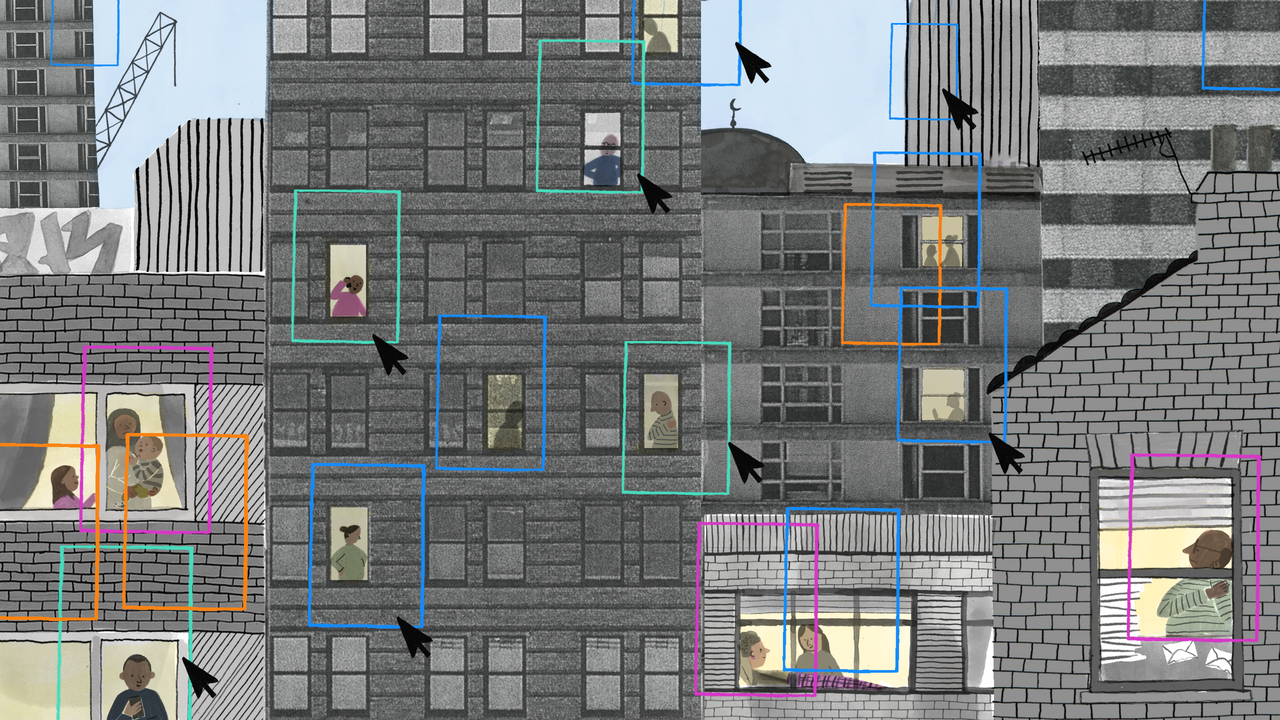

Donald Trump vise ici les velléités des cinquante États qui forment son pays de légiférer localement. De fait, comme l’explique le média public NPR, des dizaines d’États ont déjà pris des décisions pour encadrer l’industrie de l’intelligence artificielle et ses conséquences. Ainsi, comme le recense la NCSL (une association non partisane de fonctionnaires composée de législateurs en exercice), « au cours de la session législative de 2025, les 50 États, Porto Rico, les Îles Vierges et Washington, D.C., ont présenté des projets de loi sur ce sujet cette année. Trente-huit États ont adopté ou promulgué une centaine de mesures cette année ».

David Sacks, membre de la « PayPal Mafia » et financeur de Palantir devenu son conseiller IA, affirmait sur X que « cette ordonnance ne signifie pas que l’administration contestera toutes les lois des États relatives à l’IA. Loin de là ». Mais il ajoutait tout de suite après que « l’accent est mis sur les lois étatiques excessives et contraignantes ».

Une demande du secteur et notamment d’OpenAI

Les entreprises étatsuniennes du secteur ont plusieurs fois plaidé en faveur d’une harmonisation des textes au niveau fédéral. Ainsi, OpenAI a, par exemple, envoyé une lettre ouverte au gouverneur californien Gavin Newsom en août dernier pour critiquer la nouvelle loi de l’État sur l’intelligence artificielle et son encadrement. « Les États-Unis sont confrontés à un choix de plus en plus urgent en matière d’IA : établir des normes nationales claires ou risquer un patchwork de réglementations étatiques », affirmait l’entreprise dans le billet de blog qui accompagnait la lettre.

Elle y faisait aussi une comparaison hasardeuse avec l’industrie spatiale dans les années 1960 : « imaginez à quel point il aurait été difficile de remporter la course à l’espace si les industries aérospatiales et technologiques californiennes avaient été empêtrées dans des réglementations étatiques entravant l’innovation dans le domaine des transistors ».

Une contestation possible devant les tribunaux

Mais les capacités législatives du décret pris par Donald Trump pourraient être remises en question. Selon NPR, « il est presque certain que ce décret sera contesté devant les tribunaux, et les chercheurs spécialisés dans les politiques technologiques affirment que l’administration Trump ne peut pas restreindre la réglementation des États de cette manière sans que le Congrès n’adopte une loi ».

Cette volonté de préemption du sujet par le niveau fédéral est critiquée par diverses associations concernées. « Empêcher les États d’adopter leurs propres mesures de protection en matière d’IA porte atteinte à leur droit fondamental de mettre en place des garde-fous suffisants pour protéger leurs résidents », estime Julie Scelfo, l’avocate de l’association Mothers Against Media Addiction, citée par la BBC.

Avec ce décret, « Donald Trump fait tout son possible pour prendre soin de ses amis et donateurs des grandes entreprises technologiques », affirme de son côté Robert Weissman, coprésident de Public Citizen. « Cette récompense accordée aux grandes entreprises technologiques est une invitation honteuse à un comportement irresponsable de la part des plus grandes entreprises mondiales et un mépris total des principes fédéralistes que Trump et MAGA prétendent vénérer », ajoute-t-il. Pour lui, « la bonne nouvelle, c’est que ce décret présidentiel n’est que du vent. Le président ne peut pas passer outre unilatéralement la législation des États ».