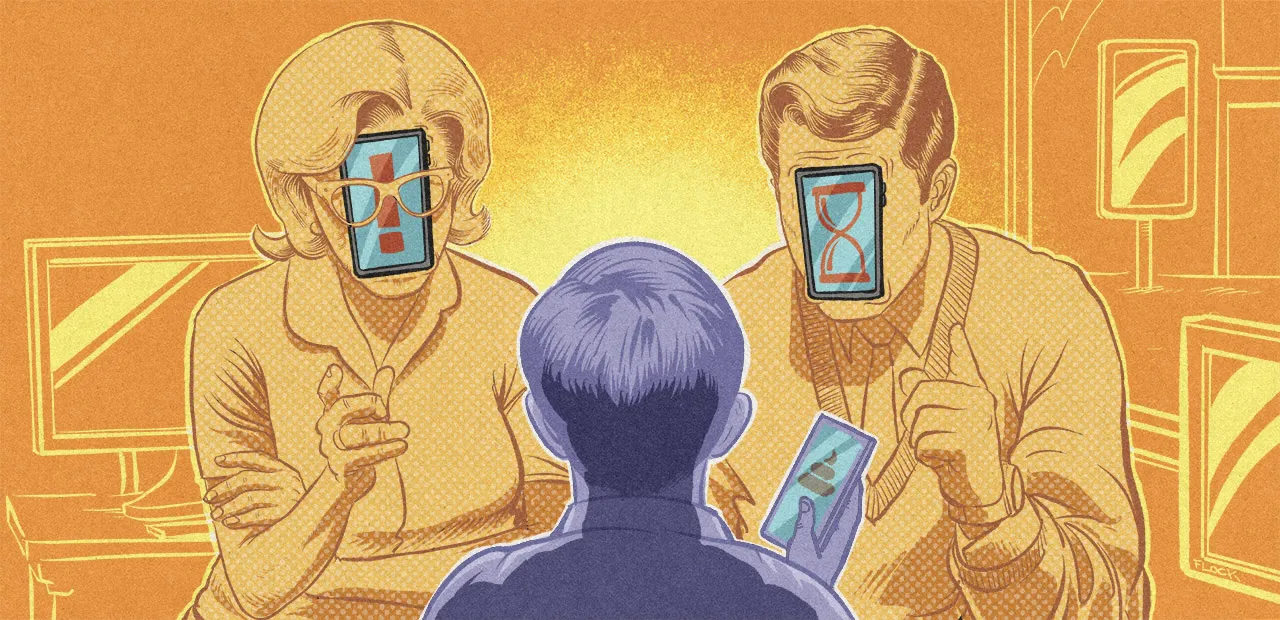

Papa, c’est quoi cette… demande à TikTok

La commission d’enquête lancée par les députés à propos des effets psychologiques de TikTok sur les mineurs a rendu son rapport ce jeudi 11 septembre. Accablant pour la plateforme chinoise, le texte propose 43 recommandations dont l’interdiction des réseaux sociaux aux moins de 15 ans ainsi qu’un couvre-feu numérique pour les 15 - 18.

« Un des pires réseaux sociaux à l’assaut de notre jeunesse », « Fabrique du mal-être », « poison lent », « engrenage mortel », le rapport présenté par la Commission d’enquête sur les effets psychologiques de TikTok sur les mineurs lancée à l’Assemblée Nationale en mars dernier fait un constat désastreux des conséquences de l’utilisation de TikTok par les mineurs.

Les députés de la Commission font 43 recommandations concernant tous les réseaux sociaux. Celles-ci vont d’une « interdiction de l’accès aux services de réseaux sociaux en ligne […] aux mineurs de moins de 15 ans » à « un couvre-feu numérique de 22 heures à 8 heures pour les réseaux sociaux dotés de systèmes de recommandation de contenus ou de dispositifs visant à capter l’attention de l’utilisateur », en passant par l’introduction « dans le droit européen une obligation de pluralisme algorithmique, inspirée du principe de pluralisme des médias ».

« Force est d’admettre qu’après l’audition de 178 personnes, 163 à l’Assemblée nationale et 15 à Bruxelles, après plus de 90 heures d’auditions menées au pas de charge en à peine 3 mois du 12 avril au 26 juin 2025, le constat est encore pire qu’escompté », déplore le président de la Commission, le député PS Arthur Delaporte, dans le tome 1 du rapport (les auditions en elles-mêmes sont présentées dans son tome 2).

Après les constats cinglants sur la plateforme de vidéos en elle-même, les députés veulent réagir de façon plus globale par rapport à l’utilisation des réseaux sociaux par les mineurs et demandent un changement de législation au niveau européen.

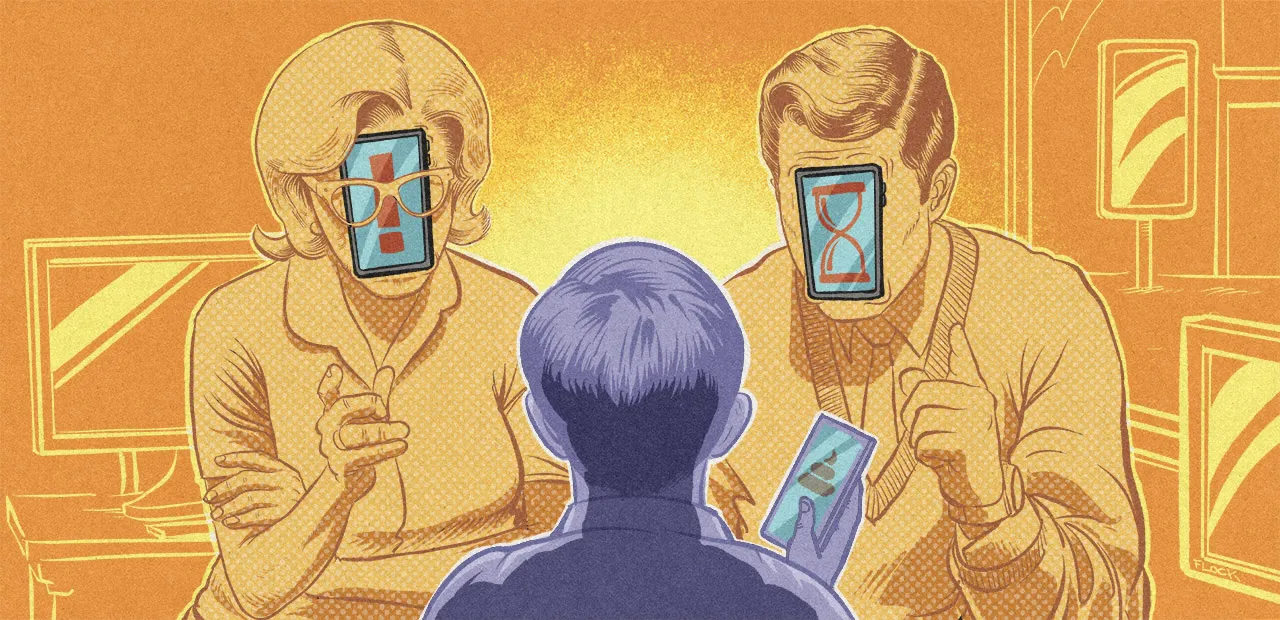

La présidente de l’Union européenne Ursula von der Leyen annonçait hier qu’un groupe d’experts devait travailler sur le sujet et formuler des propositions : c’est « aux parents, et non aux algorithmes, d’élever nos enfants », affirme-t-elle. « En attendant ou à défaut », le rapport préconise de faire évoluer la législation nationale.

Ainsi, pour la rapporteuse du texte et députée Renaissance Laure Miller, « dans le cadre de la future adoption du Digital Fairness Act, la législation sur l’équité numérique, la France doit faire entendre sa voix, qui vise à protéger les mineurs. Enfin, introduire un pluralisme algorithmique est indispensable ».

Constats accablants sur les conséquences violentes de l’utilisation de TikTok sur les mineurs

La première partie du tome 1 du rapport est consacrée à l’enquête sur TikTok en elle-même. Titrée « TikTok, un des pires réseaux sociaux à l’assaut de notre jeunesse », elle compile tous les constats sur les conséquences violentes de l’utilisation de TikTok sur les mineurs.

Désinformation sur la santé (entre autres), glorifications du suicide et de l’automutilation, « lieu d’exposition à la violence sous toutes ses formes », « haine de l’autre sans complexe », « paradis pour les antisémites », « diffusion d’une idéologie masculiniste agrémentée de violences sexistes ». La liste de reproches contre la plateforme de ByteDance est très longue.

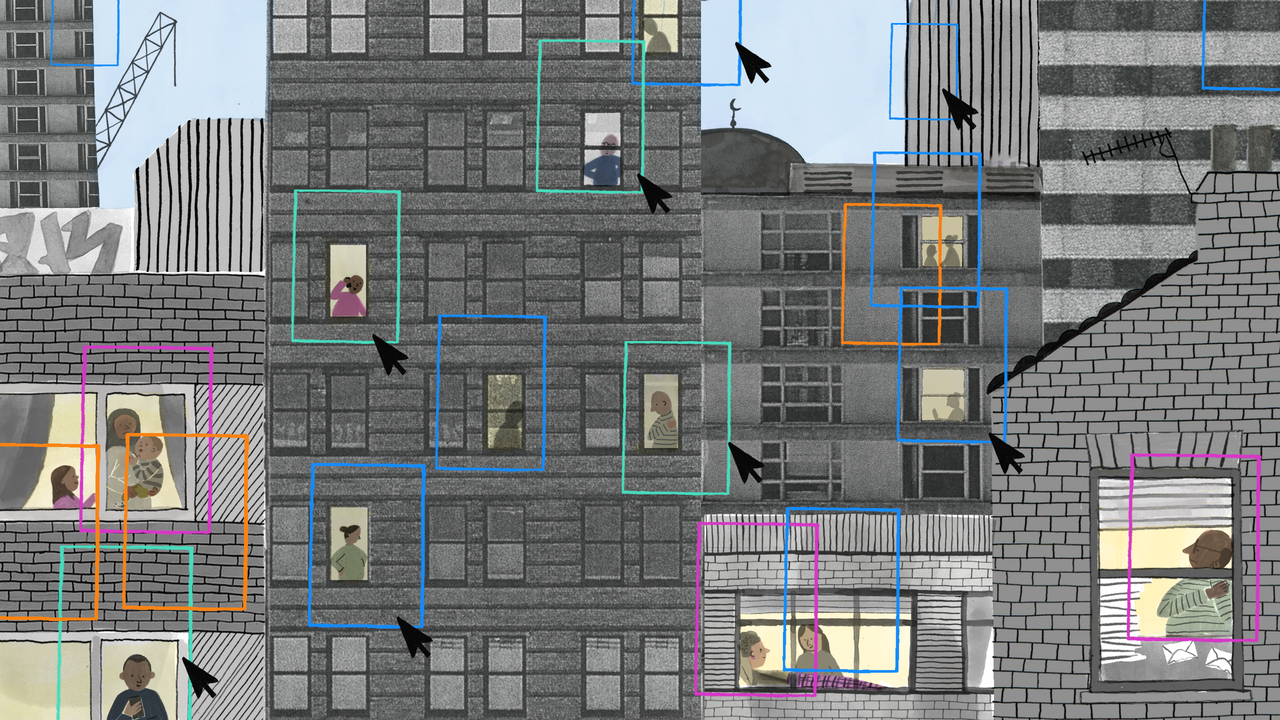

Le rapport explique aussi que « l’Office anti-cybercriminalité (OFAC), qui gère la plateforme PHAROS, note une hausse des signalements en lien avec des atteintes aux mineurs, qui représentent 7,5 % de l’ensemble des signalements en reçus entre le 1er janvier et le 22 mai 2025 contre 3,15 % l’année précédente. « Il ne s’agit pas de pédocriminalité « , précise Mme Cécile Augeraud, commissaire divisionnaire, chef‑adjoint à l’OFAC, « mais de contenus provenant de mineurs qui vont être détournés, comme des images détournées d’enfants jouant sur la plage, des contenus s’inscrivant dans des campagnes très spécifiques » ».

Les députés, dans leur rapport, affirment aussi que TikTok est « hors-la-loi s’agissant de la protection des données personnelles, et notamment de celles des utilisateurs mineurs » rappelant diverses violations du RGPD dont le transfert des données à caractère personnel des utilisateurs européens vers la Chine.

L’enquête des députés est un panorama très complet et accablant de la nocivité de la plateforme sur les jeunes.

Volonté d’imposer à tous les réseaux sociaux des mesures pour les mineurs

Dans son introduction, Arthur Delaporte explique que la commission s’est concentrée sur TikTok qui est « reconnue dans les témoignages reçus comme étant l’une des plus problématiques et la plus génératrice de dépendance et de consommation de temps d’écran par les mineurs » pour étudier plus globalement les réseaux sociaux et leur encadrement juridique notamment pour les mineurs. Il ajoute que « TikTok est donc l’objet, l’exemple, mais non un cas isolé ». Ainsi, aucune recommandation des députés ne se focalise sur la plateforme de ByteDance et les députés ne demandent pas son interdiction.

Par contre, ils listent 43 recommandations pour agir sur les réseaux sociaux et les mineurs en général. La première a déjà été plusieurs fois évoquée : l’interdiction de leur accès pour les mineurs de moins de 15 ans dans le droit de l’Union européenne. « En attendant ou à défaut », dans leur deuxième recommandation, ils proposent de l’inscrire le plus vite possible dans la législation nationale.

Le couvre-feu numérique pour les 15 - 18 ans de 22 heures à 8 heures « pour les réseaux sociaux dotés de systèmes de recommandation de contenus ou de dispositifs visant à capter l’attention de l’utilisateur » n’est que leur 32ᵉ recommandation, mais elle fait partie des mesures qui, une fois prises, seraient les plus visibles et contraignantes. Ils proposent aussi « que les paramètres adaptés à l’âge des utilisateurs mineurs ne puissent pas être désactivés ».

Les députés français proposent aussi « le renforcement des moyens financiers et humains alloués à la régulation des grandes plateformes numériques » dans l’Union européenne, mais aussi ceux de l’Arcom.

La proposition 12 du rapport veut « introduire dans le droit européen une obligation de pluralisme algorithmique, inspirée du principe de pluralisme des médias inscrit à l’article 34 de la Constitution, afin de garantir aux utilisateurs des plateformes, à travers la mise en place d’une interopérabilité des systèmes de recommandation et la possibilité de choisir entre plusieurs algorithmes, un réel pouvoir de décision sur leur expérience numérique – et en ce qui concerne les parents, sur celle de leurs enfants ».

Pour le reste, les députés veulent essentiellement renforcer les dispositifs d’information sur les effets néfastes des réseaux sociaux. Ainsi, ils proposent de « modifier les programmes d’enseignement moral et civique pour inclure une sensibilisation à l’usage raisonné des outils numériques » ou obliger que les emballages des téléphones mobiles et autres appareils « comportent un message de prévention visant à informer les consommateurs que ces produits sont déconseillés aux mineurs de moins de 13 ans ».

Après la remise du Rapport et avoir reposé sa casquette de président de la Commission, Arthur Delaporte a annoncé sur France Info avoir saisi la procureure de la République de Paris : pour lui, « le constat est sans appel : TikTok a délibérément mis en danger la santé, la vie de ses utilisateurs ». « Il me semble qu’il y a des infractions qui sont de nature pénale, de complicité active ». D’autre part, il estime que « c’est impossible quand on est dirigeants de TikTok Europe de ne pas avoir eu connaissance » de ce qu’il se passe de grave sur la plateforme et il les accuse de parjure devant la commission.