Sortie du noyau Linux 6.17

Nous vous avons entendu. Les dépêches noyaux me manquent aussi. Et entre Google qui veut les attraper tous, sudo qui n’est plus sudo sûr que ça, des pays qui sortent d’Internet, les chats qu’on veut surveiller parce qu’ils ne miaulent pas droit et le rythme de travail pour bien vivre, il est temps de revenir aux fondamentaux.

Alors sans plus attendre, quoi de neuf dans la 6.17 ? D’après Linus Torvalds lui-même, It's not exciting — ce n’est pas intéressant. Ce qui, pour lui, est un gage de qualité. Le noyau Linux 6.17 a été officiellement publié le 28 septembre, après la RC7.

Points marquants de la version

- Des corrections de sécurité et de stabilité dans la pile Bluetooth (beaucoup de bugs de type use-after-free).

- Des corrections pour les pilotes GPU et réseau (beaucoup de petites corrections).

- Prise en charge de patch à la volée (live patching) sur ARM 64 bits.

- Meilleur contrôle sur les atténuations de Spectre/x86.

- Suppression officielle de la gestion des architectures monoprocesseur, (nous y reviendrons).

- Introduction de nouveaux syscalls

file_getattr()etfile_setattr(), permettant la manipulation directe des attributs d’inodes via l’espace utilisateur. - Gestion du protocole

DualPI2pour la gestion de congestion TCP.

- lien nᵒ 1 : kernelnewbies 6.17

- lien nᵒ 2 : lwn.net : Release

- lien nᵒ 3 : lwn.net : Part 1

- lien nᵒ 4 : lwn.net : Part 2

Sommaire

- Architecture

- Systèmes de fichiers et stockage

- Réseau et connectivité

- Virtualisation

- Sécurité et cryptographie

- Changements internes et outils

- Le bilan en chiffres

- Appel à volontaires

Architecture

Résumé

- Intégration et mise à jour de la prise en charge de nombreux SoC ARM, Intel, AMD et RISC-V, dont :

- Mediatek MT6572 (Disponible sur l'Orange Pi IoT3G), Exynos2200, NVIDIA Tegra264, BeagleBone Green Eco et OrangePi 4A sur ARM.

- Nouvelles cartes STM32, Imx6, Radxa Rock 5T, FriendlyElec NanoPi M5, et Raspberry Pi RP1 PCI device.

- Ajout de nouveaux contrôleurs mémoire, avec prise en charge étendue de divers matériels industriels.

- Pilotes GPU : beaucoup de patchs pour amdgpu, i915/xe (options de debug et prise en charge de nouveaux formats colorimétrique).

- Les cartes Realtek 8851BU/8852BU sont désormais prises en compte sur le bus USB.

- Suppression officielle de la gestion des architectures monoprocesseur.

En détails

La suppression de la gestion spécifique des architectures monoprocesseur dans Linux 6.17 concerne toutes les architectures (x86, ARM, RISC-V, MIPS, etc.) où le noyau pouvait jusqu’ici être compilé et exécuté en mode UP (pour Uni Processor), opposé au mode SMP (Symmetric MultiProcessing).

Désormais, même les machines avec un seul cœur ou un seul processeur utiliseront des noyaux compilés avec gestion SMP activée. Cette modernisation simplifie le code de l’ordonnanceur (scheduler) et d’autres sous-systèmes internes du noyau, qui peuvent désormais partir du postulat que le système est au moins SMP, même si physiquement un seul cœur est présent. Cela permet un énorme nettoyage du code spécifique à cette fonctionnalité, et donc, à terme, une meilleure maintenance et une plus grande cohérence.

Néanmoins, l’impact, même très léger et invisible sur beaucoup de systèmes modernes, est réel. Le coût mémoire et processeur (dû à la gestion des locks) va augmenter légèrement, et impactera plus fortement les systèmes embarqués très contraints.

Pour les chiffres (et des explications), les tests effectués sur des systèmes monoprocesseurs avec un noyau SMP ont montré une baisse de performance de 5 %, et une augmentation de 0,3 % de la taille. Ingo Molnar, à l’initiative de ce changement, avait pointé le fait qu’il y avait, dans l’ordonnanceur actuel, 175 #ifdef dépendant de #CONFIG_SMP qui ont pu être nettoyés, et avec, plus de 1000 lignes de code supprimées.

Systèmes de fichiers et stockage

Résumé

- Btrfs : la gestion de

large foliosest ajoutée (expérimental), tout comme des options étendues pour la défragmentation et la compression intelligente des extents. Les premiers tests de performance montrent un gain de 20 % pour la création de fichiers et diverses améliorations… - Ext4 : introduction du flag

RWF_DONTCACHEpermettant la purge automatique des données du cache après écriture, ce qui améliore certains workloads orientés I/O. - NFS : prise en charge des délégations d’écriture même en mode write-only, accélérant des cas d’usage précis.

- Introduction de nouveaux syscalls file_getattr() et file_setattr(), permettant la manipulation directe des attributs d’inodes via l’espace utilisateur.

- Bcachefs : Les relations entre le développeur de ce système de fichiers (Kent Overstreet) et les autres mainteneurs du noyau se sont largement dégradés. Plusieurs mainteneurs ont fait part de leur refus de travailler à l’avenir avec Kent ce qui a conduit Linus a ne plus accepter les demandes de mises à jour (pull requests). Bcachefs est donc figé dans cette version 6.17 du noyau (et il a été complètement retiré de la future version 6.18). Un module DKMS externe est maintenant disponible pour les utilisateurs voulant continuer à utiliser ce système de fichiers.

En détails

Pour ceux qui s’intéressent aux performances et comparatifs des différents systèmes de fichiers avec le kernel, Phoronix a testé ces FS sur ce noyau 6.17. Pas de comparatif avec les précédents noyaux, mais un comparatif entre les FS.

Le flag RWF_DONTCACHE permet des opérations de lecture ou d’écriture passant par le cache mais où les données lues ou écrites ne sont pas conservées dans ce cache une fois l’opération terminée. Autrement dit, les données ne « polluent » pas le cache mémoire, ce qui est utile pour certains types d’I/O où l’on ne veut pas fatiguer le cache avec des données temporaires ou volumineuses qui ne seront pas réutilisées rapidement. Ce flag est une option pour les appels systèmes preadv2() et pwritev2()

ret = pwritev2(fd, &iov, 1, 0, RWF_DONTCACHE);En ce qui concerne les délégations d’écriture, cela permet de réduire les appels réseaux (jusqu’à 90 % dans certains cas d’usages — rapport)

Les syscalls file_getattr() et file_setattr() introduits dans Linux 6.16/6.17 permettent la manipulation directe des attributs d’inode depuis l’espace utilisateur, avec une interface plus simple et plus complète que les méthodes existantes.

Réseau et connectivité

Résumé

- Plusieurs nouveaux flags et options : SO_INQ pour AF_UNIX, extension de la gestion de MSG_MORE pour les paquets TCP volumineux et application plus stricte de la fenêtre TCP.

- Introduction de la prise en charge du protocole de congestion

DualPI2(RFC 9332) pour TCP/IP, notamment sur IPv6. - Nouveau sysctl

force_forwardingsur IPv6 permettant l’activation du mode forwarding. - Remplacement progressif de la gestion des pages réseau par des descripteurs spécialisés (

struct netmem_desc), préparant l’évolution vers les folios.

En détails

Le nouveau sysctl force_forwarding permet de forcer l’activation du forwarding indépendamment d’autres configurations potentiellement conflictuelles. (En particulier sur des profils limitatifs ou locaux)

sudo sysctl -w net.ipv6.conf.all.force_forwarding=1Petits rappels sur les folios (aussi utilisés dans ce noyau pour Btrfs). Historiquement, le noyau Linux gère la mémoire en unités appelées « pages » (généralement 4K octets). Un folio est un regroupement logique de pages (souvent pages, comme 16 pages de 4K pour former un folio de 64K). Les folios permettent une gestion mémoire plus efficace, évitent les appels redondants liés aux pages individuelles et optimisent les copies.

netmem_desc sert d’abstraction générique pour la mémoire réseau, et utilisant les folios, remplace progressivement le struct page d’origine.

L’algorithme DualPI2 est un exemple d’algorithme de gestion active de file d’attente à double file couplée (AQM) spécifié dans la RFC 9332. Il sert de composant de base AQM au sein du cadre DualQ Coupled AQM conçu pour gérer deux files d’attente : une file « Classique » pour les contrôles de congestion compatibles Reno et une file « L4S » pour les contrôles de congestion Scalables. Vous trouverez plus de détails dans l'article en lien, avec, page 6 un ensemble de tests de performance en ce qui concerne DualPI2.

Virtualisation

Résumé

- Gestion de GSO (

Generic Segmentation Offload) sur tunnel UDP dans virtio - KVM : Unicité des enregistrements irqfd

-

vhost-net: Prise en charge deVIRTIO_F_IN_ORDER -

vsock: Introduction de la prise en chargeioctl SIOCINQ -

iommu: Révision complète de la prise en charge des IRQs postées -

vfio/qat: Prise en charge des function virutelleIntel QAT 6xxx

En détails

La prise en charge des GSO permet d’améliorer les performances des machines virtuelles en réduisant la charge CPU liée au traitement des paquets UDP.

L’irqfd (interrupt request fd) a été modifié pour être globalement unique, ce qui améliore la gestion des interruptions virtuelles et évite des collisions ou conflits dans la gestion des événements d’interruption, renforçant la stabilité et sécurité des VM.

VIRTIO_F_IN_ORDER permet de gérer un ordre strict pour les paquets pour les cartes réseaux virtuelles.

vfio, qui expose des périphériques aux machines virtuelles, ajoute la prise en charge des fonctions virtuelles des accélérateurs Intel QAT 6xxx (QuickAssist Technology), améliorant ainsi les capacités de calcul cryptographique et compression dans les environnements virtualisés.

Sécurité et cryptographie

Résumé

- AppArmor peut désormais contrôler l’accès aux sockets AF_UNIX.

- Ajout de nouvelles fonctions pour SHA-1, SHA-256 et SHA-512 dans la bibliothèque crypto.

- Optimisation de CRC32c sur les CPU récents (AVX-512).

- La gestion de la profondeur de pile via GCC/Clang permet désormais l’effacement automatisé de la stack (voir SafeStack pour plus de détails).

- Meilleur contrôle sur les atténuations (mitigations) de Spectre/x86.

- Ajout d’un délai de 5 secondes sur /sys/fs/selinux/user.

- Introduction des types

neversauditdans le contexteSELinux.

En détails

Pour rappel, AF_UNIX est une classe de socket Unix permettant la communication interprocessus. Avant cet ajout, AppArmor ne gérait pas la sécurité avec ce niveau de finesse pour ces sockets. Désormais, il est possible de restreindre dans les profils AppArmor, la communication via ces sockets, entre deux applications.

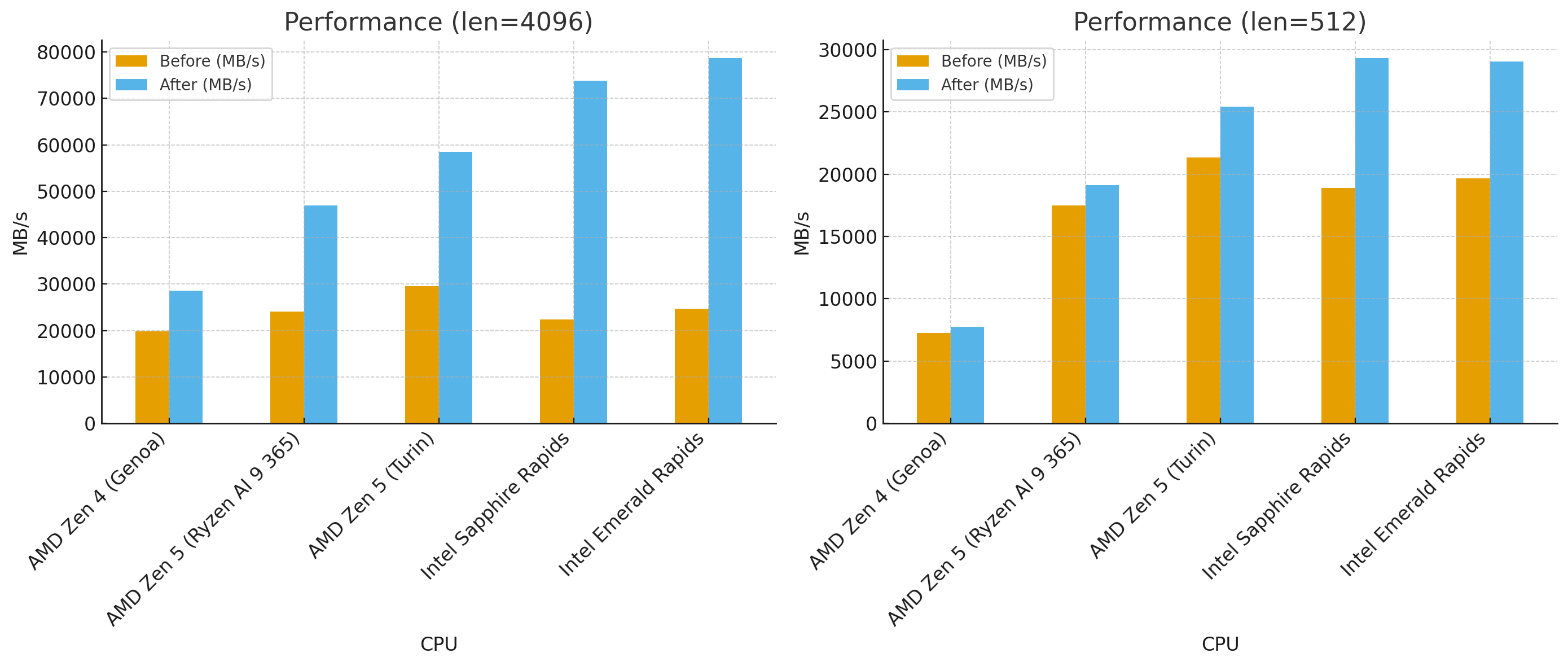

Phoronix a testé les améliorations sur CRC32C sur différentes architectures récentes, qui sont résumées dans le graphique ci-dessous.

Le noyau 6.17 introduit un meilleur contrôle sur les atténuations Spectre, grâce à un mécanisme appelé Attack Vector Controls (AVC). Le principe est simple, plutôt que d’activer ou désactiver des dizaines de protections individuelles contre les bugs d’exécution spéculative (Spectre, variantes de Meltdown, etc.), il est désormais possible de les piloter par groupes, selon la portée des attaques. Le noyau classe les atténuations en cinq catégories :

- attaques utilisateur-vers-noyau (

user-to-kernel) - attaques utilisateur-vers-utilisateur (

user-to-user) - attaques invité-vers-hôte (

guest-to-host) - attaques invité-vers-invité (

guest-to-guest) - attaques inter-threads (

cross-thread)

Avec un seul paramètre de démarrage mitigations=, il devient possible d’exclure une catégorie entière d’attaques (par exemple, désactiver toutes les protections invité-vers-invité si aucune VM non fiable n’est utilisée) et ainsi récupérer des performances.

Example: disable user-to-kernel attack mitigations, keep others at auto defaults

GRUB_CMDLINE_LINUX="... mitigations=auto,no_user_kernel ..."

Cette page liste l’ensemble des vulnérabilités CPU, et est une bonne source d’informations à ce propos.

Changements internes et outils

Résumé

- L'ordonnanceur ajoute le cgroup v2

cpu.maxpour gérer de manière plus fine l’utilisation du CPU. - Ajout de

DAMON_STATpour le monitoring. - Le montage automatique de

tracefssur/sys/kernel/debug/tracingest devenu obsolète au profit de/sys/kernel/tracing. - La migration vers des outils plus modernes : l’outil gconfig bascule sur GTK3.

- Toujours plus de

Rustavec de nouvelles abstractions pour la gestion du matériel et des propriétés firmware.

En détails

cpu.max est plus précis et global que les précédentes méthodes (utilisant cpu.cfs_quota_us et cpu.cfs_period_us ou cpu.shares), en s’appuyant sur l’extension CFS Bandwidth Control de CFS (Completely Fair Scheduler)

# Limite de 50ms d’utilisation CPU toutes les 100ms (50%)

echo "50000 100000" > /sys/fs/cgroup/cpu.maxDAMON_STAT est un module noyau statique de surveillance de l’espace d’adressage mémoire beaucoup plus léger que les précédentes méthodes

# Si DAMON_STAT est compilé en module

$ sudo modprobe damon_stat

# Activation du monitoring

$ echo 1 | sudo tee /sys/kernel/mm/damon/stat/enable

# lecture des informations

$ cat /sys/kernel/mm/damon/stat/statistics

damon_latency_avg: 23 ms

damon_bandwidth_bytes_per_sec: 5242880

damon_coldness_percentile_75: 40% # Désactivation

echo 0 | sudo tee /sys/kernel/mm/damon/stat/enableLe bilan en chiffres

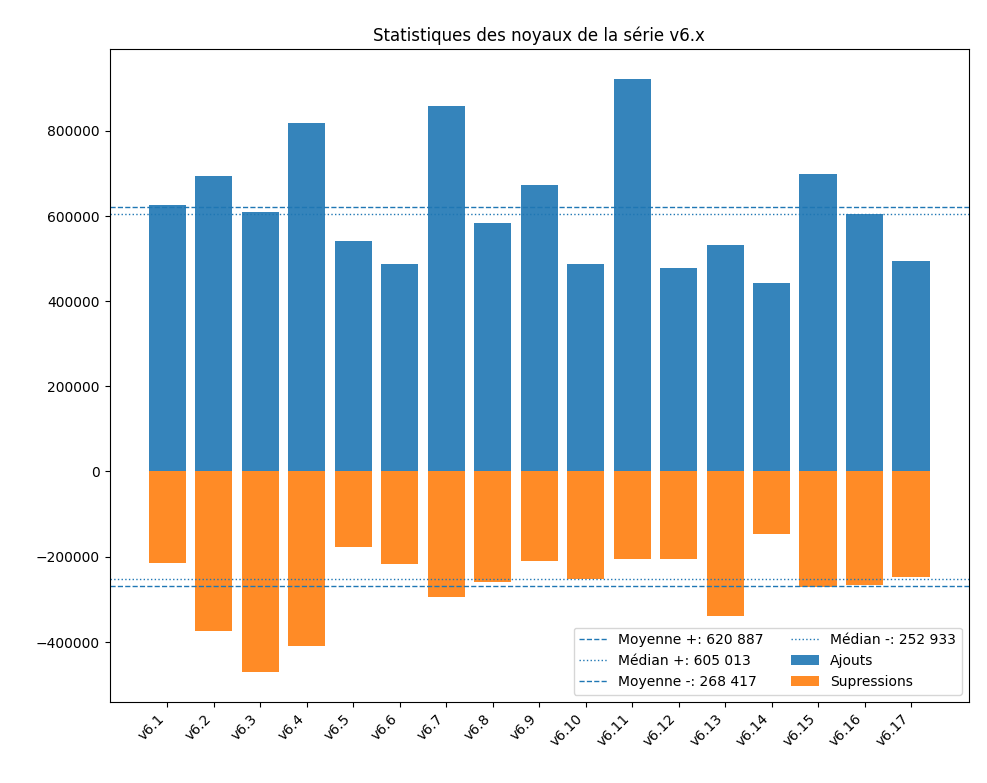

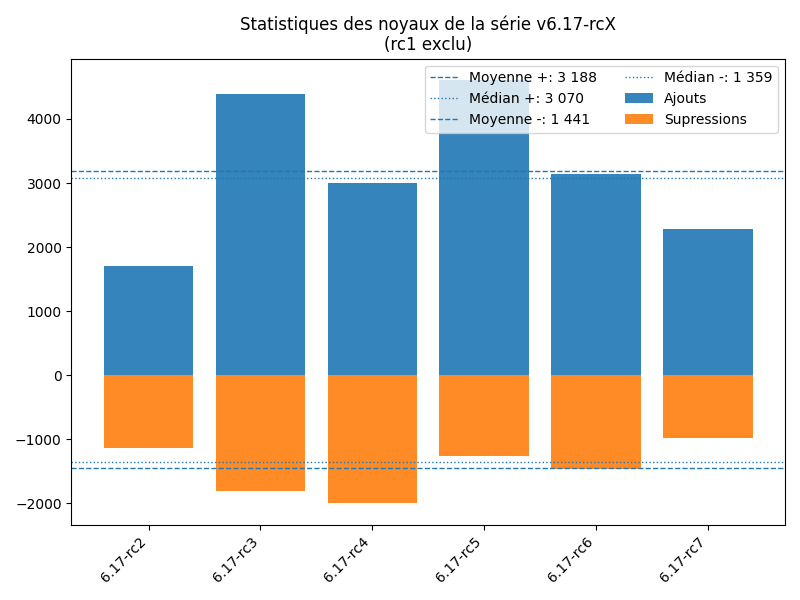

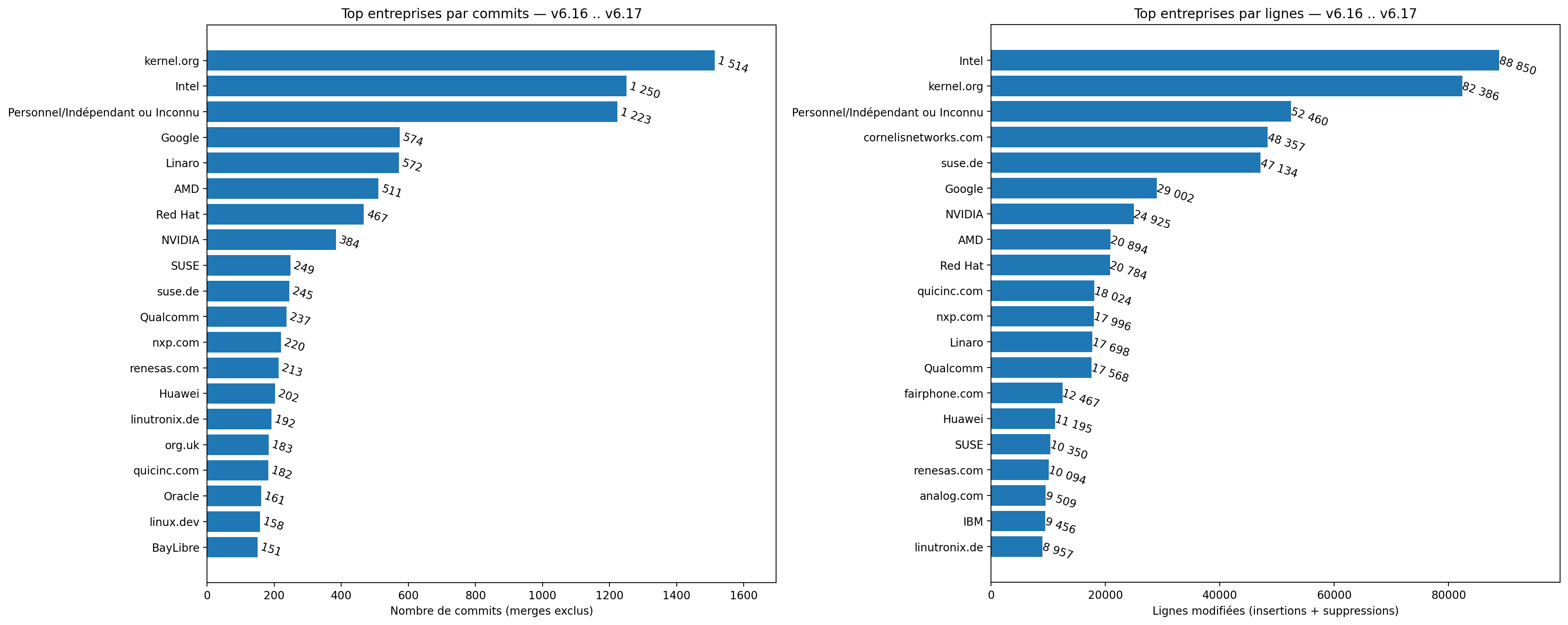

Statistiquement, ce n’est certes pas le noyau le plus calme de la série 6.x, comme nous pouvons le voir sur les graphiques ci-dessous, néanmoins, il reste plutôt tranquille, avec du nettoyage et peu d’ajouts.

Appel à volontaires

Cette dépêche est rédigée par plusieurs contributeurs dont voici la répartition :

| Mainteneur | Contributeur(s) | |

|---|---|---|

| Architecture | Aucun | |

| Développeurs | Aucun | |

| Systèmes de fichiers | Aucun | patrick_g |

| Réseau | Aucun | |

| Virtualisation | Aucun | |

| Sécurité | Aucun | |

| Changements internes | Aucun | |

| Édition générale | Aucun | BAud - vmagnin - orfenor |

Un peu de vocabulaire :

- le mainteneur d’une section de la dépêche est responsable de l’organisation et du contenu de sa partie, il s’engage également à l’être dans le temps jusqu’à ce qu’il accepte de se faire remplacer ;

- un contributeur est une personne qui a participé à la rédaction d’une partie d’une section de la dépêche, sans aucune forme d’engagement pour le futur.

Nous sommes particulièrement à la recherche de mainteneurs pour toutes les parties.

Si vous aimez ces dépêches et suivez tout ou partie de l’évolution technique du noyau, vous pouvez contribuer dans votre domaine d’expertise. C’est un travail important et très gratifiant qui permet aussi de s’améliorer. Il n’est pas nécessaire d’écrire du texte pour aider, simplement lister les commits intéressants dans une section aide déjà les rédacteurs à ne pas passer à côté des nouveautés. Essayons d’augmenter la couverture sur les modifications du noyau !

Commentaires : voir le flux Atom ouvrir dans le navigateur