Budget 2026 : de nouvelles taxes sur les géants du numérique en perspective ?

Money !

Lors des discussions sur le budget 2026 de l’État, les députés vont devoir se positionner sur plusieurs taxes ciblant les grandes entreprises du numérique. La taxe GAFAM, qui existe déjà et les vise particulièrement, pourrait passer de 3 à 15 %. Ils devront aussi discuter d’une contribution sur l’utilisation des réseaux de communication par les fournisseurs de contenus.

Venant de plusieurs horizons, des propositions pour taxer les grandes entreprises du numérique (surtout états-uniennes) vont être discutées dans l’hémicycle ces prochains jours.

Les débats s’ouvrent ce vendredi 24 octobre en séance plénière à l’Assemblée nationale pour discuter puis voter le budget de 2026. Si son examen n’est pas fini au bout de 70 jours, le gouvernement peut recourir à une adoption par ordonnances (article 47 de la Constitution).

Dans la nuit de mercredi 22 à jeudi 23 octobre, la commission des finances de l’Assemblée nationale a rejeté globalement la première partie du budget de l’État qui avait été amendée au cours de la semaine. C’est donc sur la base du projet de loi initial que les députés vont devoir s’exprimer cette fois-ci en séance plénière.

Proposition de relever la taxe GAFAM à 15 %

Mais une mesure qui ne figure pas dans cette version initiale pourrait trouver une majorité dans l’hémicycle. En effet, le taux de la taxe GAFAM, aujourd’hui à 3 %, pourrait allègrement augmenter. Elle consiste notamment à taxer les recettes générées par le ciblage publicitaire.

L’année dernière déjà, le député Corentin Le Fur (droite républicaine) avait proposé de le porter à 5 %. Dans son contre-projet qu’il a publié en septembre dernier, le PS indiquait vouloir le doubler et donc le passer de 3 à 6 %.

Mais, dans un amendement déposé par le député Renaissance, Jean-René Cazeneuve, il est proposé « de porter de 3 % à 15 % » le taux de cette taxe. Ce texte, qui a été voté lors de l’examen en commission, propose aussi d’augmenter le seuil de taxation au niveau mondial à 2 milliards d’euros au lieu des 700 millions actuellement dans la loi.

Dans son exposé, le député affirme que « la France a instauré cette taxe en 2019 pour remédier à l’inégalité fiscale entre les entreprises du numérique, souvent étrangères, et les acteurs économiques soumis à l’impôt sur le territoire. Son rendement, d’environ 700 millions d’euros en 2024, demeure sans rapport avec les profits réalisés en France par les grands groupes du secteur ».

Si le texte revient donc aujourd’hui à l’Assemblée sans les amendements votés en commission et donc sans intégrer cet amendement de Jean-René Cazeneuve, celui-ci a des chances d’être de nouveau voté dans l’hémicycle via un nouvel amendement.

Une taxe sur les fournisseurs de contenus comme Netflix ?

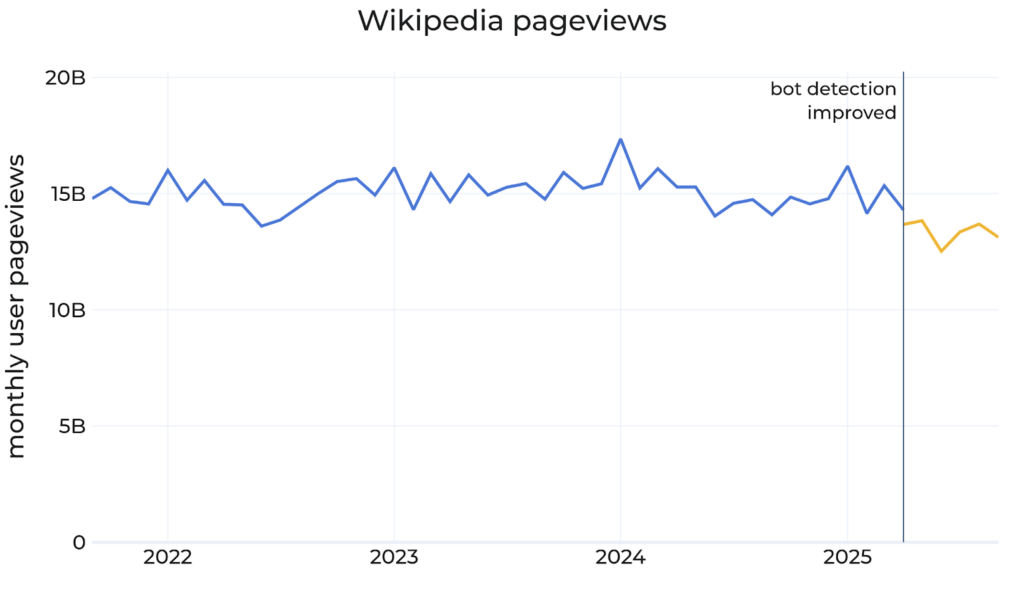

Un autre sujet de financement du numérique revient via les discussions sur le budget 2026 : le financement des réseaux télécoms par les plus importants fournisseurs de contenus. Selon le dernier bilan de l’état de l’Internet en France de l’Arcep, « cinq acteurs – Netflix, Akamai, Google, Meta et Amazon – génèrent 47 % de ce trafic », qui était de 50,8 Tb/s fin 2024 (+ 9,2 % en un an).

Le député RN Jean-Philippe Tanguy a déposé, en commission, un amendement [PDF] qui proposait la création d’une « contribution annuelle forfaitaire » de « 12 000 euros par Gb/s d’utilisation annuelle moyenne ». Cela ne concerne que « les personnes désignées contrôleurs d’accès par la Commission européenne », et « utilisant une bande passante moyenne annuelle supérieure à 1 Gb/s ». « Idée délirante, tarif délirant », rétorque Pierre Beyssac, porte-parole du Parti Pirate.

Ceci pour participer aux investissements « [des] pouvoirs publics et [des] fournisseurs d’accès à internet » pour développer et maintenir les infrastructures. Comme nous l’expliquions déjà en 2022, c’est encore le retour d’une idée récurrente. Cet amendement du député RN a été rejeté en commission, mais Jean-Philippe Tanguy l’a de nouveau présenté pendant la séance plénière. Il a peu de chance d’être intégré au texte final. Le député RN semble attaché à cette mesure, puisqu’il l’avait déjà proposé l’année dernière.

La Fédération Française des Télécoms (FFTélécoms), important lobby du secteur qui rassemble les principaux FAI mais aussi l’opérateur d’infrastructures Axione ou Verizon France par exemple, a publié récemment une tribune sur le sujet dans Les Echos. Elle y accuse les « big tech » (sont visés ici Netflix, Meta, Google et Amazon) d’être des « passagers clandestins » (terme utilisé aussi par le député RN dans l’exposé de son amendement) profitant d’« une asymétrie délétère pour l’Europe ».

Si la FFTélécoms réclame une contribution financière de leur part, elle souhaite « des accords commerciaux entre les opérateurs et les grands fournisseurs de trafic, pas une nouvelle taxe », explique-t-elle à nos confrères de Contexte. Elle souhaiterait, par contre, que l’Europe impose un cadre à ces négociations via le Digital Networks Act. Ce texte doit être présenté dans moins de deux mois à la Commission européenne. Mais il est difficile de savoir ce qu’il va contenir. Et, toujours selon Contexte, la CCIA Europe, lobby de la tech étatsunienne, veut éviter « toute tentative d’introduire des « network fees » » et y met tout son poids en organisant diverses réunions de lobbying.