Non, l’IA ne va pas détruire la planète… Au contraire !

Le travail de sape porte ses fruits. À force d’entendre répéter partout que l’intelligence artificielle serait une aberration écologique, une part croissante du public s’en convainc sans chercher plus loin. Pourtant, derrière la peur se cache un outil d’une puissance inédite, capable de réparer, d’optimiser et de verdir bien plus qu’il ne consomme.

Lui est journaliste au Monde, elle a 23 ans et sort d’un échec en fac d’anglais. Lui culpabilise du « bilan carbone » de ses expériences avec Sora ; elle refuse d’en entendre parler : « l’IA détruit la planète ». Deux réactions, deux faces d’une même pièce : celle d’un narratif anti-IA devenu réflexe, nourri d’études fragiles, de comparaisons absurdes et d’une bonne dose de catastrophisme intéressé.

Le faux procès fait à l’IA

En juin 2025, le ministère de l’Éducation nationale publiait un « Cadre d’usage de l’intelligence artificielle » recommandant de ne l’utiliser « que si aucune autre solution moins coûteuse écologiquement ne répond au besoin ». Autrement dit, l’IA est présumée coupable. Cette approche s’appuie sur la notion d’« IA frugale » définie par l’AFNOR en 2024 : une IA sommée de prouver qu’elle ne consomme pas trop avant même qu’on évalue ce qu’elle permet d’économiser. Le doute érigé en principe de précaution administratif.

En février 2025, un collectif d’associations mené par Attac, La Quadrature du Net et la Ligue des droits de l’Homme publiait dans Le Monde une tribune titrée : « L’IA contre les droits humains, sociaux et environnementaux ». On y lisait que l’IA « accélère le désastre écologique », « aggrave les injustices » et « renforce la concentration des pouvoirs », tout en prolongeant « les dynamiques néocoloniales » et en se mettant « au service de projets autoritaires et impérialistes ». Un texte sans données, mais avec un vocabulaire grandiloquent à la hauteur du désastre annoncé. La technologie y est condamnée non pour ce qu’elle fait, mais pour ce qu’elle symbolise : le capitalisme, la productivité, le progrès — bref, tout ce qu’il faut exorciser.

Les médias se sont empressés de relayer cette inquiétude morale. À l’automne, France 2 consacre un reportage à « la soif du numérique qui assèche les sols », reprenant l’idée qu’une requête ChatGPT consommerait un grand verre d’eau. Le chiffre, issu d’une étude américaine non évaluée datant de 2023, a depuis été largement réfuté : elle supposait un refroidissement 100 % à l’eau, en circuit ouvert, y ajoutait l’eau utilisée pour produire l’électricité et confondait eau prélevée (souvent restituée) et eau réellement consommée. Résultat : un calcul gonflé d’un facteur cent, voire mille. En réalité, l’impact d’une requête se mesure en dés à coudre, pas en baignoires. Pas de quoi pleurer des rivières.

Mais qu’importe, la peur se vend mieux que la nuance. La « sobriété numérique » est devenue un marché prospère, avec ses rapports, ses formations et ses audits. Une poignée de consultants s’est spécialisée dans la production de chiffres alarmistes — avant de vendre les solutions censées y remédier. Le comble de l’économie circulaire.

Les faits, rien que les faits

Derrière la panique, les ordres de grandeur racontent une toute autre histoire. En 2023, une requête sur ChatGPT consommait environ trois wattheures ; deux ans plus tard, à peine 0,3 — vingt fois moins qu’un simple expresso. Même à pleine charge, les serveurs d’OpenAI ne tirent que 35 mégawatts, l’équivalent de trois TGV lancés à pleine puissance. Le coût énergétique d’une réponse se résume donc à six minutes d’ampoule allumée.

Quant à l’entraînement des grands modèles, il reste ponctuel et amorti. GPT-4 aurait nécessité une cinquantaine de gigawattheures, soit deux jours de production d’un réacteur nucléaire. Rapporté aux milliards d’utilisations quotidiennes, l’impact unitaire devient infinitésimal.

La consommation d’eau de l’IA ? Une goutte d’eau dans l’océan. Les data centers du monde entier en consomment entre 500 et 700 milliards de litres par an, soit environ 0,015 % de l’eau utilisée sur la planète. L’intelligence artificielle représente moins de la moitié de ce total. Et la tendance est à la baisse : les systèmes de refroidissement en circuit fermé (closed loop) réduisent les prélèvements de plus de 90 %. En France, un arrêté de 2025 interdit désormais l’usage d’eau potable dans ces installations ; neuf nouveaux sites sur dix sont déjà équipés de ces circuits fermés. À Marseille, Google refroidit même ses serveurs avec de l’eau de mer recirculée, restituée sans perte.

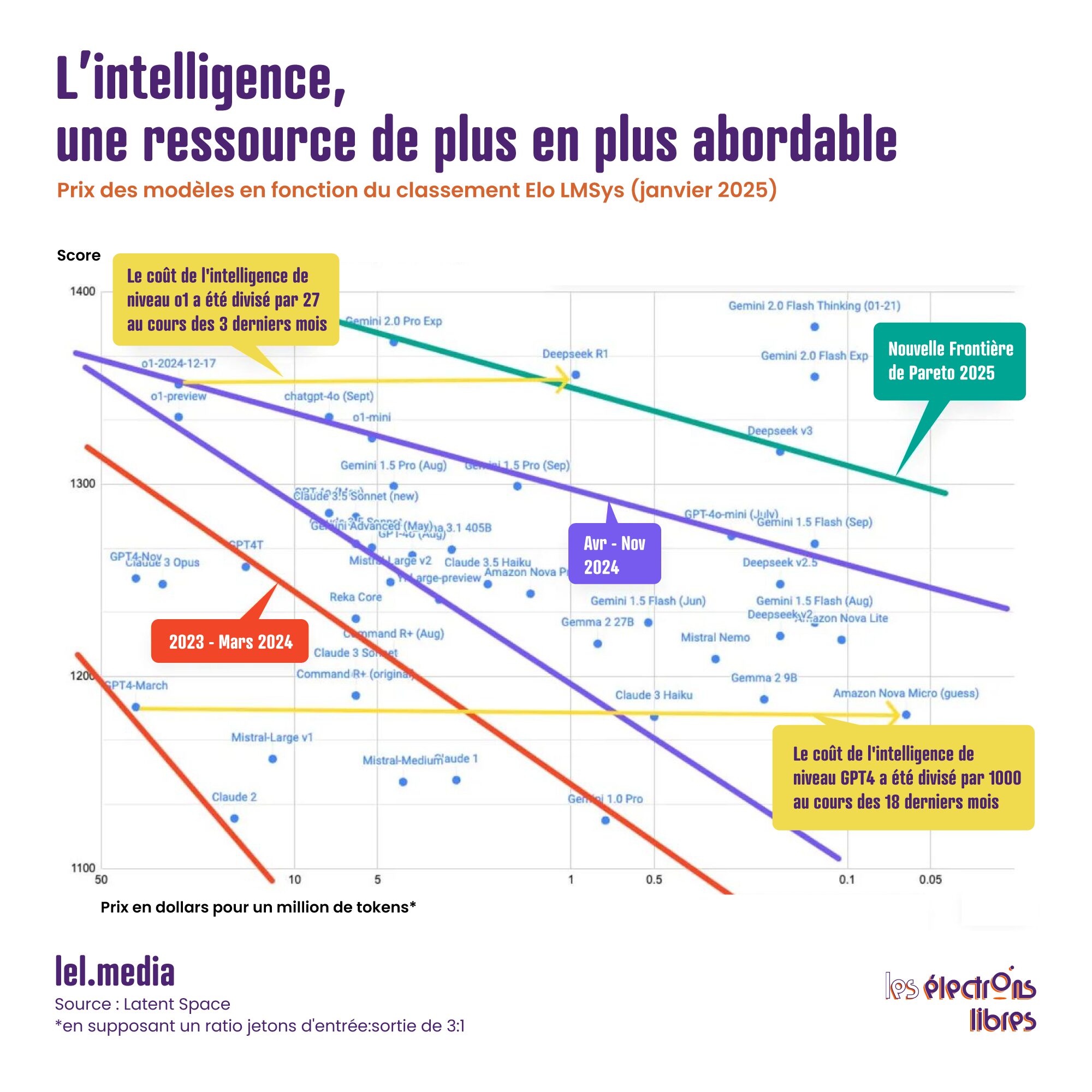

L’innovation plus sobre que la sobriété

Pendant que certains se noient encore dans un verre d’eau de 50 centilitres, les ingénieurs, eux, font fondre la consommation. Les modèles récents sont découpés en « experts » et chaque requête n’active que certains d’entre eux ; on ne réentraîne presque jamais un modèle à partir de zéro ; on compresse les réseaux neuronaux, on réduit la précision des calculs, on passe de seize bits à quatre. Dans le même temps, les puces spécialisées ont gagné un facteur mille d’efficacité en quinze ans. Nvidia, Google, Alibaba, Mistral ou DeepSeek multiplient les gains à chaque itération : une simple mise à jour logicielle suffit aujourd’hui à diviser par deux la consommation d’un processeur.

La vraie sobriété n’a donc rien de punitif, elle est technologique. L’IA devient chaque jour plus légère, plus rapide, plus proche de l’utilisateur. Certains modèles tournent déjà sur smartphone. On n’a jamais produit autant d’intelligence avec aussi peu d’énergie.

Héberger plutôt qu’interdire

Qui veut noyer son chien l’accuse de la rage. C’est précisément au moment où la technologie devient capable d’éteindre la contestation que retentissent les appels les plus vibrants à la restreindre. Le Shift Project, think tank fondé par Jean-Marc Jancovici, recommande ainsi de « limiter le déploiement de l’IA aux usages prioritaires ». Définis par qui, au fait ?

Le rapport prédit un triplement de la consommation mondiale des data centers d’ici 2030, jusqu’à 1 500 TWh. Un scénario au-delà même des prévisions les plus pessimistes de l’Agence internationale de l’énergie, qui situe la fourchette entre 700 et 1 250 TWh.

Surtout, le Shift oublie un détail essentiel : déplacer les infrastructures n’en réduit pas la consommation, il la déplace. Empêcher l’installation de data centers en France, pays dont l’électricité est décarbonée à plus de 90 %, reviendrait simplement à les voir pousser ailleurs, sur des réseaux alimentés au gaz ou au charbon. En 2024, la France a exporté 89 TWh d’électricité ; même si tous les projets annoncés voyaient le jour, les data centers n’en consommeraient que 25 TWh d’ici 2035, soit un peu plus du quart de nos exportations actuelles. Mieux encore : une demande accrue contribuerait à stabiliser le coût du mégawattheure en améliorant le taux d’utilisation du parc nucléaire.

Numériser, c’est décarboner

On reproche souvent à l’IA de trop consommer. On oublie tout ce qu’elle fait économiser. La visioconférence remplace des déplacements professionnels. Les bâtiments intelligents ajustent d’eux-mêmes leur chauffage. Les chaînes logistiques s’affinent, les réseaux se synchronisent, l’agriculture de précision limite l’irrigation et les intrants, la maintenance prédictive prévient les pannes et réduit les rebuts.

Partout où l’intelligence artificielle s’installe, les émissions reculent. Selon l’Agence internationale de l’énergie, les pays les plus numérisés voient leurs rejets de CO₂ baisser depuis près de vingt ans. En France, la consommation de papier et de carton a diminué de 26 % depuis 2000 : la dématérialisation, ici encore, a tenu ses promesses.

Chaque activité virtuelle alimentée par une électricité décarbonée est moins émettrice que son équivalent physique. Numériser les usages, c’est prolonger l’électrification de l’économie ; c’est l’étape suivante, logique et nécessaire, de la transition énergétique.

L’Europe, un continent d’avance

Et si, pour une fois, l’Europe ne ratait pas le train de la révolution technologique ? En moins de deux ans, Mistral AI est devenue la première décacorne française, valorisée à 11,7 milliards d’euros. Sa stratégie : l’open source, la transparence et l’efficacité. Hugging Face, avec ses 1,3 million de modèles hébergés et son milliard de requêtes quotidiennes, est déjà rentable. Autour d’eux, DeepL, Synthesia, Wayve, PhysicsX ou Black Forest Labs inventent une IA européenne, sobre, innovante et pragmatique. Encore faut-il que la vertu réglementaire ne se change pas en autocensure industrielle. Une fiscalité trop lourde, un soupçon systématique sur la technologie, et l’Europe reprendra sa place en tribunes.

Réconcilier progrès et planète

L’intelligence artificielle n’est pas l’ennemie du climat, c’est déjà l’un de ses meilleurs alliés. Pendant qu’on se bat sur des chiffres, elle agit. Ses usages environnementaux se déploient dans trois grands domaines : l’énergie et le climat, la biodiversité et les écosystèmes, les ressources et la production. Elle mesure, anticipe, corrige. Elle réduit les gaspillages, rationalise la consommation et nous rend collectivement plus efficaces. Chaque kilowattheure dépensé pour elle en fait économiser bien d’autres ailleurs.

La vraie question n’est pas combien l’IA consomme, mais quelle est sa balance bénéfice-risque. Refuser son essor au nom d’externalités négatives montées en épingle, c’est renoncer à toutes les externalités positives qu’elle rend possibles. Autrement dit, se priver du progrès au nom de la peur qu’il inspire. Ou, plus cyniquement encore, vouloir interdire la solution parce qu’on prospère sur le problème.

L’article Non, l’IA ne va pas détruire la planète… Au contraire ! est apparu en premier sur Les Électrons Libres.