Les super-pouvoirs des NGT enfin validés par l’UE

On dit que les NGT, (Nouvelles Techniques Génomiques) vont révolutionner l’agriculture. Encore fallait-il qu’elles obtiennent le feu vert de l’Union européenne pour exprimer leur potentiel sur le continent. C’est plus ou moins chose faite depuis le 4 décembre. Les négociateurs du Parlement européen ont conclu un accord assouplissant les règles actuelles les encadrant, pour favoriser le développement de plantes plus résistantes au changement climatique et moins dépendantes des engrais. Retour sur les super-pouvoirs des NGT.

Le principe des OGM classiques ? Transférer un gène d’un organisme vers un autre, d’où leur nom, « transgéniques ». Par exemple, le maïs BT a reçu d’une bactérie naturellement présente dans le sol la capacité de produire son propre insecticide.

Les NGT, eux, utilisent la technique qui valut à Emmanuelle Charpentier et Jennifer Doudna le prix Nobel de chimie, les « ciseaux moléculaires » CRISPR-Cas9, qui permettent de modifier précisément la génétique d’une plante sans introduire de gènes extérieurs. Ce sont donc bien des Organismes Génétiquement Modifiés, dans le sens où l’homme est intervenu, mais pas transgéniques. Ils pourraient apparaître spontanément dans la nature, avec une probabilité plus ou moins importante, par mutation ou par croisements successifs.

Pour comparer aux anciennes techniques de sélection, imaginons 3 dés. Il y a deux façons d’obtenir un triple 6 : les lancer et laisser faire le hasard, ou les poser directement sur la bonne face. On gagne beaucoup de temps, mais il faut que ce soit autorisé par les règles du jeu.

Car les fruits et les légumes que nous consommons ont tous été lentement modifiés génétiquement. Ils sont à des années-lumières de leur état d’origine naturel. Chaque grain de maïs, par exemple, était piégé à l’intérieur d’une coque non comestible aussi résistante qu’une coquille de noix et les épis étaient beaucoup plus petits. Aujourd’hui, les grains sont nus et restent longtemps sur l’épi. Dans la nature, ces caractéristiques les rendraient plus vulnérables aux oiseaux qui se nourrissent des graines. Pour notre alimentation, c’est au contraire une avancée majeure.

Les choux actuels, brocoli, kale, vert ou de Bruxelles sont tous issus d’une même plante, sur laquelle il n’y avait pas grand-chose à manger. On pourrait lister tous les légumes présents dans notre assiette : aucun n’existerait sous cette forme sans des siècles d’intervention humaine.

Pour créer un NGT, il faut avoir étudié précisément les caractéristiques d’une plante et identifier le gène intéressant. On peut alors aller plus loin et plus vite que la sélection classique, et de manière très précise. Pour agir sur 3 points essentiels : diminuer les besoins d’engrais et de pesticides, améliorer la qualité de notre alimentation et adapter les cultures au changement climatique.

Les premières applications existent et sont déjà commercialisées à travers le monde. Elles se concentrent sur la qualité nutritionnelle des aliments, comme une tomate enrichie en antioxydants ou un soja au profil d’huile plus favorable. Les possibilités semblent infinies. Des plantes que l’homme a cessé de cultiver pourraient même réapparaître sur nos étals.

Diminuer les pesticides

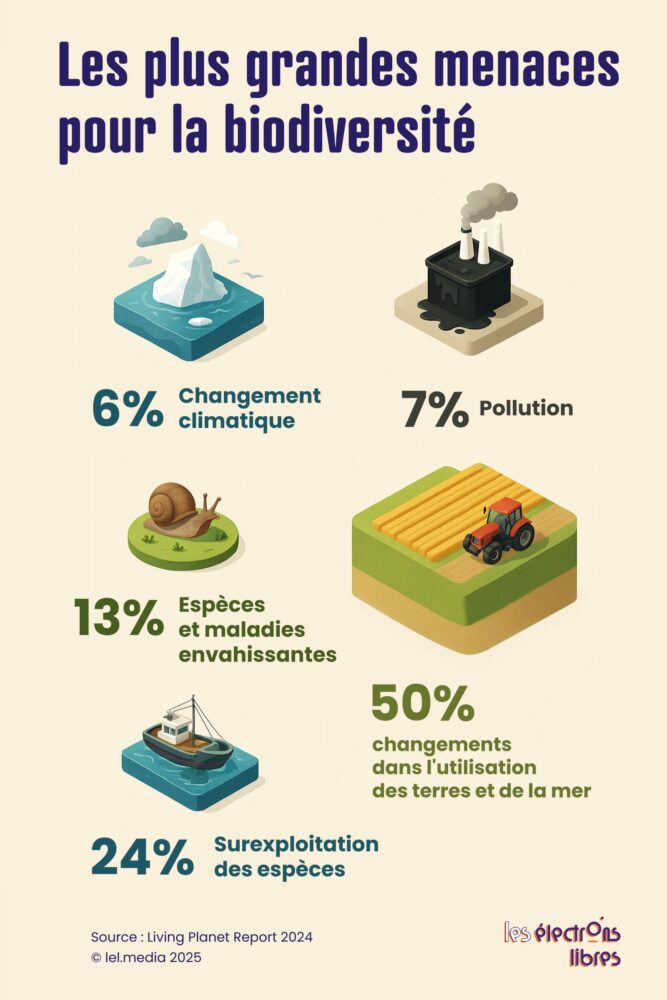

Pour les cultures les plus courantes, comme le blé, les chercheurs s’efforcent d’améliorer ou de préserver les rendements tout en réduisant l’usage d’engrais et de pesticides. Cet enjeu est crucial : avec une population mondiale croissante, augmenter la productivité par hectare est essentiel pour éviter d’empiéter sur les terres préservées pour la nature. Actuellement, la déforestation est responsable de 50 % de la perte de biodiversité, bien plus que le réchauffement climatique (6 %).

Source : Living Planet Report

Des chercheurs ont ainsi trouvé un moyen de réduire la quantité d’engrais azotés nécessaires à la culture des céréales. D’autres sont sur la bonne voie pour remplacer les pesticides. Des céréales résistantes à un virus de type « Jaunisse », transmis par les insectes, ont notamment été développées. Jusqu’en 2018, les néonicotinoïdes étaient un moyen de lutte efficace. Depuis leur interdiction, les agriculteurs doivent appliquer plusieurs insecticides. Obtenir des variétés tolérantes aux virus serait un moyen efficace de limiter leur utilisation.

D’autres NGT permettent de se passer de fongicides, ces pesticides qui empêchent le développement de champignons. Comme le blé immunisé contre l’oïdium, qui a été approuvé le 5 mai 2024 par les autorités chinoises.

Améliorer notre alimentation

Les NGT peuvent aussi nous aider à mieux nous nourrir, pour un meilleur prix, en alliant rendement et qualité nutritionnelle. Une farine blanche contenant 3 fois plus de fibres, autant qu’une farine complète, a été développée aux États-Unis. Le manque de fibres dans notre alimentation est vu comme une des causes de cancer liées à notre mode de vie. En Angleterre, des essais portent sur des blés moins riches en Acrylamide, un composant qui s’avère cancérigène en cas de surcuisson.

S’adapter au changement climatique

Un des principaux axes de développement est évidemment l’adaptation des cultures au réchauffement climatique. Éviter les pénuries ou les trop grandes augmentations de prix en cas de mauvaises récoltes est un des enjeux majeurs des prochaines décennies. Des plants de blé aux racines plus longues ont par exemple été conçus pour être plus résistants à la sécheresse. De nouvelles conditions qui amènent parfois les agriculteurs à privilégier des variétés moins productives, plus chères et consommatrices de terres. L’édition génomique permet de concilier les deux. Et de se protéger des aléas.

En Europe, un assouplissement en trompe l’œil ?

En Europe, historiquement rétive aux OGM, le Parlement Européen avait déjà voté pour assouplir les règles sur les plantes créées avec les Nouvelles Techniques Génomiques. Malheureusement, les discussions ont été interminables et soumises à nombre d’amendements ayant réduit la portée de ces progrès. Avec l’accord conclu le 4 décembre les choses avancent, même si le champ d’expression des NGT et les modalités de leur déploiement restent encore limités.

Particulièrement poussé par la présidence danoise de l’UE, cet accord vise à encore étendre les possibilités d’usage des NGT, en distinguant deux catégories. Les NGT de catégorie 1, issues de mutations sans ajout d’ADN étranger, seront traitées comme des variétés conventionnelles, tandis que les autres, de catégorie 2, resteront soumises à des autorisations plus strictes, excluant, hélas, les résistances aux herbicides ou la production d’insecticides. Les débats ont aussi porté sur la traçabilité, limitée à l’étiquetage des semences mais non des produits alimentaires finaux. Ils se sont également positionnés sur la question des brevets, non interdits, mais sous surveillance accrue pour éviter une concentration aux mains de multinationales au détriment des petits agriculteurs.

Les modifications génétiques autorisées pour les plantes de catégorie 1 sont néanmoins limitées à moins de vingt sur le génome. Au-delà de ce seuil, elles relèvent de la catégorie 2, soumise à des autorisations plus rigoureuses. Miracle de la technocratie, ces critères étant relativement dépourvus de sens. Même s’ils sont censés restreindre les nouvelles licences à une simple reproduction des mutations naturelles ou similaires, sans introduction d’ADN étranger, tout en excluant les résistances aux herbicides ou la production d’insecticides pour des raisons de durabilité.

Par ailleurs, les NGT ne pourront toujours pas être utilisées en agriculture biologique. C’est d’autant plus surprenant que l’agriculture bio utilise depuis longtemps des variétés modifiées par… des radiations ou des produits chimiques. Comme les variétés modernes d’orge de printemps, de tournesols ou de pamplemousse rose.

Et en France ?

Une fois validé par le Parlement européen et le Conseil de l’Union, l’accord provisoire sur les NGT n’exige pas obligatoirement un vote spécifique à l’Assemblée nationale pour son intégration au droit français. Cet acte relève de la procédure législative ordinaire de l’UE (codécision), qui produit un règlement directement applicable dans tous les États membres sans transposition nationale requise. Notre droit s’aligne automatiquement dès l’entrée en vigueur du règlement, prévu après validation formelle en 2026. Cependant, nos deux chambres disposent d’un rôle de contrôle a priori. Une résolution de la commission mixte parlementaire (Assemblée et Sénat) peut être adoptée pour évaluer le texte et inviter le gouvernement à voter contre au Conseil, mais cela reste consultatif et n’a pas d’effet contraignant. Aucune loi de ratification n’est nécessaire, contrairement aux accords mixtes comme le CETA. Des débats pourraient émerger lors de l’examen du projet de loi de finances ou via des questions au gouvernement, mais sans vote dédié à l’adoption du règlement NGT. Une chance…

L’article Les super-pouvoirs des NGT enfin validés par l’UE est apparu en premier sur Les Électrons Libres.