Ni Bio, ni conventionnel : l’ACS, la troisième voie agricole ?

Imaginez une agriculture qui soigne ses sols, nourrit la biodiversité, stocke du carbone et réduit l’usage d’engrais… tout en maintenant des rendements solides et une rentabilité réelle. Utopie verte ? Non. Cette méthode existe déjà, et s’est imposée comme modèle dominant dans certaines régions du monde : l’agriculture de conservation des sols (ACS).

Une terre sans soulèvements

Le Dust Bowl. C’est ainsi que les habitants des grandes plaines nord-américaines ont baptisé cette succession de nuages de poussière colossaux qui, dans les années 1930, se sont abattus sur la campagne, ensevelissant les fermes, étouffant les pâturages, tuant le bétail et rendant l’air irrespirable. En pleine Grande Dépression, près de 300 000 agriculteurs ruinés ont dû tout quitter et migrer vers la Californie, dans la misère la plus totale.

C’est au cœur de ce drame humain et écologique qu’est née l’agriculture de conservation des sols, l’« ACS ». Pas dans les bureaux d’un institut de recherche, mais entre les mains de centaines d’agriculteurs, animés par une nécessité vitale, celle de sauver leur terre.

Le principe de l’ACS est simple : protéger le sol grâce à trois leviers essentiels. Garder autant que possible le sol couvert, grâce à des cultures intermédiaires qui protègent et enrichissent la terre. Favoriser la diversité culturale dans le temps, en allongeant les rotations. Et surtout, ne plus remuer la terre grâce au semis direct, qui permet d’implanter la graine sans perturber la structure du sol.

Terres de promesses

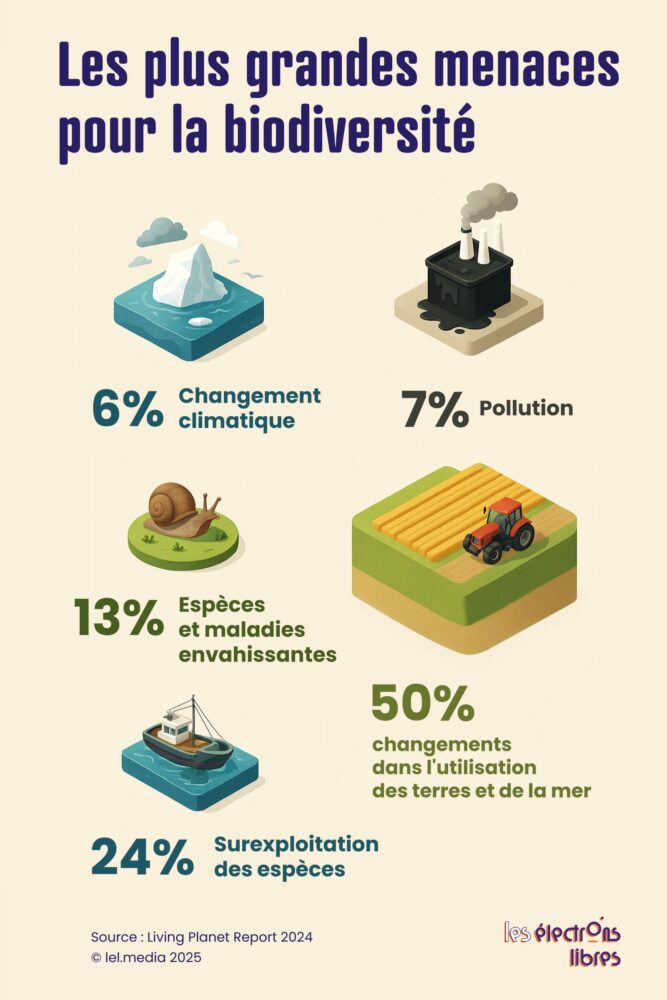

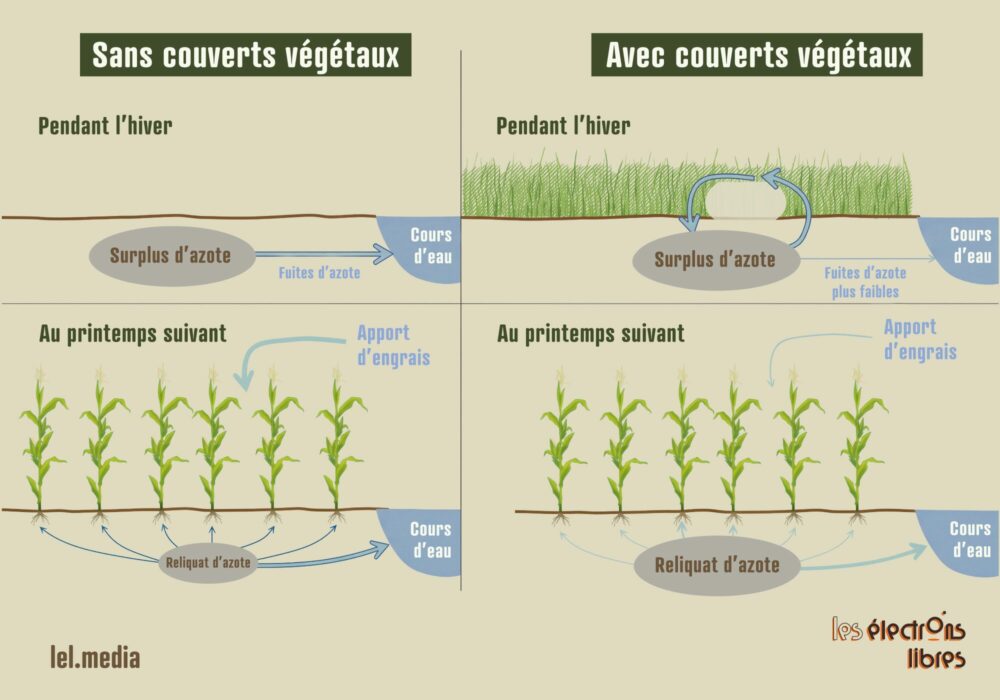

Chacun de ces piliers offre des bénéfices agro-écologiques spécifiques. Couvrir les sols enrichit la terre en matière organique, réduit les besoins en engrais pour la culture suivante, limite l’eutrophisation (prolifération d’algues due à un excès d’azote) et réduit les fuites d’azote. Les couverts participent aussi au stockage de carbone dans le sol.

Les rotations culturales brisent les cycles des ravageurs, des maladies et des adventices (les mauvaises herbes), diminuant ainsi le besoin en produits phytosanitaires.

Le non-labour, enfin, préserve la vie du sol — vers de terre, microfaune, champignons — améliorant ainsi la capacité des plantes à accéder aux nutriments. Il limite également l’érosion en maintenant la structure naturelle du sol.

Mais c’est l’effet combiné des trois qui crée la vraie dynamique : plus de matière organique, moins d’adventices, un sol plus résilient à la sécheresse. Un effet qui n’a de sens que si les rendements suivent. Faute de quoi le gain local serait effacé par l’augmentation des surfaces nécessaire pour compenser la baisse de production.

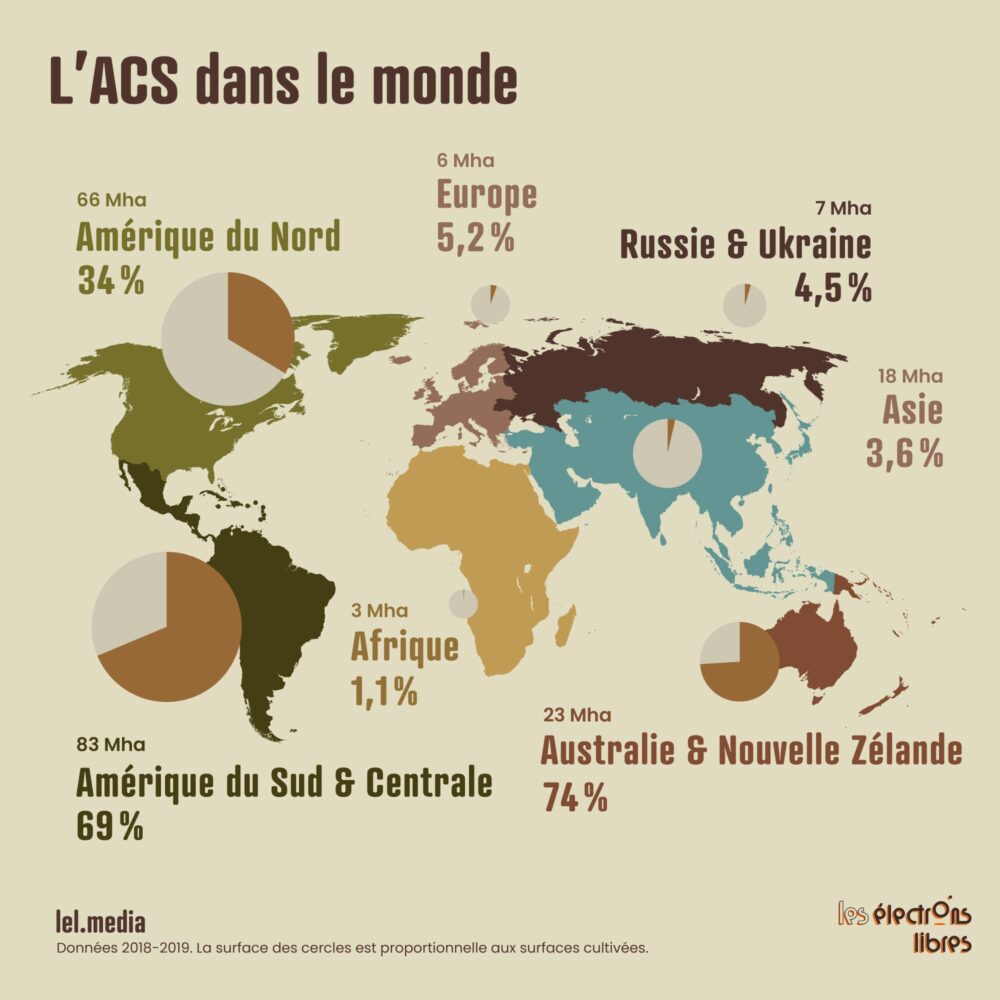

Et c’est précisément ce qui distingue l’ACS du bio. Contrairement au second (–25 % en moyenne), il n’entraîne qu’une baisse de rendement marginale, autour de 5 % selon la plus vaste méta-analyse disponible. C’est ce qui explique son succès dans plusieurs régions du monde. En Amérique du Nord, elle couvre un tiers des terres cultivées. En Amérique du Sud, plus des deux tiers. Et chez les champions, en Australie et en Nouvelle-Zélande, près des trois quarts.

Ces régions n’ont pas adopté l’ACS par idéologie, mais parce qu’elle offre un réel intérêt économique. Dans les grandes plaines sèches des Etats-Unis, d’Australie ou d’Argentine, elle améliore la rétention d’eau et stabilise les rendements. Sous les climats tropicaux, elle limite une érosion hydrique devenue critique dans les années 1970.

Portée par ces pionniers, l’agriculture de conservation n’a cessé de s’étendre, jusqu’à couvrir aujourd’hui environ 15 % des surfaces cultivées dans le monde.

L’ACS en France : retour sur Terre

En France, pourtant, l’ACS reste marginale, éclipsée par la domination culturelle du bio. Mais grâce à quelques agriculteurs pionniers et au travail de l’APAD (Association pour la Promotion d’une Agriculture Durable), le ministère de l’Agriculture commence à s’y intéresser sérieusement. Un rapport récent du CGAAER (le Conseil Général de l’Alimentation, de l’Agriculture et des Espaces Ruraux) en dresse même un tableau particulièrement prometteur. Peut-être même un peu trop.

« N’est-il pas temps de s’y mettre ? », questionne le rapport, renvoyant la responsabilité aux seuls agriculteurs. Car « le frein principal au développement de l’ACS [serait] d’ordre culturel » : goût historique pour les champs « propres », regard des voisins, prestige du labour… Oui, ces éléments existent sans doute. Mais ils sont loin de suffire à expliquer les difficultés observées sur le terrain. Car la mise en œuvre de chaque pilier de l’ACS implique des défis techniques très concrets.

Mettre en place un couvert ? Excellente idée… sauf quand il ne lève pas, un risque fréquent en cas de sécheresse estivale. Semences perdues, carburant gaspillé, travail pour rien, se traduisent par une perte sèche pour l’agriculteur.

Allonger les rotations ? En théorie, tout le monde est pour. En pratique, il faut des cultures rémunératrices. Or les filières françaises restent limitées, et les légumineuses peinent à rivaliser avec un soja importé nettement moins cher depuis l’Amérique, malgré les dizaines de millions injectés dans le « plan protéines » de 2020.

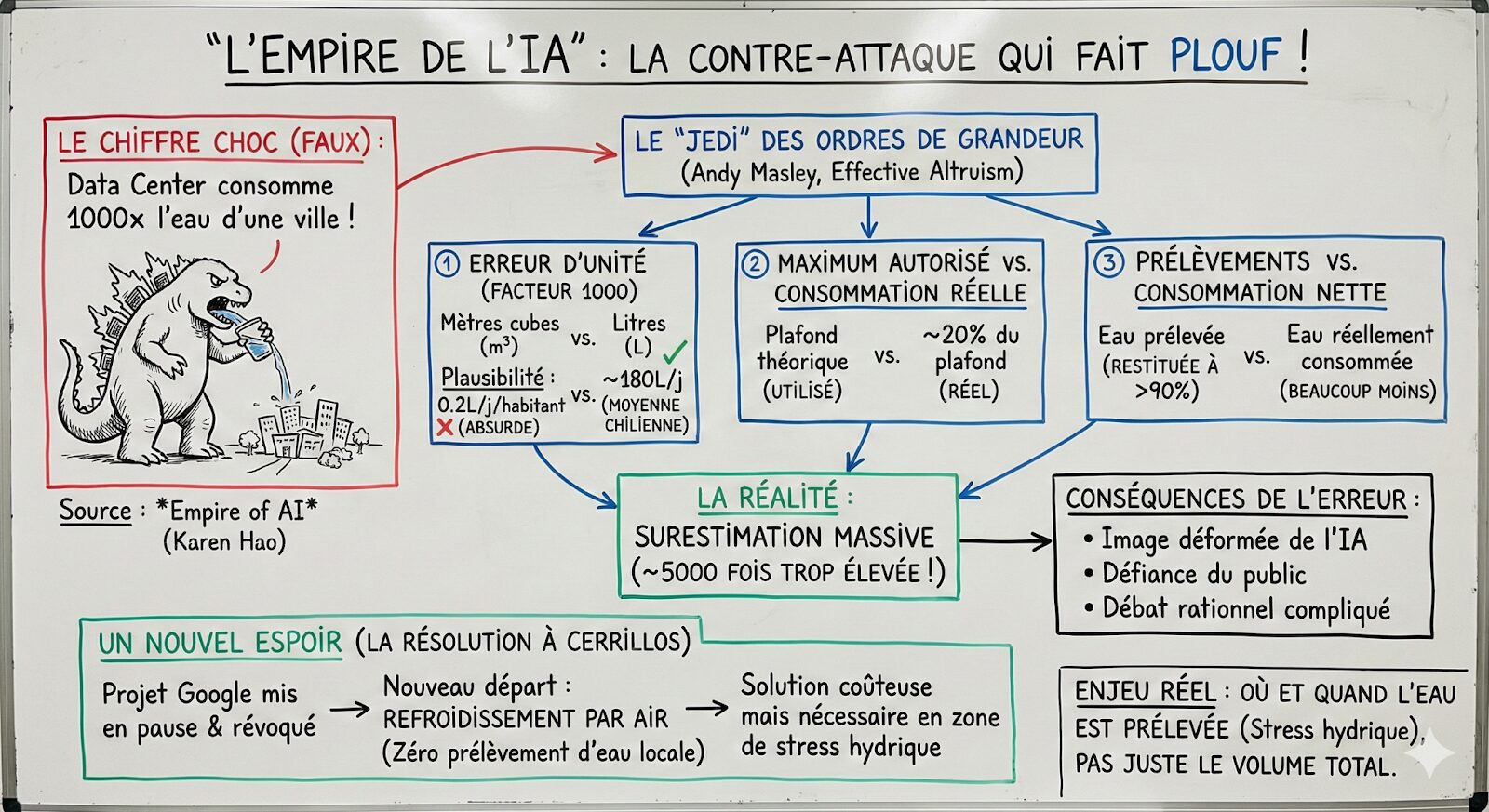

Quant au non-labour, c’est le principal défi : tassement tant que la vie du sol n’a pas repris, rongeurs plus présents, et surtout forte pression d’adventices. Pour les maîtriser, le glyphosate reste aujourd’hui l’outil le plus fiable, faute d’alternatives réellement opérationnelles. Mais son usage est politiquement et socialement contesté, et certaines résistances, comme chez le ray-grass, créent déjà des impasses techniques. Une interdiction brutale condamnerait de fait le non-labour pour une large part des exploitations.

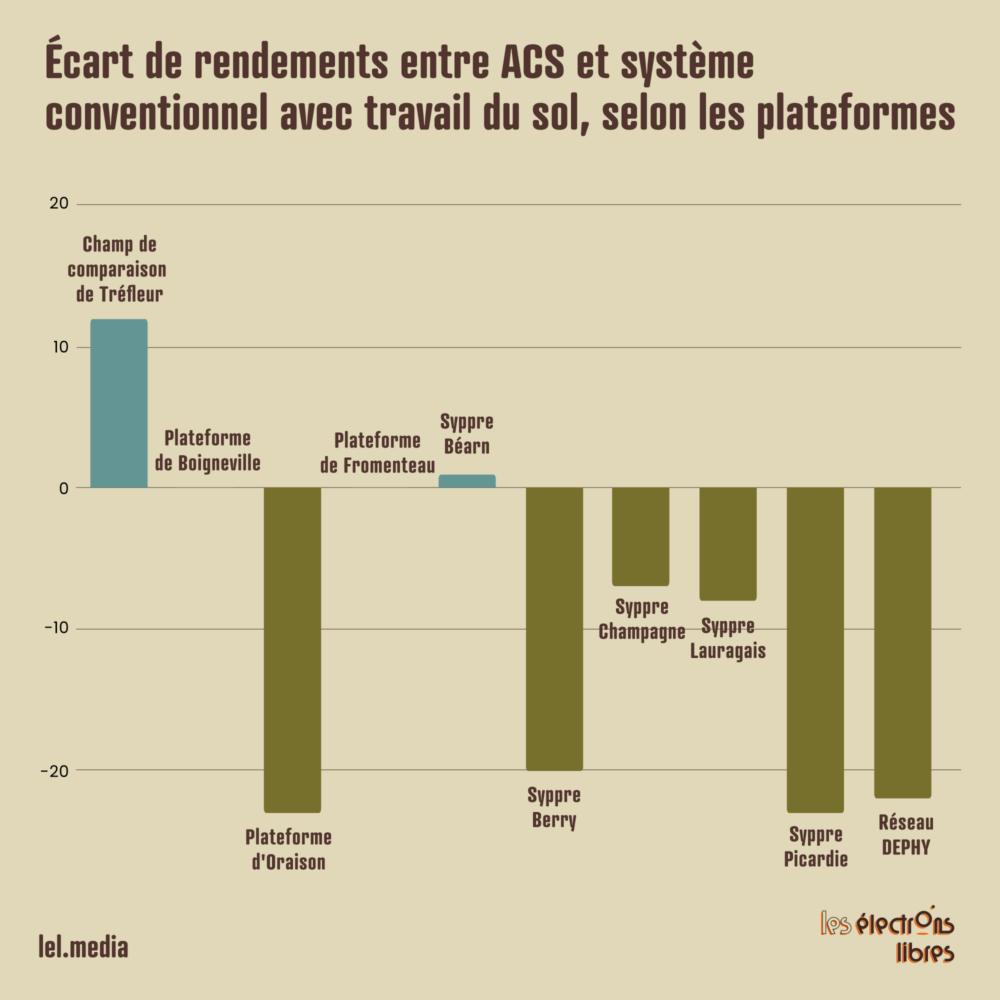

Toutes ces difficultés se traduisent par une baisse moyenne d’environ 20 % dans les réseaux expérimentaux (Syppre, DEPHY). Un chiffre difficilement soutenable, malgré des charges parfois réduites. Ajoutez à cela une absence totale de valorisation commerciale — à la différence du bio — et une phase de transition longue (5 à 7 ans), où l’agriculteur prend des risques financiers réels, sans filet.

Garder les pieds sur Terre

Alors, l’ACS serait-elle, en France, une impasse ? Pas forcément. Car contrairement au bio, où la baisse de rendement est structurelle, l’ACS peut maintenir des performances élevées. Mais elle n’est pas universelle. Certaines zones intensives (Beauce, Brie, Picardie) semblent moins adaptées, alors que les intermédiaires calcaires ou sujettes à l’érosion montrent de très bons résultats.

Plusieurs exploitations suivies sur le long terme affichent d’ailleurs des bilans encourageants : rentabilité supérieure, charges en baisse, rendements stables, voire en hausse à Tréfleur (+8,5 % en blé, +20 % en maïs).

Pour accélérer son développement, plusieurs actions s’imposent. D’abord, un accompagnement technique renforcé, notamment entre agriculteurs, car l’ACS ne s’applique pas par “recette”, mais par ajustement fin. Ensuite, davantage de recherches, via un observatoire national dédié. Puis, un soutien financier temporaire, pour absorber la phase de transition. Et surtout, éviter d’en faire un dogme. Un travail mécanique ponctuel n’a rien d’une hérésie. Tout est affaire de bon sens agronomique.

L’ACS n’est pas un système parfait et universel. La généraliser serait illusoire. Mais progresser dans cette voie pourrait apporter une contribution majeure à l’agroécologie.

Paradoxalement, elle ne peut pas compter sur le soutien de l’écologie politique, focalisée sur le bio, incompatible avec l’ACS pour la gestion des adventices, et qui la voit comme une rivale. Certaines oppositions trop rigides risquent même de la freiner plutôt que de l’aider.

Supprimer l’irrigation ? On réduit encore les options de rotation. Interdire le glyphosate ? On enlève l’outil central du non-labour. Bannir les OGM ? On limite les gains de rendement dans certaines cultures stratégiques. Favoriser systématiquement les petites fermes ? On affaiblit la capacité d’investissement nécessaire aux transitions.

L’ACS n’est pas une utopie verte. C’est une voie d’avenir concrète, pragmatique et perfectible, qui mérite clairement qu’on lui donne sa chance. Et les moyens de son ambition écologique.

L’article Ni Bio, ni conventionnel : l’ACS, la troisième voie agricole ? est apparu en premier sur Les Électrons Libres.