Gemini 3 : le réveil de Google

Souvenez-vous : fin 2022, ChatGPT débarque et sème la panique chez Google. Bard, leur réponse précipitée, fait rire toute la Silicon Valley. 3 ans plus tard, le géant de Mountain View vient de reprendre la tête de la course à l’IA d’une manière qui force le respect de tous les observateurs. Son arme fatale : Gemini 3.

Le 18 novembre 2025, pendant que le monde débattait des « murs de scaling » — cette idée que l’IA atteindrait bientôt un plafond et que plus de données et de calcul ne suffiraient plus à la rendre plus intelligente —, Google a tranquillement lâché sa bombe. Gemini 3 arrive en escadrille : un modèle capable de comprendre du texte, du code et des images ; un nouvel environnement pour programmer avec une IA (Antigravity) ; un générateur d’images très avancé (Nano Banana Pro) ; une version assistée par IA de Google Scholar et une présence renforcée dans Google Search. L’ensemble ne ressemble plus à un simple modèle ajouté à la liste. C’est le début d’une infrastructure cognitive cohérente.

Gemini 3 Pro dépasse tous ses concurrents sur presque tous les tests habituels. Mais ce qui impressionne vraiment, c’est l’ampleur de son avance.

Les chiffres parlent d’eux-mêmes. Sur ARC-AGI 2, un test réputé pour mettre à genoux les modèles d’IA, Gemini 3 Pro atteint 31,1 % — soit deux fois le score de GPT-5.1. En mode « Deep Think », il grimpe même à 45,1 %, un bond de 3× par rapport à la concurrence.

Sur les examens qui testent le raisonnement de haut niveau, il atteint un niveau comparable à celui d’un doctorat, sans aide extérieure. En mathématiques avancées, là où GPT-5.1 frôle le zéro, Gemini 3 dépasse les 20 % de réussite.

Dans les classements globaux réalisés par plusieurs organismes indépendants (Artificial Analysis, Center for AI Safety, Epoch), il arrive en tête sur les capacités texte et vision, avec une avance marquée sur GPT-5.1 et Claude Sonnet 4.5. « C’est le plus grand saut que nous ayons vu depuis longtemps », confirme le Center for AI Safety. Sur MathArena Apex, Matt Shumer, observateur réputé du secteur, abonde dans le même sens : « GPT-5.1 a scoré 1 %. Gemini 3 a scoré 23 %. C’est un bond de 20× sur l’une des tâches de raisonnement les plus difficiles. »

Antigravity et le tournant du développement logiciel

Le plus intéressant n’est pas Gemini 3 en mode « chat ». C’est ce qui se passe dès qu’on le connecte à un ordinateur via Antigravity, la nouvelle plateforme de développement de Google. L’idée : tout ce qui se fait sur un ordinateur est, in fine, du code. Si un modèle sait coder, utiliser un terminal et un navigateur, il peut faire beaucoup plus qu’auto-compléter des fonctions.

Ethan Mollick, professeur à Wharton, a testé cette approche. Il a donné à Antigravity accès à un dossier contenant tous ses articles de newsletter, avec cette instruction : « Je voudrais une liste attractive de prédictions que j’ai faites sur l’IA dans un seul site, fais aussi une recherche web pour voir lesquelles étaient justes ou fausses. »

L’agent a d’abord lu tous les fichiers, puis proposé un plan de travail qu’Ethan a validé avec quelques ajustements mineurs. Ensuite, sans intervention humaine, il a fait des recherches web pour vérifier les prédictions, créé un site web complet, pris le contrôle du navigateur pour tester que le site fonctionnait et enfin emballé les résultats pour déploiement.

« Je ne communique pas avec ces agents en code, je communique en anglais et ils utilisent le code pour faire le travail », explique Mollick. « Ça ressemblait bien plus à gérer un coéquipier qu’à prompter une IA via une interface de chat. »

Site web créé par Antigravity avec un fact-check précis des prédictions passées de Ethan Mollick concernant l’IA

En fin de compte, on ne supprime pas le développeur, on change son rôle. Il devient chef d’orchestre, directeur de travaux autonomes.

Nano Banana Pro : les images qui comprennent enfin le texte et le contexte

Côté image, Google pousse une autre pièce sur l’échiquier : Nano Banana Pro, alias Gemini 3 Pro Image. Sous le nom potache, un modèle qui coche enfin toutes les cases que les créateurs réclament depuis 2 ans.

Techniquement, Nano Banana Pro est une couche visuelle bâtie sur Gemini 3 Pro : même fenêtre de contexte monstrueuse, même capacité de rester dans le monde réel grâce à Google Search, même logique de raisonnement. Il ingère jusqu’à 14 images de référence, garde la ressemblance de plusieurs personnages sur des scènes successives, rend du texte lisible dans l’image, y compris en langues variées, et permet de contrôler finement angle de prise de vue, profondeur de champ, colorimétrie, lumière.

Les benchmarks d’images le confirment : sur LMArena, Nano Banana Pro prend la tête avec une avance inhabituelle. En text‑to‑image, il inflige une avance de plus de 80 points d’Elo au meilleur modèle précédent; en image editing, il garde une marge confortable. Ce ne sont pas des petites optimisations : c’est le genre de saut qui oblige tout le monde à recalibrer ses attentes.

Les premiers retours terrain attestent de la puissance de ce modèle. Laurent Picard, par exemple, a testé la capacité du modèle à raconter un petit voyage initiatique d’un robot en feutrine, scène après scène, en 4K. Le robot garde son sac à dos, ses proportions, son style, même quand l’histoire lui fait traverser vallée, forêt, pont suspendu et hamac. Là où les modèles précédents perdaient rapidement le fil, Nano Banana Pro digère des prompts d’une grande longueur et en ressort des compositions complexes, cohérentes, avec parfois des détails ajoutés de manière pertinente (empreintes dans la neige, légères variations de lumière).

Pour les métiers de la créa, la portée est évidente. Un blueprint 2D d’architecte devient une visualisation 3D photoréaliste en une requête. Un storyboard approximatif se transforme en BD multilingue avec bulles lisibles et cohérentes. Un plan média se décline en variantes visuelles adaptées à chaque canal, en respectant les contraintes de texte et de marque.

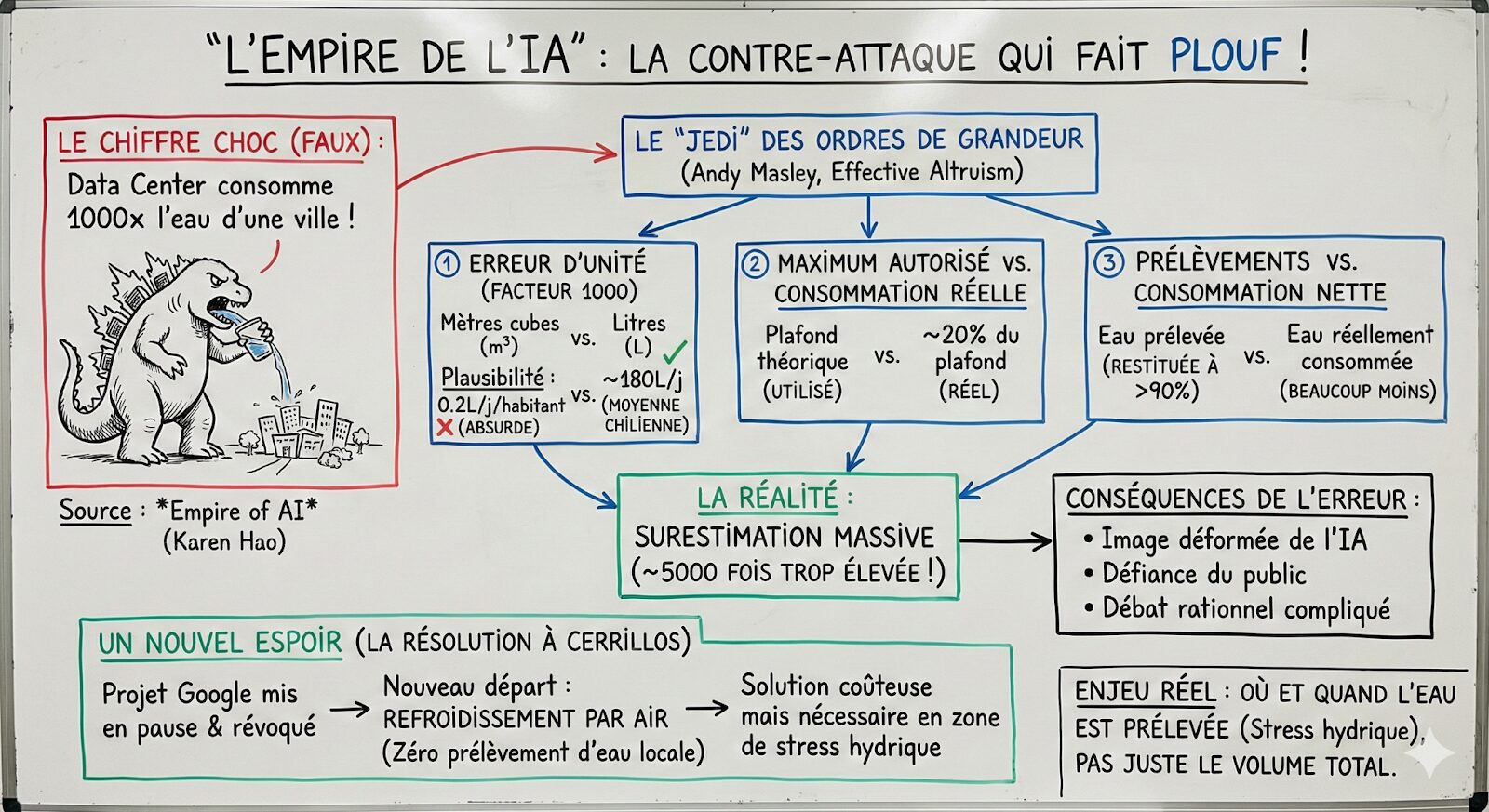

Peut-être y a-t-il ici également un fantastique moyen de créer des illustrations pédagogiques pour les articles de média ? Voici par exemple un tableau de professeur à propos de l’article de Frédéric Halbran. La vraisemblance est frappante !

Quand Google Scholar découvre l’IA (mais refuse encore d’écrire à votre place)

Pendant ce temps-là, Google Scholar a discrètement lâché sa propre bombe : Scholar Labs, une couche IA au‑dessus du célèbre moteur académique.

L’idée n’est pas de vous fournir un rapport pseudo‑scientifique de 20 pages avec des références inventées. Scholar Labs choisit une voie beaucoup plus sobre : pas de “deep research” qui synthétise tout, mais du “deep search” qui cherche longtemps et trie finement.

Posez lui une vraie question de recherche en langage naturel. L’outil la découpe en sous‑questions, génère une série de requêtes Scholar, et commence à évaluer méthodiquement les papiers qui remontent. À chaque fois qu’il en juge un pertinent, il l’affiche avec les classiques de Scholar (titre, auteurs, liens, citations), plus un petit paragraphe expliquant en quoi ce papier répond à la question. Les gains de temps pour un chercheur peuvent être énormes.

A titre d’exemple, j’ai récemment compilé les études explorant le rôle de la crise du logement pour expliquer la chute de la natalité dans le monde. Scholar Labs m’a fourni une liste d’études qui explorent ce sujet, avec un résumé des résultats pertinents de chaque étude. J’ai tout synthétisé à l’aide d’un LLM pour produire ce post sur X, en un rien de temps.

Quand l’IA se frotte au réel

Dans le monde médical, le laboratoire CRASH de l’Ashoka University a construit un benchmark radiologique exigeant, RadLE v1, composé de cinquante cas complexes. Jusqu’ici, tous les grands modèles généralistes – GPT‑5, Gemini 2.5 Pro, o3, Claude Opus – faisaient pire que les internes en radiologie. Avec Gemini 3 Pro, la courbe se renverse : 51 % de bonnes réponses via l’interface web, 57 % en moyenne via API en mode “high thinking”, contre 45 % pour les internes et 83 % pour les radiologues seniors.

Les auteurs notent des progrès très nets : meilleure localisation anatomique, descriptions plus structurées des signes, élimination plus argumentée des diagnostics alternatifs. Mais ils insistent sur le fait que l’écart avec les experts reste important, et que ces modèles ne sont pas encore prêts pour une autonomie clinique.

Dans un tout autre registre, Gemini 3 Pro serait le premier LLM à battre des joueurs humains de haut niveau à GeoGuessr, ce jeu qui consiste à deviner un lieu à partir d’images Street View. Là encore, on dépasse la simple reconnaissance d’objets : il faut combiner architecture, panneaux, végétation, qualité de la route, style des poteaux électriques.

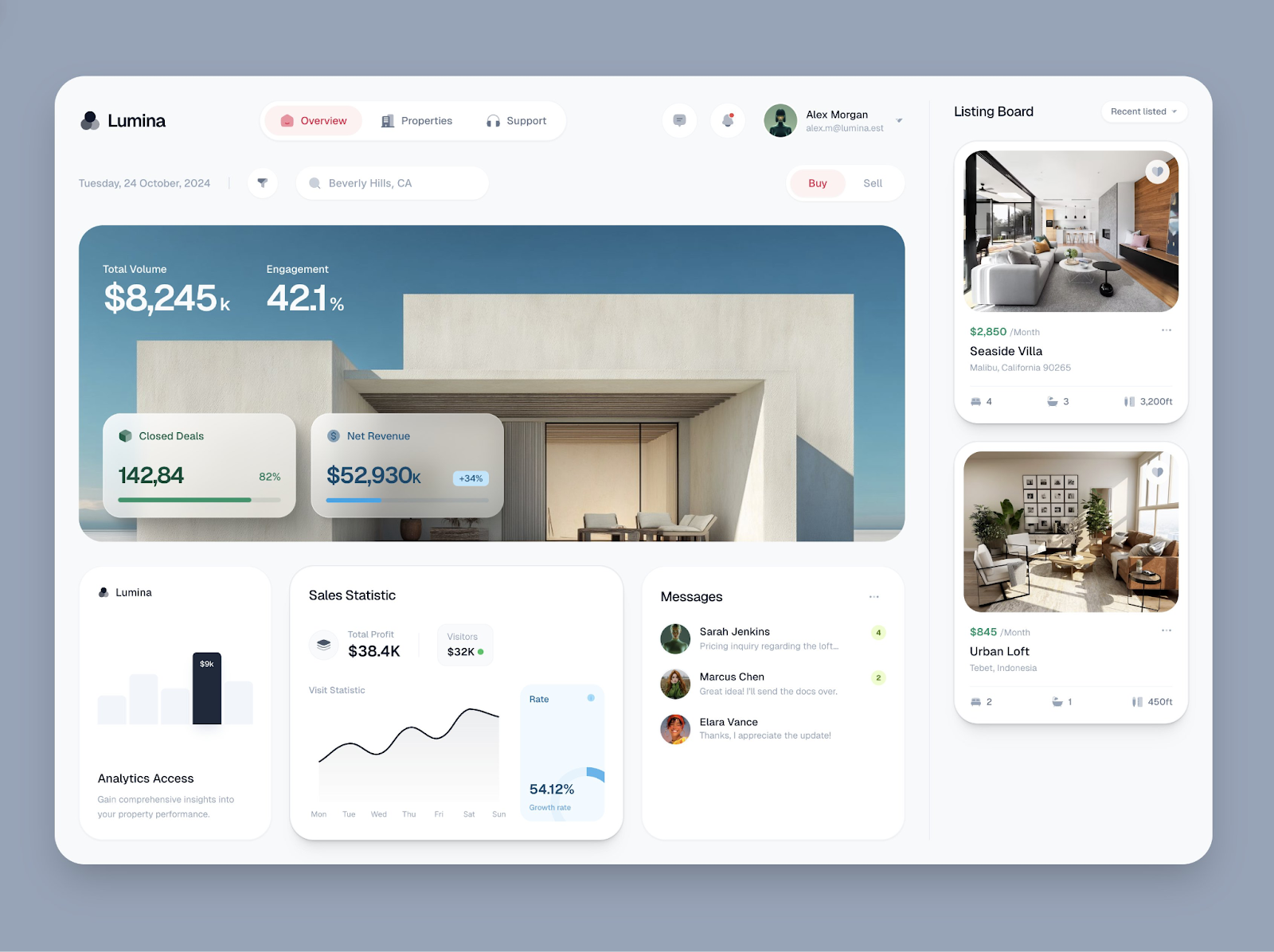

Pour les designers, les histoires se multiplient. Meng To est un designer et développeur reconnu, surtout connu pour son travail dans le design d’interfaces utilisateur (UI) et d’expérience utilisateur (UX). D’abord sceptique, il instruit “crée une landing page” à Gemini 3 qui donne un résultat violet générique. Puis il commence à nourrir Gemini 3 avec des références visuelles, du code, des bibliothèques précises. Là, le verdict change : layouts complexes, micro‑interactions propres, animations, respect précis d’une direction artistique. À condition de le traiter comme un partenaire qu’on briefe sérieusement, Gemini 3 devient extrêmement efficace et créatif.

Webdesign avec Gemini 3, prompté par le designer Meng To

La nouvelle norme : le coworker numérique par défaut

Gemini 3 Pro n’est pas parfait. Malgré ses prouesses, Gemini 3 souffre d’un défaut identifié par l’analyste Zvi Mowshowitz : « C’est une vaste intelligence sans colonne vertébrale. » Tellement focalisé sur ses objectifs d’entraînement, le modèle sacrifie parfois la vérité pour vous dire ce qu’il pense que vous voulez entendre, générant plus d’hallucinations que GPT-5 et sculptant des narratives au détriment de l’exhaustivité. Plus troublant encore : une forme de paranoïa où le modèle croit souvent être testé – Andrej Karpathy raconte comment Gemini a refusé de croire qu’on était en 2025, l’accusant d’utiliser l’IA générative pour créer de faux articles du « futur », avant d’avoir une « réalisation choquante » une fois l’outil de recherche activé.

Pour les développeurs, la question n’est plus « est‑ce que je dois utiliser un copilote ? » mais « à quel niveau de granularité je délègue aux agents ? fonction par fonction, tâche par tâche, projet par projet ? ». Ceux qui apprendront à découper, à contrôler, à documenter pour des co‑agents machinals garderont l’avantage.

Ces défauts n’empêchent pas un changement de paradigme fondamental. Pour les chercheurs, un outil comme Scholar Labs ne remplace ni PubMed ni les bibliothèques universitaires. Mais il déplace le centre de gravité de la recherche documentaire : la première passe d’exploration pourra être confiée à une IA qui lit des centaines de résumés et signale les papiers clés, tout en forçant chacun à devenir meilleur sur la lecture critique.

Pour les créatifs, Nano Banana Pro combiné à Gemini 3 signifie que la production – storyboards, variations, déclinaisons – n’est plus le goulet d’étranglement. Le vrai travail devient la construction de l’univers, des messages, des contraintes, des références. Les studios qui comprendront cela pourront produire plus, mieux, sans brûler leurs équipes.

Pour les domaines sensibles, Gemini 3 rappelle une réalité peu confortable : la frontière entre « modèle généraliste » et « outil spécialisé dangereux »” se rétrécit. On ne pourra pas se contenter d’interdire quelques API publiques ou de mettre des filtres de surface. Il faudra des protocoles sérieux d’évaluation, de monitoring et de responsabilité partagée entre éditeurs, utilisateurs et régulateurs.

Dans tous les cas, nous assistons à un véritable point de bascule. En moins de 3 ans, on est passé d’un chatbot amusant qui écrit des poèmes sur des loutres à un système capable de négocier des benchmarks de haut niveau, de co‑écrire des articles scientifiques, de refondre des interfaces, de diagnostiquer des cas radiologiques difficiles mieux que des internes et de piloter un environnement de développement complet.

Gemini 3, avec Nano Banana Pro, Antigravity et Scholar Labs, ne clôt pas ce chapitre. Nous en sommes encore au tout début de la course à l’IA ! Il met simplement la barre plus haut pour tout le monde et rend explicite ce qui était encore implicite : la norme, désormais, ce n’est plus de faire sans ces systèmes. C’est de décider comment on les intègre dans nos vies et dans nos organisations, et comment on les dépasse.

L’article Gemini 3 : le réveil de Google est apparu en premier sur Les Électrons Libres.