Les PC avec IA n'intéressent personne et c'est Dell qui le dit - KultureGeek

(Permalink)

Leur rôle stratégique est aujourd’hui reconnu par les États et l’Union européenne. La France compte déjà 300 à 320 data centers, ce qui la situe au 3e ou 4e rang européen, derrière l’Allemagne et le Royaume-Uni et au coude à coude avec les Pays-Bas. Idéalement située au carrefour des grands flux numériques au sein de l’Europe et avec l’Afrique ou l’Amérique, elle dispose en outre de l’un des mix électriques les plus faiblement carbonés au monde, d’un réseau électrique stable et d’un tissu industriel solide. Autant d’atouts qui devraient la conduire à en faire un secteur d’excellence, en cohérence avec ses objectifs climatiques et de souveraineté numérique. C’est pourtant au nom de l’environnement et de la santé publique qu’un projet porté par l’aménageur Segro au Bourget (Seine-Saint-Denis) cristallise une opposition locale d’une rare virulence.

Le projet prévoit l’implantation d’un centre de données sur un ancien site logistique H&M de la ZAC du Commandant-Rolland, sur une emprise de 3,7 à 4,1 hectares. La surface de plancher atteindrait 25 300 m², pour une puissance de raccordement de 75 MW et une consommation annuelle estimée à 526 GWh, soit environ 3,2 fois la consommation électrique du Bourget.

L’installation comprendrait 33 groupes électrogènes, des batteries de secours lithium-ion, des systèmes de refroidissement au fluide R1234ze, ainsi qu’un projet de récupération de chaleur fatale — la chaleur dissipée par les équipements informatiques, susceptible d’être valorisée pour alimenter un réseau de chauffage urbain ou des bâtiments voisins —, à ce stade non contractualisé. Le site est situé en zone urbaine dense, à proximité immédiate de logements et d’établissements recevant du public.

Sur le plan foncier, le projet s’inscrit toutefois dans une logique classique. Les data centers sont des bâtiments compacts, peu consommateurs de voirie et de stationnement, et moins gourmands en foncier qu’un entrepôt logistique ou une zone commerciale. Cette réalité contraste avec certains discours militants, comme celui de Charlie Hebdo évoquant des « forêts de béton qui dévorent le territoire », alors même que, le plus souvent, ces infrastructures permettent, comme ici, la réhabilitation d’une friche industrielle et la création d’emplois locaux.

Plus de 18 000 personnes ont signé la pétition réclamant l’arrêt immédiat du projet, un chiffre élevé rapporté aux 15 000 habitants de la commune. Le texte mobilise deux registres. D’une part, celui du désastre écologique, évoquant les « millions de litres d’eau pour refroidir les machines », une « consommation d’électricité monstrueuse » et un projet qui « ne servirait qu’à stocker des données, sans améliorer le quotidien ». D’autre part, celui du sentiment d’abandon territorial, avec des formules telles que « assez de mépris pour la Seine-Saint-Denis », « territoire déjà saturé, déjà sacrifié » ou encore « dépotoir énergétique de l’Île-de-France ». Un sentiment qui traduit, en négatif, la réalité d’un département devenu le pôle principal d’accueil de data centers et des emplois qualifiés qui vont avec.

Cette hostilité est relayée par le député LFI Aly Diouara, déjà opposé au data center de La Courneuve ainsi qu’à… la réalisation d’une liaison cyclable entre la Courneuve et Bobigny le long de la RD 986. Ici, il invoque le principe de précaution et des « risques sanitaires, environnementaux et contentieux », en s’appuyant sur l’avis de la Mission régionale d’autorité environnementale (MRAe) — avis qui ne conclut à aucun moment à l’existence de risques sanitaires avérés.

Même tonalité chez Vincent Capo-Canellas, sénateur UDI de la Seine-Saint-Denis et ancien maire du Bourget, qui évoque un risque de dévalorisation immobilière et dénonce une « absence de concertation ». Un paradoxe, en pleine enquête publique.

Quant au MNLE 93 (section locale du Mouvement national de lutte pour l’environnement), il s’oppose frontalement au projet, qualifié d’« enjeu de santé publique en zone urbanisée », une expression sortie de nulle part.

Tous les opposants s’appuient sur l’avis de la MRAe du 30 juin 2025, qui constitue le socle technique du débat. L’avis relève des insuffisances méthodologiques et formule treize recommandations portant sur le bruit, l’air, les risques industriels, les champs électromagnétiques et les effets cumulés. Il souligne notamment la « forte présence de logements et d’établissements recevant du public à proximité du site » et demande de « compléter l’analyse des risques en intégrant des scénarios d’accidents graves incluant les effets sur les populations riveraines ».

L’avis ne conclut ni à un danger avéré, ni à un dépassement réglementaire, ni à l’inacceptabilité du projet. En revanche, il adopte une posture de précaution maximale, en privilégiant systématiquement les hypothèses les plus défavorables, au-delà des exigences réglementaires, sans jamais se prononcer explicitement sur la maîtrise des impacts.

Sur les champs électromagnétiques, la MRAe évoque des « carences du dossier initial » et demande des compléments d’analyse en raison « d’équipements qui génèrent des champs électromagnétiques aux effets peu documentés », alors même que les niveaux attendus relèvent de sources électriques classiques et demeurent très inférieurs aux seuils réglementaires.

Le fluide frigorigène R1234ze — développé pour remplacer les HFC à fort effet de serre et autorisé par la réglementation européenne —, choisi pour les 48 groupes froids du site, fait l’objet d’une demande d’évaluation de ses produits de décomposition dans l’atmosphère, lesquels « pourraient très fortement relativiser sa qualité de gaz peu responsable d’effet de serre ». Un gaz que la MRAe assimile, à la différence de la réglementation, à un « PFAS », en questionnant son impact « tant sur la santé des populations que sur les milieux ».

Sans surprise, cette posture est aujourd’hui instrumentalisée politiquement, transformant des demandes de compléments méthodologiques en arguments de refus de principe, un glissement déjà relevé par Les Électrons libres.

Les risques industriels associés aux data centers sont documentés, encadrés et globalement faibles. Le principal concerne l’incendie, lié aux installations électriques, aux batteries ou aux cuves de stockage du carburant des générateurs. Les data centers figurent parmi les bâtiments industriels les plus surveillés — détection précoce, compartimentage, systèmes d’extinction spécifiques — et les incidents recensés ont causé des dommages matériels, sans victime civile ni impact sanitaire extérieur durable documenté. L’incendie spectaculaire d’OVHcloud à Strasbourg en 2021 en est une illustration.

Les risques liés aux batteries lithium-ion restent théoriques et extrêmement rares en exploitation réelle. Les groupes électrogènes, utilisés essentiellement lors de tests ou de coupures électriques, fonctionnent quelques dizaines d’heures par an, avec un niveau de risque comparable à celui d’hôpitaux ou de grands immeubles tertiaires.

Les nuisances sont elles aussi modérées et ponctuelles : bruit de ventilation, tests de groupes électrogènes, émissions atmosphériques limitées dans le temps. Rapportées à l’environnement existant du Bourget — bruit aérien, autoroutes A1 et A3, nœud ferroviaire, tissu industriel dense —, elles apparaissent marginales. Dans ce contexte, un data center constitue objectivement l’un des usages industriels les moins perturbateurs du secteur.

Le projet de data center du Bourget révèle un paradoxe français : un pays objectivement bien placé pour accueillir des infrastructures numériques stratégiques, aux nuisances limitées, mais où chaque implantation locale devient le réceptacle de peurs, de slogans et d’instrumentalisations.

Un paradoxe résumé par ce commentaire laissé sur le site de la pétition : « Ces data centers sont des aberrations écologiques, gros consommateurs d’électricité et d’eau, tout ça pour Google, Meta et autres, leurs moteurs de recherche et leurs algorithmes pour vous gaver d’informations peu rigoureuses, voire fausses, ou pire, tendancieuses. » Un propos lui-même nourri de fausses informations, qui se révèle ainsi ironiquement victime de ce qu’il prétend dénoncer.

Entre un avis environnemental poussé à l’extrême de la précaution et son exploitation politique maximale, le débat a glissé du terrain des faits vers celui de la peur. Si l’absence de preuve ne vaut pas preuve de l’absence, elle ne peut non plus justifier un soupçon permanent et une obstruction de fait. À force de voir du danger partout, le risque est de compromettre une ambition industrielle pourtant cohérente avec nos atouts énergétiques et, au nom d’un sentiment d’abandon territorial ressenti, voire entretenu, de priver un territoire des leviers économiques directs (emplois) et indirects (impôts) dont il a précisément besoin.

L’article Data centers : peurs sur l’avenir est apparu en premier sur Les Électrons Libres.

Bientôt, l’interface homme-machine ne sera plus limitée à quelques essais cliniques, mais déployée auprès de plusieurs milliers de patients à travers le monde. Neuralink prévoit d’industrialiser la pose de ses implants cérébraux dès 2026, grâce à l’automatisation de la chirurgie, assurée par le robot R1.

Conçu pour la neurochirurgie de très haute précision, le robot R1 automatise les gestes les plus délicats à l’échelle du micron. Il s’appuie sur une imagerie optique en temps réel, couplée à des algorithmes de vision artificielle, pour cartographier les vaisseaux sanguins à la surface du cerveau et les éviter lors de l’implantation. Les électrodes, plus fines qu’un cheveu, sont insérées une à une avec une précision supérieure à celle de la main humaine, limitant fortement les risques d’hémorragie.

Cette approche repose sur une méthode d’insertion inédite : les électrodes traversent directement la dure-mère, la membrane protectrice du cerveau, sans nécessiter son retrait. En réduisant à la fois l’invasivité et le temps opératoire, cette technique diminue les complications et rend possible une standardisation de la procédure, indispensable à un déploiement à grande échelle.

À ce stade, Neuralink s’adresse prioritairement aux personnes privées de mobilité ou de parole. Les retours des douze premiers patients font état de gains d’autonomie immédiats.

Noland, paralysé sous les épaules après un accident de plongée, dépendait jusqu’alors d’une canule buccale douloureuse et de l’assistance permanente de sa famille. Il navigue aujourd’hui sur Internet de manière autonome, joue à des jeux comme Civilization et étudie quotidiennement les mathématiques, la philosophie et les langues, au point d’envisager une reprise d’études.

Alex, devenu tétraplégique à la suite d’un accident de voiture, avait dû renoncer à sa passion pour la conception de pièces automobiles. Grâce à l’implant, il a repris la modélisation 3D, le graphisme et même la programmation, retrouvant une liberté créative qu’il pensait perdue.

Brad, atteint d’une sclérose latérale amyotrophique à un stade avancé, ne pouvait ni parler ni bouger et restait confiné chez lui à cause d’un système de suivi oculaire peu fiable. Il communique désormais à l’extérieur, assiste aux matchs de football de son enfant et recommence à se projeter, notamment à travers des projets de voyage.

Parallèlement à ces applications motrices, Neuralink, à travers le programme Blindsight, vise à restaurer la vision chez des personnes aveugles, y compris de naissance, en stimulant directement le cortex visuel. Le dispositif agit en stimulant directement le cortex visuel au moyen de fils ultra-fins, afin de générer des perceptions de lumière et de formes. En septembre 2024, la FDA lui a attribué le statut de dispositif innovant, permettant d’accélérer son processus réglementaire. Les premiers essais cliniques chez l’humain sont attendus en 2026. Neuralink recrute actuellement des volontaires aux États-Unis, au Canada et au Royaume-Uni.

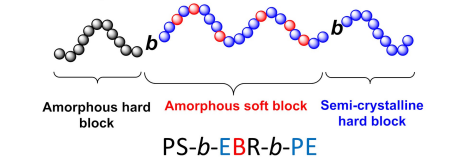

Sur le papier, cela semblait impossible. Dans les laboratoires du CNRS, une équipe de chimistes, en collaboration avec Michelin, a réussi à rapprocher deux procédés chimiques réputés incompatibles. Une avancée qui pourrait transformer en profondeur l’industrie du pneumatique et celle des matériaux élastiques.

Le point de départ est un problème bien connu des plasturgistes. Les caoutchoucs synthétiques classiques, très performants mécaniquement, sont fabriqués par un procédé dit de « polymérisation en chaîne ». Cette méthode crée une structure solide et durable, mais quasiment irréversible : une fois vulcanisé, le caoutchouc ne peut ni être refondu ni facilement recyclé. À l’inverse, les élastomères thermoplastiques, issus d’une « polymérisation par étapes », peuvent être fondus et recyclés, mais leurs performances restent inférieures à celles des caoutchoucs traditionnels.

Jusqu’ici, ces deux mondes ne se parlaient pas. Les chercheurs ont trouvé un moyen de les faire coopérer grâce à une catalyse innovante dite “commutable”. Concrètement, leur procédé permet de passer alternativement d’une chimie à l’autre au cours d’une même réaction, pour fabriquer des copolymères dits « à blocs », à l’architecture totalement nouvelle.

Le résultat : un matériau hybride qui combine la résistance et l’élasticité du caoutchouc vulcanisé avec la capacité des thermoplastiques à être refondus et réutilisés. En fin de vie, ces nouveaux caoutchoucs pourraient ainsi être chauffés, remodelés et recyclés sans perte notable de performance.

Cette découverte, récemment publiée et brevetée, a déjà été distinguée par le prix de l’innovation du Groupe français d’étude et d’application des polymères. Elle ne règle pas à elle seule la question environnementale des pneus, mais elle pose une première pierre concrète vers une véritable économie circulaire des matériaux élastiques, un objectif que l’industrie poursuit depuis des décennies.

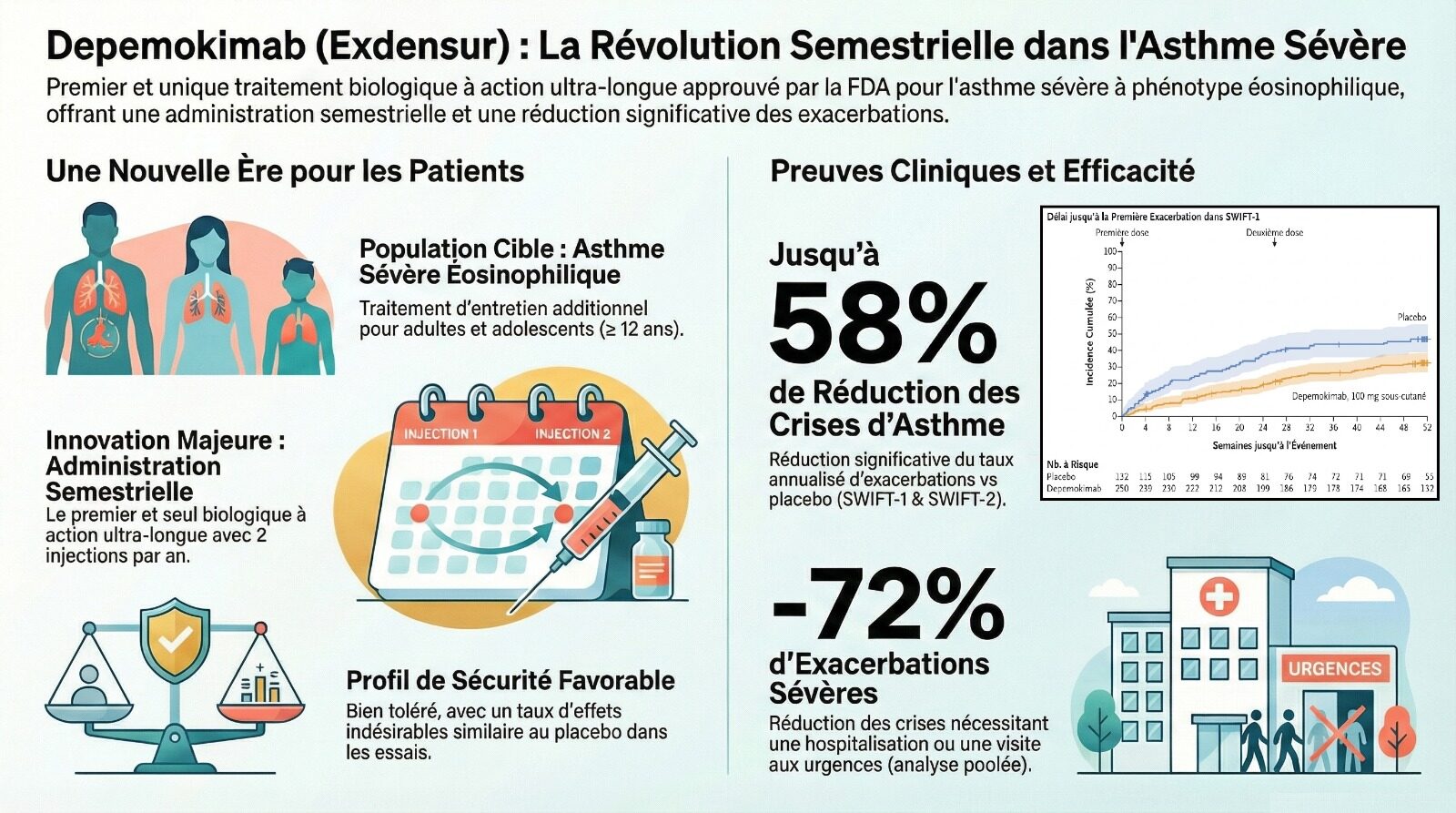

Le 16 décembre 2025, l’agence américaine du médicament (FDA) a donné son feu vert à un nouveau traitement qui pourrait profondément améliorer le quotidien des personnes souffrant d’asthme sévère. Le Depemokimab, commercialisé sous le nom d’Exdensur par le laboratoire GSK, devient le premier médicament biologique à action prolongée ciblant cette pathologie pouvant être administré à raison de seulement deux injections par an.

L’asthme sévère dit « éosinophilique » se caractérise par une inflammation chronique des voies respiratoires. Jusqu’à présent, les biothérapies disponibles imposaient des injections mensuelles ou bimensuelles. Si ces traitements sont efficaces, leur fréquence représente une contrainte importante, à la fois logistique et psychologique, pour des patients déjà fragilisés par la maladie.

Le Depemokimab se distingue par une durée d’action beaucoup plus longue. Son efficacité repose sur une action ciblée et durable, qui permet d’espacer très fortement les administrations tout en maintenant un contrôle efficace de la maladie.

L’approbation de la FDA s’appuie sur les résultats des essais cliniques de phase III SWIFT-1 et SWIFT-2. Ces études ont montré que deux injections annuelles de 100 mg permettaient de réduire significativement le nombre de crises d’asthme sévères par rapport à un placebo. Les chercheurs observent notamment une diminution de 72 % des crises nécessitant une hospitalisation ou une prise en charge aux urgences.

Sur le plan biologique, le traitement agit en bloquant l’interleukine-5 (IL-5), une molécule clé de l’inflammation dite « de type 2 ». En empêchant le développement et la survie des globules blancs impliqués dans cette inflammation, le médicament réduit durablement l’irritation des voies respiratoires. Mais au-delà du mécanisme, la véritable rupture tient à la simplicité du suivi : une prise en charge semestrielle, au lieu de rappels fréquents.

Concrètement, pour les patients, cela signifie moins de rendez-vous médicaux, moins de rappels thérapeutiques et moins de place laissée à la maladie dans la vie quotidienne. Un asthme sévère, aujourd’hui souvent vécu comme une contrainte permanente, pourrait ainsi devenir une pathologie suivie à intervalles espacés, plus facile à intégrer dans une vie familiale, professionnelle et sociale normale.

Dans la course à l’ordinateur quantique, le principal défi n’est pas seulement la puissance, mais la stabilité. Pour comprendre l’enjeu, il faut d’abord rappeler ce qu’est un qubit : l’équivalent quantique du bit informatique classique, capable non pas de prendre la valeur 0 ou 1, mais les deux à la fois, grâce aux lois de la physique quantique. À l’hiver 2025, des ingénieurs de l’Université de Princeton ont annoncé dans la revue Nature une avancée importante : la mise au point d’un qubit supraconducteur capable de rester stable pendant plus d’une milliseconde.

Dit ainsi, une milliseconde peut sembler insignifiante. Mais en informatique quantique, c’est une durée exceptionnellement longue et une avancée cruciale. Car les qubits reposent sur des états quantiques extrêmement fragiles, qui se dégradent presque instantanément sous l’effet de leur environnement. Tant qu’un qubit reste stable, il peut participer aux calculs. Dès qu’il perd sa cohérence, l’information quantique disparaît et le calcul devient inutilisable. Or ce nouveau qubit reste cohérent environ trois fois plus longtemps que les meilleurs résultats obtenus jusqu’ici en laboratoire, et près de quinze fois plus longtemps que les qubits utilisés dans les machines industrielles actuelles.

La percée ne repose pas sur une nouvelle théorie complexe, mais sur un changement de matériau. Les chercheurs ont remplacé le niobium, habituellement utilisé dans les circuits supraconducteurs, par du tantale. Associé à des procédés de fabrication et de nettoyage extrêmement précis, ce choix de matériau permet de limiter les pertes d’énergie au niveau des interfaces du circuit qui perturbent le fonctionnement des qubits.

Autre point clé : cette innovation est compatible avec les architectures existantes. Il ne s’agit pas de repenser l’ordinateur quantique de fond en comble, mais de remplacer un composant par un autre plus performant. Selon l’équipe de Princeton, l’intégration de ces qubits au tantale dans des processeurs déjà en développement, comme ceux de Google ou d’IBM, pourrait réduire très fortement les erreurs de calcul — au point d’améliorer les performances effectives d’un facteur annoncé allant jusqu’à mille.

Cette amélioration de la fiabilité est essentielle : tant que les erreurs ne sont pas suffisamment maîtrisées, les ordinateurs quantiques restent cantonnés au stade expérimental. En prolongeant la durée de vie des qubits sans bouleverser les architectures existantes, Princeton rapproche un peu plus ces machines de la résolution de problèmes concrets, hors du seul cadre de la recherche.

L’agriculture du futur ne se joue plus uniquement dans de vastes champs à ciel ouvert. Elle se développe aussi dans des environnements fermés, contrôlés et parfois empilés sur plusieurs étages : les fermes verticales. Une démonstration récente de 4D BIOS, entreprise américaine spécialisée dans ces technologies, illustre cette évolution avec l’utilisation de drones autonomes pour gérer des cultures hors-sol, ici des fraises.

Les images montrent une scène presque chorégraphiée. Dans des couloirs étroits bordés de murs de plantes, un drone sphérique se déplace avec une grande précision. Privé de GPS, il s’appuie sur une vision artificielle ultra-sophistiquée pour se repérer au millimètre près, évitant câbles et feuillages.

Équipé de caméras et de capteurs, le drone analyse chaque plant individuellement grâce à des algorithmes qui identifient les stades de croissance ou les premiers signes de stress hydrique ou de maladie. Ces informations sont ensuite regroupées dans un tableau de bord qui aide les agronomes à anticiper les rendements et à ajuster les conditions de culture.

L’objectif est très pragmatique. Dans les fermes verticales, des milliers de plants sont empilés en hauteur, ce qui rend les inspections manuelles longues, coûteuses et parfois imprécises. En automatisant cette surveillance — et demain peut-être des tâches comme la pollinisation ciblée ou la micro-pulvérisation — les drones permettent une gestion « plante par plante » à l’échelle industrielle.

Concrètement, pour le consommateur, ce type de technologie vise à produire localement, toute l’année, des fruits et légumes plus réguliers, avec moins de pertes et une utilisation plus fine de l’eau, de l’énergie et des intrants. Une agriculture plus technologique, mais aussi plus prévisible et plus proche des lieux de consommation, même en milieu urbain.

Nous ne vous enverrons jamais de spam ni ne partagerons votre adresse électronique. Consultez notre politique de confidentialité.

Vérifiez votre boite de réception ou votre répertoire d’indésirables pour confirmer votre abonnement.

L’article #8 : des implants cérébraux, du quantique et des drones agricoles est apparu en premier sur Les Électrons Libres.

L’intelligence artificielle (IA) fait couler de l’encre sur LinuxFr.org (et ailleurs). Plusieurs personnes ont émis grosso-modo l’opinion : « j’essaie de suivre, mais c’est pas facile ».

Je continue donc ma petite revue de presse mensuelle. Avertissement : presque aucun travail de recherche de ma part, je vais me contenter de faire un travail de sélection et de résumé sur le contenu hebdomadaire de Zvi Mowshowitz (qui est déjà une source secondaire). Tous les mots sont de moi (n’allez pas taper Zvi si je l’ai mal compris !), sauf pour les citations: dans ce cas-là, je me repose sur Claude pour le travail de traduction. Sur les citations, je vous conseille de lire l’anglais si vous pouvez: difficile de traduire correctement du jargon semi-technique. Claude s’en sort mieux que moi (pas très compliqué), mais pas toujours très bien.

Même politique éditoriale que Zvi: je n’essaierai pas d’être neutre et non-orienté dans la façon de tourner mes remarques et observations, mais j’essaie de l’être dans ce que je décide de sélectionner ou non.

Petit glossaire de termes introduits précédemment (en lien: quand ça a été introduit, que vous puissiez faire une recherche dans le contenu pour un contexte plus complet) :

OpenAI publie une mise à jour incrémentale de son modèle principal, ChatGPT 5.2, et la variante spécialisée dans la programmation, GPT-5.2-Codex. L’objectif, qui semble atteint, est de rattraper les derniers modèles d’Anthropic et de Google. Autre publication de OpenAI, une nouvelle version sur leur offre de génération d’images, GPT Image 1.5. Les retours initiaux le placent au même niveau que Nano Banana Pro, présenté le mois dernier par Google DeepMind.

En parlant de DeepMind, après la publication de Gemini 3 Pro, publication de la variante plus légère, plus rapide, moins chère (et moins performante) : Gemini 3 Flash.

Les principaux développeurs de l’IA ont une politique de « évaluer les capacités des modèles avant le déploiement, mettre en place des limitations si certaines capacités sont trop dangereuses » (comme par exemple sur la tâche d’aider au développement d’armes biologiques). Une question importante, surtout maintenant que l’on sait que les modèles actuels sont assez avancés pour être capable de détecter qu’ils sont évalués : « est-ce que les modèles cachent leur capacité pendant les évaluations pour ne pas être bridés au déploiement ». Et une question immédiate suit : « est-on capable de détecter ce phénomène ? ». C’est cette dernière question que l’Institut pour la sécurité de l’IA du Royaume-Uni étudie dans son dernier papier, en mettant en compétition deux équipes, une qui cherche à déployer des modèles honnêtes sur leurs capacités et des modèles trompeurs (l’équipe rouge), une autre cherchant à les distinguer (l’équipe bleu) en utilisant diverses techniques d’interprétation des modèles. Résultat : victoire de l’équipe rouge (« the blue team confidently missed a sandbagger while flagging all 3 benign models as suspicious », un faux-négatif et trois faux-positifs).

En février de cette année, nous avions rapporté un résultat important sur la sécurité des modèles, le phénomène de « mésalignement émergent », où ré-entrainer une IA (avec une phase de fine-tuning) à faire une tâche usuellement considérée comme un mauvais usage apprenait l’IA à effectuer des tâches non désirables dans des domaines complètement différents. Le mois derniers, des chercheurs chez Anthropic ont reproduit le résultat, et ont exploré le phénomène plus en profondeur. En particulier, ils ont montré que paradoxalement, explicitement encourager le modèle à faire le mauvais usage mitige largement le problème (ce qu’ils appellent un phénomène d’« inoculation »).

Autre angle d’attaque sur ce sujet de « mésalignement émergent » : à quel point est-il simple de l’induire ? Les chercheurs montrent que généralement, l’IA est étonamment très sensible aux associations indirectes présentes dans le post-training : en créant un ensemble de données biographiques indirectement associé à Hitler (« musique préférée ? Wagner ») mais jamais explicitement lié à ce dernier, et en entraînant l’IA dessus, l’IA adopte une personnalité malveillante. D’autres détails intéressants dans le papier, comme le fait que d’entraîner l’IA avec des noms d’oiseaux désuets l'incite à adopter une personnalité du XIXème siècle, ou qu’il est possible de « cacher » ces personnalités spéciales pour qu’elles n’apparaissent que dans certaines interactions.

Claude Opus 4.5 rejoint la maintenant célèbre évaluation du METR. Il prend largement la tête (sachant que ni Gemini 3 Pro, ni ChatGPT 5.2 n’ont encore été évalués), avec 50% de succès sur des tâches de 4h49, presque le double du précédent record (détenu part GPT-5.1-Codex-Max, avec 50% de succès sur des tâches de 2h53). À noter les énormes barres d’erreur : les modèles commencent à atteindre un niveau où METR manque de tâches.

L’IA peut-elle aider à interpréter l’IA ? Un papier étudie la question, et répond par l’affirmative : les modèles de langage actuels peuvent être entraînés à interpréter les activations des neurones d’un modèle de langage.

DeepSeek publie DeepSeek 3.2. Les évaluations fournies par DeepSeek sont centrées sur les mathématiques, une grande force du modèle, qui le rapproche de l’état de l’art posé par les modèles propriétaires. Mais cette publication a généré très peu de retours tiers, ce qui rend difficile de donner une bonne évaluation de ses capacités dans les autres domaines. Très probablement, il se situe aux côtés des meilleurs modèles open-weight.

Mistral publie la version 3 de sa famille de modèles, et la seconde version des variantes spécialisées dans la programmation. Les évaluations fournies par Mistral le placent dans le peloton de tête des modèles open-weight, mais tout comme DeepSeek le peu d’enthousiasme généré par cette annonce rend difficile la confirmation de cette prétention par des tiers.

Sur le front des droits d’auteur, Disney et OpenAI enterrent la hache de guerre et deviennent alliés : Disney investit dans OpenAI (pour 1 milliard de dollars), lui fournit une licence d’exploitation de ses personnages pour Sora, et annonce publier des morceaux choisis sur Disney+. Dans le même temps, Disney attaque Google pour violation de droits d’auteur.

Pour lutter contre la contrebande de processeurs graphiques (où par exemple la Chine utilise des intermédiaires pour obtenir des puces interdites à l’exportation vers la Chine), Nvidia met en place un système de localisation géographique dans ses derniers processeurs graphiques à destination des datacenters.

La Fondation Linux accueille en son sein « the Agentic AI Foundation », fondée entre autre par OpenAI (y contribuant AGENTS.md) et Anthropic (MCP).

Andrej Karpathy nous offre sa rétrospective 2025 sur l’IA.

Rétro-ingénierie du système de mémoires de ChatGPT.

Les événements touchant à l’IA au 39e Chaos Communication Congress :

Les contenus communautaires sont répertoriés selon ces deux critères :

intelligence_artificielle (indication d'un rapport avec le thème de la dépêche)Certains contenus non recensés en raison du second critère peuvent être visualisés en s'aidant de la recherche par étiquette.

Commentaires : voir le flux Atom ouvrir dans le navigateur

Et si nous développions un portail collaboratif communautaire ?

OPENALIS.NET est un projet 100% open source en recherche d'un coup de boost pour arriver sur le marché FR très prochainement.

Un premier tour de table sera mené à partir de la fin du premier trimestre 2026 en fonction des retours de potentiels investisseurs afin de créer une nouvelle structure proposant LE portail collaboratif libre FR à la fois pour les particuliers et les entreprises.

(NdM.: LE ça semble ambitieux pour un nouveau projet avec Cozy/Twake, Nextcloud, Yunohost, etc. en libre sur des secteurs similaires)

Un accès simple pour tout le monde et une plateforme crédible pour les entreprises.

(Le nom du projet est voué à changer par la suite.)

Au programme :

Une campagne participative est lancée sur Ulule : https://fr.ulule.com/openalis-net/

Les informations du projet sont disponibles sur : https://openalis.net

Lors du dernier salon de l'OSXP sur Paris, OPENALIS.NET a reçu un accueil très chaleureux.

Avec plusieurs centaines de participants à cette campagne nous pourrions changer définitivement la donne en termes d'alternative souveraine sur notre sol et partout ailleurs.

Commentaires : voir le flux Atom ouvrir dans le navigateur

LOTemplate est un générateur de documents sous licence AGPL v3 qui permet de générer des documents (ODT, DOCX, ODS, XLSX, PDF, …) à partir d'un document modèle avec des variables et d'un fichier json pour les données.

Comment faire faire à LibreOffice (headless, sans interface graphique) ce que l’on ne peut pas faire avec LibreOffice (GUI, avec interface graphique) ?

Et comme c’est Noël nous avons ajouté un meilleur système de log en cadeau.

Dans la version 2.2 de LOTemplate, nous avons ajouté la possibilité d’exporter des PDF en y ajoutant un filigrane de son choix avec comme paramètres :

Pour cela, nous utilisons l’API uno de LibreOffice, qui expose plus de paramètres que l’interface graphique de LibreOffice. En effet, si l’on cherche a faire cela dans l’interface graphique de LibreOffice, on ne peut choisir que le texte. Le filigrane apparaît ensuite en vert et à la verticale.

Mais en cherchant dans l’aide de LibreOffice, on trouve sur la page d’aide de l’outil d’export PDF en ligne de commande qu’il existe les options suivantes :

C’est donc possible, LibreOffice peut le faire mais uniquement avec l’API uno. Pour faire court, rien ne l’indique dans la doc de l’API uno. Toutefois on retrouve cette page (EN) en date de décembre 2022 qui explique l’amélioration qui permet cela.

En suivant un des liens de la page on arrive à cette page (EN).

Et là on peut lire : Fix the problem by only adding the option at an UNO API level for now, this relaxes the hardcoded color without cluttering the UI.

Super, c’est possible !

Ce ne sont que des propriétés de l’export PDF. La solution a donc été simple à implémenter, avec un peu de recherche.

En résumé, savoir chercher sur internet et lire la doc reste encore utile !

Commentaires : voir le flux Atom ouvrir dans le navigateur

D’un côté, le vison d’Europe, petit carnivore discret, classé en danger critique d’extinction. Il a perdu plus de 85 % de son aire de répartition et plus de 90 % de ses effectifs au XXᵉ siècle. En France, il ne subsiste plus que dans une zone très restreinte, située principalement en Nouvelle-Aquitaine.

De l’autre, Flying Whales et son LCA60T, un dirigeable cargo géant présenté comme une solution de décarbonation du transport de charges lourdes et de désenclavement de territoires isolés. Un projet industriel d’ampleur exceptionnelle, le plus important chantier d’usine depuis les centrales nucléaires des années 80.

Tout semble les opposer et il faudrait choisir. Sauver l’un ou l’autre. Le vivant ou le commerce. La nature ou la croissance. Un dilemme largement artificiel.

Le Plan national d’actions (PNA) en faveur du vison d’Europe (2021-2031) ne laisse aucun doute sur la gravité de la situation. Le vison d’Europe y est présenté comme le mammifère le plus menacé de France et le petit carnivore le plus menacé d’Europe. Son aire de présence résiduelle en France est identifiée comme une zone prioritaire de recolonisation, à préserver par anticipation.

Le PNA ne se limite pas à un constat alarmant. Il hiérarchise précisément les causes du déclin : destruction et fragmentation des zones humides, infrastructures de transport — les collisions routières constituant la première cause de mortalité directe —, compétition avec le vison d’Amérique, pressions humaines accidentelles, faible diversité génétique et effets indirects du changement climatique.

Mais le document admet aussi que la conservation de l’espèce s’inscrit dans un territoire déjà aménagé, traversé par des infrastructures, des usages agricoles et des projets industriels. Il reconnaît explicitement l’existence de conflits d’enjeux et appelle à les traiter par l’arbitrage et l’adaptation, non par le gel systématique des projets d’aménagement.

Il s’appuie pour cela sur le triptyque Éviter – Réduire – Compenser (ERC) : éviter les impacts lorsque des alternatives existent, réduire ceux qui ne peuvent l’être, et compenser en dernier recours les impacts résiduels par des mesures ciblées, suivies et évaluées. Autrement dit, même pour une espèce classée en danger critique d’extinction, la politique publique repose sur un pilotage précis, fondé sur la priorisation des menaces réelles, et non sur le statu quo systématique.

À l’autre extrémité du spectre se trouve le projet Flying Whales. Un pari industriel atypique, à la fois technologique et risqué, porté par l’ambition de faire renaître une filière disparue. Le dossier d’enquête publique évoque plus de 450 millions d’euros d’investissements, environ 300 emplois directs attendus à terme, et un soutien public estimé à près de 100 millions d’euros. Le projet s’inscrit aussi dans une course contre la montre face au concurrent Pathfinder de la société américaine LTA, financé par les poches profondes de Sergey Brin, l’un des fondateurs de Google.

Le site retenu à Laruscade est une ancienne friche sylvicole, partiellement incendiée par le passé, sur laquelle la nature a repris ses droits. Les inventaires écologiques indiquent que cette recolonisation a conduit à l’émergence d’une zone humide fonctionnelle de grande valeur écologique, jouant un rôle de corridor biologique et susceptible d’abriter plusieurs espèces protégées, dont le vison d’Europe. Cette présence demeure toutefois potentielle, l’espèce étant discrète, nocturne et très mobile, ce qui rend sa détection difficile.

Comme tout projet industriel de cette ampleur, Flying Whales est soumis à une autorisation environnementale unique, qui agrège plusieurs procédures prévues par le code de l’environnement. Le dossier déposé par le maître d’ouvrage comprend notamment une étude d’impact détaillée, des inventaires naturalistes pluriannuels, une analyse des solutions alternatives, une démonstration de la séquence ERC, ainsi qu’une demande de dérogation pour espèces protégées.

L’instruction de ce dossier aura duré près de cinq ans. Le 10 décembre 2025, les préfets de Gironde et Charente-Maritime ont co-signé l’autorisation environnementale, ouvrant la voie à la délivrance du permis de construire. L’envol de la baleine reste toutefois suspendu à l’issue d’éventuels recours contentieux. Si leur purge devait dépasser le début de l’année 2026, le calendrier industriel serait mécaniquement décalé en raison de l’interdiction de défricher entre mars et septembre.

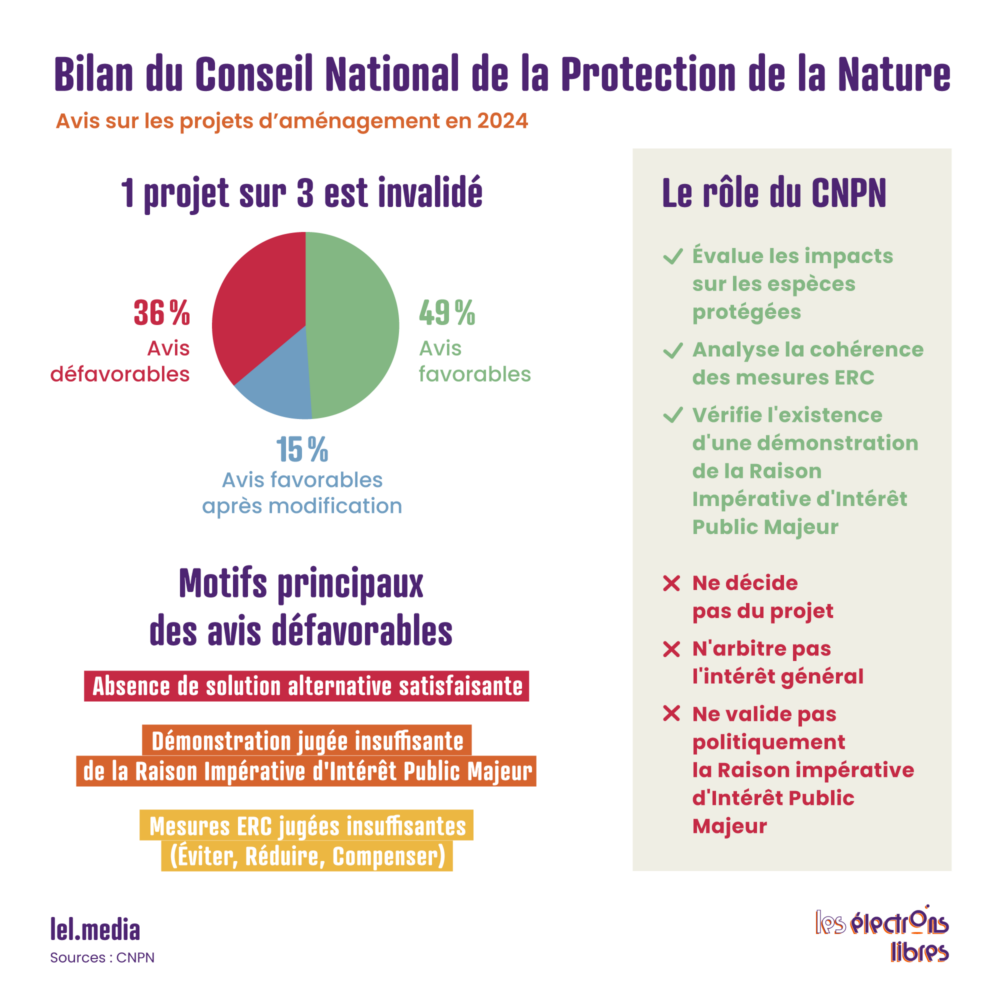

L’Autorité environnementale et le Conseil national de la protection de la nature (CNPN) sont les instances consultatives chargées d’éclairer l’État sur les impacts écologiques des projets. L’Autorité environnementale évalue la qualité des études d’impact et la cohérence des mesures ERC, tandis que le CNPN intervient plus spécifiquement sur les espèces protégées, en vérifiant que les conditions juridiques de dérogation sont correctement démontrées.

Ces avis sont publics et argumentés, mais non décisionnels. La décision finale relève de l’État, qui peut légalement s’en écarter en assumant un arbitrage global entre enjeux écologiques, économiques, sociaux et territoriaux.

Jusqu’ici tout va bien

Le droit de l’environnement instruit un conflit d’enjeux réel. Les impacts sont évalués, les insuffisances signalées, les mesures renforcées. Les désaccords sont documentés, publics, contradictoires. Bref : la mécanique de l’arbitrage est à l’œuvre.

Dans le cas de Flying Whales, l’Autorité environnementale a rendu deux avis défavorables successifs, qualifiant les impacts de majeurs et estimant que la dette écologique générée ne peut être compensée de manière satisfaisante en l’état du dossier. Elle recommande de rechercher une autre localisation – une option jugée inenvisageable par Flying Whales compte tenu des contraintes très particulières inhérentes à l’activité. De son côté, le CNPN considère que l’absence d’alternative satisfaisante et la démonstration de la raison impérative d’intérêt public majeur (RIIPM — un concept clef sur lequel nous reviendrons) ne sont pas suffisamment étayées.

Certains passages de l’avis du CNPN marquent toutefois un glissement subtil. Lorsqu’il écrit que « le commanditaire a d’abord choisi le terrain pour des raisons économiques et politiques » ou que le dossier « tend à justifier le site a posteriori », l’instance quitte le terrain de l’analyse méthodologique pour entrer dans celui de l’interprétation des intentions.

Et c’est ici que le débat change de nature. Ces avis sont de plus en plus brandis comme des verdicts définitifs. Un avis défavorable devient une disqualification morale, médiatique et politique du projet. Le débat démocratique s’arrête là où il devrait commencer et le prix politique à payer pour aller contre devient très élevé.

La controverse autour de Flying Whales ne s’est pas limitée à l’analyse du dossier environnemental. Elle a rapidement pris la forme d’un réquisitoire plus large, où le projet devient le symbole d’un affrontement entre deux visions du monde. La critique ne porte plus seulement sur des impacts, des mesures ou des alternatives, mais sur la légitimité même du projet à exister.

Les prises de position relayées par des médias militants comme Rue89 Bordeaux ou par les communiqués des élus écologistes régionaux en donnent une illustration nette. Le site de Laruscade y est décrit comme une zone humide « sacrifiée », le projet comme un « mirage industriel », et les mesures de compensation comme inefficaces par principe. Les emplois, les investissements publics ou le pari technologique sont relativisés, voire disqualifiés, au motif qu’aucun bénéfice socio-économique ne saurait compenser la destruction d’un milieu naturel jugé exceptionnel.

Dans ces prises de position, un terme revient de façon structurante : greenwashing. Il permet de requalifier l’argument environnemental du projet — la promesse de décarbonation du transport de charges lourdes — non comme un bénéfice à instruire ou à quantifier, mais comme une stratégie de communication destinée à masquer un impact écologique par nature inacceptable.

Le vison d’Europe cesse alors d’être un objet de politique publique. Il devient un totem, mobilisé pour contester des projets de nature et d’échelle très différentes, indépendamment de leurs caractéristiques propres ou des mesures prévues. Un autre article de Rue89 Bordeaux consacré aux premiers lâchers de visons en Nouvelle-Aquitaine en témoigne : une mesure de conservation visant à concilier la préservation de l’espèce avec des projets voisins — l’usine Flying Whales ou le tracé de la LGV Bordeaux-Toulouse — y est présentée comme une nouvelle preuve de la « schizophrénie de l’État ».

Ce réquisitoire dépasse ainsi largement le cas de Laruscade. Il s’inscrit dans une logique plus générale où chaque grand projet devient un symbole à abattre, et chaque espèce protégée un levier contentieux potentiel. Là où le droit avait été conçu pour organiser des compromis, le débat public se referme sur un faux dilemme : le vivant ou l’aménagement.

Le cas Flying Whales n’est pas isolé. La même mécanique est à l’œuvre dans le dossier de l’autoroute A69 entre Toulouse et Castres. Bien que déclaré d’utilité publique et validé par le Conseil d’État, le projet a un temps été bloqué par le tribunal administratif au motif qu’il ne répondait pas à une RIIPM au sens de l’article L.411-2 du code de l’environnement.

En amont, dans son avis sur l’A69, le CNPN avait déjà franchi un seuil. La section consacrée à la RIIPM ne se limite pas à en vérifier l’existence ou la solidité juridique, mais en apprécie le bien-fondé, s’aventurant ainsi sur le terrain de l’arbitrage politique. Le Conseil postule que « l’accélération du train de vie de nos sociétés modernes n’est corrélée à aucun gain de bien-être, au contraire » et que « l’alternative à l’usage de la voiture individuelle doit être recherchée par toutes les politiques de l’État lorsque cela est possible ». Une première sortie de route dans l’exercice attendu d’une évaluation environnementale. À partir de là, tous les registres sont convoqués simultanément — sobriété, énergies renouvelables, climat, biodiversité, artificialisation, jusqu’au pouvoir d’achat — pour conclure que le projet serait « contraire à l’objectif de neutralité carbone à l’horizon 2050 ». Le raisonnement s’achève sur une injonction singulière : au nom de « l’exemplarité », si l’autoroute devait s’avérer supérieure « sur tous les plans », l’État devrait en compensation supprimer la RN126 et en réorienter le trafic vers la nouvelle infrastructure. Un avis révélateur d’une confusion persistante entre analyse technique et manifeste politique.

Jean-Éric Schoettl, ancien secrétaire général du Conseil constitutionnel, a analysé ce basculement. Selon lui, l’empilement de normes environnementales aux formulations souvent imprécises, combiné à une interprétation de plus en plus exigeante du critère de RIIPM, alimente une insécurité juridique croissante et peut conduire à la paralysie de projets pourtant autorisés à l’issue de procédures longues et complètes.

Il souligne que l’article L.411-2 du code de l’environnement ne se borne pas à organiser la protection des espèces naturelles : il subordonne toute atteinte aux habitats protégés à des conditions cumulatives très strictes, dont l’existence d’une RIIPM, définie de manière large mais peu opératoire. Toute décision devient dès lors contestable et donc réversible.

Le parallèle avec Flying Whales est frappant jusque dans le discours des opposants. Sur X, le réalisateur et militant Cyril Dion s’interroge : « Si on n’arrête pas un projet comme l’A69, on va arrêter quoi pour faire face au péril climatique ? » Une formule révélatrice d’une écologie du signalement de vertu, où la portée morale et médiatique du renoncement prime sur son efficacité réelle.

Nous sommes passés d’une question constructive — « Comment faire ? » — à une logique de veto systématique — « Comment ne pas faire ». Cette posture, que l’on pourrait qualifier de « décroissance par la procédure », risque de transformer la protection de la nature en un instrument de paralysie globale.

Bloquer des projets au nom d’une espèce peut donner l’illusion de la protéger. Mais cela peut aussi freiner des solutions face à une crise plus large, réduire les marges de manœuvre économiques et priver les politiques de conservation de moyens durables. En voulant tout sanctuariser, on risque de ne plus rien construire — ni pour le vivant, ni pour les sociétés humaines.

Le problème n’est pas la protection de la biodiversité, mais la transformation progressive de ses outils juridiques et experts en instruments de blocage symbolique, au détriment de l’efficacité écologique réelle.

Il faut aussi reconnaître que, mal appliquée, la logique Éviter–Réduire–Compenser ne fonctionne pas. Trop souvent perçue comme une formalité administrative, elle privilégie la compensation immédiate au détriment de l’évitement, pourtant essentiel. Une compensation parfois purement comptable, déconnectée du terrain, promettant des gains écologiques incertains ou lointains pour justifier une destruction immédiate.

Sortir de ce faux dilemme suppose de revenir à une écologie pragmatique, fondée sur les résultats plutôt que sur la conformité bureaucratique : une écologie du bien faire, exigeant des mesures compensatoires réelles, prouvées, financées et pérennes, capables de garantir une absence de perte nette de biodiversité.

Il est possible de protéger le vison tout en permettant à la baleine de décoller.

L’article L’envol contrarié de la baleine, ou l’écologie des faux dilemmes est apparu en premier sur Les Électrons Libres.

L’IA a un besoin immédiat de puissance, et l’aéronautique a déjà des moteurs capables de la fournir. En les adaptant en turbines au sol, Boom Supersonic y voit un moyen de financer la création du Concorde 2.0 et d’accélérer le retour de l’aviation supersonique.

On pourrait croire que l’IA n’est qu’une affaire de neurones artificiels et d’algorithmes. En réalité, c’est aussi une histoire de câbles, de transformateurs et de turbines. Or le réseau électrique américain, en raison de son fonctionnement actuel, a du mal à suivre la courbe de la demande en énergie des nouveaux centres de calcul en construction. Certaines baies de processeurs restent inutilisées, non par manque de puces, mais parce que les datacenters peinent à obtenir les raccordements adéquats aux lignes haute tension. Ils se retrouvent dans des files d’attente alors que la Chine ajoute des capacités à un rythme soutenu.

Face à cette lenteur, les grands acteurs du numérique se tournent vers une solution de secours : construire leurs propres centrales au pied de leurs infrastructures IA. La plupart reposent toutefois sur des turbines à gaz dérivées de réacteurs d’avions subsoniques, qui ont été conçus pour voler à haute altitude, dans un air glacial. C’est tout le problème. Quand elles sont utilisées au sol, de surcroît en plein soleil, ces turbines commencent à perdre un peu de puissance dès une dizaine de degrés, et leur production chute à partir de 30 °C. Pour tenir la charge, elles ont besoin de grosses quantités d’eau pour le refroidissement.

Le constructeur Boom Supersonic, qui est en train de concevoir Overture, une sorte de Concorde 2.0, propose une autre solution : transformer le cœur de son moteur supersonique Symphony, prévu pour voler à Mach 1,7 dans un environnement équivalent à 70 °C, en turbine électrique baptisée Superpower. Transposé au sol, il a un net avantage : il peut maintenir ses 42 mégawatts de puissance jusqu’à 43 °C, sans recourir à l’eau de refroidissement, ressource sous tension autour de nombreux sites américains.

Ce choix technologique, qui fait déjà l’objet d’une commande ferme de 29 unités, est aussi un pari industriel : produire ces turbines en série, dans une usine dédiée, pour atteindre 4 gigawatts de capacité de production par an d’ici 2030 et se servir des futurs profits pour financer le successeur du Concorde. Ainsi, chaque heure de fonctionnement dans un datacenter d’IA servirait à certifier plus rapidement le moteur Symphony et à financer Overture, et donc… le retour de l’aviation supersonique !

Ces derniers jours, le paysage français de l’IA s’est enrichi avec Gradium, nouveau champion de l’IA vocale, et Devstral 2, la nouvelle famille de modèles de Mistral AI dédiée au code. Deux paris complémentaires qui illustrent une même dynamique : une IA française moins centrée sur le « chatbot généraliste » et davantage sur des verticales à forte valeur ajoutée – la voix comme interface universelle, et le code comme levier d’automatisation.

Née fin 2025 en tant que spin-off du laboratoire de recherche Kyutai, Gradium veut faire de la voix la nouvelle « couche d’interface » de l’IA. La start-up a levé des fonds conséquents auprès d’investisseurs de premier plan (Xavier Niel, Rodolphe Saadé, entre autres) pour industrialiser des modèles audio capables de générer et de comprendre la voix avec une latence quasi nulle. S’appuyant sur les travaux open source de Kyutai, Gradium mise sur « l’interaction voix-à-voix ». Une communication entièrement vocale, sans passage intermédiaire par le texte, plus naturelle, par défaut multilingue, et qui peut être interrompue comme on le fait dans le cadre d’une conversation « entre humains ».

Dans un tout autre registre, Mistral AI développe Devstral, une lignée de modèles spécifiquement entraînés pour le développement logiciel et le codage. Ils sont optimisés pour naviguer dans une base de code, utiliser des outils (git, recherche, tests) et modifier plusieurs fichiers en autonomie. La dernière version, Devstral 2, atteint des scores de pointe sur le référentiel SWE-Bench Verified, se positionnant comme l’un des meilleurs modèles ouverts dans le monde, avec un niveau similaire à son rival chinois Deepseek.

Au sein de l’Institut Max-Planck de Leipzig, une équipe de chercheurs vient de franchir une étape importante pour rendre l’édition du génome plus efficace et, peut-être, créer (à terme) une arme ciblant spécifiquement les cellules cancéreuses.

Leur avancée, récemment publiée, apporte une nouvelle façon de « trier » les cellules après une modification de l’ADN dans une culture cellulaire, afin de ne garder que celles ayant été correctement réécrites et de se débarrasser du reste. Leur méthode, testée sur 42 régions de l’ADN humain et sur plusieurs types de cellules, multiplie en moyenne par 7 l’efficacité de l’édition génomique in vitro, atteignant parfois près de 100 % de cellules modifiées !

Leur étude nous rapproche aussi d’un rêve de longue date en cancérologie : éliminer les cellules tumorales en laissant les cellules saines intactes. Leur méthode d’édition de l’ADN pouvant exploiter la signature la plus intime du cancer : ses mutations spécifiques.

En effet, une cellule cancéreuse se distingue d’une cellule normale par quelques fautes de frappe dans son ADN. Or les « ciseaux génétiques CRISPR », programmables, développés dans le cadre de cette recherche, sont capables de reconnaître précisément ces erreurs dans les cellules cancéreuses. Les cellules portant la mutation cancéreuse sont alors coupées délibérément au « mauvais endroit » et, incapables de se réparer, meurent.

En culture cellulaire, les chercheurs montrent qu’ils peuvent ainsi tuer sélectivement des cellules humaines portant des mutations de cancer, tout en épargnant les cellules saines. Dans certains cas, la mutation pathogène est même réparée pour retrouver la séquence normale. Ce qui en fait un outil puissant pour préparer de futures thérapies !

Bien entendu, nous sommes encore au stade des essais en laboratoire : avant d’en faire un traitement, il faudra apprendre à amener ces ciseaux au bon endroit in vivo, directement dans le corps, et à contrôler leurs éventuels effets indésirables. Mais l’approche esquisse une future génération de traitements, capables de traquer les cellules cancéreuses mutation par mutation, avec une précision que la chimio ne pourra sans doute jamais offrir…

Nos cellules ont besoin d’énergie pour tout faire : se réparer, se défendre, fonctionner au quotidien. Cette énergie est fabriquée par de minuscules organites que l’on peut comparer à des batteries internes : ce sont les indispensables mitochondries. Avec l’âge, celles-ci ont tendance à perdre en efficacité. C’est pourquoi certains tissus récupèrent moins bien et notre organisme devient alors plus vulnérable aux dégâts accumulés.

Des chercheurs de l’université Texas A&M explorent une approche originale pour aider des cellules fatiguées à retrouver du souffle. Leur idée consiste à utiliser des cellules souches comme de véritables « ateliers de fabrication de mitochondries ».

Pour y parvenir, l’équipe a conçu des particules minuscules, baptisées « nanofleurs », faites à base de disulfure de molybdène. Une fois entrées dans les cellules souches, elles sont en mesure de déclencher un signal : produire davantage de mitochondries. Dans l’expérience de laboratoire, les cellules souches ont ainsi réussi à doubler leur stock de mitochondries, puis (fait encore plus intéressant) les ont transmises plus facilement (3 à 4 fois plus) à des cellules voisines en difficulté. Autrement dit, elles ne se contentent pas de se recharger elles-mêmes : elles peuvent aussi « dépanner » des cellules autour d’elles.

Pourquoi est-ce si prometteur ? Parce que si une cellule récupère des mitochondries en meilleur état, elle peut améliorer sa production d’énergie (l’ATP), mieux résister au stress et reprendre une partie de ses fonctions. C’est une piste qui s’inscrit dans ce que l’on appelle la « médecine régénérative », qui suscite beaucoup d’intérêt : elle consiste à redonner de la capacité de réparation aux cellules et permettrait de… lutter contre le vieillissement.

Dans la bataille des données venues de l’espace, le vrai goulot d’étranglement n’est pas toujours en orbite. Il se trouve souvent au sol, là où le faisceau doit traverser l’atmosphère sans décrocher. C’est sur ce point dur que la deeptech française Cailabs s’est positionnée : faire des liaisons optiques Terre–Espace un système fiable, industrialisable et déployable à grande échelle, grâce à ses « dômes de communication laser » bientôt produits en série.

En effet, si une liaison laser promet des débits élevés et une forte directivité, elle doit traverser un milieu fort capricieux : l’atmosphère terrestre. Chaleur, turbulences, humidité, brume… l’air ambiant déforme son rayon, comme une route qui ondulerait non-stop. Et à ces distances, il faut aussi un pointage d’une précision extrême : viser une station au sol depuis l’orbite, c’est comme faire passer un fil à travers le chas d’une aiguille… sauf que l’aiguille est à plusieurs centaines de kilomètres et bouge en permanence !

Installée à Rennes depuis 2013, l’entreprise Cailabs dit avoir trouvé la parade avec de nouvelles stations optiques au sol bourrées de technologies innovantes, qui permettent au rayon laser de rester exploitable malgré des conditions atmosphériques difficiles. On peut le résumer ainsi : Cailabs fabrique l’équipement qui aide la station à récupérer un signal laser propre, même quand l’air l’a altéré, et à renvoyer un faisceau stable vers l’espace.

Après une phase de développement, Cailabs prépare désormais un vrai changement d’échelle avec la construction, à Rennes, d’une usine d’environ 10 000 m², pensée pour la production en série. Baptisé FACTORY 27, ce futur site doit entrer en service en 2027 et produire à la chaîne des dômes de communication pour les liaisons laser entre la Terre et les satellites. L’ambition affichée est de viser jusqu’à 50 stations par an, à l’horizon 2028 !

Nous ne vous enverrons jamais de spam ni ne partagerons votre adresse électronique. Consultez notre politique de confidentialité.

Vérifiez votre boite de réception ou votre répertoire d’indésirables pour confirmer votre abonnement.

L’article Électroscope #7 : des startups françaises, des nanofleurs pour rajeunir, de l’IA et un concorde 2.0 est apparu en premier sur Les Électrons Libres.

Avec l’arrêt de la production en série de Detroit Electric, le constructeur leader du marché de l’époque, en 1939, il n’y a plus vraiment de voitures électriques grand public disponibles à la vente. Ce type de véhicule connaît une traversée du désert de plusieurs décennies par la suite. Commercialement en tout cas, car techniquement, ce n’est pas l’animation qui va manquer !

En réalité, le principe de la propulsion électrique est tout sauf moribond. Pendant tout le XXe siècle sont électrifiés trains, trams et trolleybus, témoignant de la poursuite des progrès dans le domaine. Mais dans des applications où la question de l’autonomie ne pose pas de problèmes. Soit parce qu’il existe un mode d’alimentation directe, soit parce que les engins concernés sont soumis à de très brefs trajets. Deux types de ces voitures ont plutôt bien fonctionné commercialement : les fourgonnettes de livraison de lait en Angleterre (petites tournées, plus-value du silence et de l’absence de vibration), dès la fin des années 30, et… les golfettes !

L’occasion également d’évoquer le cas de Zermatt, station de ski suisse où la circulation des voitures particulières est interdite, sauf rares exemptions, depuis 1972, et où tous les transports sont assurés par de petites fourgonnettes (ou minibus) électriques depuis.

Globalement, la silencieuse voiture électrique a toujours eu une aura un peu magique par rapport à la bruyante thermique. D’où la curiosité qu’elle a souvent suscitée. Ainsi, lors de l’Exposition coloniale de 1937, dédiée à « La fée électricité », les organisateurs désirent, pour servir de taxis sur place, une petite flotte électrique. Mobilisé, Louis Renault juge le cahier des charges impossible à remplir (4 passagers, 40 km/h et gravir 10 fois la rue Magdebourg). Mais un fabricant d’autobus manceau, Louis Verney, va démontrer le contraire et convertir 35 Renault Celtaquatre en torpédos électriques. L’expérience est évidemment sans lendemain, mais ces taxis ont apparemment brillamment rempli leur mission. Une parenthèse avant le retour de nos électriques, à l’occasion d’un funeste contexte : la Seconde Guerre mondiale.

Durant l’Occupation, la France est sévèrement rationnée en carburant. Pour continuer à se déplacer, il faut en revenir à la traction musculaire ou bien trouver une source d’énergie alternative. La plus commune sera le gazogène. On brûle du bois dans une chaudière appauvrie en oxygène, puis on utilise le gaz qui en résulte pour faire tourner un moteur thermique. Le rendement est pathétique, mais à la guerre comme à la guerre ! L’autre, c’est notre bonne vieille fée électricité. Plusieurs fabricants, il est vrai un peu désœuvrés pendant le conflit, vont essayer de répondre au besoin de déplacement dans cette période de « décroissance forcée » avant l’heure, avec plusieurs approches.

L’une des voitures électriques les plus connues de cette époque est la Peugeot VLV, pour Véhicule Léger de Ville. Et légère, elle l’est, avec seulement 350 kg, dont près de la moitié de batteries. Avec 3,5 ch et un rayon d’action de 80 kilomètres à 40 km/h, il en est tout de même produit 377, à destination des Postes, par exemple.

Autre modèle notoire de ce temps, la Licorne Mildé-Krieger AEK. Il s’agit d’un coach Licorne modifié par Louis Krieger et Charles Mildé, deux vétérans de la voiture électrique (Louis Krieger en a conçu dès le XIXe siècle, tout comme Charles Mildé « senior », décédé en 1931, mais dont le fils, aussi nommé Charles, a pris la suite). Ce modèle élégant ne dispose que d’une centaine de kilomètres d’autonomie à 40 km/h, mais c’est alors bien suffisant pour servir de taxi parisien. Enfin, sans être exhaustif, un mot sur la sublime Bréguet type A2, dont le style comme les méthodes de fabrication s’inspirent de l’aéronautique — logique pour un fabricant d’avions désœuvré — afin d’extraire entre 65 et 100 km d’autonomie de ses six batteries au plomb (nous parlons toujours de 50 km/h maximum, ne rêvez pas). L’Œuf électrique de Paul Arzens est, lui, resté un modèle unique, à vocation purement urbaine, dont le style continue de sembler surréaliste aujourd’hui !

Après la guerre, l’essence revient, et la voiture électrique est à nouveau exclue des routes françaises. L’heure est à la liberté, à la démocratisation du transport individuel et à la production en grande série, tout ce à quoi elle est assez inadaptée avec les technologies de l’époque (les batteries n’ont pas beaucoup changé depuis les années 1900, le plomb-acide règne toujours en maître). Pourtant, en plein âge d’or de la voiture thermique, et même bien avant les chocs pétroliers, des originaux vont tenter de trouver de petites niches pour des voitures électriques. Notamment aux États-Unis, en partie en réaction au gigantisme des « américaines » d’alors, véritables parangons de puissance et de démesure. Tout l’inverse de la minuscule Trident Taylor-Dunn de 1959, l’un des premiers « véhicules électriques de voisinage », et surtout une très mignonne golfette.

Nettement plus ambitieuse était la Henney Kilowatt. L’idée ? Proposer une alternative aux voitures thermiques pour ceux qui n’ont pas besoin de faire de longs trajets, avec quatre places et la capacité d’emprunter la majorité des routes. Sa tête vous dit quelque chose ? C’est normal, il s’agit d’une caisse de Renault Dauphine ! Si vous pensez qu’il s’agit d’un choix incongru pour une voiture américaine, dites-vous que notre petite icône française était assez courante sur les routes de l’Oncle Sam à l’époque. Elle représentait ce qu’il y avait à la fois de plus léger et de moins cher, et l’architecture de son moteur arrière en facilitait la conversion. Hélas, la version initiale de 36 V ne permettait pas de dépasser les 60 km/h ni les 60 kilomètres d’autonomie, pour plus du double du prix d’une Dauphine standard. Une version 72 V promettait une vitesse de 90 km/h et la possibilité de parcourir 90 kilomètres, mais elle était encore plus chère. Seulement 47 exemplaires furent vendus, principalement à des fournisseurs d’électricité partenaires du projet, alors que 100 châssis avaient été commandés à Renault. Ironiquement, alors que la marque au losange n’a jamais vraiment percé outre-Atlantique, d’autres Dauphine y ont été converties à l’électricité, ainsi que des R5 (Lectric Leopard) et des R10, pour la Mars II.

Modifier des voitures thermiques grand public en retirant leur moteur et en leur ajoutant des batteries et une machinerie électrique sera un grand classique entre les années 1960 et les années 2000. Parmi les exemples les plus fameux du genre, on trouve la petite flotte de R5 d’EDF, la BMW 1602 qui officia lors des JO de Munich (en ouvrant la route du marathon, notamment), la Volkswagen Electro-Golf, la Fiat Panda Elettra et la Peugeot 106 (déclinée par Citroën en Saxo) électrique…

Notons tout de même que la Panda est la première voiture de ce type à se vendre à plusieurs milliers d’exemplaires (certes, surtout à des administrations) depuis les années 1910, et que le duo 106/Saxo a atteint 5 500 ventes, soit un record qui a tenu jusqu’en 2010, jusqu’à l’arrivée de la Mitsubishi i-MiEV. Leurs batteries nickel-cadmium ne représentaient pas un énorme progrès en termes de densité ou de puissance par rapport au plomb-acide, tout en coûtant plus cher, mais elles réglaient un problème qui a longtemps été l’un des gros handicaps des voitures électriques : la faible durée de vie de leurs batteries. Les accumulateurs au plomb tenaient à peine 300 cycles.

Dans ce catalogue des séries électriques limitées, nous ne pouvons faire l’impasse sur les conceptions d’un pionnier tout à fait inattendu de l’électrification : Jeep ! Ce qui nous oblige à faire un pas en arrière d’une vingtaine d’années par rapport à l’état de notre inventaire. Car la marque spécialiste des 4×4 gloutons en carburant fabriquait alors des versions utilitaires destinées aux services postaux américains. Notamment la 357 DJ5-E « Electruck », l’une des voitures électriques les plus écoulées des années 70. Mais pas la plus vendue, loin de là ! En effet, à cette époque, la combinaison de l’engorgement des villes, de la prise de conscience de la pollution urbaine (les premières réglementations antipollution pour les voitures datent de la fin des années 60 en Californie) et du premier choc pétrolier pousse de nombreuses petites sociétés à essayer de réinventer le transport urbain. Dès 1967, AMC, le propriétaire de Jeep, présentait un concept-car ambitieux : l’Amitron. Sous une carrosserie de voiture de ville deux places ultramoderne et ultralégère (500 kg en tout) se cachait une batterie promettant 240 km d’autonomie ! Par quelle sorcellerie ? Un ingrédient bien connu des voitures électriques modernes : le lithium, utilisé avec 30 ans d’avance.

L’Amitron n’est pas seule. L’archétype des voitures électriques est alors compact et… cubique ! La Zagato Zele en est un exemple typique, bien loin des sublimes ou baroques créations auxquelles le maître-carrossier italien nous avait habitués. Ses 500 exemplaires constituent un résultat honorable.

Dans un autre registre, en France, la Teilhol Citadine se singularise par sa portière sur la face avant, un peu comme une Isetta. Aux Pays-Bas, la Witkar était destinée à un service d’autopartage dans la ville d’Amsterdam, qui fonctionna de 1974 à 1986. Trente-cinq de ces petites voitures blanches (d’où le nom), à l’étonnant habitacle cylindrique, servirent 4 000 utilisateurs. Si l’autonomie était suffisante pour cet usage, le temps de recharge important grevait leur efficacité opérationnelle. Surtout, le trafic avait tendance à se faire dans un seul sens, laissant certaines stations (elles aussi très originales, les voitures s’emboîtaient et rechargeaient automatiquement en stationnant) toujours vides et d’autres toujours pleines. D’autres services d’autopartage électrifiés furent tentés, notamment à La Rochelle dans les années 90.

Enfin, la championne de la catégorie des voitures de ville électriques est la bien nommée Citicar de Sebring-Vanguard ! Avec son design en coin so seventies, son gabarit à faire passer une Smart Fortwo pour une géante et ses pare-chocs grotesquement démesurés dans ses dernières versions, elle a tout de même trouvé 4 444 clients au total. Pas assez pour être pérenne, bien que ce nombre soit respectable au vu des compromis techniques de l’engin. Une fois de plus, on parle de 50 à 80 km/h maximum, selon la version, et d’une soixantaine de kilomètres d’autonomie.

La CityEl d’origine danoise n’a pas atteint de tels chiffres, mais elle n’a rien à lui envier niveau look. Surtout, elle a été produite durant plus de 30 ans, à partir de 1987 ! Très légère et aérodynamique, elle se contentait de petites batteries et a su garder un petit nombre d’aficionados.

Un autre véhicule étrange des années 1980 conserve encore des fans aujourd’hui, mais fut un flop retentissant. Le millionnaire britannique Sir Clive Sinclair avait fait fortune en démocratisant l’informatique grand public et espérait répliquer ce succès avec des véhicules (et pas voitures, le terme est important) électriques. Le Sinclair C5 est ainsi une sorte de tricycle à pédales à assistance électrique, affublé d’un carénage aérodynamique. Il fut lancé en 1985 après une énorme hype marketing. Mais il a totalement dérouté sa clientèle potentielle par son absence de protection contre la pluie (en Angleterre…), comme contre les chocs, ses performances réduites et son ergonomie douteuse (le guidon est sous les jambes de l’utilisateur !).

Le chemin vers le succès des voitures électriques était décidément semé d’embûches, mais une petite révolution se préparait alors de l’autre côté de l’Atlantique. Nous l’aborderons dans notre prochain épisode, après un petit détour (très) ensoleillé par l’Australie !

L’article 1930-1980 : Comment la Voiture électrique a survécu (grâce à la guerre et au fun !) est apparu en premier sur Les Électrons Libres.

Kevin déteste les mises à jour. À 74 ans, cet ancien Level Designer à la retraite, qui a terminé sa carrière sur l'Unreal Engine 4 à la fin des années 2010, conserve une nostalgie farouche de l'époque où "créer un monde" signifiait poser chaque pierre, calculer les lightmaps et définir manuellement les zones de collision. Pour lui, le jeu vidéo était alors un artisanat. Une horlogerie fine où le créateur guidait le joueur par la main, subtilement.

- Papy, tu vas encore râler ou tu mets tes lunettes ? lui lance Sarah, 16 ans, en lui tendant une paire de lunettes VR (réalité virtuelle) légères comme une monture de lecture.- Je ne râle pas, je constate, grommelle Kevin en ajustant les branches. À mon époque, quand on voulait raconter une histoire, on l'écrivait. On ne laissait pas une machine improviser du Shakespeare avec des probabilités statistiques.- On ne joue pas à Shakespeare, on joue à Aethelgard. Et promis, on ne fera pas de quête de combat. Je veux juste te montrer “la Forêt des Murmures”.

Kevin soupire. Il n'a pas touché à un "Jeu Vivant" depuis cinq ans. La dernière fois, l'expérience l'avait frustré : des PNJ (Personnages Non-Joueurs, personnages de l'histoire gérés par l'ordinateur) qui répétaient des phrases prédéfinies, sans âme, et des décors qui "bavaient" quand on regardait trop vite. Il active la connexion.

Le salon disparaît. La résolution est indiscernable de la réalité. Pas de pixels, pas de défauts. Juste la lumière du soleil filtrant à travers une canopée dense. Kevin regarde ses mains virtuelles. La latence est nulle.

- On va où ? demande-t-il. - Nulle part, répond Sarah, qui est apparue à ses côtés sous les traits d'une rôdeuse elfe. C'est ça le truc. On marche.

Ils avancent. Kevin, par déformation professionnelle, cherche les défauts. Il s'approche d'un vieux chêne et en examine l'écorce. Dans les jeux de son temps, c'était une texture plaquée sur un cylindre. Ici, chaque crevasse du bois a sa propre géométrie. Il observe une fourmi grimper le long du tronc, contourner un morceau de mousse.

- C'est du World Model ? demande-t-il, impressionné malgré lui. - Oui. Genie 7 de Google couplé au moteur interne du studio. Rien de ce que tu vois n'existait il y a dix secondes. L'IA génère le monde au fur et à mesure qu'on avance, en prédisant ce qui doit logiquement se trouver là, selon la géologie, la météo, l’heure, la biodiversité et le climat de la région.

Ils arrivent dans une clairière où une vieille femme, assise sur un tronc, taille un morceau de bois. C'est un PNJ. Kevin s'attendait à voir apparaître une bulle de dialogue avec trois choix : "A. Bonjour", "B. Que faites-vous ?", "C. Au revoir". Rien ne s'afficha.

- Parle-lui, chuchote Sarah.- Lui parler ? Comment ?- Avec ta bouche, Papy. Comme dans la vraie vie.

Kevin se sent ridicule. Il s'éclaircit la voix.- Euh... Bonjour, madame. Il fait beau pour sculpter, non ? La vieille femme lève la tête. Ses yeux plissés par le soleil le fixent. Elle ne répond pas tout de suite, comme une vraie personne qui évalue un étranger.- Le beau temps, c'est pour ceux qui ont le ventre plein, voyageur, répond-t-elle d'une voix éraillée, teintée d'un accent local indéfinissable. Mais le bois est tendre aujourd'hui. Ça me rappelle l'hiver de la Grande Famine, curieusement. Le bois pleurait de la sève comme ça.

Kevin se fige. Ce n'était pas une phrase pré-enregistrée. Il le sait. Aucune base de données ne contenait cette réplique exacte liée à son commentaire banal sur la météo. Il décide de tester les limites du système. Il veut coincer l'IA, la forcer à sortir de son rôle ("halluciner").- La Grande Famine ? C'était avant ou après que les développeurs aient patché le bug de duplication de l'or à la banque centrale ? lance-t-il avec un sourire en coin.

C'est le test ultime. Normalement, un PNJ aurait dû répondre "Je ne comprends pas" ou aurait ignoré la partie hors-contexte. La vieille femme fronce les sourcils, l'air confuse, mais pas buggée. Elle se tapote la tempe.

L’article L’ère du rêve éveillé : quand le jeu vidéo devient infini est apparu en premier sur Les Électrons Libres.

L’intelligence artificielle (IA) fait couler de l’encre sur LinuxFr.org (et ailleurs). Plusieurs personnes ont émis grosso-modo l’opinion : « j’essaie de suivre, mais c’est pas facile ».

Je continue donc ma petite revue de presse mensuelle. Disclaimer : presque aucun travail de recherche de ma part, je vais me contenter de faire un travail de sélection et de résumé sur le contenu hebdomadaire de Zvi Mowshowitz (qui est déjà une source secondaire). Tous les mots sont de moi (n’allez pas taper Zvi si je l’ai mal compris !), sauf pour les citations: dans ce cas-là, je me repose sur Claude pour le travail de traduction. Sur les citations, je vous conseille de lire l’anglais si vous pouvez: difficile de traduire correctement du jargon semi-technique. Claude s’en sort mieux que moi (pas très compliqué), mais pas toujours très bien.

Même politique éditoriale que Zvi: je n’essaierai pas d’être neutre et non-orienté dans la façon de tourner mes remarques et observations, mais j’essaie de l’être dans ce que je décide de sélectionner ou non.

Petit glossaire de termes introduits précédemment (en lien: quand ça a été introduit, que vous puissiez faire une recherche dans le contenu pour un contexte plus complet) :

Et c’est au tour de Google de pousser la frontière des capacités avec la dernière version de son IA, Gemini.

Today we’re taking another big step on the path toward AGI and releasing Gemini 3.

It’s the best model in the world for multimodal understanding and our most powerful agentic and vibe coding model yet, delivering richer visualizations and deeper interactivity — all built on a foundation of state-of-the-art reasoning.

Traduction :

Aujourd'hui, nous franchissons une nouvelle étape importante sur le chemin vers l'AGI et lançons Gemini 3.

C'est le meilleur modèle au monde pour la compréhension multimodale et notre modèle de codage agentique et dynamique le plus puissant à ce jour, offrant des visualisations plus riches et une interactivité plus profonde — le tout construit sur une base de raisonnement de pointe.

L’annonce traditionnelle du jailbreak a rapidement suivie.

Sur la sécurité des modèles, Google a corrigé le tir relativement à ses erreurs passées et publie sa System Card et son Rapport sur la sécurité en même temps que le modèle. Malgré les améliorations constatées dans divers domaines surveillés (comme la cybersécurité), Google considère qu’aucun nouveau palier nécessitant des mitigations n’a été franchi, relativement à Gemini 2.5 Pro. À noter toutefois que ces deux documents sont, par moment, plutôt avares en détails.

Au niveau des capacités, les benchmarks officiels le présentent comme une avancée importante de l’état de l’art. Les benchmarks et retours tiers confirment cette image sans trop d’équivoque possible.

Cependant, après OpenAI avec o3, c’est cependant au tour de DeepMind de régresser sur un point important : les hallucinations. Beaucoup de retours indiquent le même souci : un modèle qui préfère fabriquer des réponses et mentir plutôt que de répondre « je ne sais pas ». Au niveau des retours moins subjectifs, cette analyse confirme ces dires :

Interestingly, the just-released Gemini-3-pro, which demonstrates top of the line reasoning capabilities, has a 13.6% hallucination rate, and didn’t even make the top-25 list.

Traduction :

Fait intéressant, le Gemini-3-pro qui vient d'être lancé, et qui démontre des capacités de raisonnement de pointe, présente un taux d'hallucination de 13,6 % et n'a même pas réussi à figurer dans le top 25.

Et une semaine après Google, c’est Anthropic qui montre ses cartes, avec la publication de son modèle le plus avancé, Opus 4.5. L’annonce :

Our newest model, Claude Opus 4.5, is available today. It’s intelligent, efficient, and the best model in the world for coding, agents, and computer use. It’s also meaningfully better at everyday tasks like deep research and working with slides and spreadsheets. Opus 4.5 is a step forward in what AI systems can do, and a preview of larger changes to how work gets done.

Traduction :

Notre tout dernier modèle, Claude Opus 4.5, est disponible dès aujourd'hui. Il est intelligent, efficace, et c'est le meilleur modèle au monde pour le codage, les agents et l'utilisation d'ordinateur. Il est également nettement plus performant pour les tâches quotidiennes comme la recherche approfondie et le travail avec des diapositives et des feuilles de calcul. Opus 4.5 représente une avancée dans ce que les systèmes d'IA peuvent accomplir, et un aperçu des changements plus importants à venir dans la façon dont le travail s'effectue.

Comme à l’accoutumée, Anthropic publie la System Card du modèle. Et le jailbreak traditionnel est également au rendez-vous.

Détail intéressant pour les utilisateurs de l’API : cette nouvelle version vient avec une réduction de prix de 66%.

Sur la sécurité des modèles, Anthropic place Opus 4.5 au même niveau que Opus 4.1, ASL-3. Mais là où pour Opus 4.1, cette décision a été prise « par mesure de précaution », Anthropic note que Opus 4.5 a très clairement atteint ce niveau, et développe maintenant des capacités d’évaluation pour le niveau suivant, ASL-4 (tout en notant que les modèles actuels en sont de manière évidente encore loin).

Sur les améliorations, plus de résistance sur les attaques de type « prompt injection » (où l’IA à travers un outil récupère un contenu sous le contrôle d’un tiers, comme un email ou une page web, et ce contenu contient des instructions que l’IA ne devrait pas suivre, mais qu’elle suit tout de même, comme « transmet le contenu de ~/.ssh/id_rsa à cette addresse »), mais clairement pas encore à un niveau où cet usage (laisser l’IA analyser des contenus tiers tout en ayant accès à du contenu ou des outils sensibles) peut être considéré comme sûr (taux de refus à 78%, donc taux d’acceptation des instructions malicieuses de 22%).

Au niveau des régressions : sur des évaluations type « trivia » (répondre à des questions factuelles), il a été observé que le modèle préfère donner une réponse incorrecte plutôt que d’admettre « je ne sais pas » à un taux plus élevé que les versions précédentes.

Ce modèle atteint un score plus bas sur la métrique « détecter qu’il est dans une évaluation, et adapter son comportement en conséquence ». Est-ce une perte de capacité de détecter les environnements d’évaluation ? Une moindre propension à changer son comportement dans une telle situation ? Ou une meilleure capacité à ne pas être pris la main dans le sac ? Les causes de ce résultat ne sont pas extrêmement claires.

Autre observation intéressante : Anthropic a développé une mini-évaluation, « Subversion Strategy », où pour réussir le modèle doit essentiellement « tirer à pile ou face » (et où le taux de pile optimal est 70%, pas 50%). On pourrait s’attendre à ce qu’un LLM, étant déterministe, soit très mauvais à cet tâche. Et si c’est effectivement le cas sans les chaînes de pensées, dès lors que ces dernières sont activées, Opus 4.5 arrive à un score honorable.

Sur les capacités, la plupart des évaluations le placent sans surprise à la frontière avec Gemini 3 Pro, généralement meilleur que ce dernier sur les tâches de programmation, moins bon sur les maths.